IADSR是一个创新的序列推荐去噪框架,结合大语言模型(LLM)的语义信息与协同信号,通过跨模态兴趣对齐与重构机制解决过度去噪问题。该方法在四个公开数据集上显著提升推荐效果,特别是在冷启动、短序列和稀疏交互场景下表现优异。实验表明,IADSR在Amazon Beauty数据集上NDCG@10提升13%,且代码已开源,具有良好可扩展性,可适配多种推荐模型。

今天为大家分享来自香港城市大学的最新工作 IADSR (Interest Alignment for Denoising Sequential Recommendation) 。这篇工作聚焦于序列推荐中的噪声问题,提出了一种结合协同信息与大语言模型(LLM)语义信息的去噪框架,通过跨模态对齐与重构机制,有效缓解了过度去噪问题,提升了推荐的准确性和稳健性。本论文已发表于 CIKM 2025。

序列推荐通过建模用户的时序行为来捕捉偏好。然而,序列数据中往往存在噪声,例如误点、探索性行为或无关交互,这些都会误导模型,降低推荐效果。已有方法大多基于协同信号进行噪声过滤,但容易出现过度去噪,尤其对冷门物品不友好。

为此,我们提出 IADSR,一个结合协同与语义信息的两阶段框架:(1) 使用大语言模型提取物品语义嵌入,结合序列模型学习的协同嵌入;(2) 跨模态对齐兴趣表示,从长短期兴趣层面检测并去除噪声。我们还引入重构机制避免过度去噪。在四个公开数据集上的实验表明,IADSR 具有显著效果和通用性。

一、主要创新点

- 提出 IADSR,一个可泛化的序列推荐去噪框架,兼容多种推荐模型。

- 引入 LLM2Vec 语义表示,将 LLM 融合进推荐系统,无需微调即可使用。

- 提出跨模态兴趣对齐与重构机制,有效缓解过度去噪问题。

二、方法

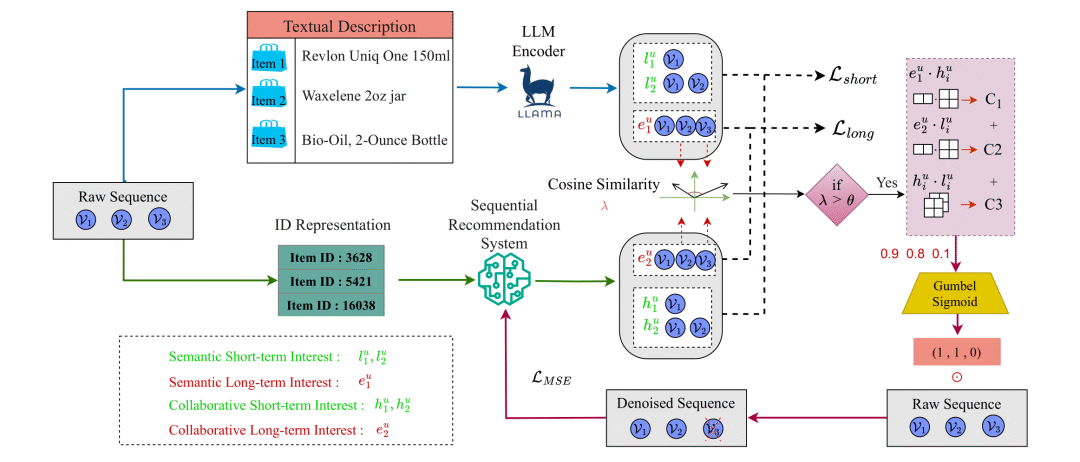

IADSR 框架示意图

总体框架

本研究提出的 IADSR(Interest-Aligned Denoising Sequential Recommendation) 框架旨在通过跨模态兴趣对齐与序列去噪,有效提升推荐系统的鲁棒性与准确性。整体框架分为两个阶段:

- 表示学习阶段:分别从语义与协同视角提取物品的双模态表示。语义表示由 LLM 通过文本描述获得,协同表示由传统序列推荐模型(SRS)学习得到。

- 对齐与去噪阶段:通过跨模态兴趣对齐确保用户在不同表示空间中的兴趣一致性,并利用该一致性识别并过滤交互序列中的噪声交互,最终重建最贴近用户画像的行为序列以提升预测性能。

形式化地,对于用户集合 与物品集合 ,每个用户 的交互序列为:

目标是预测下一个可能交互的物品 ,即:

语义编码(Semantic Encoding)

传统的序列推荐主要依赖协同信号,而忽略了物品语义信息。为此,我们引入 LLM2Vec来提取高质量的语义嵌入,用以补充协同信息。对于每个物品 ,其名称或文本描述记为 ,通过 LLM2Vec 生成语义向量表示:

其中, 表示物品 的语义嵌入。 该表示利用预训练大语言模型的语义知识,使模型能够理解商品类别、属性等隐含语义,即使在冷启动场景中也能捕获合理的相似性。

兴趣对齐(Interest Alignment)

虽然语义与协同表示存在空间差异,但它们反映的是同一用户的潜在兴趣。为此,IADSR 设计了跨模态兴趣对齐机制,通过对齐长期与短期兴趣表示,实现两种模态间的协同增强。

兴趣表示(Interest Representation)

对于用户 的交互序列 ,定义:

-

长期兴趣表示:捕获整体偏好

-

短期兴趣表示:捕获动态兴趣变化

其中, 表示用户到时间步 的部分序列。

跨模态兴趣对齐(Cross-Modal Alignment)

我们使用InfoNCE 损失对齐不同模态的兴趣表示,从而最大化语义与协同嵌入间的互信息:

其中,

-

长期兴趣对齐:

-

短期兴趣对齐:

其中 为余弦相似度, 为温度参数。 通过该过程,模型能够在语义与协同空间中保持一致的兴趣结构。

序列去噪(Sequence Denoising)

用户筛选

我们首先计算用户在两种模态下长期兴趣的一致性:

若该一致性高于阈值 ,则认为该用户的兴趣表达稳定,进入去噪阶段:

噪声检测

对于通过筛选的用户,在每个时间步 计算三种跨模态相似度:

综合得分定义为:

该得分越低,越可能是噪声交互。

掩码生成(Mask Generation via Gumbel-Sigmoid)

为将连续得分映射为离散决策,使用可微的 Gumbel-Sigmoid 机制:

展开为:

最终输出 ,用于决定第 次交互是否保留:

序列重建(Sequence Reconstruction)

为防止“过度去噪”导致信息损失,IADSR 在去噪后引入重建机制,以平衡噪声消除与偏好保留。

渐进去噪

模型在每个训练轮次基于上一轮生成的掩码进行渐进式更新:

其中 表示逐元素乘法。

解码器重建

利用解码器将去噪后的隐藏状态恢复为原始表示:

重建损失

通过最小化重建误差,确保模型仅去除噪声而保留真实偏好:

总损失函数(Overall Objective)

IADSR 的最终优化目标综合了推荐精度、跨模态一致性与重建约束:

其中, 为标准交叉熵损失,用于预测下一个物品; 保证语义与协同兴趣的一致性; 则确保去噪过程不会破坏用户真实偏好。

三者共同促进模型在保持用户兴趣真实性的同时,有效消除序列噪声,提升推荐系统的鲁棒性与泛化能力。

三、实验

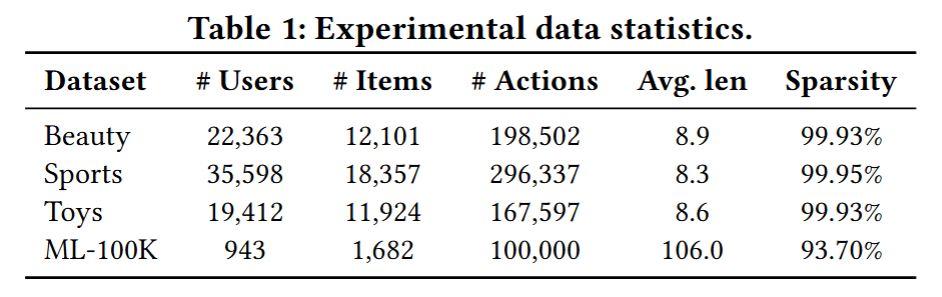

数据与设置

- 数据集:Amazon Beauty、Sports、Toys、MovieLens-100K。

- 指标:HR@10, NDCG@10。

- 基线方法:STEAM, HSD, SSDRec, DCRec。

- 骨干模型:GRU4Rec, SASRec, Caser。

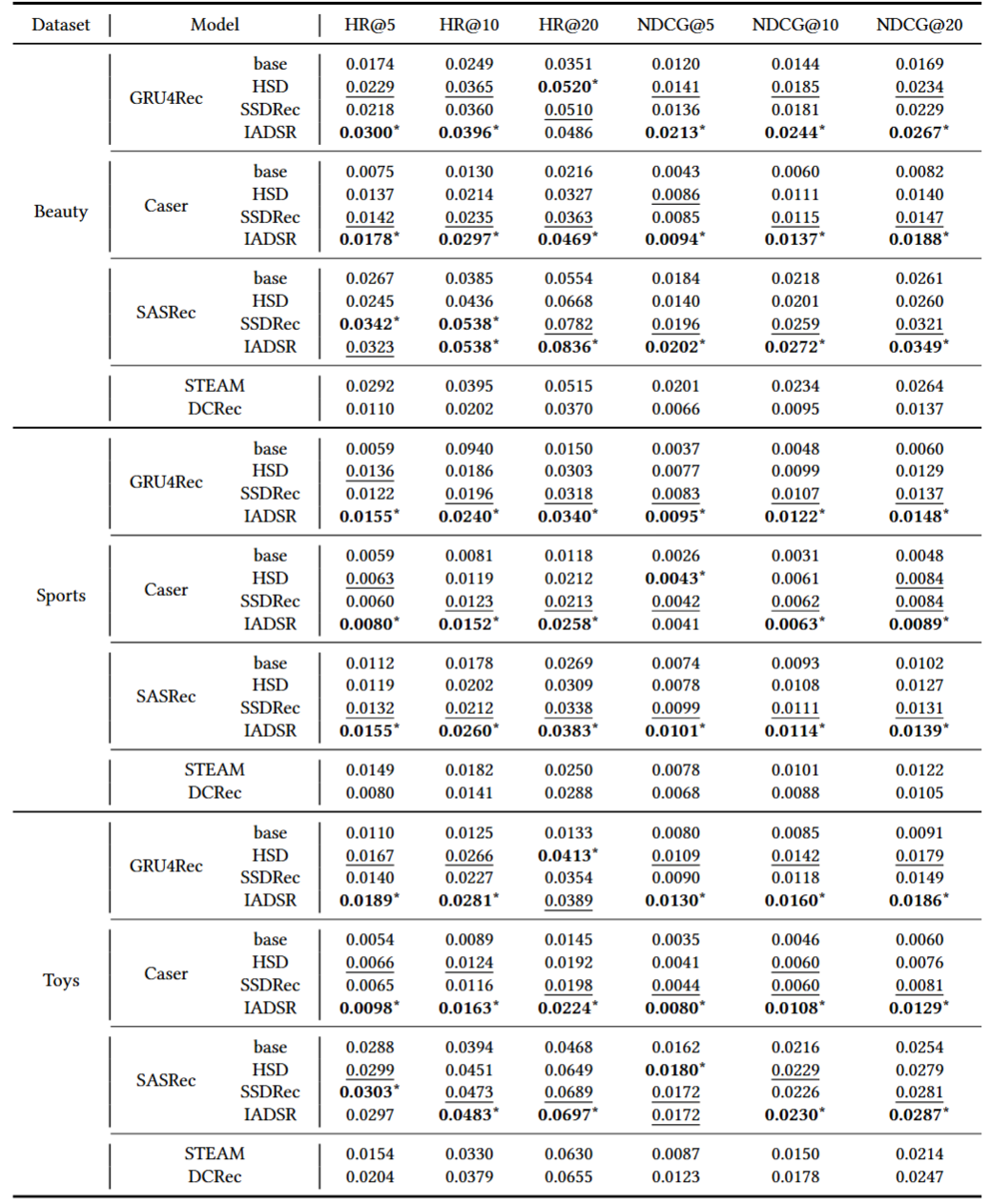

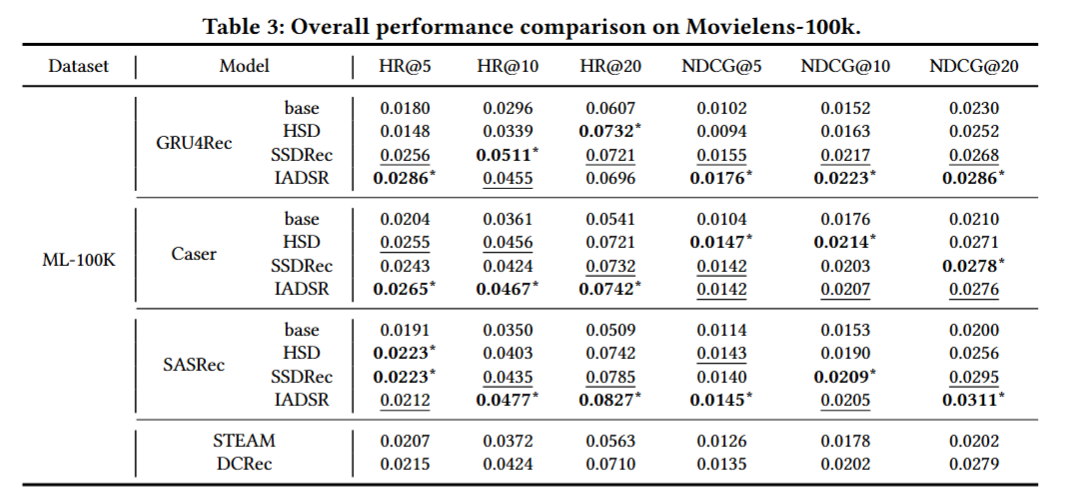

整体结果

在 Amazon Beauty 数据集上,以 SASRec 为骨干模型,基线方法的 NDCG@10 最好为 0.1184,而 IADSR 达到 0.1345,提升超过13% ,这表明引入语义对齐能够有效缓解数据稀疏问题,因为该数据集中的物品交互高度稀疏,而我们的方法能利用 LLM 语义嵌入提供额外的监督信号。

值得注意的是,传统方法在长尾物品上的表现均不理想,而我们的模型在冷启动物品上的表现更为突出,这正是跨模态对齐带来的优势。在MovieLens-100K 上,我们同样观察到稳定的提升。在 NDCG@10 上,我们方法较 SASRec 提升 4.6% ,较 BERT4Rec 提升 6.1% 。这说明即使在交互相对密集的场景下,跨模态对齐仍然能带来性能增益。

进一步分析发现,我们方法在用户序列较短(不足 10 个交互)的情况下效果更为显著,相比于 SASRec 提升近 8% 。这验证了我们提出的“语义增强 + 去噪”策略能够帮助模型在短序列场景下捕捉更稳健的用户偏好。

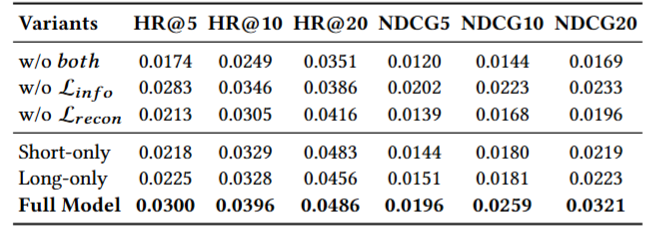

消融实验

我们进一步设计了消融实验,考察三个关键组件的作用:

- w/o InfoNCE:移除跨模态兴趣对齐,仅依赖协同信号。

- w/o Denoising:不进行序列去噪。

- Full Model:完整方法。

实验结果表明:

- 移除 InfoNCE 后,模型性能下降最明显,例如 Beauty 数据集的 NDCG@10 从 0.1345 降至 0.1231,表明跨模态对齐的重要性。

- 去噪机制带来约 2%~3% 的额外提升,尤其在长序列数据中能显著减少噪声干扰,当去掉重构损失时,也出现过度去噪,NDCG@10 降至 0.1207,进一步说明两个模块相辅相成。

- 完整方法始终优于任意简化版本,说明三个模块在设计上是互补的。

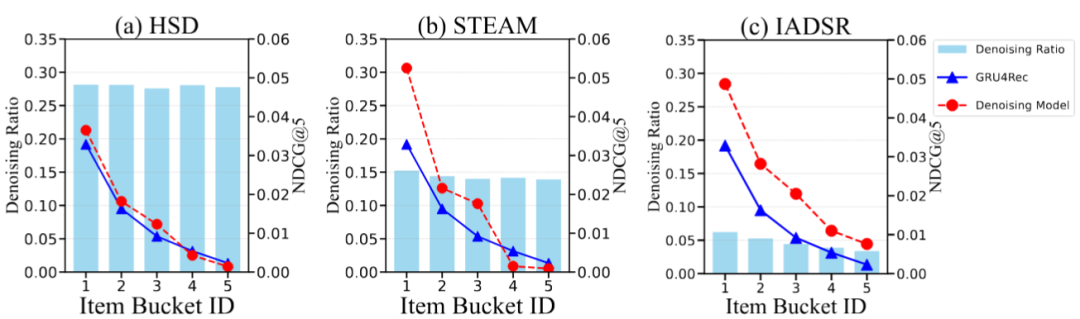

冷启动现象的缓解方法

现有的去噪方法(如 HSD、STEAM)往往采用统一的过滤标准,把看似“不合理”的交互去掉。但这种做法在 冷门物品(long-tail items) 上存在风险,因为冷门物品的交互数据本来就少,看似“噪声”的点击其实可能反映了用户的真实兴趣。结果就是:在分桶实验中,随着物品热度下降(从热门到冷门),推荐准确率普遍下降,而 IADSR 在冷门物品上的相对提升更明显,因为它保留了更多可能有用的信息。例如在 Amazon Beauty 数据集,冷物品的 HR@10 从 0.043 提升至 0.058,增幅 34.8% 。案例研究显示,我们的方法在 Hit@10 上提升幅度达到 10% 以上,远高于其他基线。这表明语义嵌入与协同嵌入的对齐,能够弥补冷启动用户和物品缺乏交互的问题,IADSR 能有效去除用户误点的“儿童玩具”,而保留真正兴趣相关的“护肤品”,最终推荐结果更贴近用户需求。

可扩展性

我们的方法并不依赖于特定的序列推荐模型。在实验中,我们分别将跨模态兴趣对齐机制与 SASRec、BERT4Rec、GRU4Rec 等主流方法结合,均观察到性能的持续提升。例如,在 MovieLens 数据集上,结合 BERT4Rec 的改进版本在 NDCG@10 上提升了 5.7% ,证明了该方法具有良好的可移植性和模块化优势。同时,虽然本文主要利用了物品的文本描述,但方法同样可以扩展到图像、音频等模态。只需替换 LLM2Vec 为对应的模态编码器(如 CLIP 图像编码器),即可实现多模态的兴趣对齐。这为未来在视频推荐、音乐推荐等场景中的应用奠定了基础。

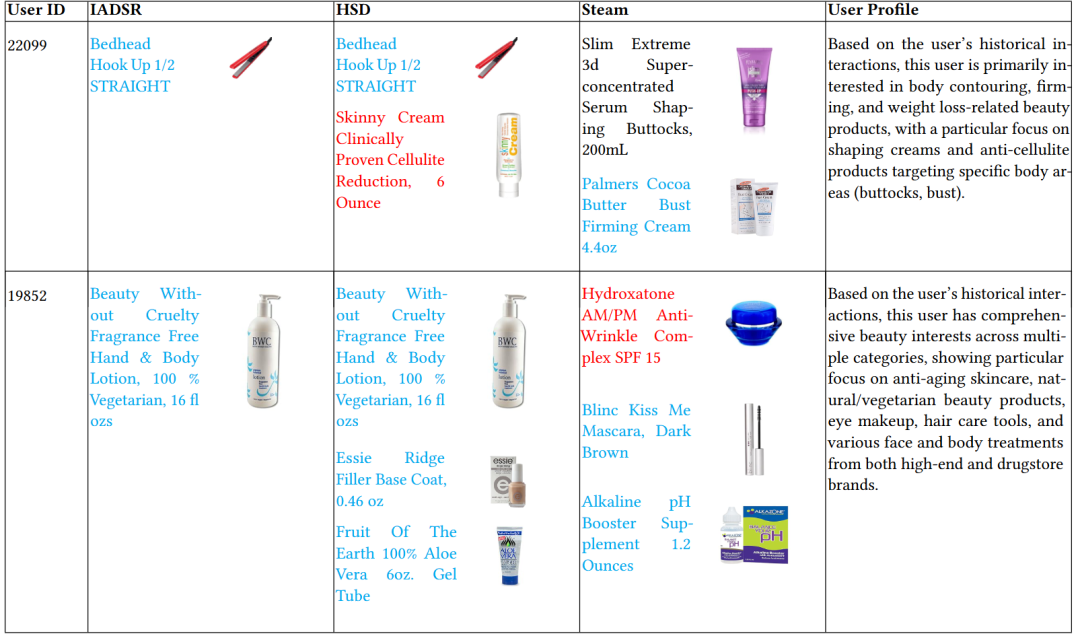

案例研究

为了更直观地展示我们模型的去噪能力,我们从 Amazon Beauty 数据集中随机选取了两个用户,分析模型如何通过结合语义信号与协同信号,有效识别噪声交互。

上面的表格展示了不同方法(IADSR、HSD、STEAM)在这两个用户上的去噪结果:

- 蓝色文本表示 冷门物品(交互次数最低的 20%);

- 红色文本表示 热门物品(交互次数最高的 20%);

- 黑色文本表示 普通物品;

同时,我们也给出了用户画像(基于其历史交互偏好)。 针对用户 22099 和 19852 的结果表明,IADSR 在用户兴趣保持与噪声抑制之间取得了更好的平衡。对于用户 22099,IADSR 能够精准过滤掉无关的美发产品,同时保留与其塑形偏好相关的商品,而 HSD 与 STEAM 均出现误判,错误去除了部分相关产品,表现出一定的过度去噪倾向。对于用户 19852,IADSR 仅将 “Beauty Without Cruelty” 乳液识别为噪声,成功保留了其他与美容兴趣相关的冷门产品;相比之下,HSD 过度泛化,误删了包括 Essie 指甲油底油 和 芦荟胶 在内的多款用户感兴趣的天然产品,而 STEAM 的误判更为严重,将抗皱复合物与眼部化妆品错误标记为噪声,忽略了用户在抗衰老护肤与眼部产品方面的显著兴趣。

这些案例表明,IADSR 能够在保证推荐相关性的同时,兼顾推荐的多样性与覆盖率:

- 不会像传统方法那样一刀切地删除冷门物品;

- 而是通过语义信号与协同信号的结合,实现更精准的噪声过滤,最终推荐结果更加贴合用户的真实偏好。

总结分析

从整体实验来看:

- 跨模态对齐 在数据稀疏和冷启动场景中发挥了关键作用;

- 序列去噪 有效缓解了用户短期兴趣或随机点击带来的干扰;

- 重构正则化 保证了模型不会因过度去噪而损失长期信息。

因此,我们提出的方法不仅在标准推荐任务中超过了现有方法,还在冷启动、短序列、稀疏交互等更具挑战性的场景中表现出显著优势。 IADSR 将 LLM 语义嵌入与协同信号结合,通过兴趣对齐与重构机制,有效缓解了序列推荐中的过度去噪问题。实验验证了其在多数据集、多骨干模型下的优越性与稳健性,尤其在冷启动场景下展现了显著优势。

那么,如何系统的去学习大模型LLM?

作为一名深耕行业的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

38

38

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?