近年来,大型语言模型(LLMs)发展势头迅猛,受到了广泛的研究关注。尽管成就斐然,但大型语言模型不可避免地存在一个突出的 “幻觉” 问题—— 即模型会无意中生成看似合理、但事实有误的回复。

为解决这一问题,研究人员提出了检索增强生成(RAG)技术,通过外部知识增强大型语言模型的能力。其中,利用知识图谱(KGs)中更可靠的结构化知识为大型语言模型赋能,是一种极具潜力的解决方案。现有研究多采用 “两阶段范式”:首先通过实体对、深度强化学习或大型语言模型等方法,从知识图谱中提取由三元组构成的 “路径”;随后将检索到的、基于关键词的原始三元组或路径直接用于增强大型语言模型。总体而言,现有方法均以 “路径” 作为载体,向大型语言模型传递知识图谱中的知识。

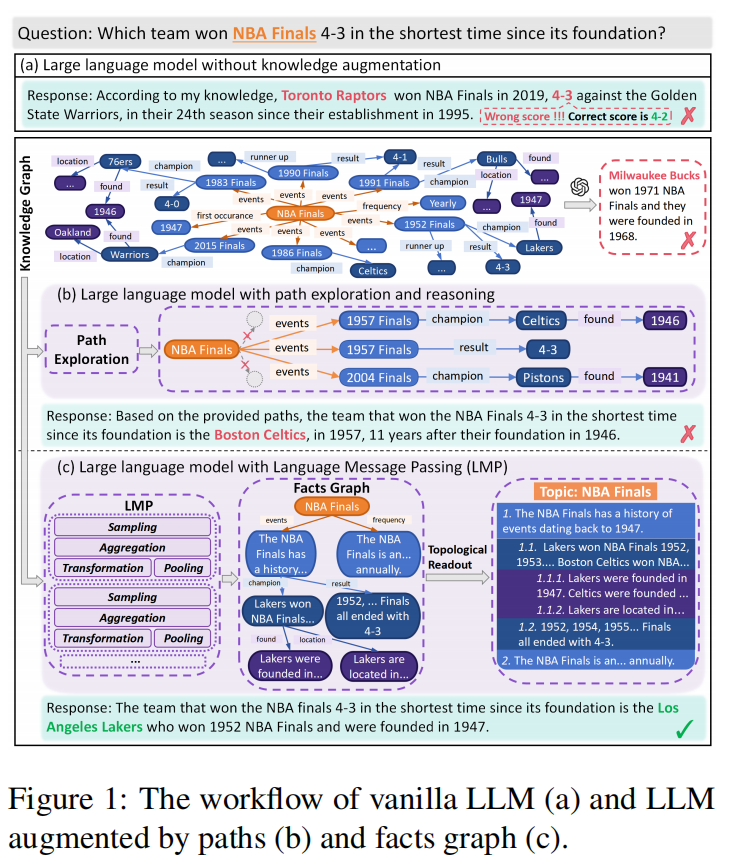

但 “路径” 真的是传递丰富知识图谱知识、且便于大型语言模型 “消化” 的合适载体吗?以 “自成立以来,哪支球队在 NBA 总决赛中以 4-3 的比分夺冠且用时最短” 这一问题为例:ChatGPT 在回答时就出现了典型的 “幻觉”,编造了虚假比分(如图 1a 所示)。

这是一个 “最高级问题”,需要所有 78 届 NBA 总决赛的比分和冠军信息才能准确回答。首先,“路径” 仅能捕捉知识图谱的 “深度信息”,缺乏对整体图结构的全局认知。其次,基于关键词的原始路径缺乏组织性,语义表达生硬,难以被大型语言模型 “消化”。即便知识图谱中包含所有必要信息,大型语言模型在回答该问题时仍会失败(如图 1 中红色虚线框所示),原因就在于这些信息分散在不同深度的独立路径中,缺乏有效组织。

原始知识图谱对大型语言模型而言显然过于复杂、噪声过多,而 “路径” 作为载体的能力又存在局限,因此需要寻找一种合适的载体,以捕捉知识图谱中结构化知识的核心本质。作者从图神经网络(GNNs)中获得灵感:图神经网络通过 “神经消息传递” 机制和 “读出” 函数,能够学习出简洁的图结构,进而捕捉高层特征与模式。但直接将 “神经消息传递” 嵌入空间中存储的知识转换为大型语言模型可理解的形式,难度较大。

为解决这一问题,这篇文章提出了一种名为 “语言消息传递(LMP)” 的新型框架:在该框架中,“消息传递” 与最终的 “问答” 过程均由大型语言模型在文本空间中完成,以确保知识的无缝传递。具体而言(如图 1c 所示),首先在知识图谱上执行 “多层语言消息传递”:通过 “采样” 筛选出无关关系,“聚合” 邻居实体信息,将基于关键词的原始实体信息 “转换” 为总结性事实,并将原始复杂的知识图谱 “池化” 为简洁的 “事实图”—— 其中每个节点都是一个总结性事实。接下来,执行 “拓扑读出” 操作:在事实图上进行深度优先搜索(DFS),同时为每个节点分配多级列表编号,以此编码图的深度与宽度信息。最后,用 “总结性事实的多级列表” 为大型语言模型赋能 —— 这种形式是文本中常用的层级化信息组织方式,不仅信息更丰富,也更便于大型语言模型 “消化”。

作者的主要贡献包括:

- 将图神经网络的核心思想及其优势融入 “知识图谱增强型大型语言模型”,为未来 “跨领域融合大型语言模型与成熟方法” 提供了新思路。

- 现有方法仅能通过 “基于关键词的路径” 解释推理过程,而 LMP 中的 “事实图” 可提供包含 “大型语言模型由浅入深消化图信息全过程” 的语义事实,实现了 “逐步式人类级别可解释性”。

- 在 5 个知识图谱问答(KGQA)基准数据集上验证了 LMP 的有效性,其性能均超越现有方法,达到当前最优(SOTA)水平。

一、Related Work

在图表示学习领域,图神经网络(GNNs)已成为一种基准方法。图神经网络的消息传递过程包含检索、采样、聚合、转换、池化与分类等步骤。具体而言,首先会检索目标节点的 k 跳邻域网络(k-hop ego-net),随后通过节点采样减少计算成本;接下来,每个节点会聚合其邻域信息,并借助神经转换更新节点表示;之后,池化操作会将高度相关的节点合并为一个超节点;经过多轮迭代后,最终得到的节点表示将用于分类任务。

在知识图谱增强大型语言模型的早期研究中,研究者会将知识图谱中的结构化知识编码为嵌入向量,并在预训练与微调阶段,将其与大型语言模型的底层神经网络融合。然而,这种 “将知识图谱嵌入大型语言模型” 的方式存在明显局限:训练过程需极高计算成本,仅适用于参数较小、能力较弱的大型语言模型,且会损失知识图谱本身具备的自然可解释性。

为解决这些局限,近年来的研究转而从知识图谱中检索结构化知识,并将其转化为文本提示,以此增强大型语言模型的能力。在知识图谱检索环节,多数方法会从知识图谱中提取由三元组构成的 “路径”:例如,RoK基于实体对构建路径,KnowGPT采用深度强化学习提取路径,ToG与 RoG则借助大型语言模型生成路径。尽管部分研究在知识图谱上采用类似广度优先搜索(BFS)的方法,但最终检索到的知识仍以 “路径集合” 的形式呈现。而在知识输入环节,所有这些方法均通过 “原始三元组” 或 “路径” 为大型语言模型赋能。

二、Method

作者的任务是基于自然语言问题q和知识图谱G的知识图谱问答(KGQA)。将知识图谱定义为(G=(E, R, X)),其中E、R和X分别代表实体集、关系集和文本集。文本集X是实体集E的文本描述(例如实体名称)。问题q的主题实体可通过实体链接技术获取。

Language Message Passing

**神经消息传递通过神经网络将邻居节点的表示投影到新的表示空间,从而迭代式聚合邻居节点并转换其表示。**这一机制使图神经网络(GNNs)能够学习到图结构和节点特征的抽象程度更高、信息量更丰富的表示。

为确保知识从图到文本的无缝传递,以支持最终的问答任务,作者提出了 “语言消息传递(LMP)” 框架:该框架不再依赖神经网络,而是利用大型语言模型(LLMs)的知识泛化与处理能力为消息传递过程赋能。**然而,若直接采用图神经网络的消息传递方式(即每层更新所有节点),对大型语言模型而言计算成本极高。**因此,作者设计了一种简化方案:在第l层语言消息传递中,仅对主题实体的l跳关系与邻域执行操作,且在多层语言消息传递过程中,每个节点 / 实体仅更新一次。

不同于图神经网络中每层节点处于由不同神经网络投影得到的不同表示空间,本文方法中的节点在所有层中均处于一个公共的共享文本空间 —— 这意味着语言消息传递无需在每层进行表示空间对齐。

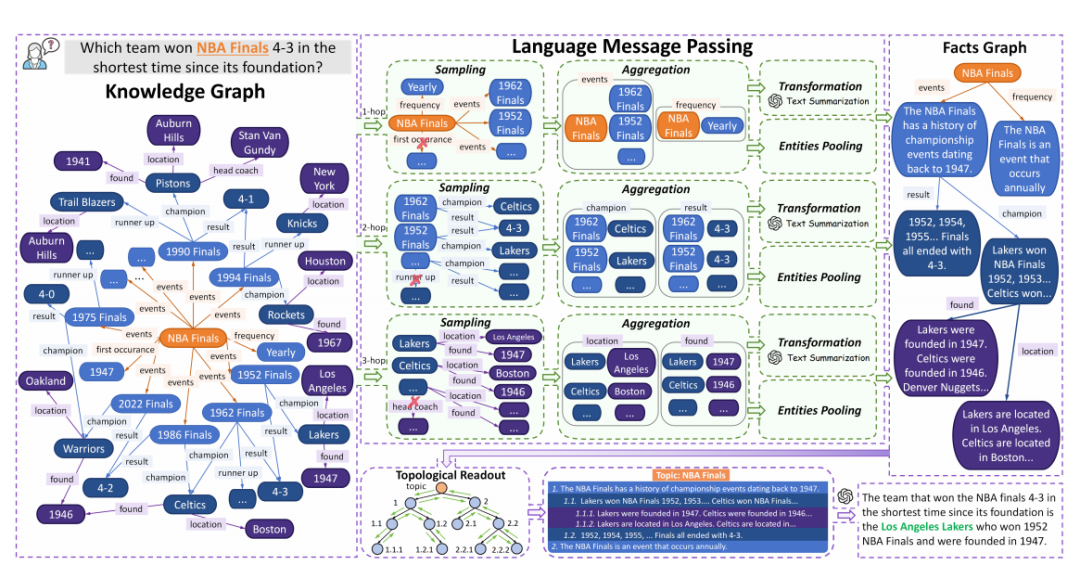

如上图所示,语言消息传递在知识图谱上执行多层迭代操作,具体步骤如下:1)采样主题实体的l跳关系中与问题最相关的前K个关系;2)为每个筛选出的关系聚合其邻域信息;3)将聚合后的图信息转换为语义化的总结性事实,并将聚合的实体池化为超实体。经过多层语言消息传递后,得到一个 “事实图(facts graph)”,其中每个节点均为一个总结性事实。

三、Sampling

由于像 Freebase 这样的知识图谱(KGs)规模庞大,且随着深度增加,邻域节点数量会呈指数级增长,因此直接在与问题相关的子图上执行多层语言消息传递,可能会耗费极高的时间成本。此外,并非所有关系都与问题相关 —— 若用无关信息增强大型语言模型(LLM),会引入噪声,进而影响模型性能。

为解决这些问题,在第 l 层语言消息传递中,作者首先对主题实体的 l 跳关系集进行采样:基于问题q和上一层的总结性事实,筛选出与问题最相关的前 K 个关系,公式如下:

其中,(第 0 层的总结性事实)初始化为空集。为实现更优性能,作者采用大型语言模型执行TopK 筛选操作。

四、Aggregation

采样完成后,作者得到第 l 层语言消息传递所需的、主题实体的 K 个 l 跳关系。为全面掌握 l 跳邻域的信息,通过对每个选定关系的关联实体进行聚合,公式如下:

其中,代表主题实体的(l-1)跳邻域实体的文本; 为主题实体本身的文本描述。需说明的是,“聚合(Aggregate)” 操作通过预定义提示词实现,无需调用大型语言模型(LLM)。

相较于基于路径的方法,作者提出的聚合操作具有两大优势:

- Token 效率更高:聚合提示词在描述邻域信息时更简洁,与包含冗余头实体和关系的三元组相比,可减少多达 2/3 的 Token 用量;

- 鲁棒性更强(核心优势):在现实场景中,知识图谱(KG)常存在实体缺失、关系缺失等 “不完整且含噪声” 的问题,而聚合操作正是语言消息传递(LMP)应对这些挑战的鲁棒性基石。通过聚合邻域信息,LMP 能够掌握图的局部结构全貌,从而最大限度降低缺失实体与关系带来的影响。

五、Transformation

由于原始聚合信息仍然过于冗长且存在噪声,仅包含关系与实体名称的关键词,因此作者希望将其精简,并进一步转换为大型语言模型(LLM)更易理解的格式。为此,对每个选定关系的聚合邻域信息 进行转换,以在仅保留与问题相关信息的前提下完成总结:

其中, 是上一层得到的总结性事实。作者使用大型语言模型(LLM)执行该转换操作。

Pooling

在对每个选定关系的聚合邻域信息 进行总结转换的同时,作者将聚合过程中涉及的那些邻居实体池化为一个超实体(hyper-entity),并将总结得到的事实 作为该超实体的文本描述:

其中,是主题实体的 l 跳邻居实体。与上述被池化实体相连的关系会被链接到超实体 上。

由于与问题相关的子图可能仍然过于复杂,作者可以通过将主题实体的 l 跳邻居实体(针对每个选定关系)池化为超实体的方式,安全地缩减图的规模 —— 在此过程中,这些邻居实体文本描述中的信息会被转换为总结性事实。

六、Topological Readout

经过 L 层语言消息传递后,作者得到一个事实图 ,其中 是池化后的超实体集合,是与问题相关的关系集合,是作为 的文本描述集合的总结性事实。

为保留图结构信息,作者从该事实图执行拓扑读出(Topological Readout),并增强大型语言模型(LLM)以完成问答任务:

读出操作以主题实体为根节点,对事实图执行深度优先搜索(DFS),并为每个节点分配如上图所示的多级列表编号。如此,事实图被转化为 “总结性事实的多级列表”—— 其中,像 “1”“1.1” 这样的列表编号表示图的深度,“1.1”“1.2” 这类编号则表示图的宽度信息。多级列表是文本中用于分层组织信息的最常用结构化方式之一,它更具信息量,也更易于 LLM 理解。

与 “仅用原始路径增强 LLM 来回答问题” 的现有方法不同,本篇论文的方法不仅保留了图结构信息,还保留了 LLM 在知识图谱(KG)中从浅到深逐步搜索、消化信息的分步过程。这有助于 LLM 分解复杂问题并逐步解决。

七、Experiment

Datasets & Knowledge Graph

作者在 5 个知识图谱问答(KGQA)数据集上对语言消息传递(LMP)框架进行评估,具体包括:用于多跳问答的 WebQSP、CWQ和 GrailQA;用于单跳问答的 Simple Questions;用于开放域问答的 WebQuestions。

所有数据集均采用 Freebase 作为知识图谱(KG),该知识图谱包含超过 1.2 亿个实体和 2 万个关系。

八、Baselines

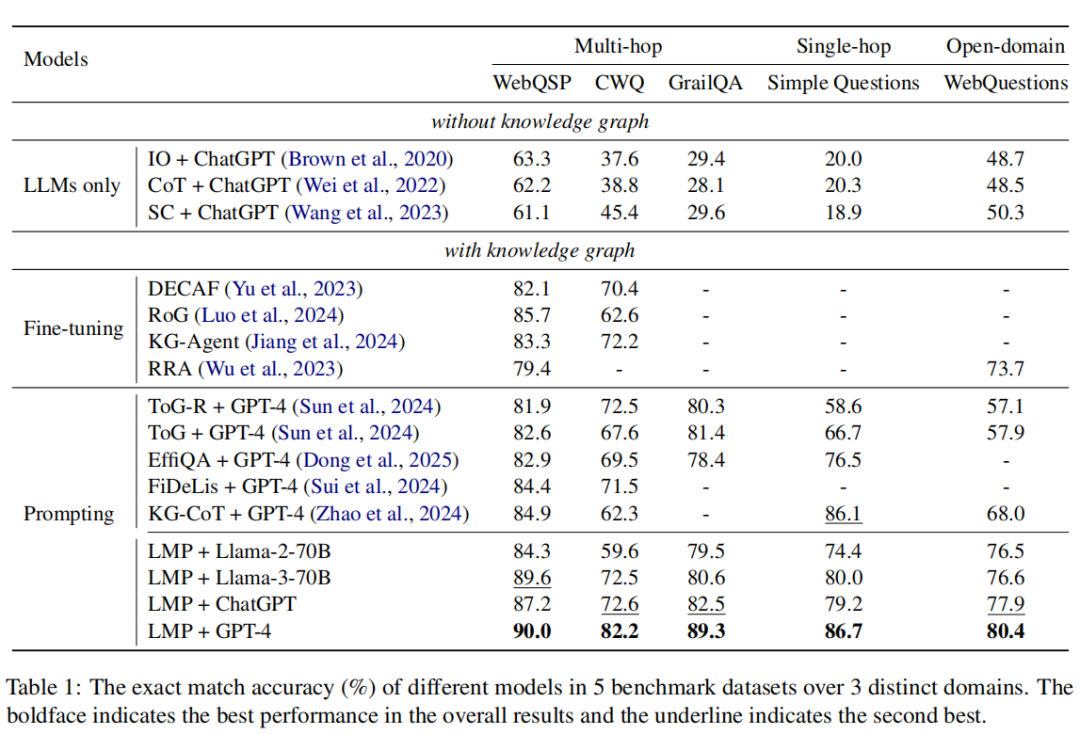

作者将所提方法与三类基线方法进行对比,即仅使用大型语言模型(LLMs only)、微调(fine-tuning)和提示(prompting)。

Implementation Details & Experiment Results

语言消息传递(LMP)是一种即插即用框架,兼容所有开源或闭源 API 的大型语言模型(LLMs)。作者采用 Llama-2-70B、Llama-3-70B、ChatGPT 和 GPT-4 作为骨干大型语言模型。

所有数据集均遵循先前研究的做法,采用精确匹配准确率(Hits@1) 作为评估指标。

实验结果如上表所示。显然,结合 GPT-4 的 LMP 在所有数据集上都取得了最佳结果,大幅领先于所有其他基线方法。此外,第二好的结果大多由结合能力较弱大语言模型的 LMP 取得,彰显了我们方法的优越性。在没有知识图谱(KG)的情况下,仅使用大语言模型的方法因缺乏领域特定知识而取得最差结果。与因训练而比提示方法天然具备优势的微调方法相比,LMP 仍有显著的性能提升。具体而言,LMP 在 WebQSP 上比 RoG 好 4.9%,在 CWQ 上比 KG-Agent 好 13.9%。

与其他提示类同类方法相比,LMP 也以显著优势领先。即使使用 Llama-2-70B 或 Llama-3-70B,LMP 仍能取得与结合 GPT-4 的其他方法相当甚至更优的性能。

九、Conclusion

本文提出语言消息传递方法,该方法通过迭代聚合邻域信息并将其转化为摘要事实,随后利用事实图谱(节点为摘要事实)的拓扑读出机制增强大型语言模型。LMP在所有5个知识图谱问答数据集上均实现最先进性能,并提供人类可理解的语义解释性。

那么,如何系统的去学习大模型LLM?

作为一名深耕行业的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

157

157

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?