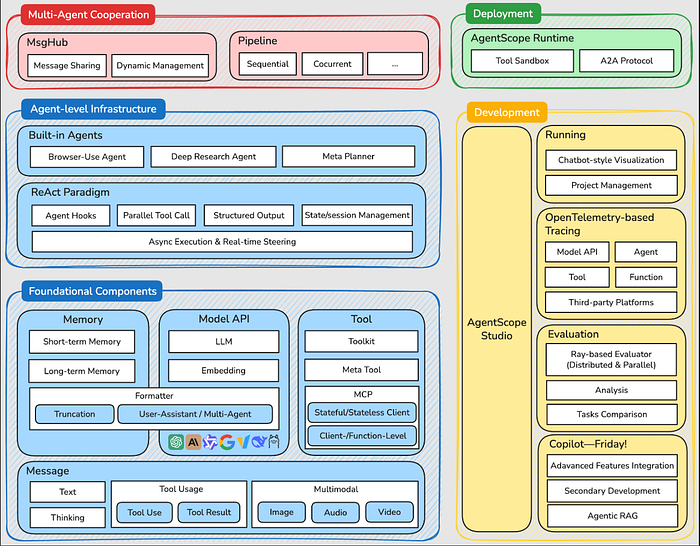

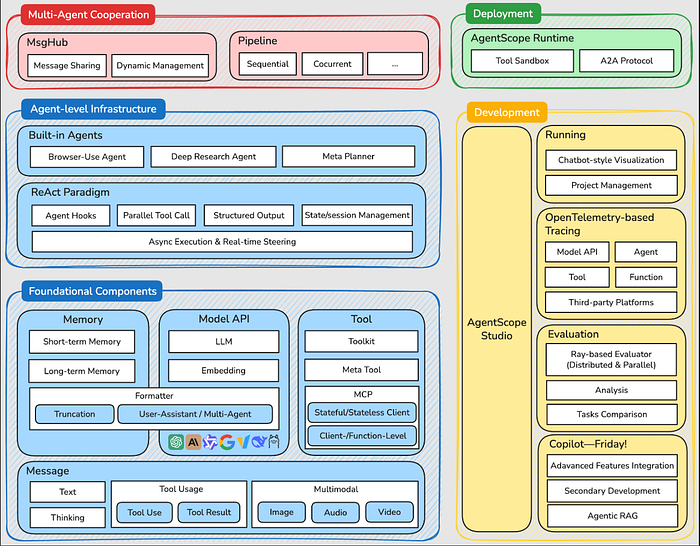

阿里巴巴推出的AgentScope是一个开源Python框架,用于构建多代理AI应用。其最大特点是完全透明化,用户可实时中断代理、调整所有组件,且不受特定模型限制。框架支持MCP协议集成,提供MsgHub实现智能体间交流,并内置追踪功能便于调试。组件化设计使其像乐高积木一样灵活组合,为开发者提供了构建复杂AI应用的强大工具。

前段时间,阿里巴巴悄然发布了AgentScope。这是一个用于构建多代理AI应用的开源Python框架。老实说,如果你一直在玩AI代理,那它真的很酷。虽然当前已经有了很多成熟的智能体框架,像Dify, LangGraph, AutoGen…,但它给你的感觉就像有人终于制作了一个不会跟你作对的智能体框架。

大多数框架隐藏了太多东西,或者将你锁定在一种工作方式中。

而AgentScope的理念恰恰相反;一切都保持可见,你始终掌控一切。没有黑箱魔法。

为什么它引起了大家的注意

AgentScope背后的人似乎痴迷于一个想法:透明度。每一个部分,提示、API调用、内存、工作流,你都可以看到并调整。这很难得。

我还喜欢其他几点:

- 你可以实时中断代理,并在不丢失内存的情况下重新开始。

- 它是模型无关的,所以你不会被一个LLM束缚。

- 所有组件(内存、工具、提示、工作流)都像乐高积木一样组合在一起。

- 它实际上是为多智能体对话设计的,而不是事后才考虑的。

它感觉就像一个希望不碍事的开发工具包。

运行

设置很无聊但很简单,你需要Python 3.10或更高版本。

如果你想快速安装:

pip install agentscope

或者如果你喜欢冒险(从源代码构建):

git clone -b main https://github.com/agentscope-ai/agentscope.git

cd agentscope

pip install -e .

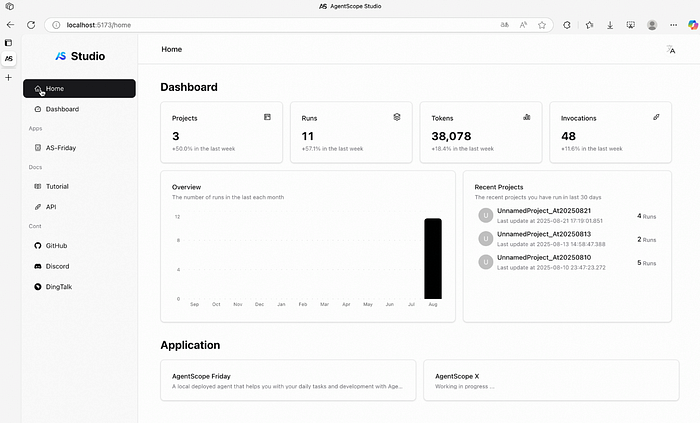

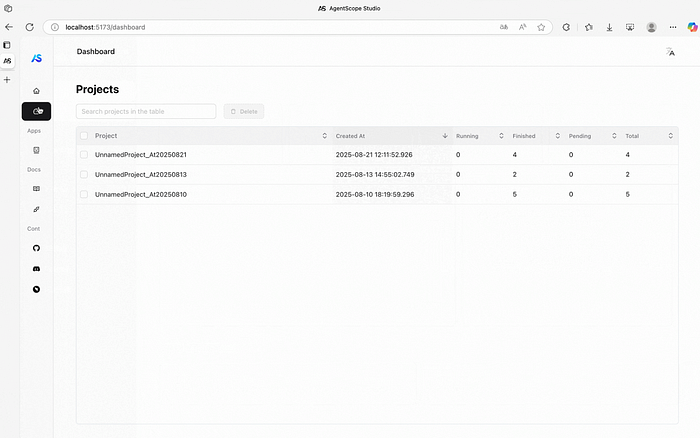

就是这样简单,可以看到如下Dashboard界面。

None

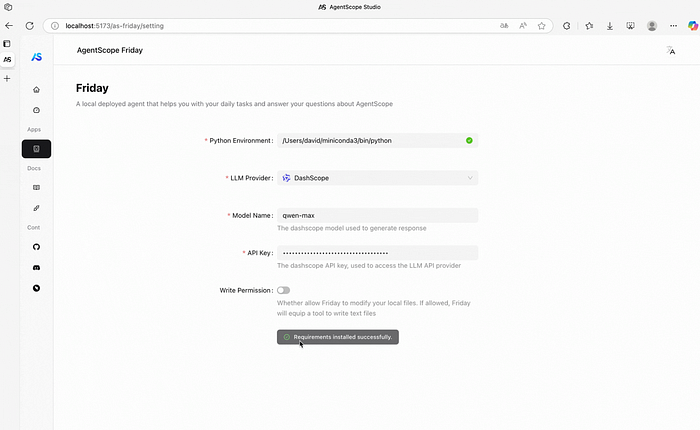

第一个“Hello World”与一个名叫Friday的智能体。

这是经典的入门示例,启动一个名为Friday的智能体,它可以与你聊天,记住上下文,甚至在你允许的情况下运行Python或shell命令。

from agentscope.agent import ReActAgent, UserAgent

from agentscope.model import DashScopeChatModel

from agentscope.formatter import DashScopeChatFormatter

from agentscope.memory import InMemoryMemory

from agentscope.tool import Toolkit, execute_python_code, execute_shell_command

import os, asyncio

async def main():

toolkit = Toolkit()

toolkit.register_tool_function(execute_python_code)

toolkit.register_tool_function(execute_shell_command)

agent = ReActAgent(

name="Friday",

sys_prompt="You're a helpful assistant named Friday.",

model=DashScopeChatModel(

model_name="qwen-max",

api_key=os.environ["DASHSCOPE_API_KEY"],

stream=True,

),

memory=InMemoryMemory(),

formatter=DashScopeChatFormatter(),

toolkit=toolkit,

)

user = UserAgent(name="user")

msg = None

while True:

msg = await agent(msg)

msg = await user(msg)

if msg.get_text_content() == "exit":

break

asyncio.run(main())

运行它,与Friday聊天,完成后输入exit。非常简单。

实时操控

其中一个突出的功能是他们称之为实时操控。

假设你的智能体在推理链中进行到一半,你突然意识到你想改变方向。

通常,这就意味着结束了。

在这里,你可以即时中断它,保留其内存,并在不丢失上下文的情况下恢复。

感觉更像是与一个真正的助手对话,而不是运行一个脚本。

MCP控制

AgentScope还与MCP(模型上下文协议)良好协作。最酷的部分是?你可以捕获一个MCP端点,并将其视为一个本地函数。

from agentscope.mcp import HttpStatelessClient

from agentscope.tool import Toolkit

import os

async def fine_grained_mcp_control():

# Initialize the MCP client

client = HttpStatelessClient(

name="gaode_mcp",

transport="streamable_http",

url=f"https://mcp.amap.com/mcp?key={os.environ['GAODE_API_KEY']}",

)

# Obtain the MCP tool as a **local callable function**, and use it anywhere

func = await client.get_callable_function(func_name="maps_geo")

# Option 1: Call directly

await func(address="Tiananmen Square", city="Beijing")

# Option 2: Pass to agent as a tool

toolkit = Toolkit()

toolkit.register_tool_function(func)

# ...

# Option 3: Wrap into a more complex tool

# ...

这意味着你每次想要连接MCP服务时,都不必编写粘合代码。

None

多智能体乐趣

当你开始让智能体相互交谈时,真正的魔法就发生了。AgentScope有一个叫做MsgHub的东西,它基本上是一个用于多个智能体的消息路由器。

示例:

from agentscope.pipeline import MsgHub, sequential_pipeline

from agentscope.message import Msg

import asyncio

async def multi_agent_conversation():

# Create agents

agent1 = ...

agent2 = ...

agent3 = ...

agent4 = ...

# Create a message hub to manage multi-agent conversation

async with MsgHub(

participants=[agent1, agent2, agent3],

announcement=Msg("Host", "Introduce yourselves.", "assistant")

) as hub:

# Speak in a sequential manner

await sequential_pipeline([agent1, agent2, agent3])

# Dynamic manage the participants

hub.add(agent4)

hub.delete(agent3)

await hub.broadcast(Msg("Host", "Goodbye!", "assistant"))

asyncio.run(multi_agent_conversation())

换句话说,你可以建立小的“智能体社会”,让它们相互交流想法。这对于集思广益的系统或任务编排非常有用。

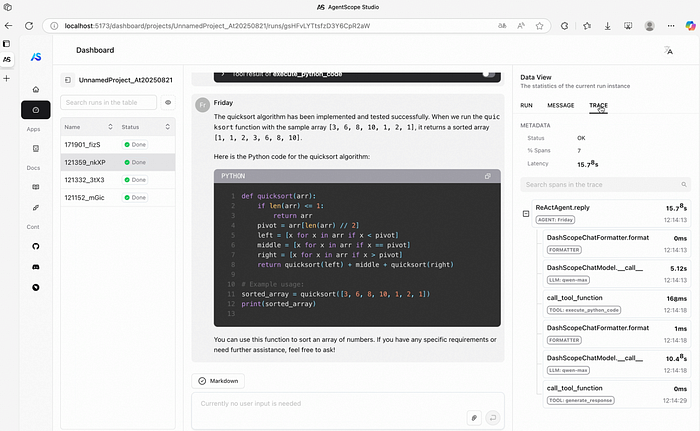

调试不再痛苦

内置了追踪功能。它们底层使用OpenTelemetry,你可以接入Langfuse或Arize-Phoenix等平台。

如果你想直观地查看发生了什么:

npm install -g @agentscope/studio

as_studio

这将打开AgentScope Studio,你可以在其中追踪和可视化你的智能体流程。这使得调试不那么痛苦。

👉 GitHub: https://github.com/agentscope-ai/agentscope

AI时代,未来的就业机会在哪里?

答案就藏在大模型的浪潮里。从ChatGPT、DeepSeek等日常工具,到自然语言处理、计算机视觉、多模态等核心领域,技术普惠化、应用垂直化与生态开源化正催生Prompt工程师、自然语言处理、计算机视觉工程师、大模型算法工程师、AI应用产品经理等AI岗位。

掌握大模型技能,就是把握高薪未来。

那么,普通人如何抓住大模型风口?

AI技术的普及对个人能力提出了新的要求,在AI时代,持续学习和适应新技术变得尤为重要。无论是企业还是个人,都需要不断更新知识体系,提升与AI协作的能力,以适应不断变化的工作环境。

因此,这里给大家整理了一份《2025最新大模型全套学习资源》,包括2025最新大模型学习路线、大模型书籍、视频教程、项目实战、最新行业报告、面试题等,带你从零基础入门到精通,快速掌握大模型技术!

由于篇幅有限,有需要的小伙伴可以扫码获取!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。

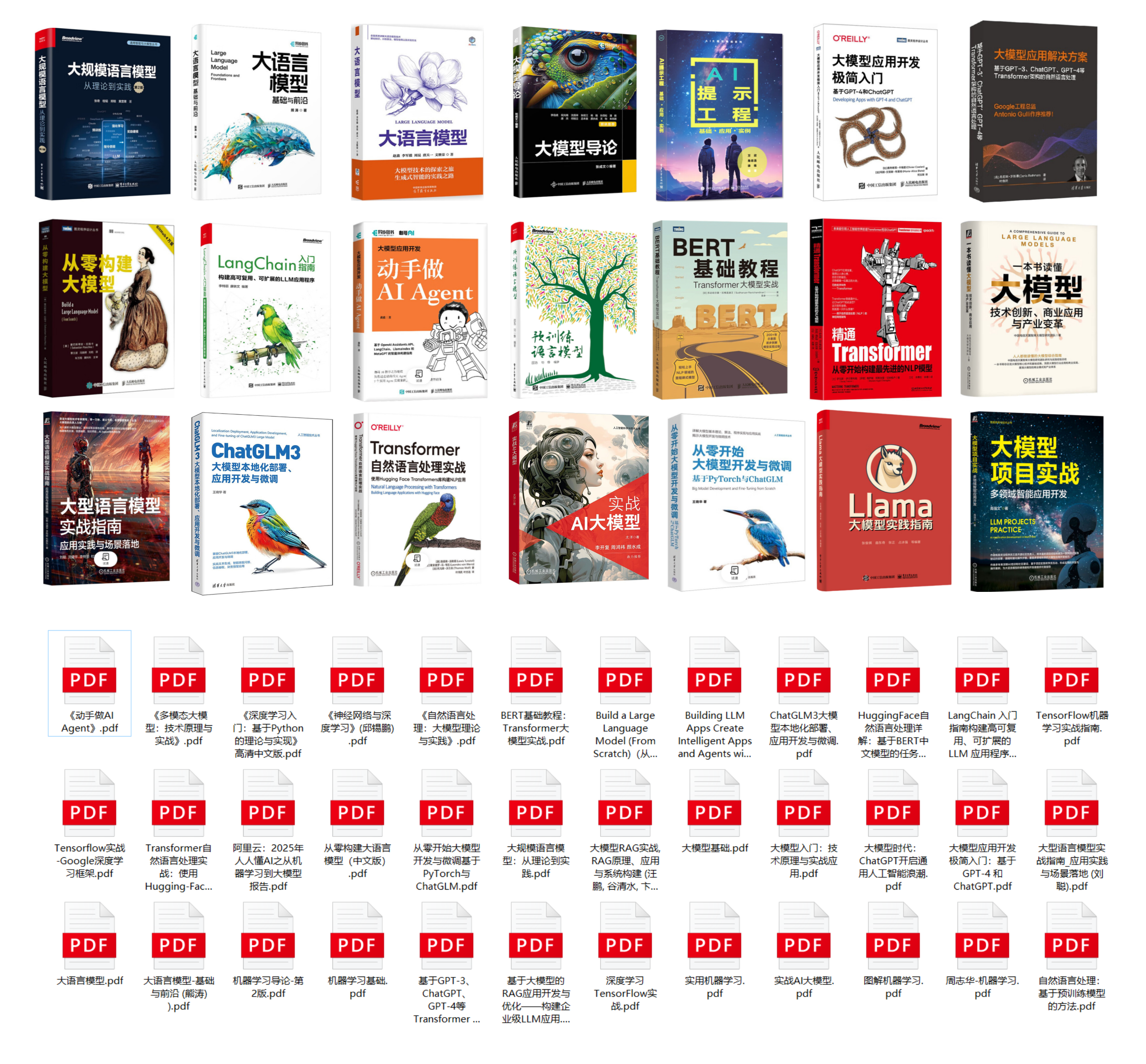

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

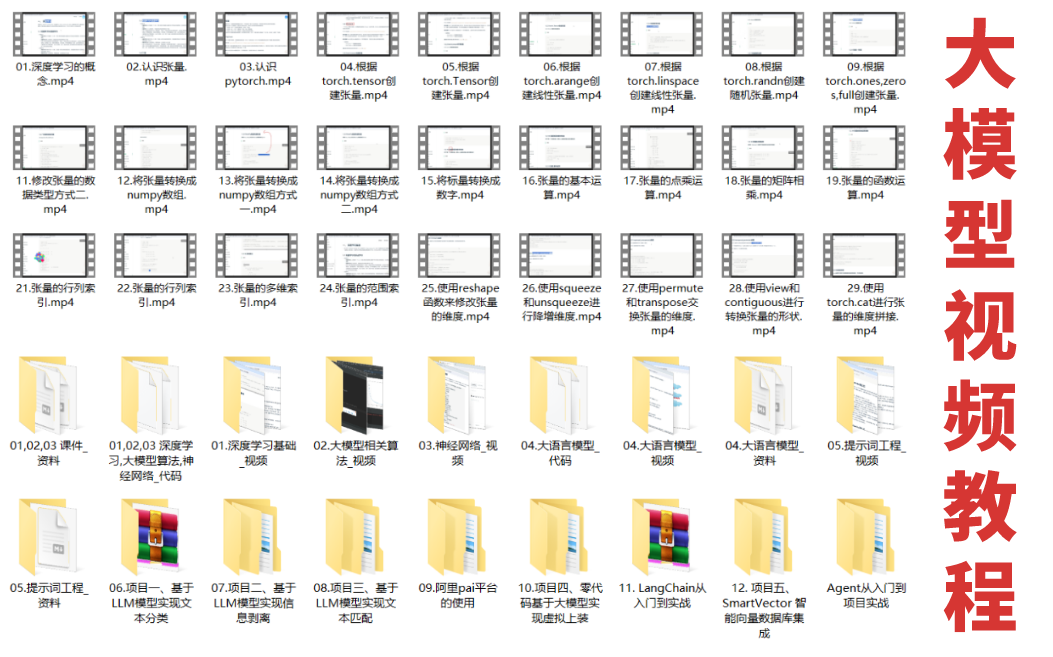

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

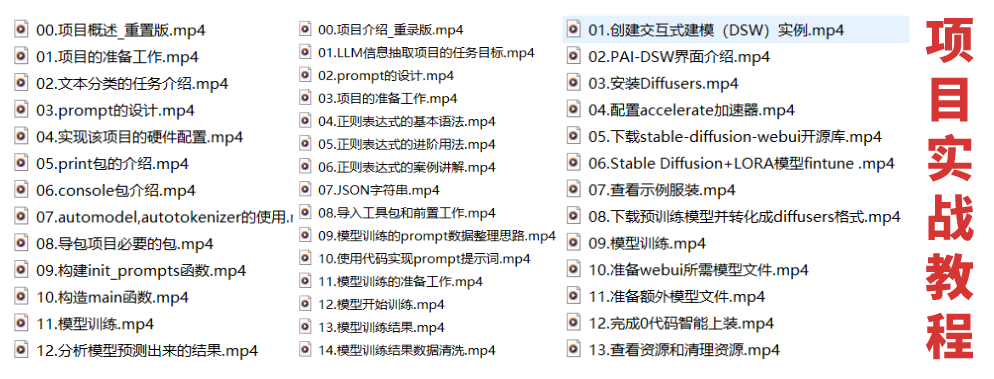

4. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

5. 大模型行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

为什么大家都在学AI大模型?

随着AI技术的发展,企业对人才的需求从“单一技术”转向 “AI+行业”双背景。企业对人才的需求从“单一技术”转向 “AI+行业”双背景。金融+AI、制造+AI、医疗+AI等跨界岗位薪资涨幅达30%-50%。

同时很多人面临优化裁员,近期科技巨头英特尔裁员2万人,传统岗位不断缩减,因此转行AI势在必行!

这些资料有用吗?

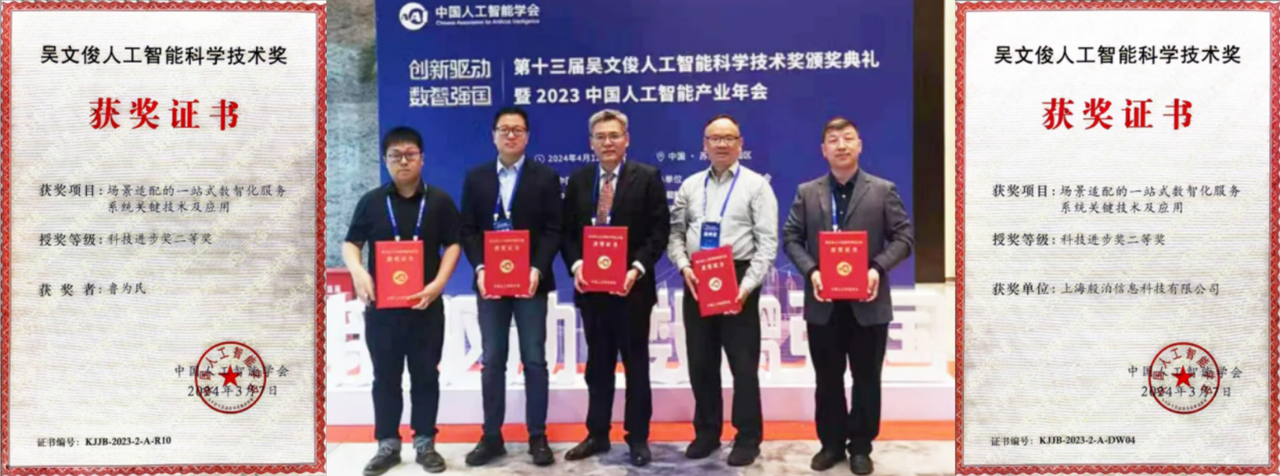

这份资料由我们和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

大模型全套学习资料已整理打包,有需要的小伙伴可以

微信扫描下方优快云官方认证二维码,免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?