知识蒸馏最早在2015年被诺贝尔物理学奖得主Geoffrey Hinton提出,在2025又被DeepSeek带火

看了许多介绍蒸馏技术的文章,我们希望把知识蒸馏这项技术的前世今生介绍给大家

一、模型压缩的提出

2006年的春天,英特尔刚刚发布第一个双核处理器 E6320(4 M 缓存、1.86 GHz),苹果也刚发布了第一台MacBook,而第一代iPhone还在乔布斯的实验室中孕育

当时研究机器学习学者们发现:用机器做预测,只要把足够多的模型组合在一起,不断叠加分析步骤,就能获得惊人的准确率

这种"集成学习"方法就像把决策委员会中请过来一千个专家,虽然决策准确,但每次决策都需要所有专家投票,既耗时又占空间。

在康奈尔大学的实验室里,Rich Caruana教授和他的学生们也面临着这个棘手的问题。

“我们的模型医疗诊断正确率高、粒子物理实验数据分析得不错、搜索引擎准确,但问题也很明显:模型动辄超过1GB!预测一个数据太久了!”

Caruana说,

"在高速粒子加速器中,每秒钟会产生数万次的粒子碰撞,每次碰撞都需要实时判断是否产生了有价值的物理现象。如果每个判断都需要2秒,那么绝大多数的碰撞事件都会被错过。

当你用2秒才能响应的老式相机去拍摄一场赛车比赛时,等你按下快门,比赛已经结束了,我们需要的是毫秒级的响应速度。"

深夜的实验室里,他们突然想到一个大胆的想法:

何不训练一个小模型来"模仿"这个大模型?

即用一个更小型的神经网络,从输入的数据自己学习最终的结果,绕过繁琐的决策

但问题是,训练神经网络来自主学习最关键的是需要大量的数据,为此,他们开发了一个叫MUNGE的算法

这是一种生成人工数据的方法,其核心思想是通过扰动真实样本来生成新样本,同时保持数据分布的关键特征,用这种生成的数据来训练小模型(神经网络)

大白话:给你一个数学题型,把条件和答案的数给你换一下再做一次,这样有了足够多的题目,给小模型做的题目也就丰富了起来。

最终用这些数据训练神经网络的结果令人振奋:

压缩后的神经网络平均大小为0.33MB,而原始集成模型平均大小为550.29MB,运行速度快了1000倍(原始模型处理10k样本需要5396秒,压缩后只需5.62秒),而且准确率几乎没有损失

这项技术最终被他们命名为"模型压缩"

二、知识蒸馏的诞生

2006-2015的9个春秋里,处理芯片随摩尔定律不断升级。

2014发布DDR4意味内存进入8GB时代,苹果新发布的6s手机也将移动设备带入2GB内存时代,神经网络也在向越来越深发展。

2015年的谷歌实验室里,Hinton看着Rich Caruana在9年前做的模型压缩方法,他提出了一个大胆的想法。

“将模型压缩就像大的模型把知识传递给小的模型,但知识的传递应该是多层次的。”

他一边敲击键盘,一边自言自语,

“不应该只盯着答案,过程也很重要。”

他把过去的模型压缩叫做硬目标(one-hot),在此之上提出了软目标(soft targets),硬目标传递结果,软目标传递中间的知识(软目标即模型输出的概率分布)

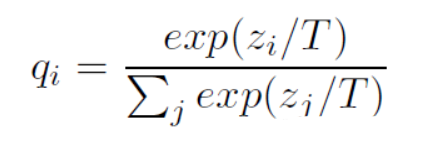

Hinton在软目标中引入温度系数(temperature),使用的概率分布如下:

大白话:当模型看到一张手写数字2的图片时,硬目标告诉模型这个数字是2,软目标告诉模型:这个图片可能90%像"2",9%像"3",1%像"7"

这种方式用概率分布把神经网络的部分中间信息保留(学习)下来,而这种细粒度的相似度信息对模型的泛化能力非常重要

Hinton最终将这种保留了结果信息与过程信息的模型压缩方法命名为知识蒸馏(Knowledge Distilling),知识蒸馏方法由此诞生

三、知识的追随者们

2015年深秋,蒙特利尔的枫叶正红得耀眼,Romero和他的同事们却始终在思考一个问题:为什么要把知识蒸馏局限在最后一层?(即用来训练小模型的知识一定是输出层的内吗?)

"你们看,"Romero指着显示器说,

“这第一层学到的是简单的边缘和纹理,第二层开始组合出更复杂的形状,到了最深的几层,已经能识别出完整的物体轮廓。这些层层递进的特征,不正是知识最本质的体现吗?”

——基于中间特定层输出的蒸馏诞生

他们的发现像涟漪一样在学术界荡开

2017年,来自韩国的研究员Yim更进一步:“离散的单一输出只是涵盖知识的部分内容,如果我们能够捕捉网络在处理信息时的’思维流’,也许能找到更本质的知识传递方式。”

于是他们提出了一个大胆的想法:用两层特征之间的关系来表示网络的解题思路:FSP矩阵

——从关注单一输出层到关注层与层之间关系的蒸馏诞生

四、算法创新

2017年,来自马里兰大学和佐治亚理工的研究者们设计了一个特殊的"判别器"网络

它像一位评委,专门对比学生模型和教师模型的输出

通过判别器网络的对抗性训练,让学生网络不断改进其输出分布,以接近教师网络的知识表示

——对抗性知识蒸馏算法就此诞生(Adversarial Distillation)

还有让多个专精不同领域的教师模型同时施教的算法

有的教师擅长捕捉细节特征,有的善于抽象高层语义,不同学科的老师各有所长,他们的知识通过精心设计的蒸馏过程,最终在学生模型中得到融会贯通。

——这就是Multi-Teacher Distillation

还有 Cross-Modal Distillation、Graph-Based Distillation、Data-Free Distillation…

如今,知识蒸馏已从一项简单的模型压缩技术,成长为一个充满活力的领域。

正如一位研究员所说:“知识不是独立的点,而是相互关联的网。要习得真正的智慧,就必须理解知识间的联系。”

五、DeepSeek的知识蒸馏技术

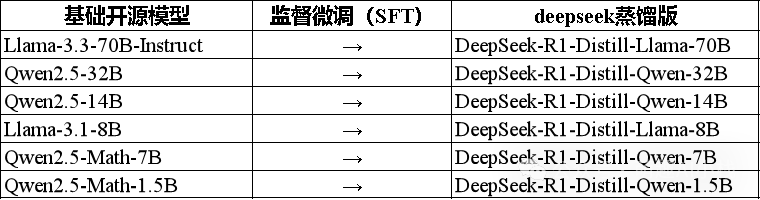

DeepSeek的知识蒸馏做法是

1、用DeepSeek R1来输出思维链和最终结果(共800k样本)

2、在较小的开源模型上做监督微调(SFT),选取的开源模型如下:

而DeepSeek蒸馏出来的小参数模型推理效果好于同样大小模型的原因则为,类似中间层蒸馏的输出蒸馏:

Hinton最早提出的蒸馏方法是基于大模型输出的结果做的蒸馏

这里是基于R1输出的结果做的蒸馏,因此蒸馏的知识类型依旧是输出结果

但是由于R1的输出结果包含大模型的思维链,因此知识中也包含了部分中间的推理过程,进而蒸馏出来的较小模型也会相较同参数大小模型更加“聪明”

至于使用体验,相信在经过互联网上铺天盖地的本地部署营销后,大家也知道了蒸馏后的实际效果肯定是不如满血版的

另外,他们在论文中也留下了这样一句话:

“For distilled models, we apply only SFT and do not include an RL stage, even though incorporating RL could substantially boost model performance.”

他们深知,仅仅依靠监督微调还远远不够——这只是通往卓越的第一步

通过强化学习等更先进的蒸馏方法,我们完全可以突破当前的瓶颈,让蒸馏后的小模型性能更上一层楼,未来说不定蒸馏后即可达到满血版性能

这个充满挑战的课题,正如一颗种子播撒在开源社区这片沃土上,未来也必定会有无数开发者不懈追寻,也必将有更轻巧、更智能的模型破土而出

本文参考论文:

- DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

- Knowledge Distillation: A Survey

- Model Compression

- Distilling the Knowledge in a Neural Network

- A Gift from Knowledge Distillation: Fast Optimization, Network Minimization and Transfer Learning

- Learning loss for knowledge distillation with conditional adversarial networks

- Fitnets: Hints for thin deep nets

六、如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 2024行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方优快云官方认证二维码,免费领取【保证100%免费】

264

264

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?