Ollama + Page Assist 本地部署一个可以联网搜索的大模型

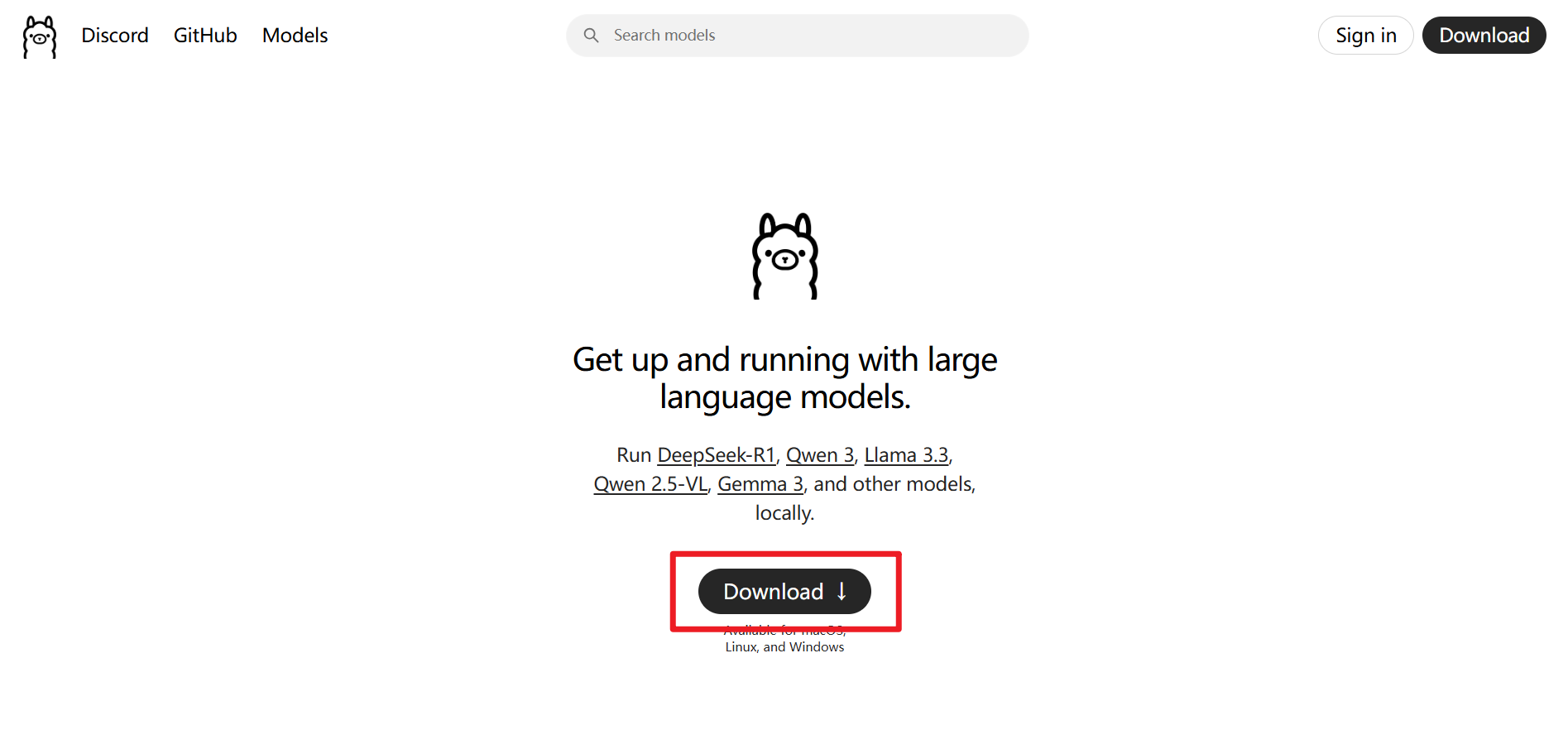

Ollama安装

官网:https://ollama.com/

1.点击下载安装ollama。

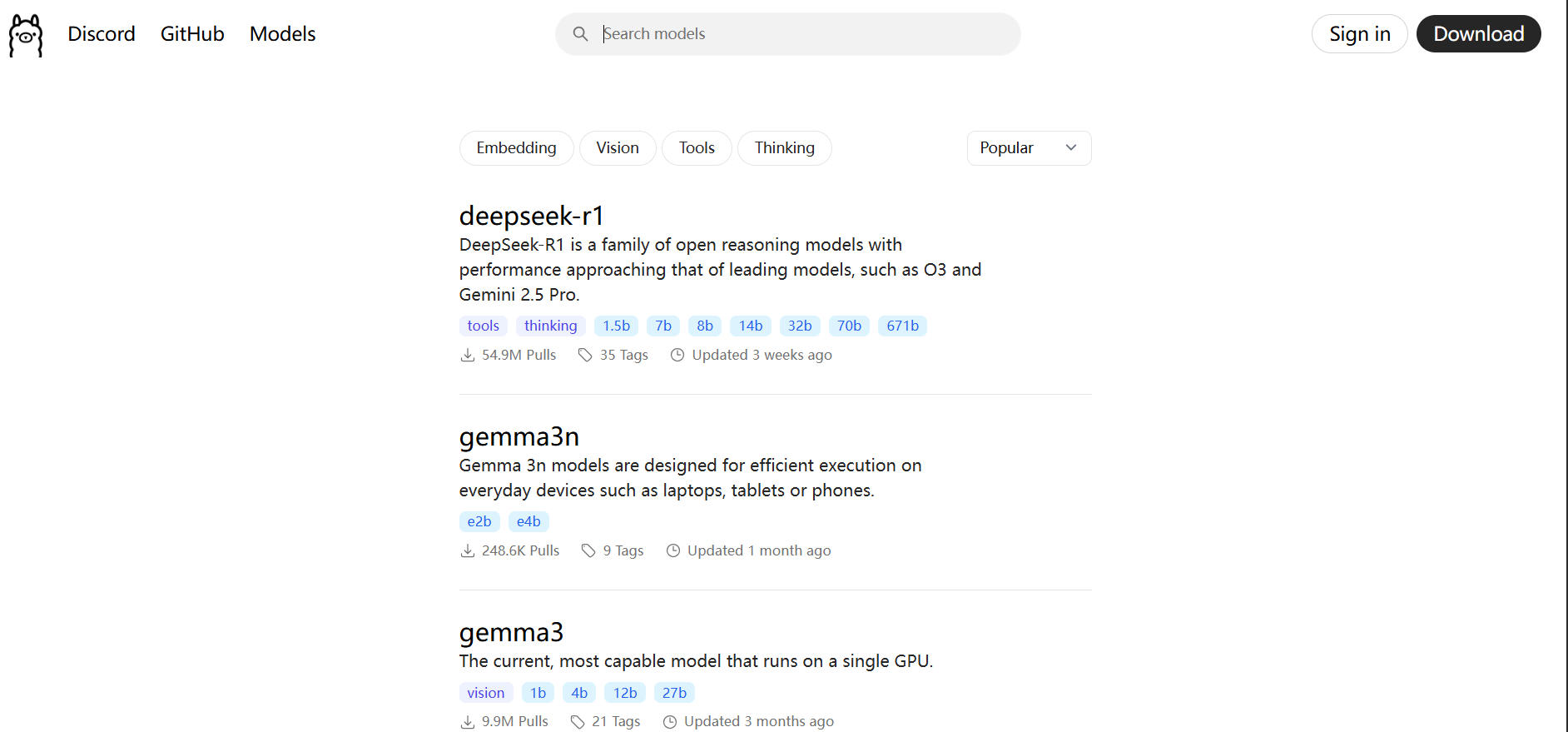

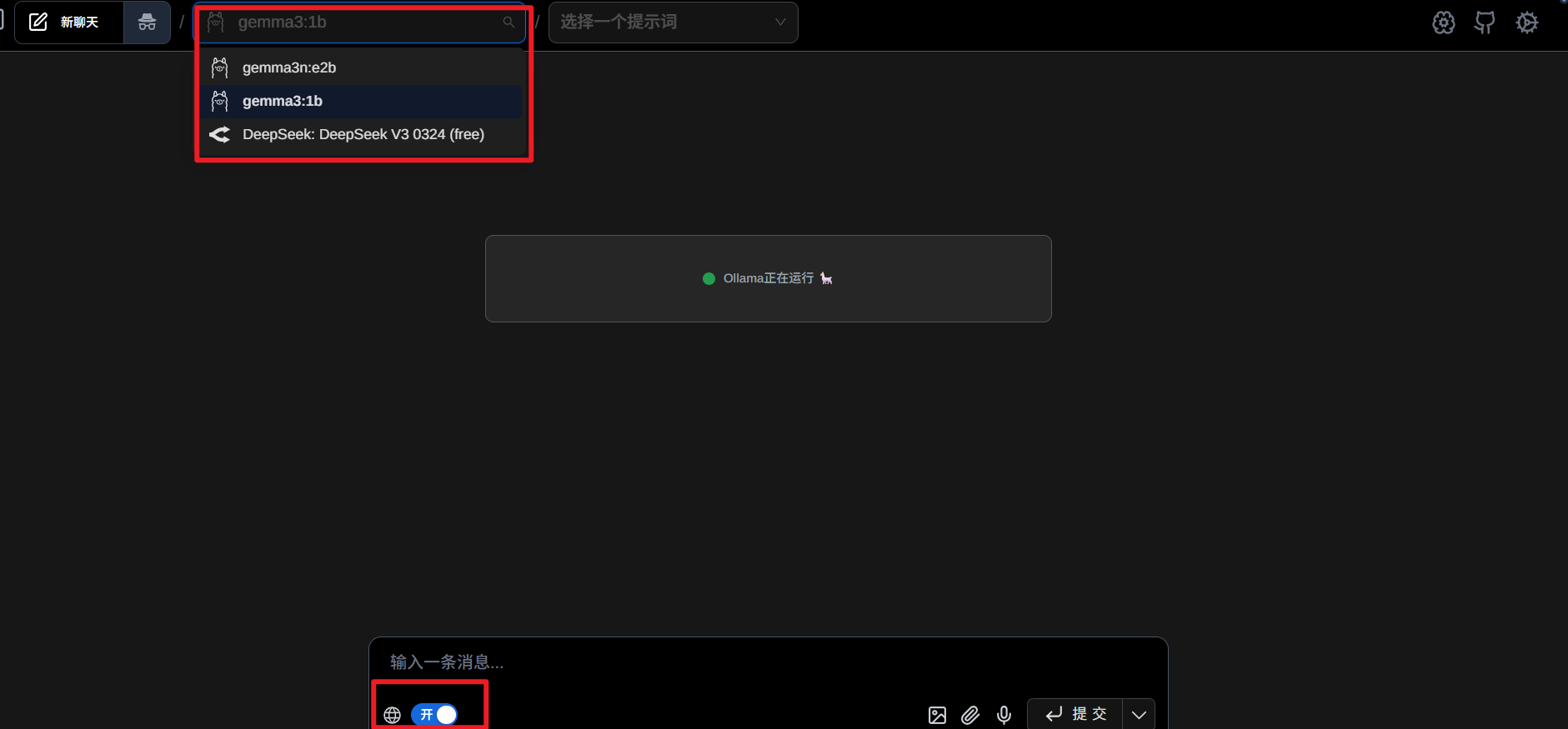

2.随便选一个你的设备能带动的模型,我是1050ti,所以只能选小大模型。我这里选择的是gemma3:1b这个模型。然后在电脑的终端(或者cmd)输入命令ollama run gemma3:1b,直接下载并且开始运行。

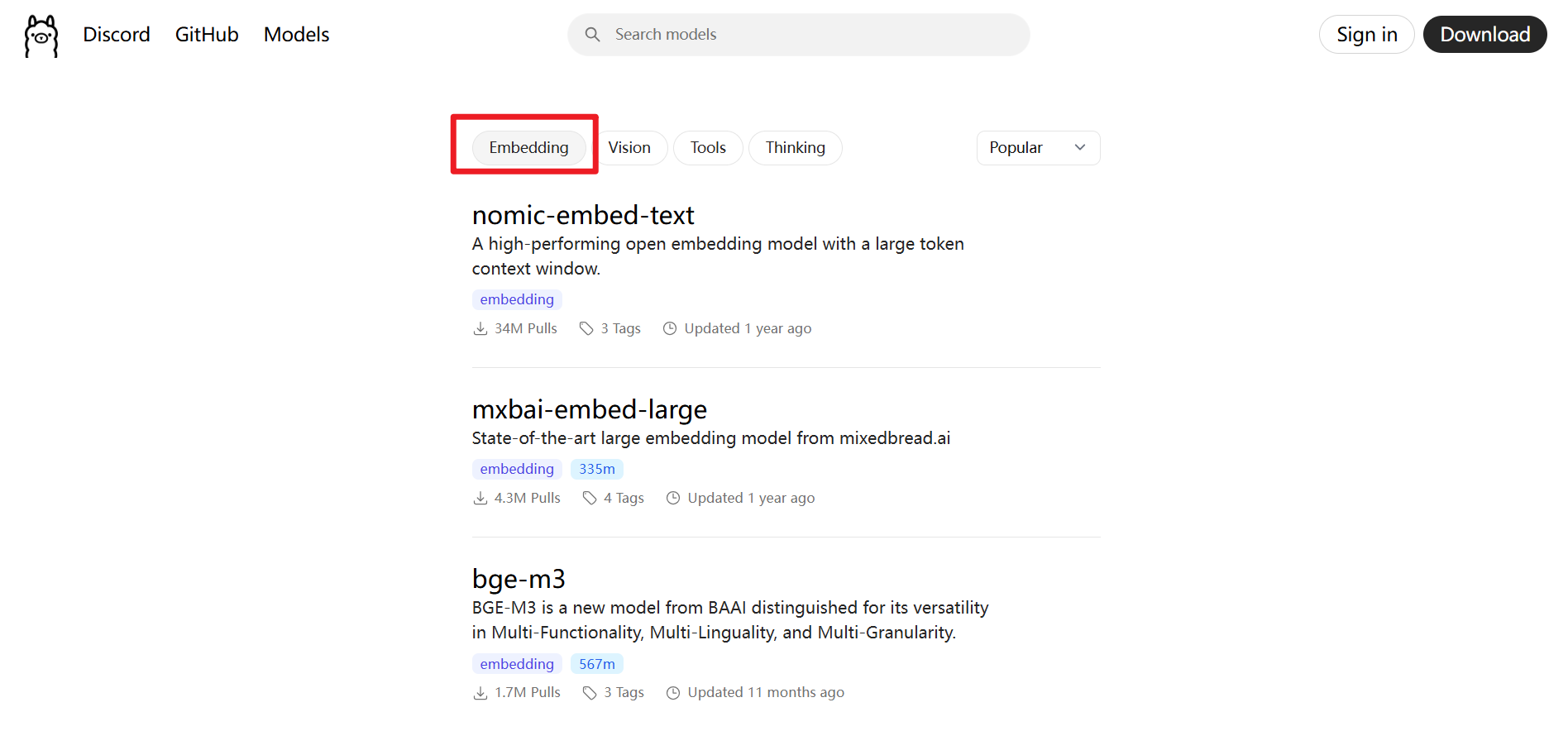

3.下载embedding模型。选一个热门的就行,例如这里的nomic-embed-text。

4.下载Page Assist的浏览器插件。Edge可以用扩展商店直接下载,或者你下载crx文件也行。

GitHub:https://github.com/n4ze3m/page-assist

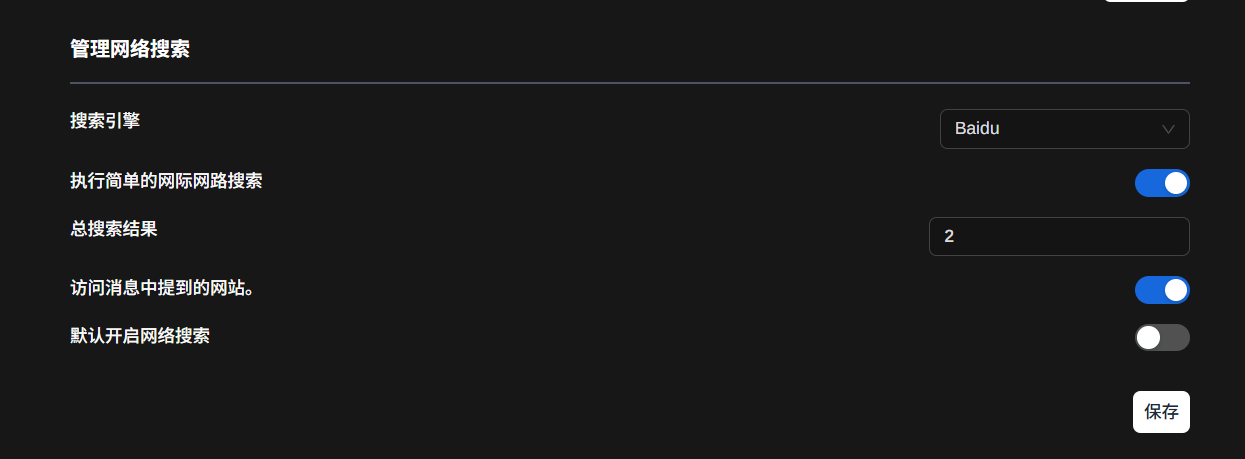

5.设置Page Assist的设置,以支持联网搜索和RAG检索增强搜索。

搜索引擎选择Baidu,Google和DuckDuckGO需要魔法,bing需要账号,比较复杂。(这个设置的位置在“一般设置”中)

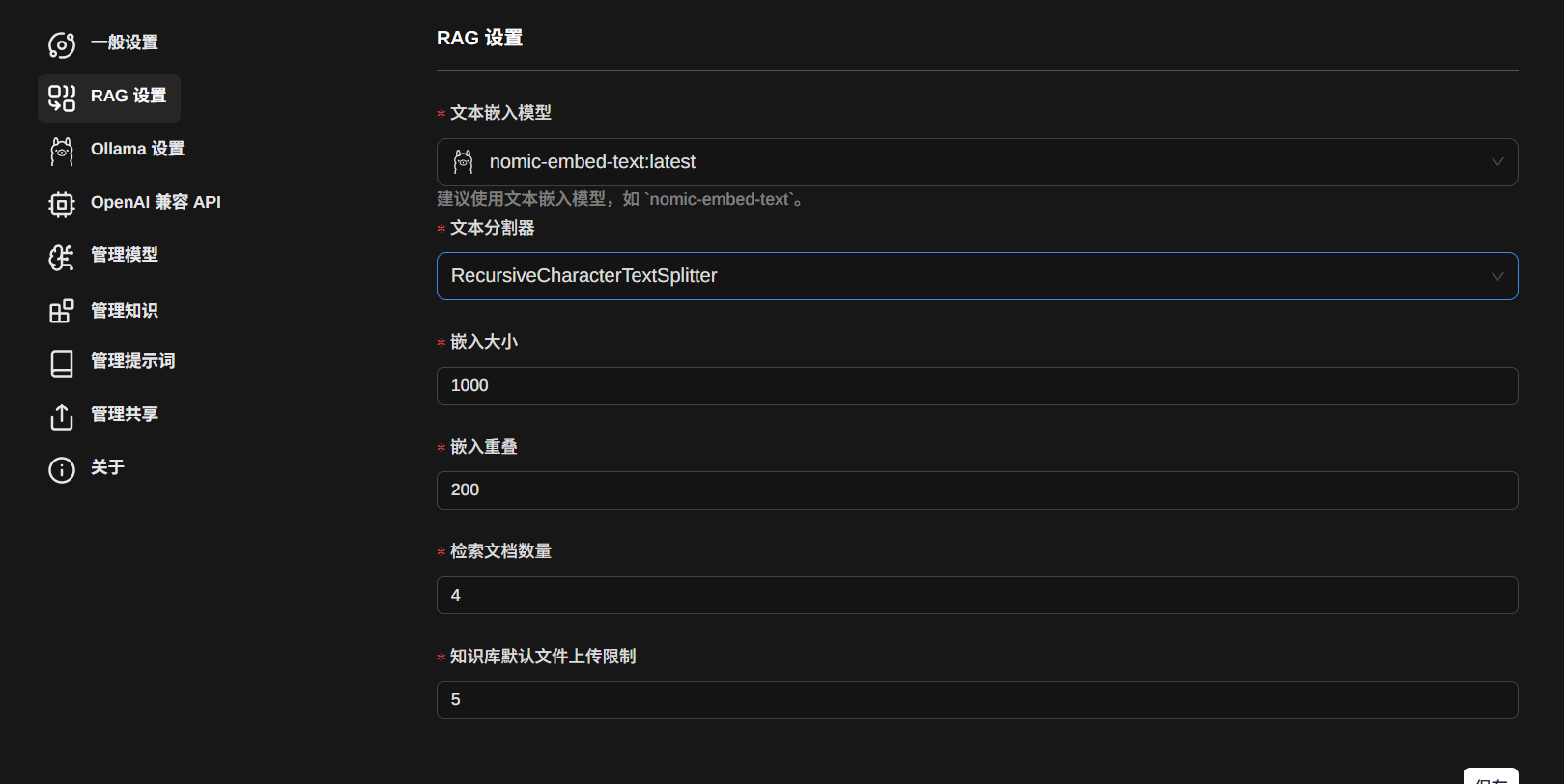

6.设置RAG。文本嵌入模型选择之前下载的那个模型。其他的可以不动。

7.然后就可以测试一下,是否成功联网。例如问今天是几号。

491

491

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?