点击下方卡片,关注“3D视觉之心”公众号

第一时间获取3D视觉干货

>>点击进入→3D视觉之心技术交流群

3D高斯的多视图不一致性

3DGS的出现显著地革新了新视角合成(Novel View Synthesis, NVS),在训练和渲染速度以及高保真度方面都取得了显著的进步。这项技术迅速被采用为各种任务的通用3D表示形式,包括3D场景感知、动态场景重建、同步定位与建图(SLAM)、3D生成与编辑等。

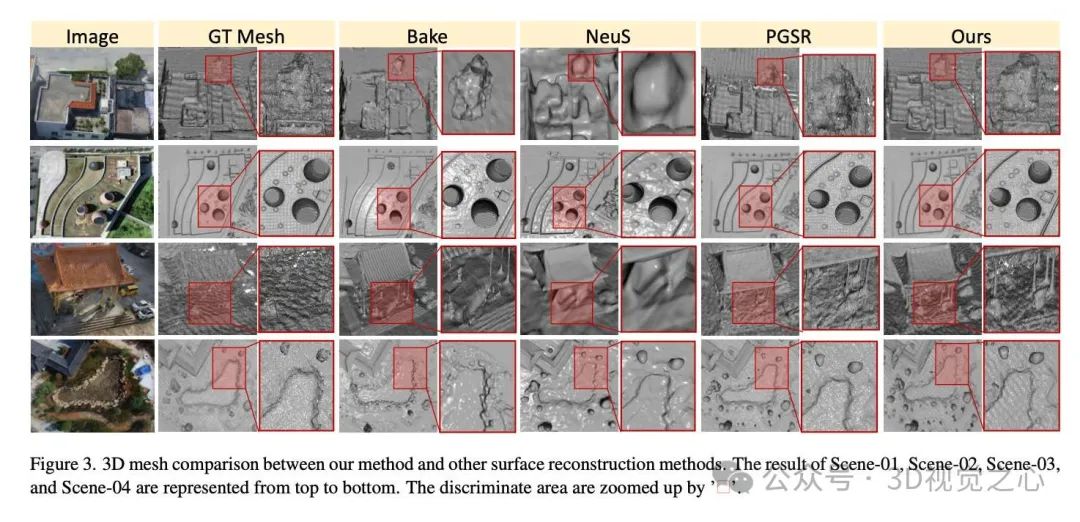

然而,由于3D高斯的多视图不一致性,3DGS在精确表示3D表面方面存在困难,从而限制了其在自动驾驶和城市规划等领域的应用。为了解决这一问题,近年来一些研究通过将3D高斯展平为定向椭圆盘并添加多视图几何约束,将3DGS扩展到表面重建。然而,在实际大规模场景中,这些方法不可避免地导致低几何精度、高内存成本以及过多的时间消耗。

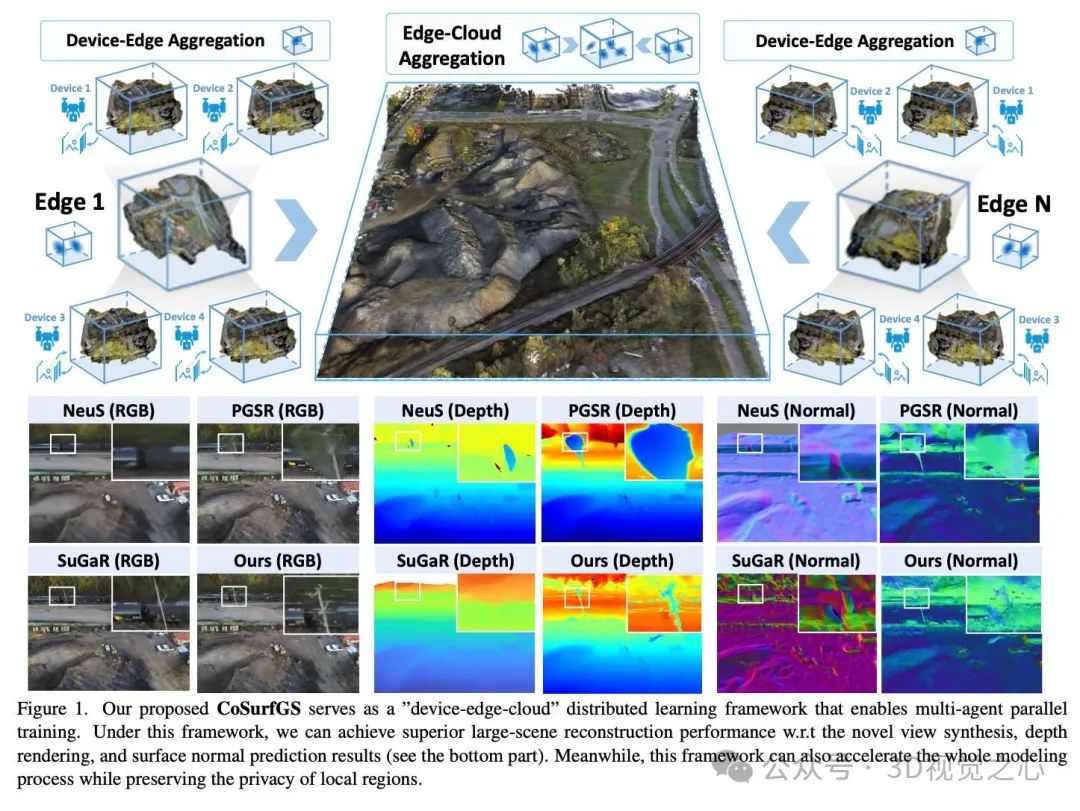

为了应对这些问题,设计了一个全新的框架,称为CoSurfGS[1],专注于大规模表面重建。在以下三个方面进行了优化:

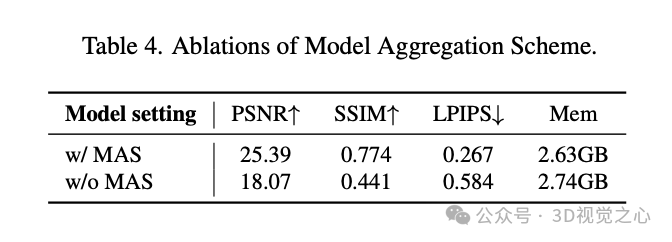

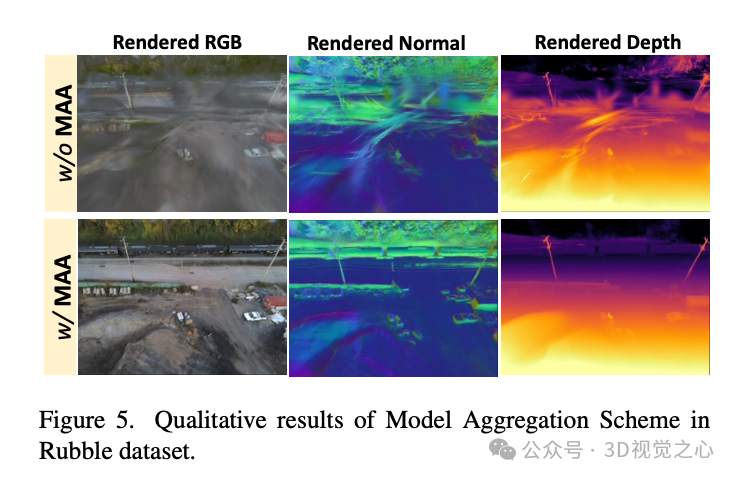

高质量表面:在大规模场景中实现高质量表面重建是一个挑战,因为单一的全局模型难以捕获场景结构的所有几何细节。为此,我们将表面几何优化问题从直接的全局场景优化转化为从局部区域到全局场景的渐进式过程。对于每个局部区域的表面几何优化,我们引入了单视图几何约束和多视图几何约束以获得局部3DGS模型。然后,为了逐步将局部区域的表面结构聚合到全局场景中,我们设计了一个模型聚合方案(MAS),该方案采用自知识蒸馏机制,以保持每个局部区域的关键结构并对齐相邻共视区域的表面几何。这两个步骤是实现大规模场景高质量表面的关键。

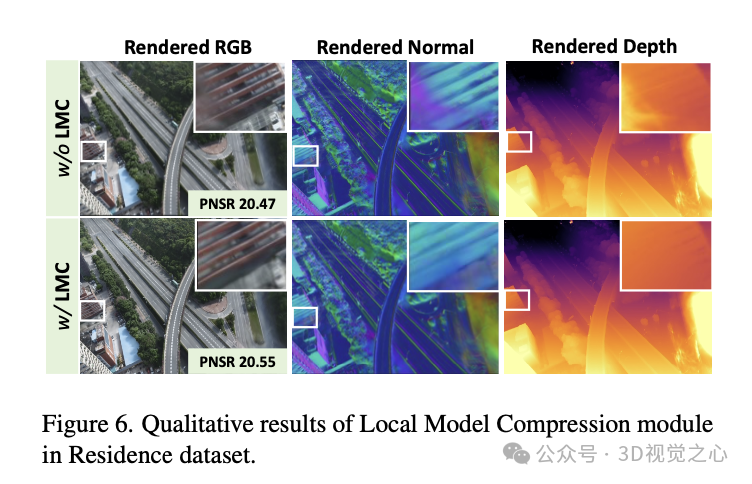

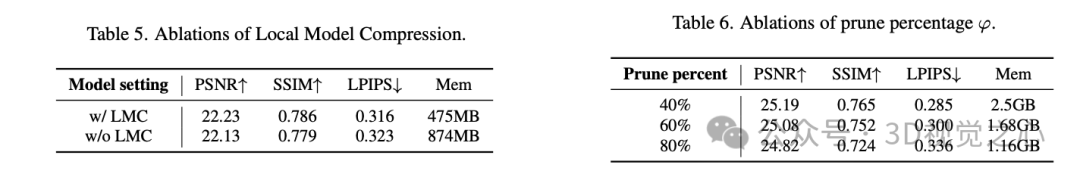

低内存成本:在大规模场景的表面重建中,内存成本是另一个关键问题。为了解决这一问题,我们在聚合到全局场景之前,对每个局部模型采用局部模型压缩(LMC)。这一策略基于一个发现,即在大多数情况下,局部模型之间会存在重叠区域,并包含许多冗余的高斯点。为减少这些冗余,我们定义了优先级分数,用于筛选缺乏多视图一致性且不透明度较低的高斯点。

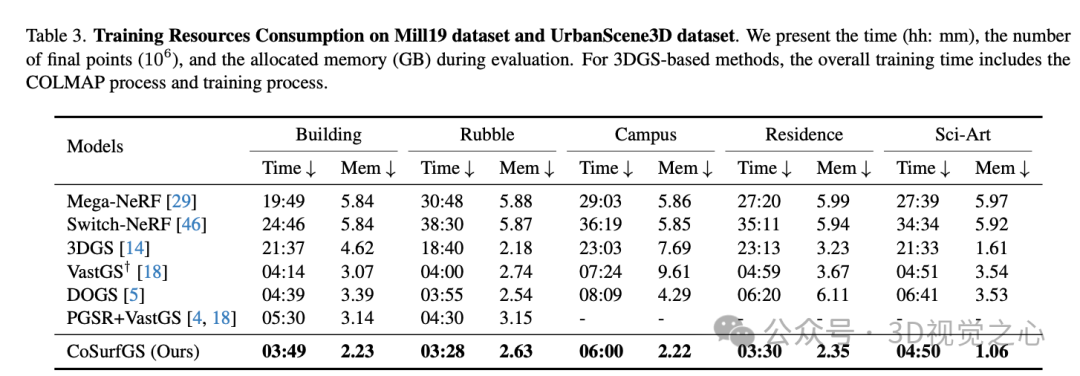

高速训练:除了内存成本之外,大规模场景重建的时间消耗也是一个难以忍受的问题。因此,加速整个训练过程具有重要意义。在我们的框架中,这一问题通过建立分布式框架得以解决,该框架允许设备之间进行并行的3DGS初始化和训练,从而显著减少了数据传输引起的延迟。此外,MAS和LMC的设计还能进一步加速全局模型的最终训练速度。

项目链接:https://gyy456.github.io/CoSurfGS/

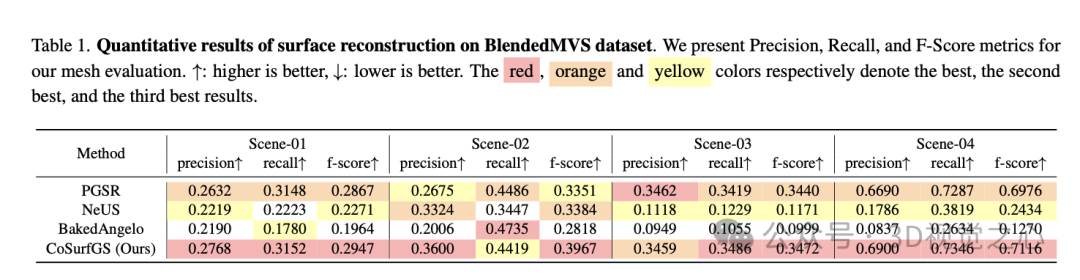

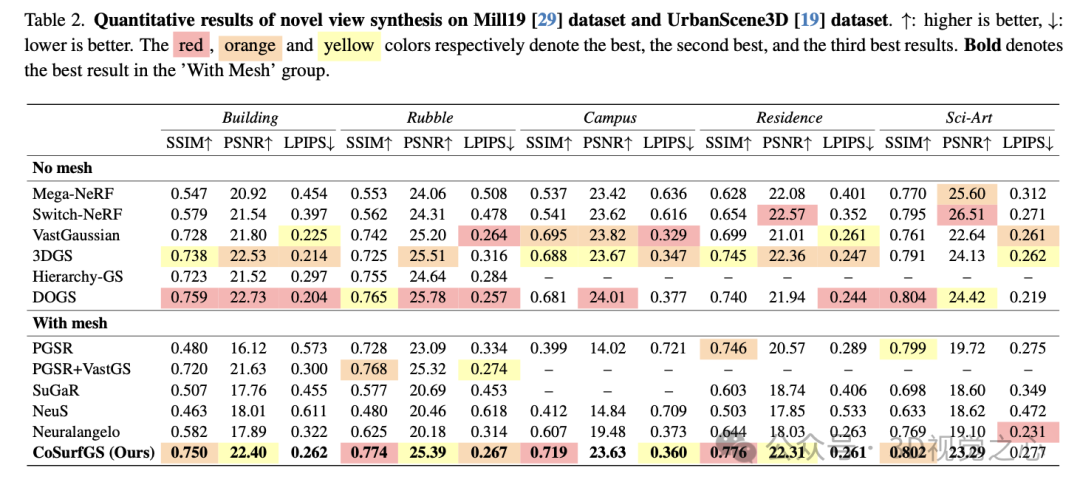

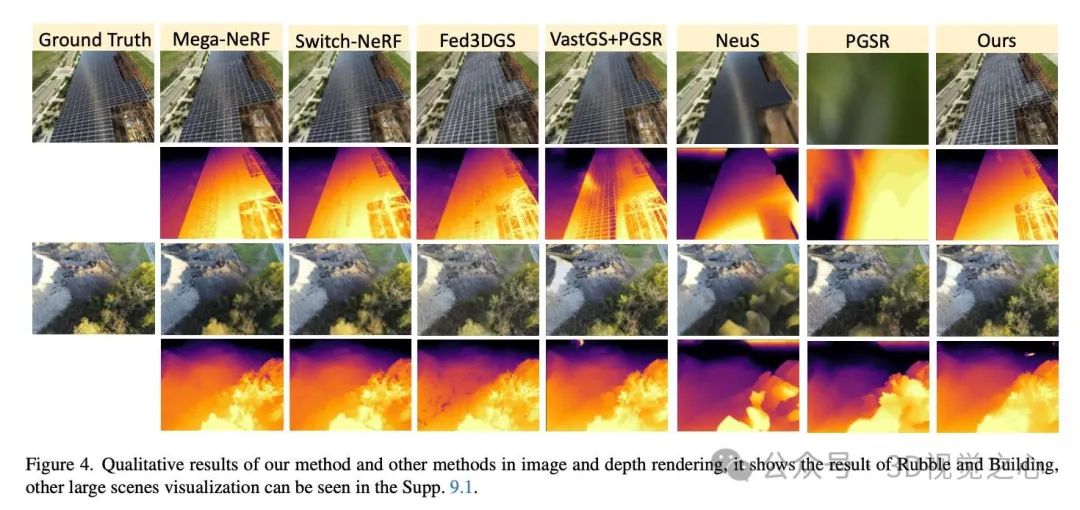

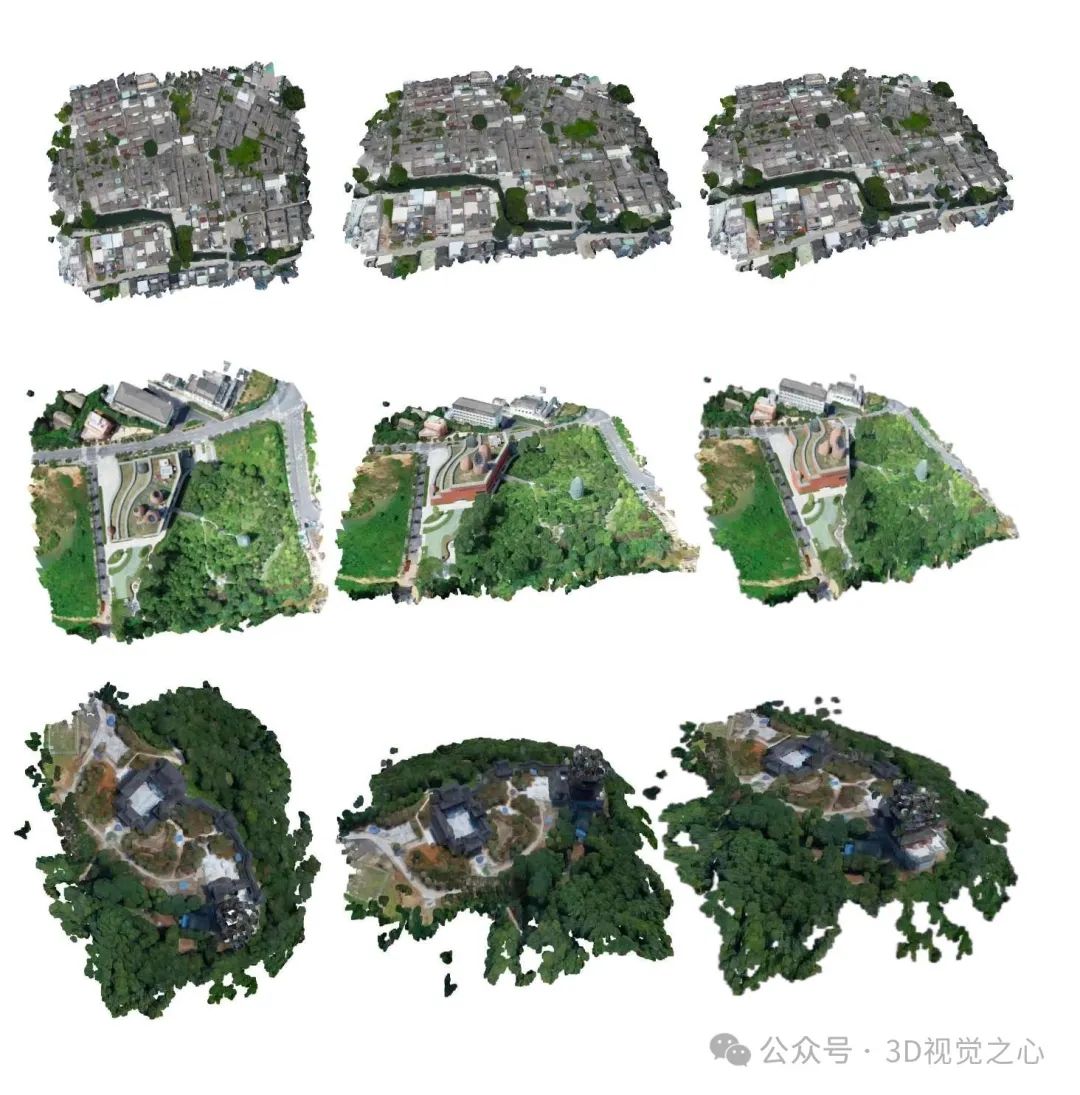

在两个数据集上进行了定量和定性评估。大量实验结果突出了我们方法的优越渲染质量和令人印象深刻的表面重建性能。我们的主要贡献包括:

提出了一种基于分布式学习的大规模表面重建协作方法,大幅减少了训练时间。

提出了局部模型压缩(LMC)和模型聚合方案(MAS),以实现更低GPU内存消耗的高质量全局场景表面表示。

综合实验表明,该方法在表面重建方面达到了最先进的性能,超越了现有的所有方法。同时,在新视角合成方面也提供了具有竞争力的结果。此外,与现有所有方法相比,CoSurfGS显著减少了训练时间和内存成本。

具体方法

整体框架

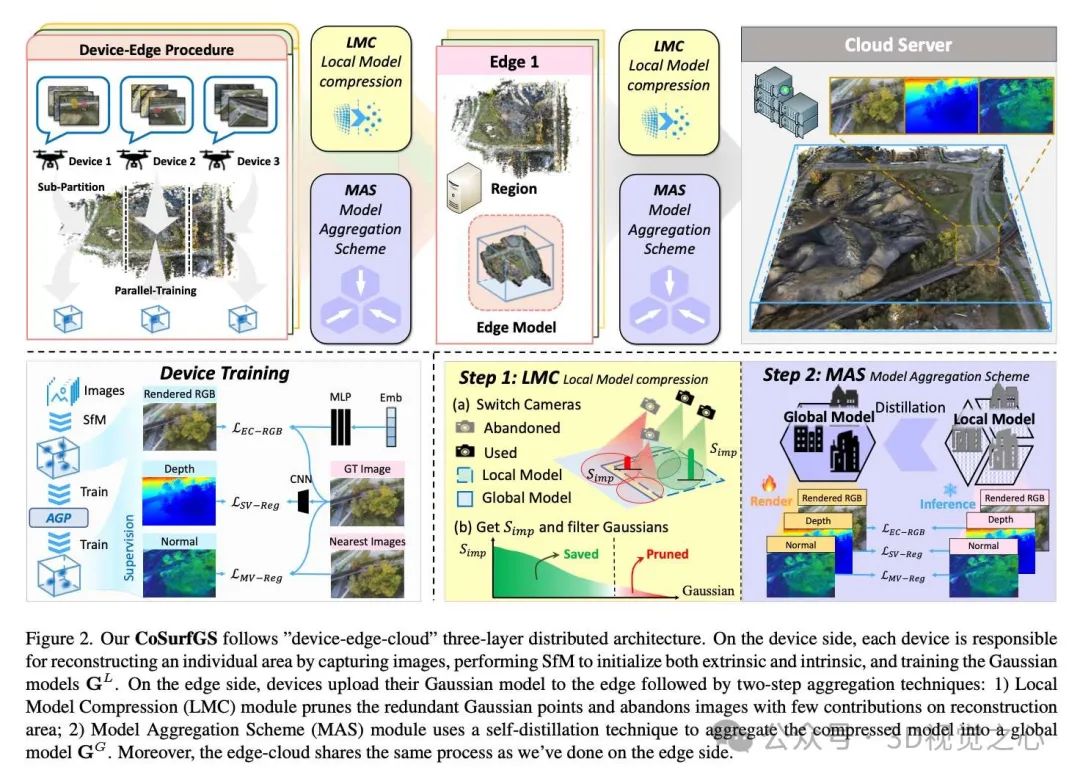

框架采用“设备-边缘-云”的架构,以实现分布式表面重建。在实践中,每个设备(如无人机)会捕获一定数量的图像,并训练一个高斯模型 (Gd_{i,j}),其中 (i) 和 (j) 分别表示第 (j) 个边缘中的第 (i) 个设备,(i \in [1, M], j \in [1, N])。随后,会执行设备到边缘的聚合过程,将 (M) 个附近设备的模型聚合到第 (j) 个边缘高斯模型中,表示如下:

其中,(f_{LMC}) 表示局部模型压缩过程,(f_{MAS}) 用于将设备的局部模型上传至边缘服务器并进行聚合,以获得第 (j) 个边缘模型 (Ge_j)。

采用相同的策略,我们将 (f_{MAS}) 和 (f_{LMC}) 应用于边缘-云聚合过程,用于大规模场景的分布式重建。最终公式如下:

通过仅上传高斯模型而非原始图像,该框架能够有效保护每个设备的隐私。从公式(4)和公式(5)可以看出,这两个过程都涉及从局部到全局的过渡。因此,在后续部分中,我们将设备-边缘或边缘-云聚合过程的输入称为局部模型 (Gl),输出称为全局模型 (Gg)。

设备端训练过程

针对第 (i) 个设备,受PGSR的启发,为了将3D高斯转化为2D平面表示,从而准确表示实际场景的几何表面,我们直接最小化每个高斯的最小缩放因子 (S_i = \text{diag}(s_1, s_2, s_3)):

。

在早期的学习阶段(即前 (τ) 次训练迭代中),我们仅专注于图像重建损失,采用原始3DGS的损失函数 (L_{3DGS}(I, I_{gt}) = (1 - \lambda)|I - I_{gt}|1 + \lambda L{SSIM}(I - I_{gt})) 和尺度损失 (L_s)。因此,第一阶段的损失函数为:

。

在第一阶段训练后,我们进一步在训练过程中引入PGSR的几何约束。使用的损失函数包含两个部分:单视图几何损失 (L_{svg}) 和多视图几何损失 (L_{mvg})。最终损失函数 (L) 表示为:

。

考虑到突然添加几何损失可能导致模型难以收敛并影响渲染质量,我们采用了平滑权重策略,逐步增加训练迭代过程中几何损失的权重,其中几何权重 (\lambda_i^{(t)}) 定义为:

ττ

其中 (t) 是训练迭代的索引,(T) 表示最大训练迭代次数,(\beta_i) 是超参数。

在上述训练过程中,高斯模型通过密化将会变得越来越大。尽管密化过程显著提高了渲染性能,但也会大幅增加高斯点的冗余以及内存成本。为此,我们采用了一种自适应高斯修剪(AGP)策略,以减少过参数化的高斯点数量,同时保留原始的准确性。具体来说,对于每个高斯点 (G_k = (x_k, \Sigma_k, S_k, \alpha_k), G_k \in G_d),我们将优先级分数 (S_{pro, k}) 与高斯点投影到图像平面视野的频率相关联:

,

其中 (M, H, W) 分别表示图像的数量、高度和宽度;(\mathbb{I}(\cdot, \cdot)) 是指示函数,用于确定某个高斯点是否与给定像素的光线相交;(\gamma(\Sigma)) 用于自适应衡量其体积维度,通过对所有排序后的高斯点的前90%进行归一化并限制范围为0到1。

通过公式(10)获得的优先级分数越高,表明该高斯点可以投影到许多图像平面上,且具有较大的尺寸和较高的不透明度;优先级较低的分数则表明其位于场景边界区域,缺乏多视图一致性且尺寸较小、不透明度较低。因此,我们可以通过引入超参数 (\phi) 轻松修剪高斯点。

局部模型压缩

为了减轻边缘或云端的GPU消耗,并在有限的训练周期内让全局模型更好地优化,有必要在将局部模型传输到边缘或云端之前减少其点冗余,特别是在靠近其他局部模型的区域。此外,由于局部模型训练的冗余高斯点缺乏多视图一致性,其几何表示通常不够准确,这会导致某些区域的几何模糊和不一致。

为了解决这些问题,我们提出了局部模型压缩模块 (f_{LMC}),将局部模型 (Gl) 压缩为 (\hat{G}_l)。在融合之前,为了精确移除冗余点,我们建立了一个修剪比例 (\Psi),该比例由局部模型与全局模型相机视角重叠的比例决定:

,

其中 (C_l = {K^l_k, E^l_k}),(C_g = {K^g_k, E^g_k}) 分别表示局部模型和全局模型的相机集合,(K^l_k)、(E^l_k) 分别为相机的内参和外参矩阵。

我们利用公式(10)计算在与全局模型视角不重叠的局部模型相机视角下,高斯点的优先级排序:

,

然后移除优先级分数最低的高斯点,比例由 (\Psi) 决定。

通过这种方式,局部模型中的冗余点可以被有效压缩,从而减少传输到边缘或云端的数据量,降低训练过程中的内存占用,并提高全局模型优化的效率。

模型聚合方案

为了将局部模型 聚合成全局模型 ,一种直观的想法是直接合并所有局部模型的高斯点:

。

然而,这种策略会在局部模型之间的边界区域引入明显的模糊。

以往的集中式方法通过两步优化解决了这一问题:扩展每个局部模型的训练区域,并在边界处修剪和合并模型。然而,扩展训练区域会增加训练时间和设备的计算资源消耗。此外,为扩展而收集相邻区域的图像可能会侵犯相邻设备的隐私。

为了解决边界模糊问题而不增加计算成本,我们采用了一种基于分布式学习的自蒸馏机制,以优化全局模型。首先,每个局部模型将其压缩模型 及其对应的相机 上传至全局服务器,用于初始化全局模型 。为了尽可能保持渲染质量和表面几何的准确性,我们将局部模型作为教师模型,利用其RGB、法向量和深度图来监督和优化全局模型 。由于高斯点已经足够密集,我们不再执行密化操作。全局模型 的优化公式为:

,

其中 表示RGB、深度和法向图的渲染过程。与设备端训练类似,我们使用尺度损失 和单视图几何损失 来组成 ,以保持高斯点的平面特性和单图像的几何一致性。此外,我们进一步引入深度损失 和法向损失 ,用于约束大规模场景表面的深度和法向一致性,定义如下:

,,

其中 是局部模型渲染的深度图和法向图, 是全局模型渲染的深度图和法向图。

优化完成后,我们根据高斯点的不透明度和尺寸修剪冗余高斯点,从而得到一个优化后的全局模型。

实验效果

总结一下

CoSurfGS是一种“设备-边缘-云”框架,以实现分布式表面重建。针对设备-边缘和边缘-云聚合过程,所提出的LMC模块可以消除局部模型之间的冗余高斯点,而MAS模块有助于优化合并的全局模型。在UrbanScene3D、MegaNeRF和BlendedMVS数据集上的大量实验表明,该方法在表面重建精度、时间消耗和内存成本方面均达到了最高水平,同时渲染质量与当前最先进的方法相当。

参考

[1] CoSurfGS:Collaborative 3D Surface Gaussian Splatting with Distributed Learning for Large Scene Reconstruction

本文仅做学术分享,论文汇总于『3D视觉之心知识星球』,欢迎加入交流!

【3D视觉之心】技术交流群

3D视觉之心是面向3D视觉感知方向相关的交流社区,由业内顶尖的3D视觉团队创办!聚焦三维重建、Nerf、点云处理、视觉SLAM、激光SLAM、多传感器标定、多传感器融合、深度估计、摄影几何、求职交流等方向。扫码添加小助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

扫码添加小助理进群

【3D视觉之心】知识星球

3D视觉之心知识星球主打3D感知全技术栈学习,星球内部形成了视觉/激光/多传感器融合SLAM、传感器标定、点云处理与重建、视觉三维重建、NeRF与Gaussian Splatting、结构光、工业视觉、高精地图等近15个全栈学习路线,每天分享干货、代码与论文,星球内嘉宾日常答疑解惑,交流工作与职场问题。

2103

2103

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?