论文信息

论文标题:Exploring Large-Scale Language Models to Evaluate EEG-Based

Multimodal Data for Mental Health

发表会议:UbiComp Companion '24 - CCF-A

论文作者: Yongquan Hu etc. —— University of New South Wales

论文链接:https://dl.acm.org/doi/pdf/10.1145/3675094.3678494

关键词: Mental Health, EEG, Large Language Model, Prompt Engineering.

研究背景

-

心理健康评估的多模态需求: 世界卫生组织将心理健康定义为个体能够应对日常压力并为社区做出贡献的状态。抑郁、焦虑等心理疾病正日益对全球经济造成沉重负担,传统评估多依赖自报问卷,易受主观因素干扰。生理信号(如 EEG、HRV、EDA)因其难以伪装和高可靠性,被广泛用于辅助诊断,但往往是单一模态分析,难以全面反映心理状态。

-

LLM 作为“健康代理人”的潜力: 随着 GPT-4 等大规模语言模型对多模态数据处理能力的提升,将 LLM 引入心理健康评估领域,有望通过零样本或少样本提示(prompting)结合 EEG、面部表情、音频/文本等多源信息,实现更精准的状态分类与干预。但现有工作多聚焦单模态,尚缺乏将 EEG 与视觉、音频等多模态深度融合的系统性研究。

主要贡献

- 提出 MultiEEG-GPT 框架: 利用 GPT-4o 单一接口同时处理 EEG 拓扑图、面部表情或音频(文本与音频特征)三种模态,形成统一的多模态心理健康评估方法。

- 零样本与少样本 Prompt 设计: 设计了灵活可扩展的零样本(zero-shot)与 1-shot 少样本 prompting 模板,能够无缝增减模态并集成示例标签,验证 LLM 在不同提示策略下的分类能力。

- 跨三大数据集实证: 在 MODMA(抑郁二分类)、PME4(七类情绪)和 LUMED-2(三类情绪)三个包含 EEG 与音频/面部表情的公开数据集上进行了对比试验,系统展示了多模态融合对分类性能的显著提升,并对零样本与少样本策略进行定量分析。

方法设计与实现

数据集选取

-

MODMA:抑郁障碍二分类,包含 EEG 拓扑图与口语音频。

-

PME4:七情绪分类(愤怒、恐惧等),含 EEG、音频、视频(视频未公开)与 EMG。

-

LUMED-2:三情绪分类(中性、快乐、悲伤),含 EEG、面部表情图像与 GSR。

本文分别选取 EEG + 音频(MODMA、PME4) 与 EEG + 面部表情(LUMED-2) 作为融合模态,以聚焦 GPT-4o 对 EEG 信息与其他模态的协同处理能力。此处使用的三个数据集都是公开数据集,可以上网下载。

Prompt 工程

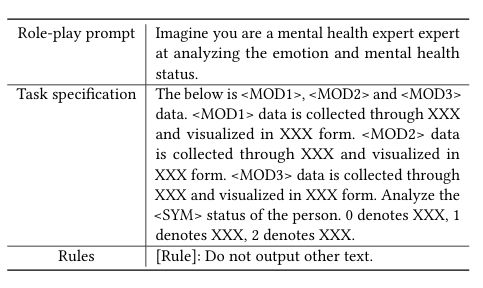

- 零样本提示: 包含角色扮演(mental health expert)、任务描述(模态来源与可视化形式)、分类标签说明与输出规则三部分,模板结构为:

{角色扮演} + {任务说明<MOD1><MOD2><MOD3>} + {规则:仅输出分类结果}

- 少样本提示: 在上述零样本模板末尾附加一个正确分类示例,作为对比基准,随机选取 1 个样本进行 1-shot 实验,以评估示例对模型判断的增益。

实验设置

-

模型与接口: 基于 OpenAI Azure 的 GPT-4o-2024-05-13 接口,内置多模态处理能力,无额外 Chain-of-Thought 或微调策略。

-

数据预处理: EEG 使用 MNE 库进行 0.1–45Hz 带通滤波与平均重参考;提取 10 个等间隔拓扑图;音频提取 MFCC、Mel 频谱等特征并以文本形式输入;面部表情取视频中间帧。

-

评估方法: 在每个数据集上进行 5 次重复实验,报告平均准确率及标准差,比较单模态、双模态及无模态(多数投票基线)下零样本与少样本的表现。

实验结果与分析

零样本 (Zero-shot)

| 模态组合 | MODMA (抑郁) | PME4 (七情绪) | LUMED-2 (三情绪) |

|---|---|---|---|

| 无模态基线 | 50.00% | 14.28% | 33.33% |

| EEG | 53.79% | 21.05% | 34.61% |

| 音频/表情单模态 | 69.35% (音频) | 15.38% (音频) | 38.46% (表情) |

| EEG + 音频/表情 | 73.54% | 28.57% | 46.13% |

少样本 (1-shot)

| 模态组合 | MODMA (抑郁) | PME4 (七情绪) | LUMED-2 (三情绪) |

|---|---|---|---|

| EEG + 音频/表情 | 79.00% | 37.00% | 52.73% |

-

多模态优于单模态: 在所有数据集上,EEG + 音频/表情都显著领先于单一 EEG 或音频/表情,使准确率平均提升约 7%–14%(相对增益)。

-

少样本 > 零样本: 1-shot 提示相比零样本增强约 5%–8% 准确率,表明示例对复杂多模态特征学习有显著帮助

。 -

模型鲁棒性: 在随机选取的少样本中,标准差较小(约1.5%–3.2%),表明 GPT-4o 对提示示例存在一定一致性。

总结一下

优势

-

端到端多模态接口: GPT-4o 一次调用内置图像+文本解析能力,简化管道设计。

-

零/少样本通用性: 无需专门微调,提示工程即可达接近传统机器学习水平的性能。

-

EEG 融合意义: 实验证明将 EEG 与视觉/音频结合,可捕捉更多互补信息,提升心理状态识别精度。

局限与改进空间

- 规模与数据多样性: 仅选用三个小规模公开数据集,难以代表临床多样场景。

- 提示工程依赖: 当前工作未探索更复杂的推理链(CoT)或分层策略,未来可结合指南微调。

- 隐私与伦理: LLM 可能记忆敏感信息,需在数据预处理与 “忘 却” 机制上加强保障。