论文信息

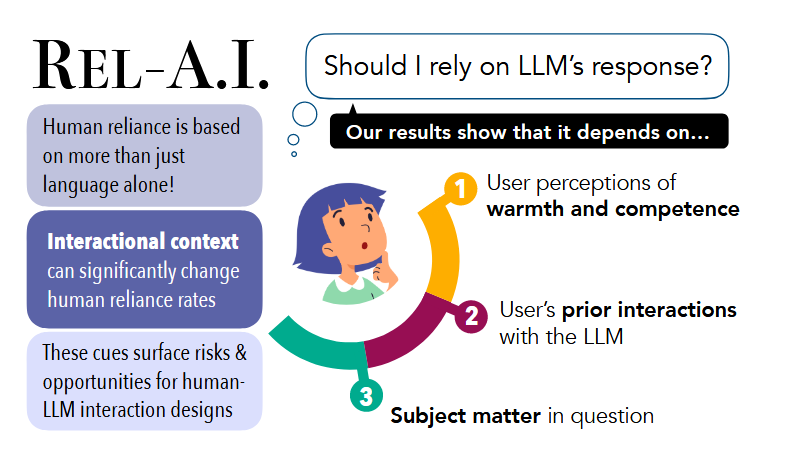

论文标题: REL-A.I.: An Interaction-Centered Approach To Measuring Human-LM Reliance - NAACL 2025

论文作者: Kaitlyn Zhou,Jena D. Hwang et al.- Standford, USC, CMU

论文链接: https://arxiv.org/abs/2407.07950

研究领域: Human-AI Interaction, LLM Evaluation&Safety, AI Psychology, Overreliance.

研究背景

随着大型语言模型(LLMs)能力的提升,其应用场景日益复杂。为了确保安全,现有的评估主要集中在 校准(Calibration) 上,即模型的预测概率是否与其准确率相匹配(例如,模型说有80%的把握,准确率是否确实为80%),换句话说就是 测评的是模型的基础能力(比如回答的正确率)。

然而,作者指出仅靠 语言校准(Verbal Calibration) 不足以衡量人机交互的安全性。原因如下:

- 人类行为的不确定性: 即使模型给出了校准过的置信度表达(如“我不确定”),人类在实际交互中是否会采取正确的行动(如去查证而非盲信)是未知的。

- 交互语境的影响: 人类对模型的依赖 (Reliance) 不仅取决于模型说的话,还受到交互语境(如模型的拟人化程度、过往的交互历史、话题领域)的显著影响。

也就是说,围绕模型的基础能力的评估并不能满足真实场景下的人机交互的安全需求,换句话说,基础能力的测试并未考虑到人的参与。因此,本研究提出了从模型为中心(Model-centered) 转向 以交互为中心(Interaction-Centered) 的评估视角,旨在测量在具体的交互语境下,人类实际依赖模型生成的程度。

核心贡献:REL-A.I. 框架

为解决上面提到的问题,作者提出了一个名为 REL-A.I. 的评估框架。用于评估基于人类信赖(Reliance) 行为的 LLM 的风险。信赖(Reliance)是一种可通过用户行动观察到的行为,而信任(Trust)是信赖的一种特殊情况,涉及可变的心理状态。

框架的设计原则(Desiderata)

- 情景评估(In Situ Evaluations): 通过将用户置于模仿真实世界、信息检索需求的游戏化场景(trivia game)中,鼓励用户积极参与,并测量在不同交互情境(如环境扰动)下,人类信赖行为的变化。

- 系统级评估(System-Level Evaluations): 要求用户在一次实验中与多个不同的系统互动,以便用户为每个系统建立不同的心智模型(mental models),从而评估情境如何影响系统层面的信赖。

- 稳健的信赖测量(Robust Reliance Measurements): 通过让同一参与者信赖两个不同的系统,以衡量个体内部(intra-subject)的相对信赖分数,从而减轻受试者之间差异带来的干扰。

核心组成部分

REL-A.I. 包含三个核心组件:

-

自我激励任务(Self-Incentivized Task):

- 参与者玩一个猜谜游戏,必须决定是信赖人工智能代理给出的包含认知标记(如“我确信是…”)的回复开头,还是选择自己查找答案。

- 模型预测的完整答案永远不会显示,这确保了模型准确性不影响信赖行为。

- 用户正确信赖得分,错误信赖失分,自己查找得零分。

-

源自LLM的认知标记(Epistemic Markers):

- 任务中使用的(不)确定性表达是从九个公开部署的 LLM 中提取的最常用表达。

- 这些标记分为三类:

- 增强词(Strengtheners):高置信度,如 “我确信它”

- 弱化增强词(Weakened Strengtheners):中等置信度,如 “我相信是…”、“我觉得可能是…”

- 弱化词(Weakeners):低置信度,如 “我不确定…”

-

元认知感知问卷(Meta-level Perception Questions):

- 在任务结束后,通过事后问卷询问参与者对 AI 代理的感知。

- 问题包括对代理的温暖度(warmth)、能力度(competence)和人性化程度(humanlikeness)的 5 点李克特量表评分,以及他们是否愿意再次与该代理合作(是/否)。

实验设计与主要发现

该研究利用 REL-A.I. 框架测试了三个新兴的交互情境可能如何加剧人类的过度信赖。

RQ1: 模型的呈现方式(拟人化/问候语)如何影响依赖?

RQ1 关注 LLM 的呈现方式(如问候语)对人类信赖的影响。

实验设置: 参与者与一个控制代理( A c o n t r o l A_{control} Acontrol,用于作为基准,正则化 A g r e e t A_{greet} Agreet 的结果)和一个实验代理 ( A g r e e t A_{greet} Agreet) 互动,两个代理在回复和认知标记的使用上相同,但 A g r e e t A_{greet} Agreet 随机地在回复开头加入问候语(例如:“I’m happy to help!”)。

主要发现:

- 简单的问候语(如“I’m happy to help!”)会引发显著更高的信赖。

- 感知的能力度、温暖度和人性化程度都与信赖率的变化呈强相关。

- 基于对能力度的不同感知,信赖率差异高达 30%

- 与人类感知不同(人类中温暖度提高,能力度可能下降),在 AI 代理中,感知温暖度增加时,感知能力度并未下降,反而略有增加。(是一种非液压关系,但为什么是非液压关系呢?)

主要结论: 拟人化的“友好”特征会掩盖风险,导致用户过分信赖模型。

RQ2:过往的交互历史(模型自信程度)如何影响依赖?

RQ2 关注用户对 LLM 历史表现形成的心智模型对后续信赖决策的影响。

实验设置: 参与者与两个代理互动:一个通常自信的代理( B c o n f B_{conf} Bconf)(只使用增强词和削弱增强词),以及一个通常不自信的代理( B u n c o n f B_{unconf} Bunconf)(只使用削弱增强词和削弱词)。研究测量在这两种系统中,对相同的削弱增强词(中等确定性表达,如“I’m pretty sure it’s…”)的信赖率差异。

主要发现:

- 当表示中等确定性的表达出现在一个通常自信的模型中时,其被信赖的频率显著低于出现在一个通常不自信的模型中时(分别为 52% 对 57%)。

- 例如,像“I’m pretty sure it’s…”这样的表达在不自信系统中被信赖的频率高出 20%。

- 这些结果表明,(不)确定性表达的含义会根据它们出现的总体信心分布而变化。

- 在感知层面, B u n c o n f B_{unconf} Bunconf 被认为能力度更低(2.45/5 分)且人类更不愿意再次合作(39.8% vs. 74%)。

主要结论:

- 对比效应: 同样的“中等置信度”表达,如果出自一个通常很自信的模型,用户依赖它的概率反而比出自一个通常不自信的模型要低。(这一结论是否可以用于其他的交互场景?)

- 现象解释: 用户建立了心理模型。对于自信的模型,稍微降低一点语气被解读为“它可能错了”;而对于不自信的模型,稍微肯定的语气被解读为“它这次很有把握”。

RQ3:话题领域(Domain)如何影响依赖?

RQ3 关注交互的知识领域是否会影响信赖行为。

实验设置: 参与者与五个代理互动,代理回复的问题来自五个不同的主题领域:大学数学、抽象代数、哲学、世界宗教和法律。所有代理表达相同程度的信心。

主要发现:

- 主题偏见: 人类的依赖行为因主题而异。用户在(如数学、代数)对LLM的依赖度显著高于非计算领域(如法律、哲学)。

- 数据支持: 对于计算密集型的主题(如数学和抽象代数)的回答,信赖率高于非计算型领域(如哲学、世界宗教和法律)。

主要结论: 用户可能错误地认为LLM是类似计算器的“计算型机器”,而忽略了其本质是概率预测模型,这在数学领域尤其危险。

主要结论

该研究通过 REL-A.I. 框架证明,先前的交互、模型的温暖度以及交互的主题领域都可能影响人类在何时选择信赖 LLM 的相同(不)确定性表达。

- 重新定位评估指标: 仅关注语言质量的评估是不足的;研究人员必须转向评估人类-LLM 交互,因为交互情境未被考虑时,即便是语言校准“完美”的模型也可能导致意想不到的人类行为反应。也就是说 我们应该跳出原有的针对模型能力的评估,转向更为复杂的真实的人机交互场景的评估。

- 问候语的成本(Cost of greetings): 建立更具人性化和亲切感的 LLM 可能会带来意想不到的风险,因为它很容易改变用户的感知能力度,而这与信赖率有显著关联

- 建议: 建议 NLP 研究人员和设计者在系统公开发布之前,使用 REL-A.I. 等以交互为中心的测量方法(真实场景下的评估),评估人机交互的重新配置将如何影响人类信赖行为,以确保交互的安全性。(换句话说,如果真实的评估 用拟人的 Agent 来进行呢?)

局限性

- 单轮交互: 研究仅关注单轮问答,未涉及多轮对话中的依赖动态变化。

- 文化与语言限制: 参与者均为美国用户,问题仅限英语。文化差异可能影响对确定性表达的理解。

- 特定表达: 仅测试了特定的认知标记,未涵盖所有可能的表达方式。

REL-A.I. 框架的工作方式就像一位产品质量检测员,不仅检查产品(LLM 的回答)本身的结构和标签(语言校准和认知标记),更重要的是检查用户在实际使用环境中对该产品的反应。如果一个药瓶(LLM)的标签(认知标记)正确地标明了药效(不确定性),但因为瓶子的设计(温暖度、历史表现)让人觉得它特别可靠,即使药效不明(中等确定性),用户仍可能会过度依赖,那么这个产品在现实世界的安全性就是存在问题的。REL-A.I. 关注的正是这种“用户实际行为”而非“产品标签准确度”的评估。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?