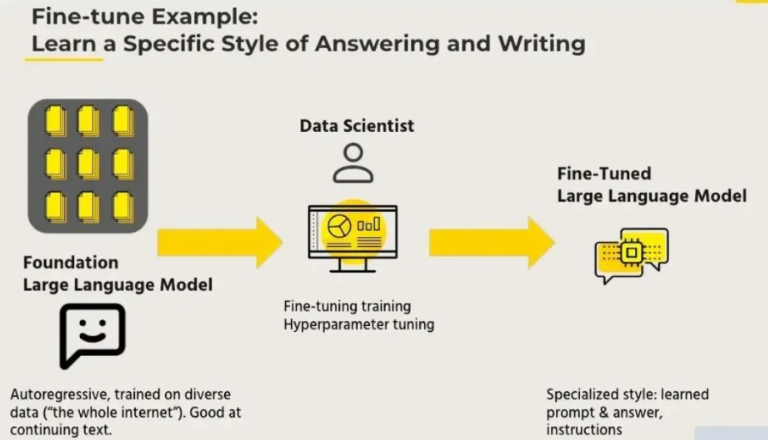

Fine-tuning

在生成式AI和大语言模型(如GPT、LLaMA)的快速发展与应用中,微调(Fine-tuning)作为模型适配特定任务的核心技术环节,其关键作用毋庸置疑。

本文将系统阐述三种主流微调方法:Prompt-tuning、Prefix-tuning和LoRA,全面解析各类技术的实现机制、优势特征及适用领域。

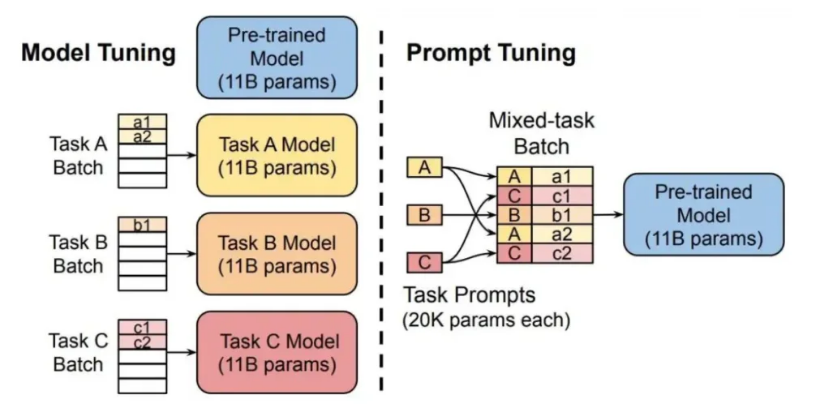

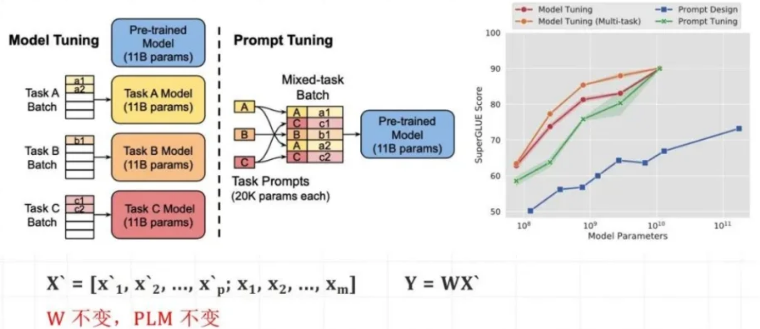

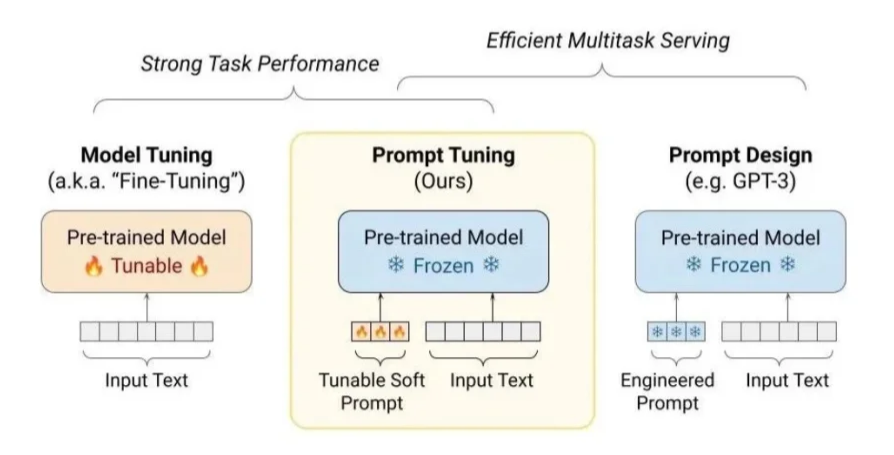

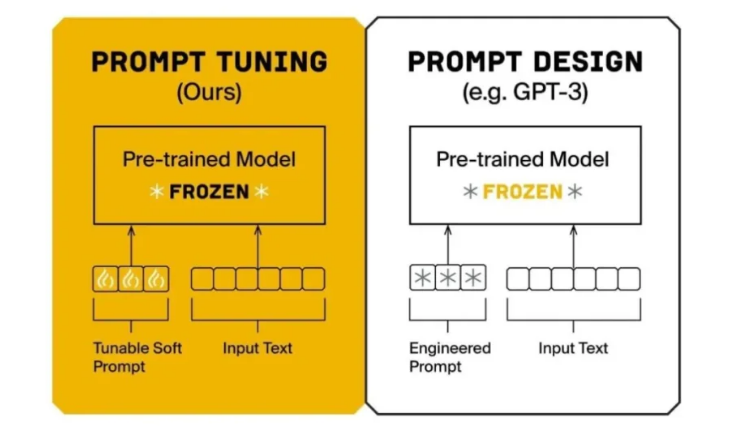

方式一: Prompt-tuning

什么是Prompt-tuning?Prompt-tuning是一种通过调整输入提示(Prompt)来指导模型产生特定任务或场景所需输出的技术,它不需要对整个模型的参数进行微调。

该技术充分发挥了预训练语言模型(PLM)在零样本或少样本学习中的优势,通过优化输入提示来激发模型内存储的相关知识和功能。

Prompt-tuning

核心原理: PLM(预训练模型)不变,W(模型的权重)不变,X(模型输入)改变。

如何进行Prompt-tuning?

通过设计任务相关的提示模板,使小模型适配下游任务,同时调整提示嵌入(PromptEmbeddings)来引导预训练模型适应特定任务需求。

该方法仅需对少量提示嵌入进行微调,无需修改整个模型的参数。

设计提示模板:

模板中应包含任务描述、输入文本占位符、输出格式要求等元素。

准备数据集:

数据集应包括输入文本、真实标签(对于监督学习任务)或预期输出格式(对于生成任务)

微调提示嵌入:

在预训练模型的输入层添加提示嵌入层,使用数据集对模型进行训练,特别是微调提示嵌入。

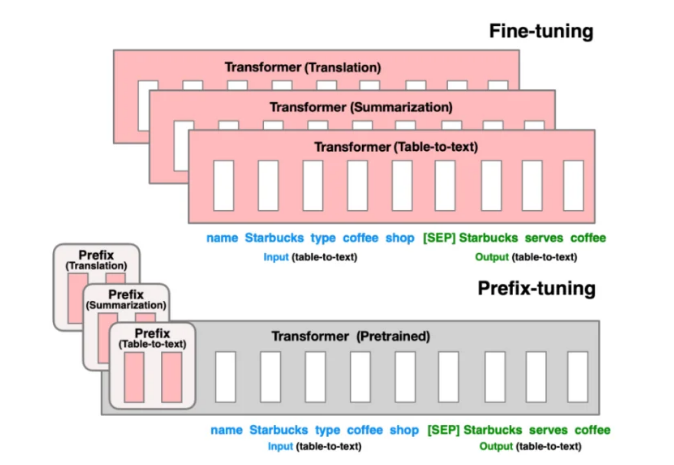

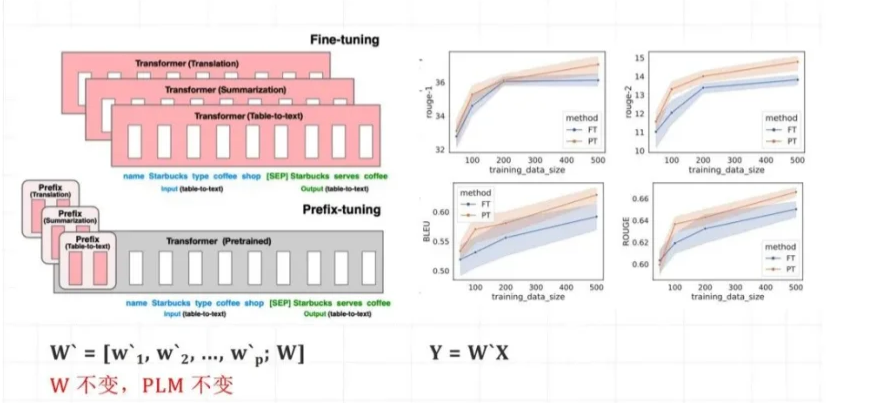

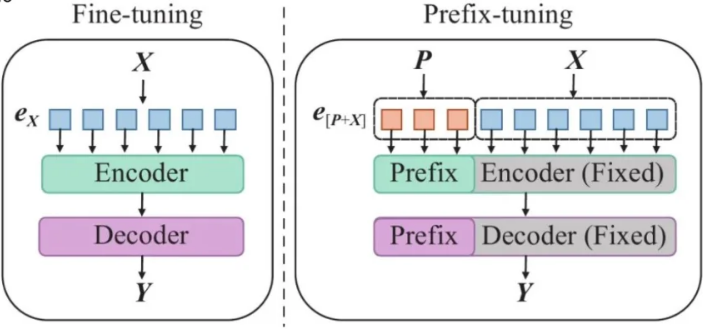

方式二: Prefix-tuning

什么是Prefix-tuning?Prefix-tuning是Prompt-tuning的一种改进方法,其核心思想是在输入序列前端插入可训练的"前缀"参数来引导模型执行任务。

这些前缀参数会与原始输入共同参与注意力计算,从而调控模型对输入信息的编码方式。

由于前缀参数具备可训练特性,它们能够在模型微调阶段针对不同任务进行优化,有效提升模型在新场景下的适应能力。

Prefix-tuning

核心原理: PLM(预训练模型)不变,W(模型的权重)不变,X(模型输入)不变,增加W(前缀嵌入的权重)。

如何进行Prefix-tuning?在Transformer 中适配下游任务

在Transformer模型的输入层或各层输入前添加可学习的前缀嵌入,并通过训练这些前缀嵌入来优化模型在特定任务上的表现。

初始化前缀嵌入

在Transformer模型的输入层之前,初始化一个固定长度的前缀嵌入矩阵。

将前缀嵌入与输入序列拼接

将初始化好的前缀嵌入与原始输入序列的词嵌入进行拼接,形成新的输入表示。这个新的输入表示将作为Transformer模型各层的输入。

训练模型

在训练过程中,模型会根据输入序列(包括前缀嵌入)和标签数据进行学习。通过反向传播算法,模型会更新前缀嵌入的参数。

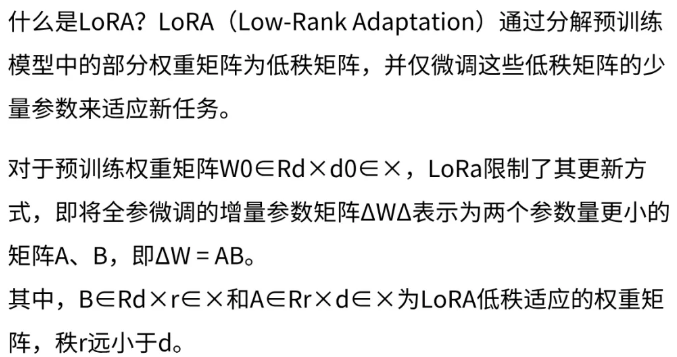

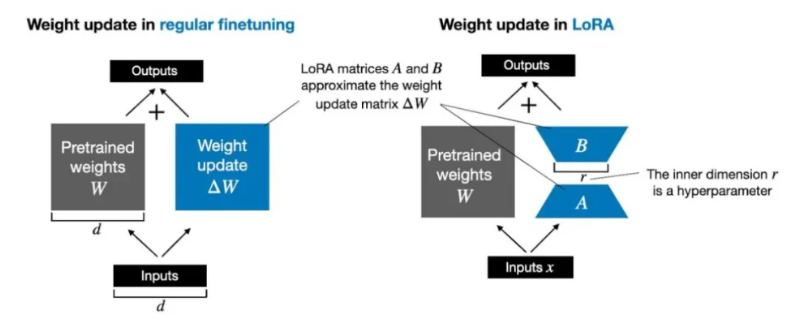

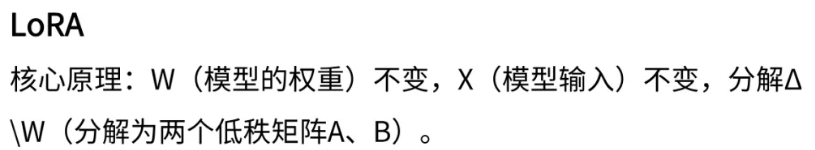

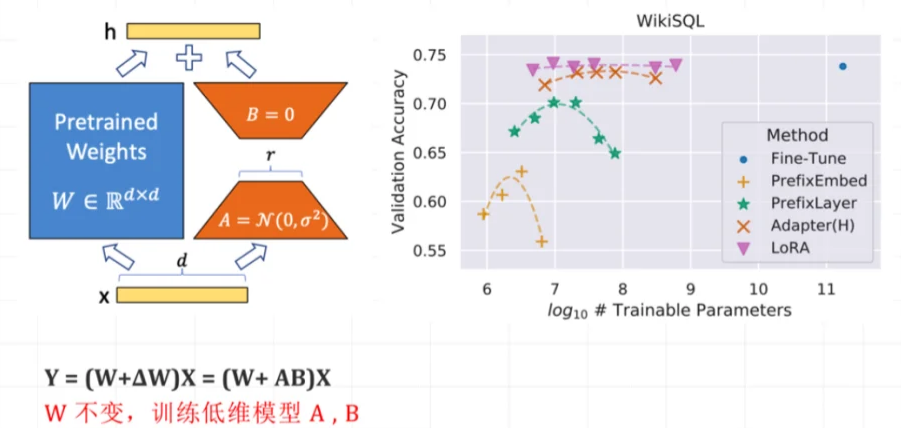

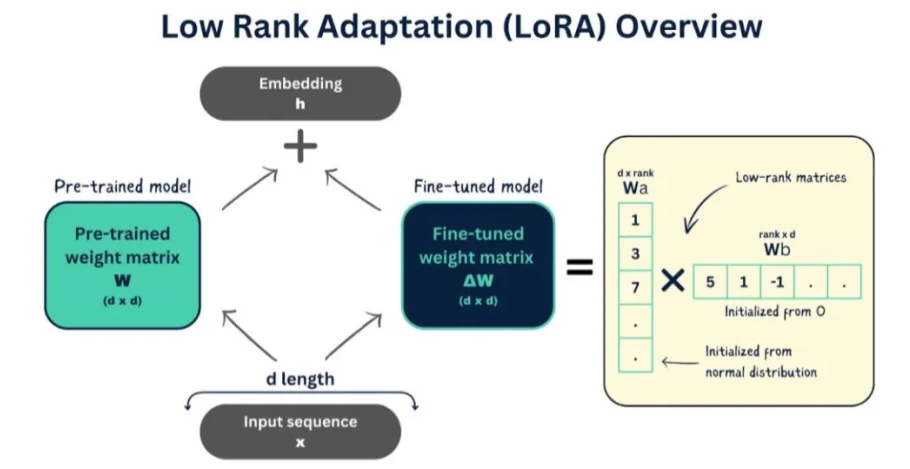

方式三: LORA

如何进行LORA微调?在冻结预训练模型权重的基础上,通过优化算法训练低秩矩阵A和B以近似增量参数,最小化下游任务损失从而实现高效的模型微调。

设置LORA模块

在预训练模型的基础上,添加LORA模块。LORA模块通常包含两个参数量较少的矩阵A和B,它们的乘积用于近似全参数微调中的增量参数。

初始化矩阵A和B,通常使用高斯函数进行初始化,以确保训练开始时LORA的旁路(即BA)为0,从而与全参数微调有相同的起始点。

训练LORA模块

在训练过程中,冻结预训练模型的权重,仅训练LORA模块中的矩阵A和B。

通过优化算法(如Adam)更新矩阵A和B的参数,以最小化下游任务的损失函数。

LLaMA-Factory通过集成LORA微调方法,为大型语言模型提供高效、低成本的微调方案,支持多模型、多算法和实时监控,仅训练低秩矩阵实现快速适应新任务。

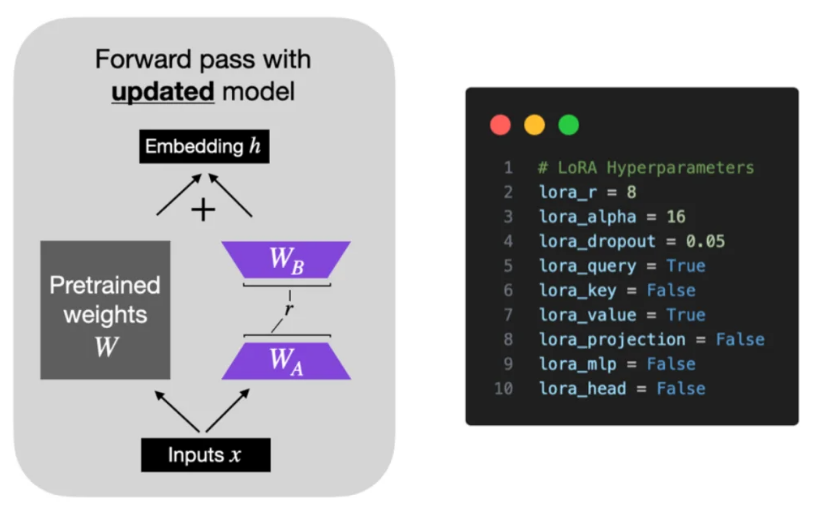

LORA参数主要包括秩(lora rank,影响性能和训练时间)、缩放系数(lora alpha,确保训练稳定)和Dropout系数(lora_dropout,防止过拟合),它们共同影响模型微调的效果和效率。

1.秩(Rank)

参数名称:lora_rank

描述:秩是LORA中最重要的参数之一,它决定了低秩矩阵的维度。

常用值:对于小型数据集或简单任务,秩可以设置为1或2;对于更复杂的任务,秩可能需要设置为4、8或更高。

2.缩放系数(Alpha)

参数名称:lora_alpha

描述:缩放系数用于在训练开始时对低秩矩阵的更新进行缩放。

常用值:缩放系数的具体值取决于秩的大小和任务的复杂度。

3.Dropout系数

参数名称:lora_dropout

描述:Dropout系数决定了在训练过程中随机丢弃低秩矩阵中元素¢撓瞀鏌宬的概率。

常用值:Dropout系数的常用值范围在0到1之间。

如何学习AI大模型?

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

这份完整版的大模型 AI 学习和面试资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

701

701

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?