时间序列处理领域迎来新突破!NeurIPS'2025科研团队提出的LSTM与卡尔曼滤波融合模型,直接解决了两者单独使用时的痛点,LSTM动态调参不灵活、卡尔曼滤波难适配非线性数据,成了近期研究热点。

要知道,LSTM擅长抓时序数据的长期依赖和非线性规律,卡尔曼滤波则在抑噪、动态状态估计上拿手。这次的融合模型刚好互补:用卡尔曼滤波实时调整LSTM参数,在工业故障预测中预警准确率升25%;还能结合多模态数据,让智能安防误报率降30%,实用性拉满。

想发论文的伙伴,可从跨模态融合、复杂噪声鲁棒性入手;我整理了23年到25年的论文,顶会/顶刊论文+论文写作技巧等等全部打包免费送,感兴趣的同学扫码领取~

扫码回复 “977C” 领取

免费获取全部论文+部分代码

Application of a long short‑term memory neural network algorithm fused with Kalman filter in UWB indoor positioning

文章解析

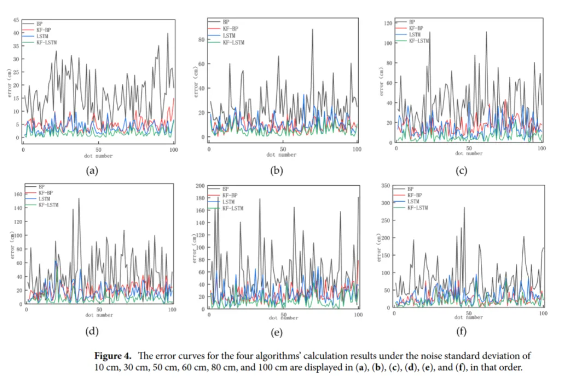

论文针对超宽带(UWB)室内定位受随机误差影响的问题,提出融合卡尔曼滤波(KF)与长短期记忆网络(LSTM)的 KF-LSTM 算法。经仿真和实际测量验证,该算法能有效削弱噪声,相比其他算法,在定位精度和稳定性上有显著提升。

创新点

创新性地将 KF 与 LSTM 融合,利用 KF 处理噪声、LSTM 分析时间序列,提升 UWB 定位精度。

实验验证算法在不同噪声环境下的性能,证明其在高噪声场景下优势更明显。

为室内定位技术发展提供新方向,推动 UWB 定位在复杂室内环境中的应用。

研究方法

建立时间序列数据集,用 KF 对 UWB 测距数据滤波,降低噪声和不确定性。

构建 LSTM 神经网络,设置特定参数,以均方根误差为损失函数进行训练。

分别进行仿真和实际测量实验,对比 BP、KF-BP、LSTM 和 KF-LSTM 算法性能。

研究结论

仿真实验中,KF-LSTM 算法在不同噪声下定位精度和稳定性均优于其他算法,噪声越大优势越明显。

实际测量实验中,KF-LSTM 算法平均定位精度达 3.7cm ,相比其他算法有大幅提升,且稳定性最佳。

KF-LSTM 算法为 UWB 室内定位提供了有效解决方案,但存在适用于低速率应用、对基站连接依赖等局限,为后续研究指明方向。

扫码回复 “977C” 领取

免费获取全部论文+部分代码

A Hybrid Long Short-Term Memory and Kalman Filter Model for Train Trajectory Prediction

文章解析

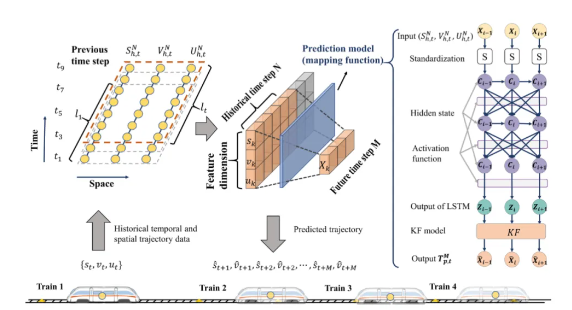

论文针对城市轨道交通中列车轨迹预测问题,提出结合长短期记忆网络(LSTM)和卡尔曼滤波(KF)的混合模型,利用成都地铁8号线数据进行实验,验证该模型能有效提升列车轨迹预测的准确性。

创新点

提出LSTM-KF混合模型,结合LSTM挖掘长期依赖关系和KF提取局部特征的优势,提升预测性能。

设计即时算法,实现模型在线预测,提高预测效率。

为列车轨迹预测提供新方法,对城市轨道交通优化运行和保障安全有重要意义。

研究方法

用LSTM分析时间序列数据,发现列车轨迹数据的长期依赖关系,为KF提供观测数据。

KF结合列车动力学机制,平滑LSTM预测的轨迹,提取局部特征。

以成都地铁8号线数据为样本,通过设置对比实验,用RMSE、MAE和MAPE等指标评估模型性能。

研究结论

实验表明,LSTM-KF模型在预测准确性上显著优于LSTM、GR 和MLP+LSTM模型。

该模型在短期预测时精度高,长期预测时稳定性强,预测误差不会随预测步数增加而单调上升。

轨迹预测在一定程度上符合高斯假设,引入KF能优化预测效果,为城市轨道交通列车轨迹预测提供了有效方案。

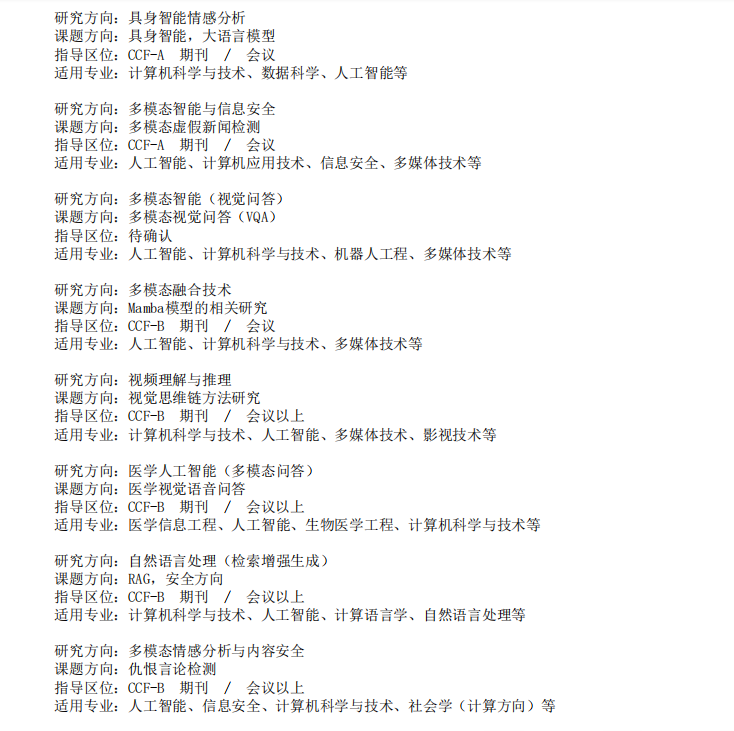

以下论文领域大家有需求的可以来咨询我

764

764

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?