在做视觉分类问题的过程中有个问题一直困扰着我:

1.CE和BCE 分别是针对何种分类任务?

2.在做具体的任务时如何区别的使用他们?

3.分类标签对于不同的多分类任务,是选择普通标签还是one-hot标签?这和loss选择有关么?

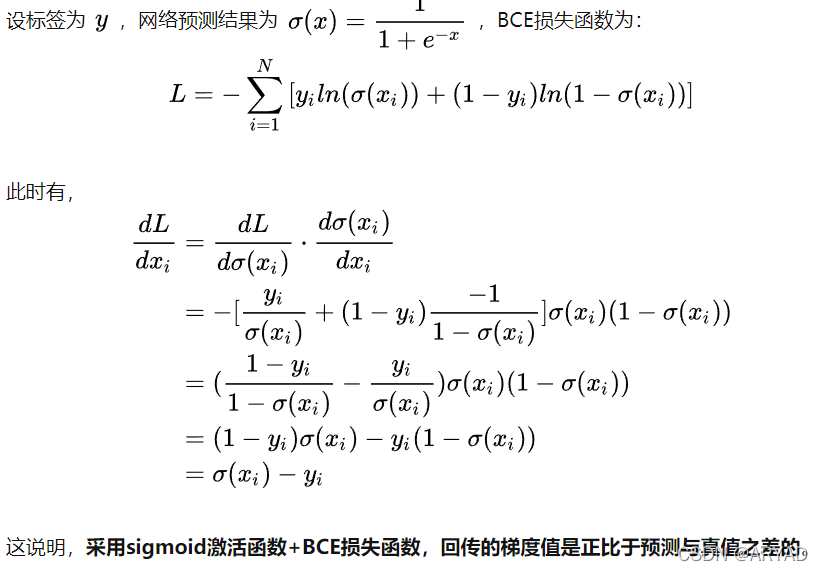

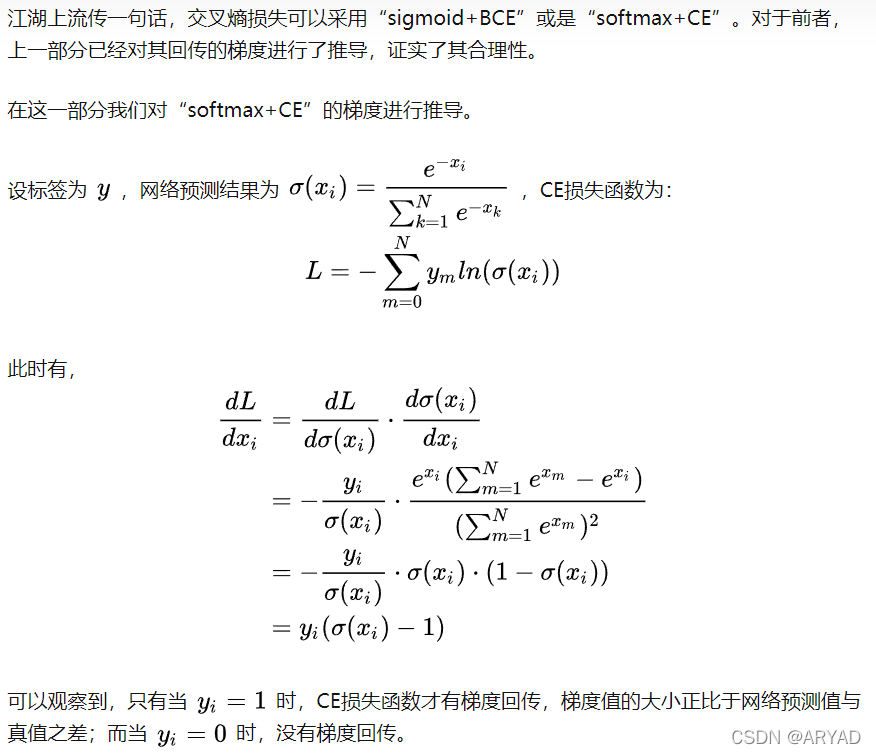

损失函数公式定义区别

由于softmax输出的概率值和为1,网络的优化方向是提升对 y=1 的分类能力,自然其它类别的预测得分就会下降,因此不必担心假阳性的预测得不到改善。

类别间是否互斥问题

在分类问题中,如果遇到类别间不互斥的情况,只能采用“sigmoid+BCE”;

如果遇到类别间互斥的情况(只能有一类胜出),“sigmoid+BCE”化为多个二分类问题与“softmax+CE”直接进行分类都是有被用到的方法。

分类问题的loss使用

经过阅读文章发现,一般二分类多使用 BCE loss,无论是普通标签还是one-hot编码后的标签。

多分类问题又分为但标签多分类和多标签多分类,一般多标签多分类的标签是one-hot形式,使用CE loss。

本文探讨了在视觉分类问题中,交叉熵(CE)和二元交叉熵(BCE)损失函数的区别和适用场景。CE通常用于多分类任务,而BCE适用于二分类或多标签分类。当类别间不互斥时,BCE结合sigmoid激活函数是合适的选择;若类别互斥,可以使用BCE处理多个二分类子问题或直接应用softmax和CE。对于多分类标签,one-hot编码通常用于多标签任务,而普通标签可能用于二分类或某些特定的多分类设置。损失函数的选择直接影响模型的训练效果和优化方向。

本文探讨了在视觉分类问题中,交叉熵(CE)和二元交叉熵(BCE)损失函数的区别和适用场景。CE通常用于多分类任务,而BCE适用于二分类或多标签分类。当类别间不互斥时,BCE结合sigmoid激活函数是合适的选择;若类别互斥,可以使用BCE处理多个二分类子问题或直接应用softmax和CE。对于多分类标签,one-hot编码通常用于多标签任务,而普通标签可能用于二分类或某些特定的多分类设置。损失函数的选择直接影响模型的训练效果和优化方向。

1011

1011

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?