如何搭建一个 10 万块显卡的集群?

如何让10万块H100显卡一起工作?分析马斯克的xAI的计算架构

150MW的功率大致相当于一个有15万家庭的用电功率,也就是说,这个耗电量大致相当于一个中等城市的用电量。

大家好,今天跟大家分享的是马斯克的xAI如何在122天的时间里,如何用10万块显卡,搭建出目前世界上最强的算力集群。注意是最强,没有之一。

目前这个集群的算力,大概用 4 天的时间就可以训练一个 GPT-4的模型。

我们可以比较一下,根据公开可以获得的消息,GPT-4 的训练使用了约25,000个NVIDIA A100 GPU,持续了 90至100天。

成本

我们可以先从宏观的角度来看搭建一个10万块显卡的集群有哪些成本?

-硬件:40 亿美金

-电力:150MW

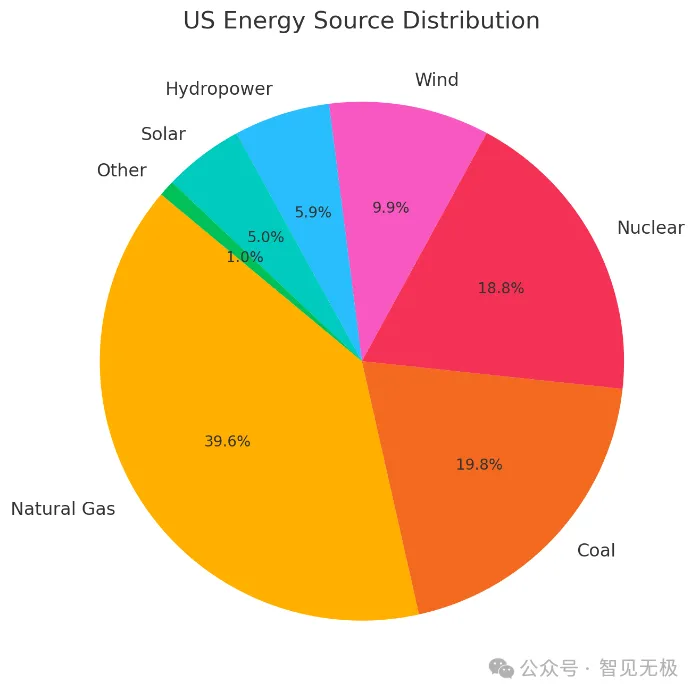

整理了一下数据,因为美国能源比较丰富,所以电价还是比较便宜的。整个机房的核心耗电大概一半会在GPU服务器上,另外一半会在普通的PC服务器和一些网络设备上面。

电力系统

三相电源

每个机架配备多个三相电源条,为GPU和其他组件提供稳定电力。三相电源能够更高效地支持高功率设备运行,减少单相系统可能带来的不均匀负载问题。

使用特斯拉 Megapack 电池组

每个Megapack的储能容量达3.9MWh,Megapack作为超级计算机和电网之间的 能量缓冲器,帮助平滑负载波动。这个实际上就是UPS,因为UPS的核心就是一个大电池加一个逆变器。因为电网的电压实际上不稳定的,所以外面的能源首先会经过Megapack 的电池组。

硬件部署

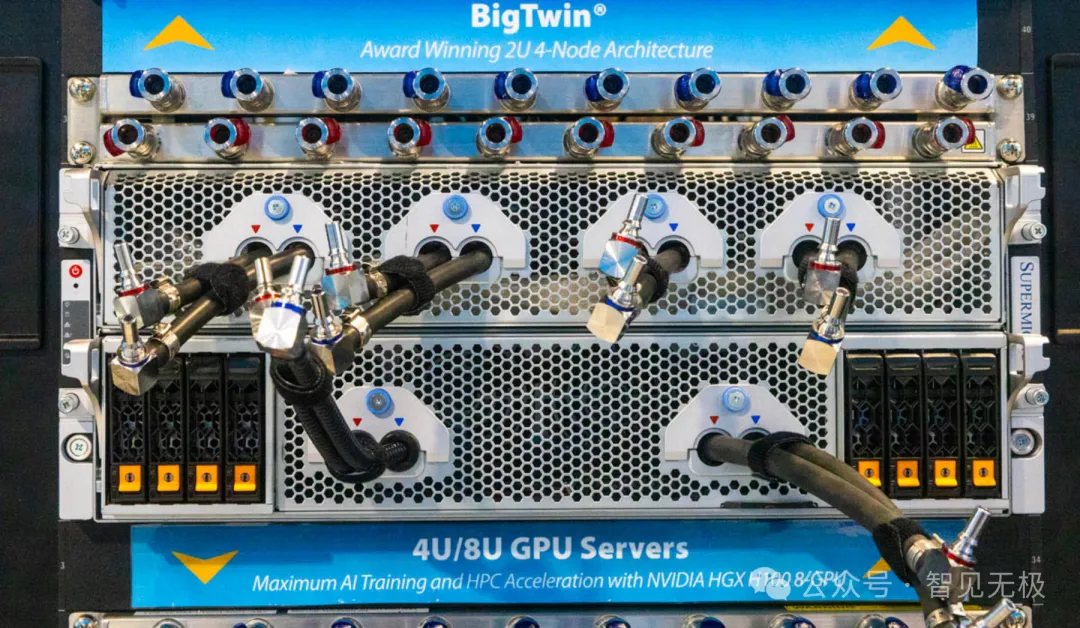

基于八路HGX GPU板卡的Supermicro机架级系统,每一个机器是4U的,上面安装8块H100的显卡,每个机架上部署8个4U的GPU服务器。每8个机架组成一个阵列,共 512片GPU。

散热系统

GPU 服务的显卡使用液冷散热

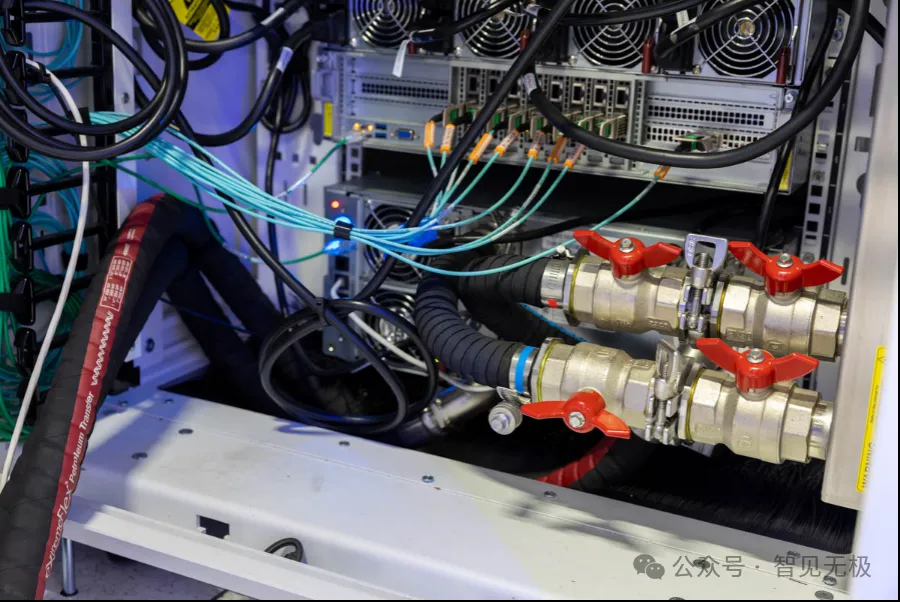

液冷系统(核心技术)

因为散热液体的导热效率更高,所以发热量大的核心部件使用液冷散热,可快速把热量带到液体中。

冷却液由每个机架底部的 冷却分配单元(Cooling Distribution Unit, CDU)提供,冷却液通过机架内的分配管道输送到各服务器,流经GPU液冷模块(NVIDIA HGX 托盘)和CPU液冷模块(x86 CPU和PCIe交换机)。

每个机架上的CDU都是冗余设计的。每个机架都有两套独立的CDU模块,CDU冷却单元、管道连接和冷却模块均支持在线热插拔。

冷却液带走设备的热量后返回CDU,再通过机房冷却系统循环降温。

风冷系统(辅助散热)

除了核心部件,例如GPU,这些部件,其它的芯片,像网卡、电源也会产生热量。用于冷却内存(DIMM)、电源单元、主板管理控制器(BMC)、网络卡。风扇从机架前部吸入冷空气,将冷却后的热空气从后部排出。

网络拓扑

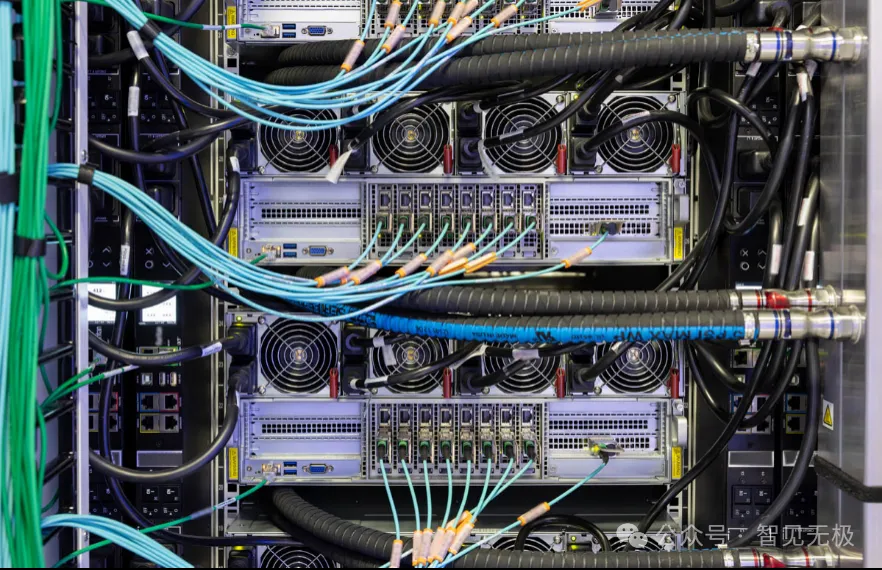

我们首先可以看到服务器后面插了一排网线,我们可以数一下,一共8根,每一根网线的速度都是400GbE的速度。整体的速度可以达到3.6Tbps。

达到这种速度的网线,虽然还是以太网的技术,但是这个网线已经不是同轴电缆,只能是光纤。

这些显卡可以直接通过网线通过RDMA技术直接和另一台服务器的GPU通信,这个通信直接是显存对显存,不需要通过CPU,避免数据的多次复制。

大家仔细看,旁边这里还有一根网线,这是给CPU使用的,主要用于网络和管理功能。

RDM

ARDMA(Remote Direct Memory Access)是一种高性能数据传输技术,它允许计算机直接通过网络访问另一台计算机的内存,而无需操作系统的参与,从而显著降低了延迟和CPU用率。一般可以做到微秒级别的延迟,一半TCP/IP都是毫秒级的。

NVLink

主要用于本机的GPU和GPU,以及GPU到CPU的通信。

训练架构

架构的设计主要是为了提高容错性,从而提高任务的并行度。从宏观的角度来看,并行主要可以分为指令并行和数据并行。

数据并行

每个GPU保留模型的完整副本,处理不同的数据分片。优点是通信需求较低,适合内存足够大的GPU,但对于超大模型可能受限于显存,对于GPT-4这种级别的模型显然是不够。

张量并行

简单来讲就是把神经网络的的每一层分布到不同的GPU去计算,包括线性变换、激活函数、注意力机制等。张量并行的目标是将每一层的计算拆分为多个部分,分布到不同的GPU上处理,从而实现并行化。这个需要低延迟的通信环境。

参考资料

https://resources.nvidia.com/en-us-tensor-core/gtc22-whitepaper-hopper

589

589

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?