前言

部署流程

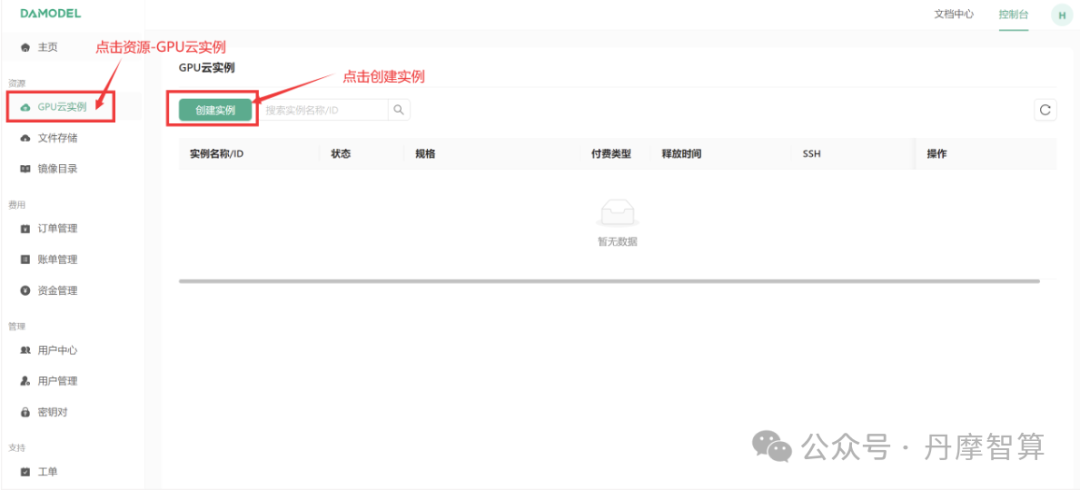

创建资源

进入[控制台-GPU云实例],点击创建实例:

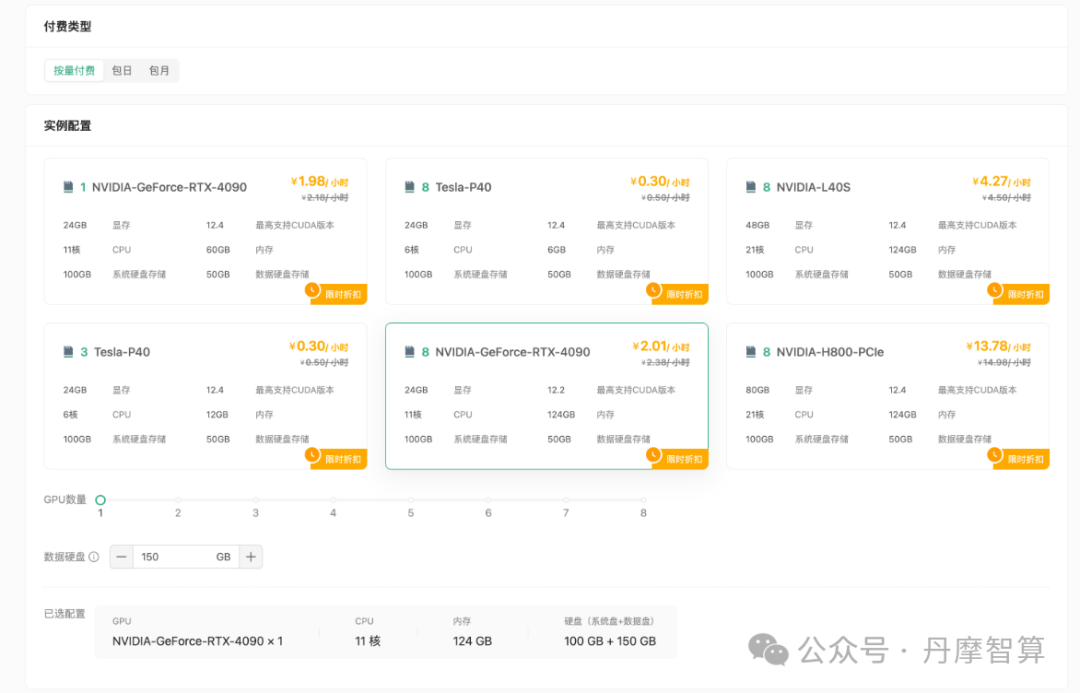

进入创建页面后,首先在实例配置中选择付费类型,一般短期需求可以选择按量付费或者包日,长期需求可以选择包月套餐;

其次选择GPU数量和需求的GPU型号,首次创建实例推荐选择:

-

• 按量付费

-

• GPU数量1

-

• NVIDIA-GeForc-RTX-4090:该配置为60GB内存,24GB的显存(本次测试的LLaMA3.1 8B 版本至少需要GPU显存16G)

接下来配置数据硬盘的大小,每个实例默认附带了50GB的数据硬盘,FLUX.1模型较大,建议扩容至150GB。

继续选择安装的镜像,平台提供了一些基础镜像供快速启动,镜像中安装了对应的基础环境和框架,可通过勾选来筛选框架,这里筛选PyTorch,选择PyTorch 2.4.0。

为保证安全登录,创建密钥对,输入自定义的名称,然后选择自动创建并将创建好的私钥保存的自己电脑中,以便后续本地连接使用。

创建好密钥对后,选择刚刚创建好的密钥对,并点击立即创建,等待一段时间后即可启动成功!

所有的AI设计工具,安装包、模型和插件,都已经整理好了,👇获取~

登录实例

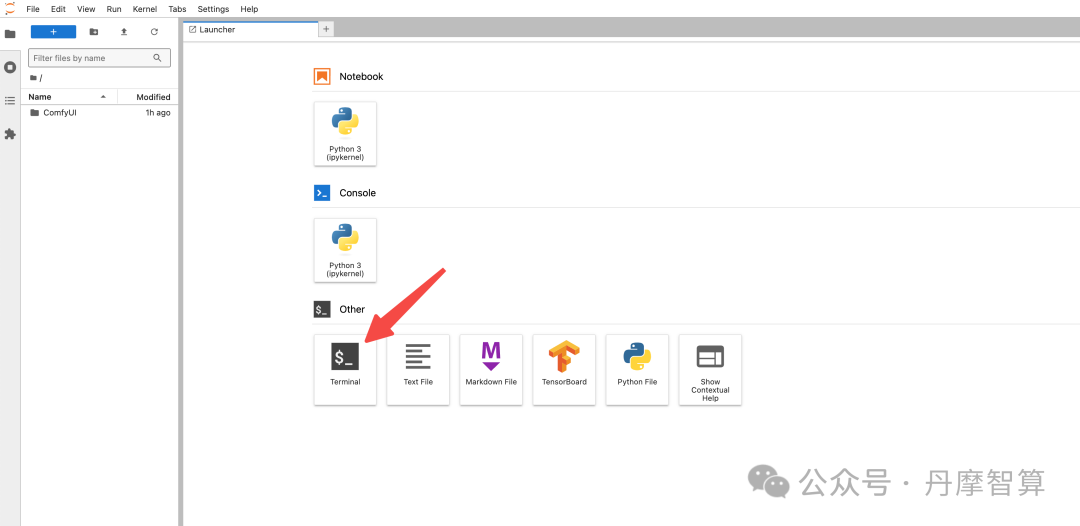

接下来将基于平台提供的JupyterLab工具,演示fp16版本的部署流程。

首先,启动JupyterLab,并创建终端:

部署ComfyUI

在终端中执行以下命令克隆ComfyUI代码:

`# github官方代码仓库 git clone https://github.com/comfyanonymous/ComfyUI.git # gitCode-github加速计划代码仓库 git clone https://gitcode.com/gh_mirrors/co/ComfyUI.git`

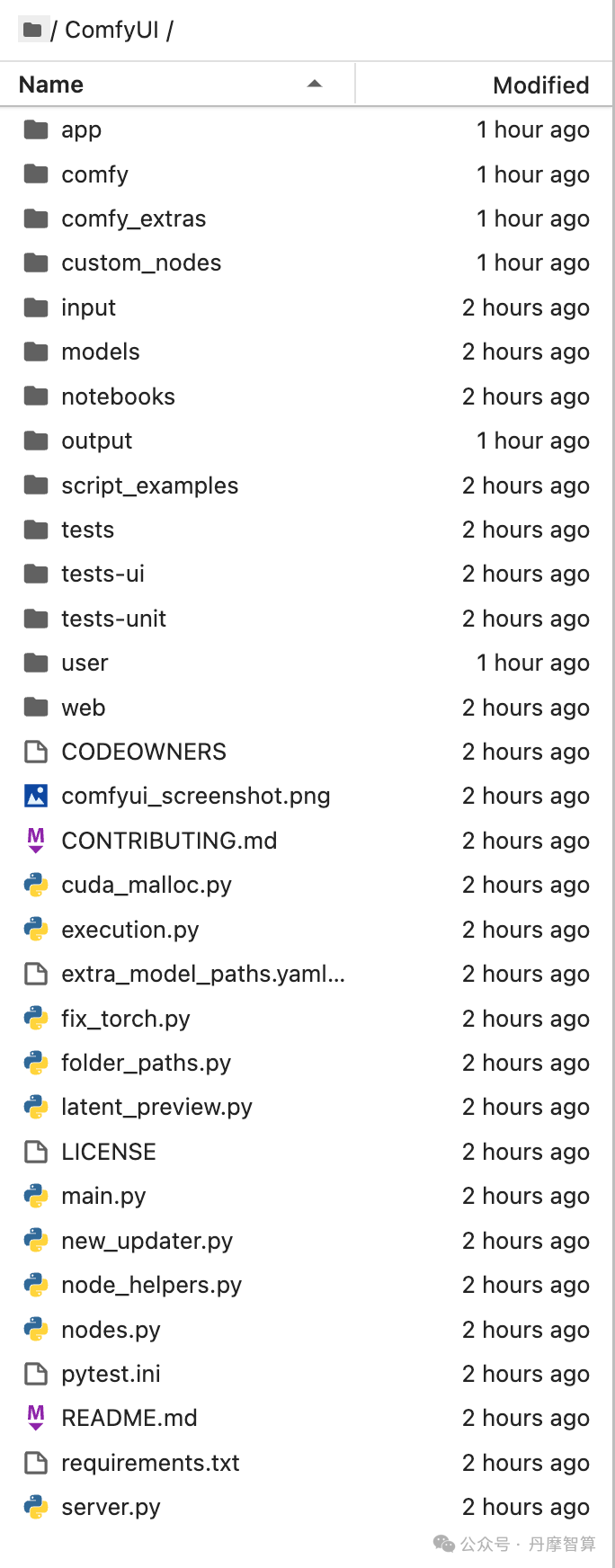

克隆完成后可看到如下目录:

终端进入/root/workspace/ComfyUI目录,执行以下命令,安装ComfyUI需要的依赖:

`cd ComfyUI/ pip install -r requirements.txt --ignore-installed`

执行以下命令,启动ComfyUI:

`python main.py --listen`

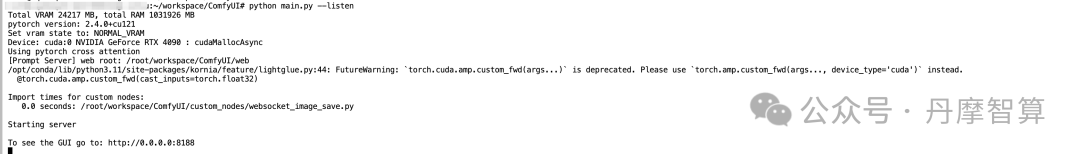

看到服务成功启动,说明ComfyUI部署成功!

提示

-您如果遇到报错

`ImportError: version conflict: '/opt/conda/lib/python3.11/site-packages/psutil/_psutil_linux.cpython-311-x86_64-linux-gnu.so' C extension module was built for another version of psutil (5.9.0 instead of 6.0.0); you may try to 'pip uninstall psutil', manually remove /opt/conda/lib/python3.11/site-packages/psutil/_psutil_linux.cpython-311-x86_64-linux-gnu.so or clean the virtual env somehow, then reinstall`

-可先卸载冲突包,再次安装依赖

`pip uninstall psutil pip install -r requirements.txt --ignore-installed`

部署FLUX.1

推荐您阅读ComfyUI官方使用FLUX.1示例,以下是基于丹摩平台的部署教程

平台已预制FLUX.1相关资源,您可通过内网高速下载:

`# 下载完整FLUX.1-dev模型 wget http://file.s3/damodel-openfile/FLUX.1/FLUX.1-dev.tar # 下载完整FLUX.1-schnell模型 wget http://file.s3/damodel-openfile/FLUX.1/FLUX.1-dev.tar # 下载完整Clip模型 wget http://file.s3/damodel-openfile/FLUX.1/flux_text_encoders.tar`

此处以FLUX.1-dev为例演示,首先下载完整FLUX.1-dev模型:

`wget http://file.s3/damodel-openfile/FLUX.1/FLUX.1-dev.tar`

解压文件:

`tar -xf FLUX.1-dev.tar`

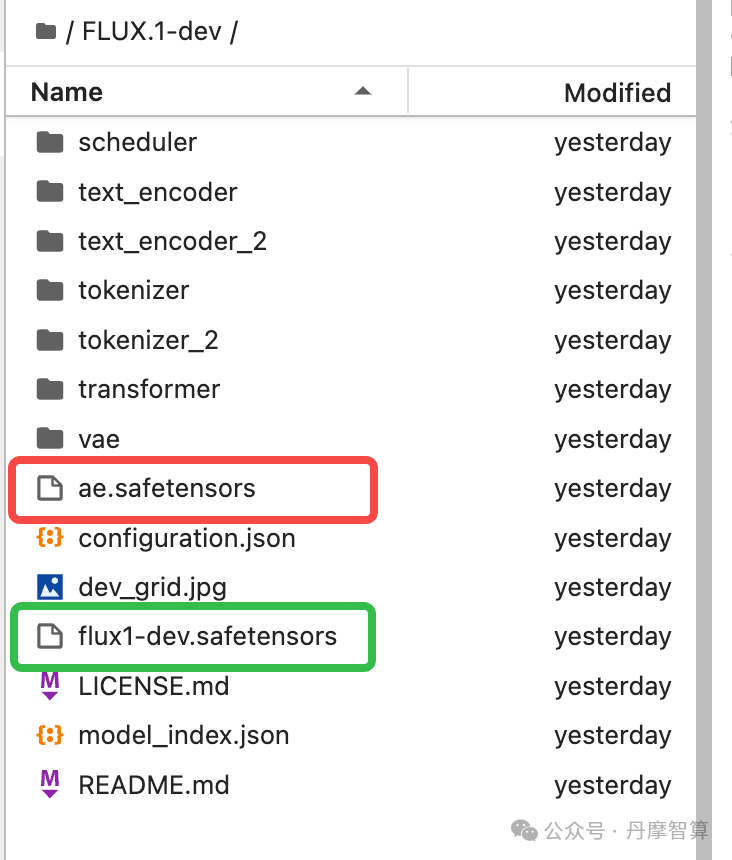

解压后完成后可看到如下目录:

我们需要把其中的一些文件移至ComfyUI指定目录:

-

• 大模型文件

flux1-dev.safetensors需要移动 -

至

/root/workspace/ComfyUI/models/unet/文件夹中 -

• vae文件

ae.safetensors需移动至/root/workspace/ComfyUI/models/vae/文件夹中

`# 进入解压后的文件夹 cd /root/workspace/FLUX.1-dev # 移动文件 mv flux1-dev.safetensors /root/workspace/ComfyUI/models/unet/ mv ae.safetensors /root/workspace/ComfyUI/models/vae/`

接下来下载完整Clip模型:

`# 进入JupyterLab根目录 cd /root/workspace # 下载文件 wget http://file.s3/damodel-openfile/FLUX.1/flux_text_encoders.tar`

解压文件:

`tar -xf flux_text_encoders.tar`

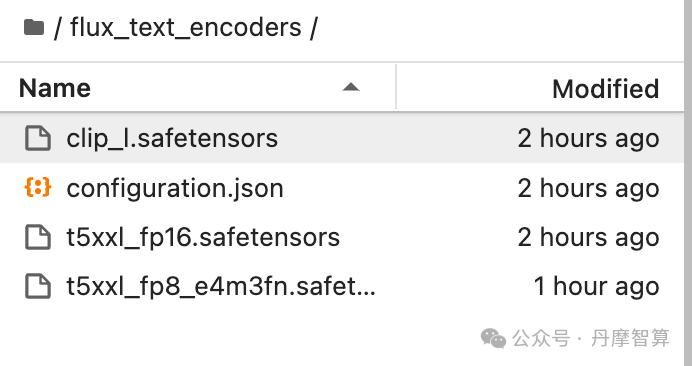

解压后完成后可看到如下目录:

我们需要把其中的一些文件移至ComfyUI指定目录:

`# 进入解压后的文件夹 cd /root/workspace/flux_text_encoders # 移动文件 mv clip_l.safetensors /root/workspace/ComfyUI/models/clip/ mv t5xxl_fp16.safetensors /root/workspace/ComfyUI/models/clip/`

以上,所有准备工作完成!

使用流程

运行FLUX.1

终端进入ComfyUI目录,执行以下命令,启动ComfyUI:

`cd /root/workspace/ComfyUI python main.py --listen`

我们看到启动成功,host为0.0.0.0,端口为8188:

`Starting server To see the GUI go to: http://0.0.0.0:8188`

接下来我们需要通过丹摩平台提供的端口映射能力,把内网端口映射到公网;

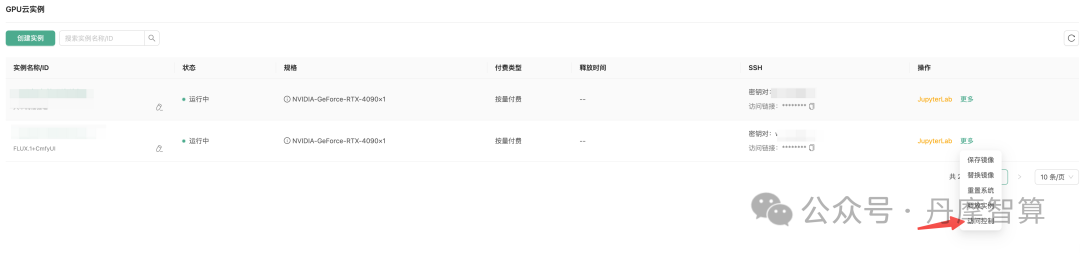

进入[GPU 云实例页面],点击操作-更多-访问控制:

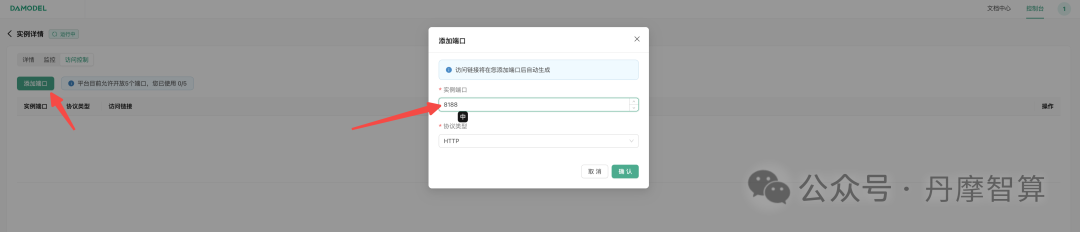

点击添加端口,添加服务对应端口:

添加成功后,通过访问链接即即可打开ComfyUI交互界面:

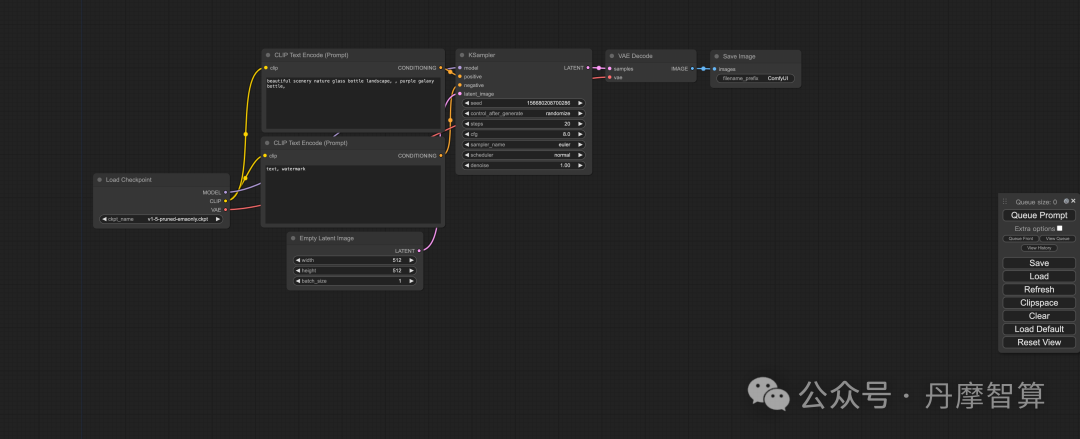

导入工作流

您可以把以下图片保存,然后在ComfyUI中加载或拖动以下图像以获取工作流。

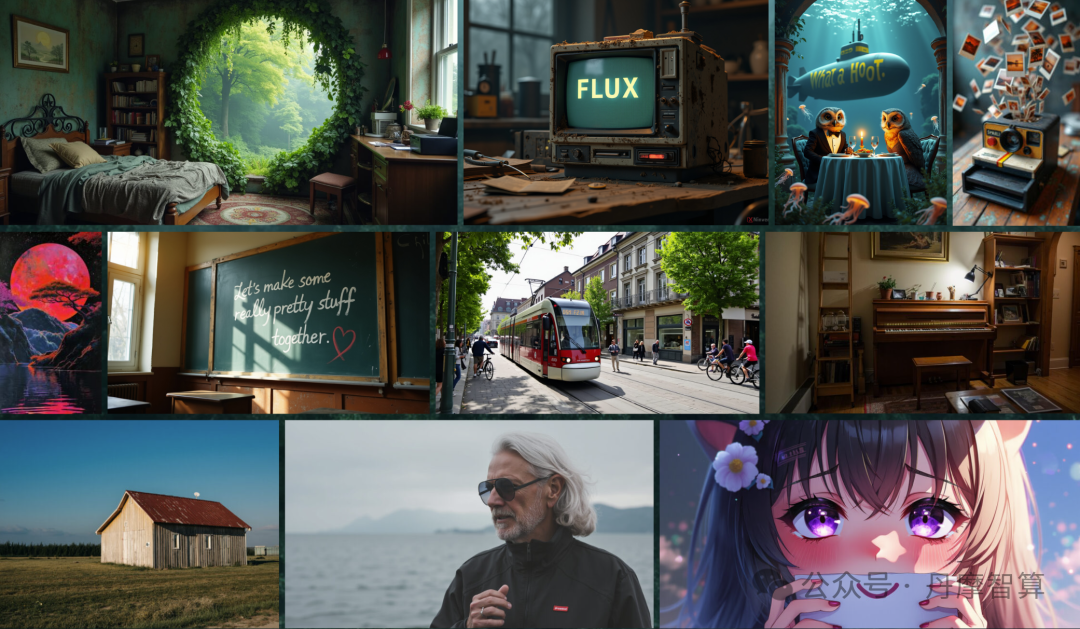

以下是FLUX.1-dev-FP16的展示效果

FLUX.1-dev-FP16

FLUX.1-schnell-FP16

FLUX.1-dev-FP8

FLUX.1-schnell-FP8

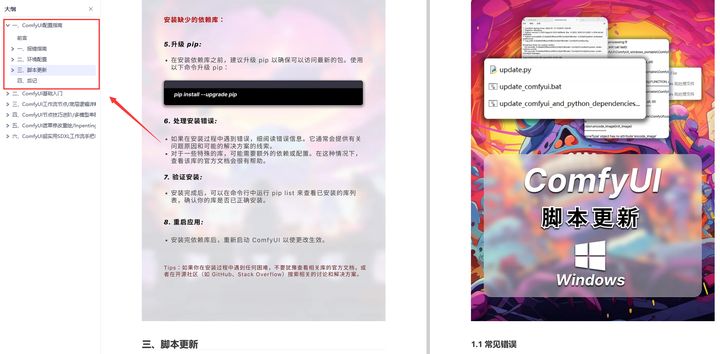

为了帮助大家更好地掌握 ComfyUI,我在去年花了几个月的时间,撰写并录制了一套ComfyUI的基础教程,共六篇。这套教程详细介绍了选择ComfyUI的理由、其优缺点、下载安装方法、模型与插件的安装、工作流节点和底层逻辑详解、遮罩修改重绘/Inpenting模块以及SDXL工作流手把手搭建。

由于篇幅原因,本文精选几个章节,详细版点击下方卡片免费领取

一、ComfyUI配置指南

- 报错指南

- 环境配置

- 脚本更新

- 后记

- …

二、ComfyUI基础入门

- 软件安装篇

- 插件安装篇

- …

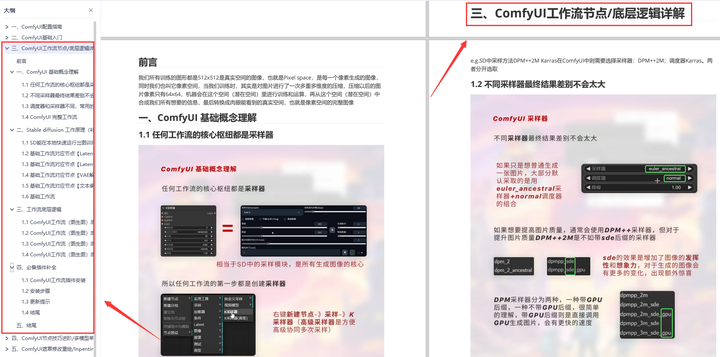

三、 ComfyUI工作流节点/底层逻辑详解

- ComfyUI 基础概念理解

- Stable diffusion 工作原理

- 工作流底层逻辑

- 必备插件补全

- …

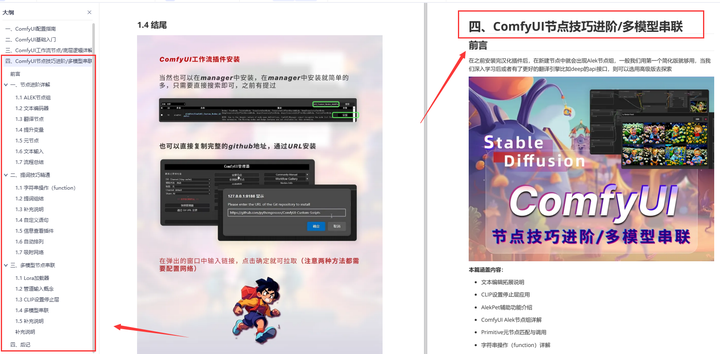

四、ComfyUI节点技巧进阶/多模型串联

- 节点进阶详解

- 提词技巧精通

- 多模型节点串联

- …

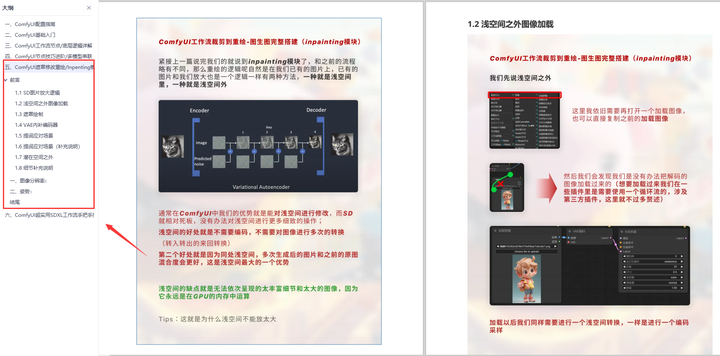

五、ComfyUI遮罩修改重绘/Inpenting模块详解

- 图像分辨率

- 姿势

- …

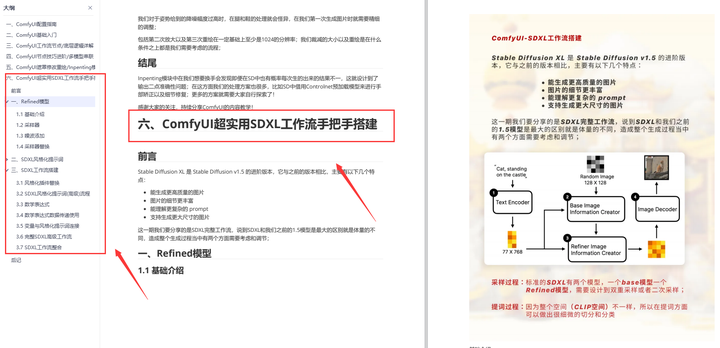

六、ComfyUI超实用SDXL工作流手把手搭建

- Refined模型

- SDXL风格化提示词

- SDXL工作流搭建

- …

由于篇幅原因,本文精选几个章节,详细版点击下方卡片免费领取

2954

2954

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?