Fine-Grained Visual Classification via Progressive Multi-Granularity Training of Jigsaw Patches

文章目录

0 摘要

对哪种粒度最具有区别性以及如何在多粒度之间融合信息所做的工作较少。

本文突出的分类框架:

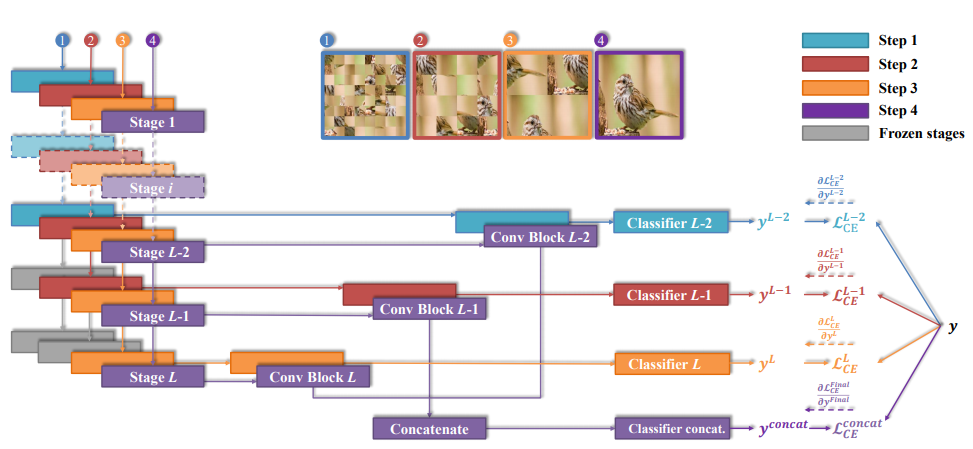

- 一种渐进式训练策略,在每个训练步骤都添加新层,以根据最后一步和上一阶段找到的较小粒度信息来利用信息

- 一个拼图生成器,形成包含不同粒度级别信息的图像(DCL提到的那个方法?)

源代码:https://github.com/RuoyiDu/PMG-Progressive-Multi-Granularity-Training

1 引言

鲜有工作对哪种粒度最有区别的局部区域、如何将跨粒度信息融合在一起以实现分类准确性这两个问题进行研究。

跨粒度的信息有助于避免类内较大变化的影响。仅识别区分性部分通常不够,识别这些部分之间的相互作用方式也不够。

最近的研究集中在“放大”因子[11,36],即不仅识别零件,而且还聚焦于每个部分内真正有区别的区域。该方法主要集中在几个部分,而忽略了其他部分,也没有考虑如何将不同放大部分特征以协同方式融合在一起。作者认为,不仅需要识别部分及最具区分性的粒度,而且还需要如何有效地合并不同粒度的部分。

既不显示也不隐式地从部分(或其放大版本)挖掘细粒度的特征表示。 而是假设:细粒度的区分性信息自然位于不同的视觉粒度之内,要鼓励网络以不同的粒度进行学习,同时将多粒度特征融合在一起。

提出的框架可同时容纳零件粒度学习和跨粒度特征融合:

- 渐进训练策略,融合不同粒度特征

- 随机拼图生成器,鼓励网络学习特定粒度特征

**多粒度渐进式训练框架,以学习不同图像粒度之间的互补信息,在训练过程中按部进行,其中每一步重点是在网络的相应阶段训练特定于粒度的信息。**从更稳定的细粒度开始,逐渐过渡到粗粒度,避免了出现在较大区域中的大型内部类差异所造成的混淆。每个训练步骤结束时,在当前步骤训练的参数将传递到下一个训练步骤作为其参数初始化。

直接应用渐进式训练将不会有益于细粒度特征学习,因为获得的多粒度信息可能倾向于集中在相似区域上。通过引入一个拼图生成器来解决,在每个训练步骤中形成不同的粒度级别,仅最后一步使用原图像训练。 鼓励模型在块级别上工作,其大小特定于特定的粒度。本质上,迫使网络的每个阶段都重点关注局部补丁,而不是整个图像,从而学习特定于给定粒度级别的信息。

本文的主要贡献可归纳如下:

- 一种渐进式训练策略,以不同的训练步骤进行操作,并且在每个步骤中都融合了先前粒度级别的数据,最终在不同粒度之间训练了固有的互补属性,从而实现了细粒度的特征学习。

- 一个拼图生成器形成不同级别的粒度

- 渐进多粒度(PMG)训练框架表现很好

2 相关工作

细粒度分类

从强监督弱监督。弱监督工作中,大多数关注定位部分、互补部分、不同粒度的部分。但如何将这些部分的信息更好地融合在一起很多有人考虑。并且当前的融合技术可以大致分为两类:不同部分各自预测将其概率直接合并,特征合并进行预测。这两种方法都训练一个全连接融合层,将从不同部分提取的特征(图或向量)融合起来。

将不同部分的特征融合起来是一个难题。 本文基于细粒度对象的内在特征来解决这个问题:尽管类内差异大,但细微的细节显示了局部区域的稳定性。因此,引导网络逐步从小粒度到大粒度的特征学习,而不是先定位。

图像分割

通过采用拼图作为弱监督网络的初始化,使网络有更好的转换性能,该方法有助于网络利用图像的空间关系。

在one-shot learning中,图像分割操作用于数据增强,分割两个图像并交换图像块以生成新的训练图像。

DCL通过破坏全局结构来强调局部细节并重构图像以学习局部区域之间的语义相关性。但是,它会在整个训练过程中以相同大小分割图像,这意味着难以利用多粒度区域。

本文应用了一个拼图生成器来限制每个训练步骤中学习区域的粒度。

渐进式训练

该策略允许网络发现图像分布的大规模结构,然后将注意力转移到越来越多的尺度细节上。

本文采用渐进式训练的思想来设计一个可以通过一系列训练阶段学习这些信息的单一网络。

- 输入图像分割成块以训练模型低层

- 逐步增加补丁的数量,高层相应的层也添加进入并训练

3 方法

鼓励模型在较浅的层中学习稳定的细粒度信息,并随着训练的进行逐渐将注意力转移到对深层中粗粒度的抽象信息的学习上。

3.1 网络架构

主干网络 F F F有 L L L个阶段,每个阶段的输出特征图为 F l ∈ R H l × W l × C l F^l\in\mathbb R^{H_l\times W_l\times C_l} Fl∈RHl×Wl×Cl, l = { 1 , 2 , . . . , L } l=\{1,2,...,L\} l={ 1,2,...,L}。目标是对在不同中间阶段提取的特征图施加分类损失。引入卷积块 H c o n v l H^l_{conv} Hconvl将 F l F^l Fl的输出作为输入变成为向量表示 V l = H c o n v l ( F l ) V^l=H^l_{conv}(F^l) Vl=Hconvl(Fl),再经过该阶段的分类模块 H c l a s s l H^l_{class} Hc

提出了一种渐进式多粒度训练框架,通过不同训练步骤融合先前粒度级别的数据,利用拼图生成器帮助网络学习特定粒度特征,有效提高了细粒度分类的准确性。

提出了一种渐进式多粒度训练框架,通过不同训练步骤融合先前粒度级别的数据,利用拼图生成器帮助网络学习特定粒度特征,有效提高了细粒度分类的准确性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

701

701