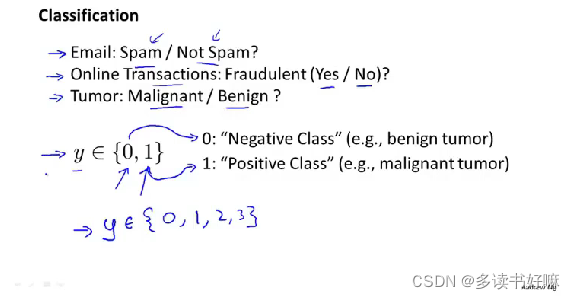

分类问题

与回归问题同属于监督学习,区别在于预测离散值的输出、

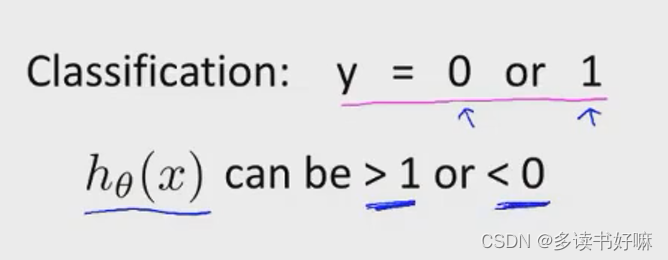

用线性回归解决分类问题

可以假设输出阈值为0.5,大于0.5则预测1,反之预测0。

若添加一个没有提供任何信息系得样本,线性回归对数据得拟合直线会因此改变,偏离正确直线;此外,假设函数的输出值会远大于1或远小于0,即使所有样本的训练标签都是0或1。因此通常不用线性回归解决分类问题。

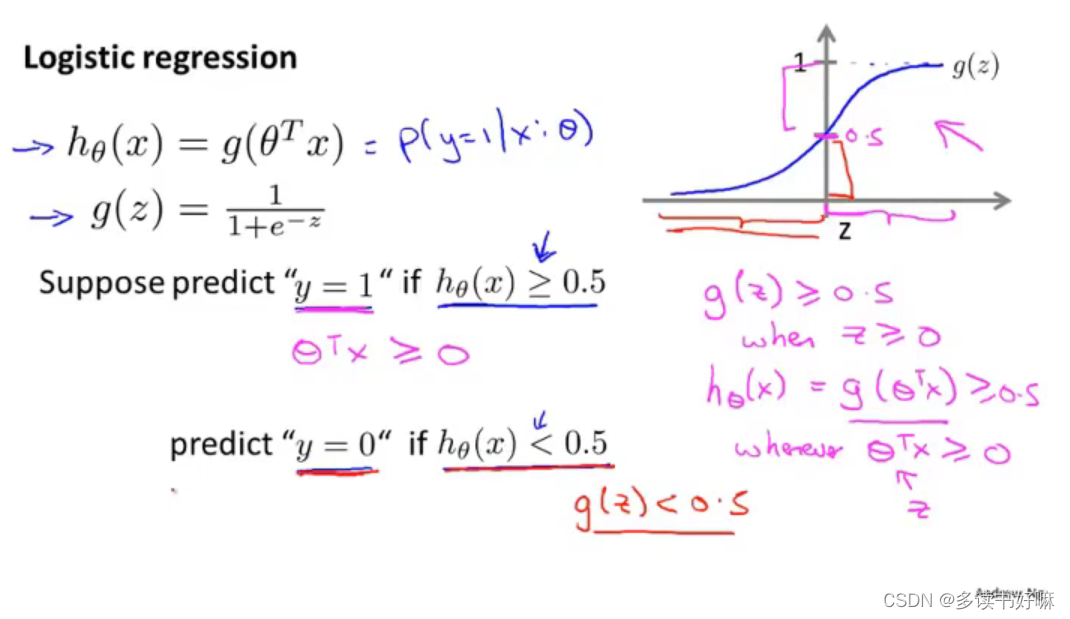

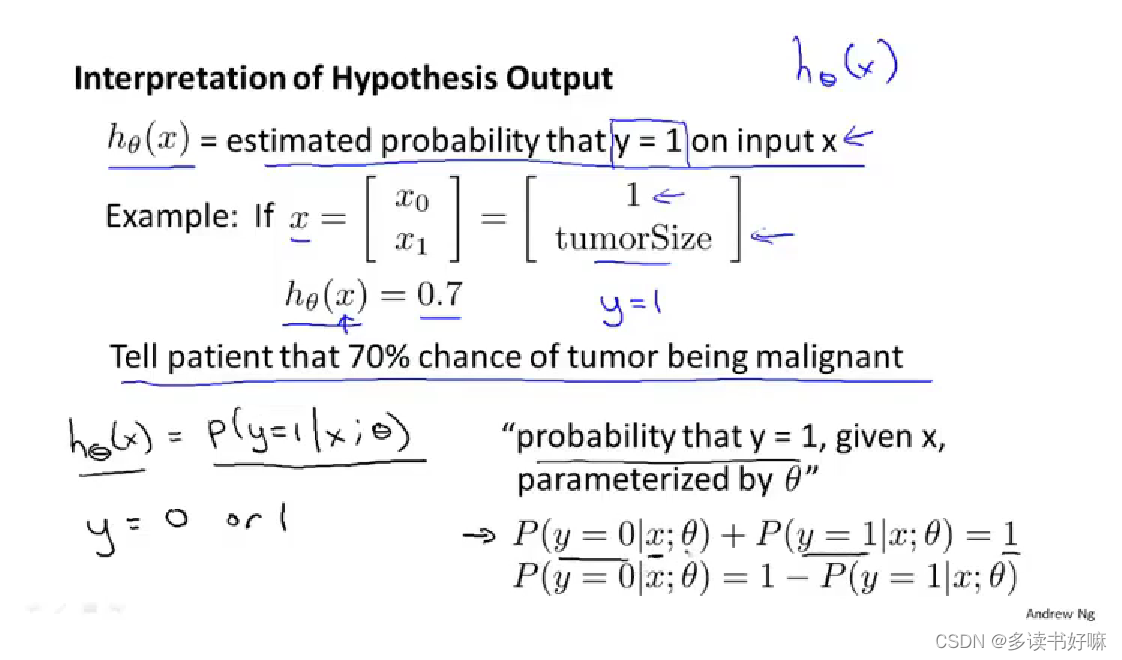

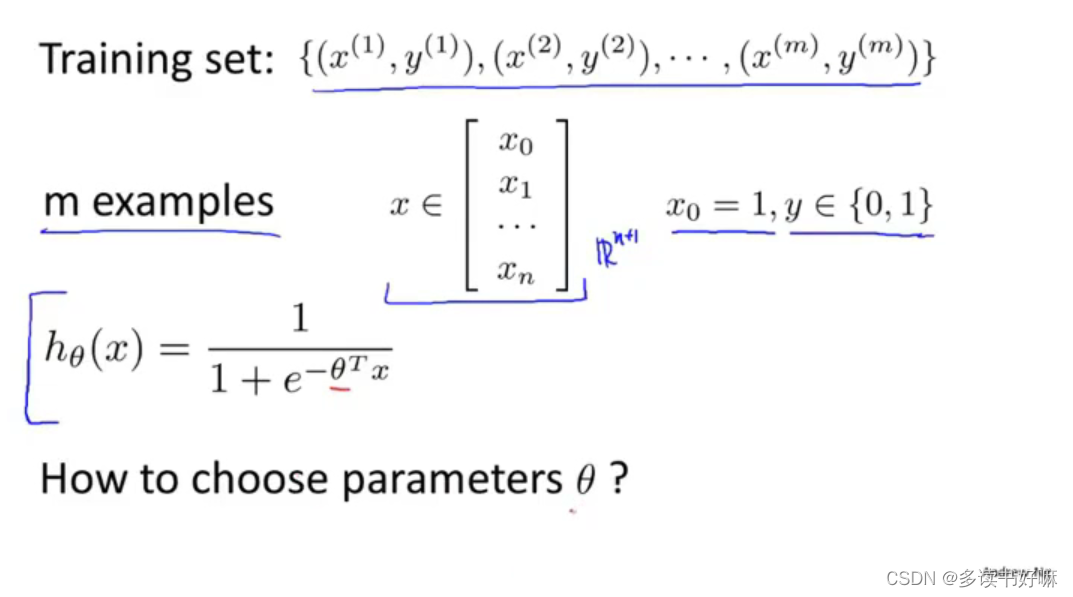

逻辑回归

模型

假设函数:hθ (x)=g(θ^TX)

其中g(x) :Sigmod函数/Logistic函数

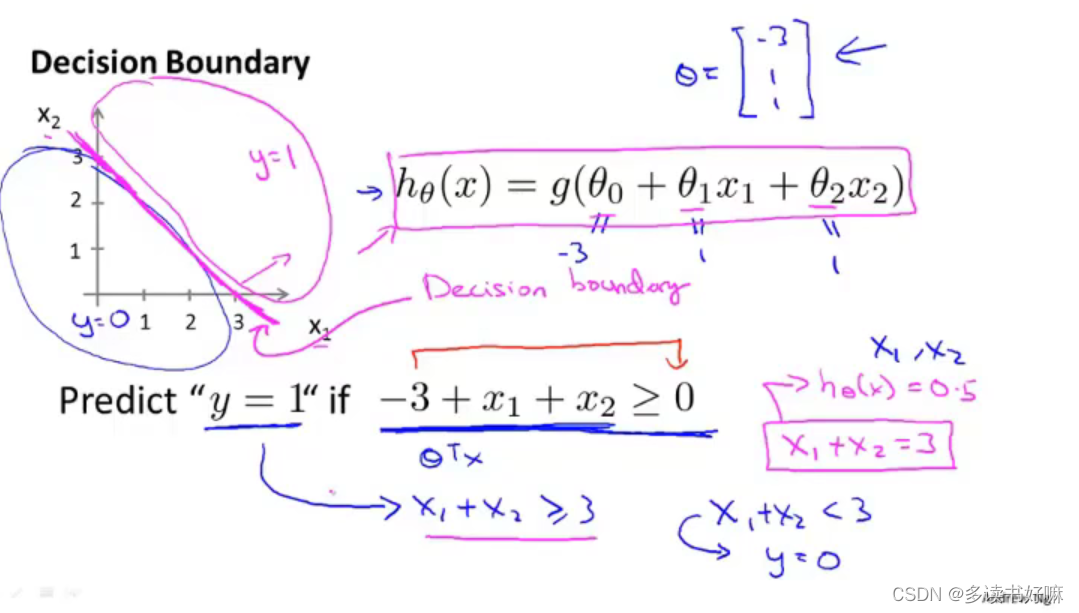

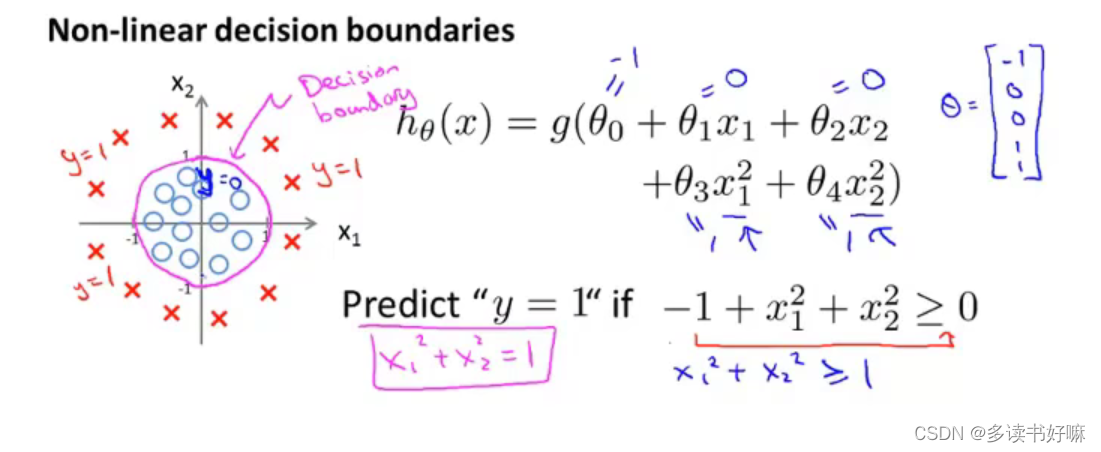

决策边界

强调:决策边界不是训练集的属性,是假设函数本身以及其参数的属性。不是用训练集来定义决策边界,我们用训练集来你和参数θ。

通过添加多项式,可以得到更加复杂的决策边界。

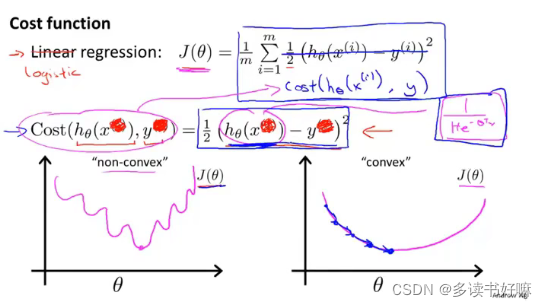

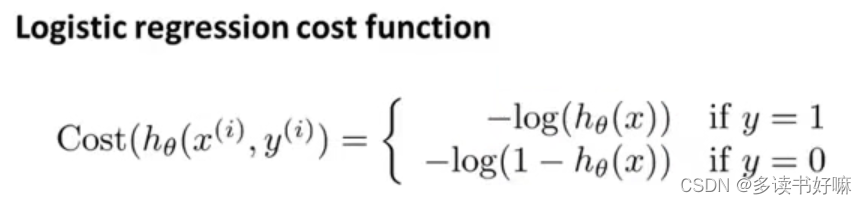

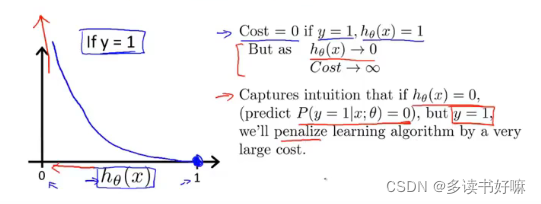

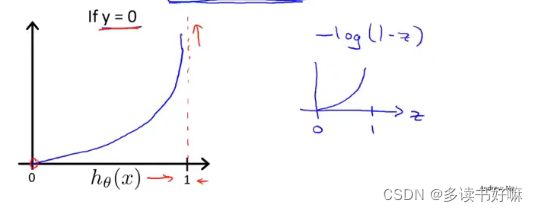

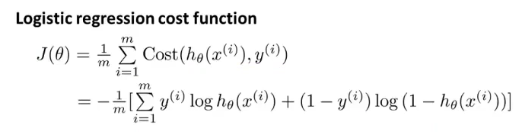

代价函数

若采用线性回归的形式,sigmoid函数会导致J(θ)非凸,产生许多局部最小值

用以下形式表示代价函数能很好解决

简化形式

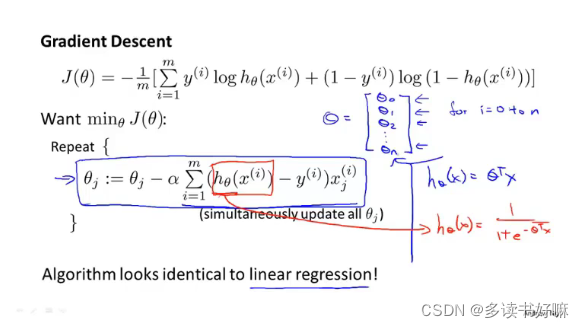

梯度下降

形式类似线性回归

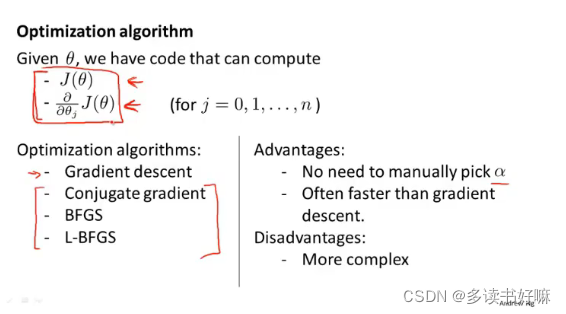

高级优化

下三者涉及其他领域,思路是给出计算导数项和代价函数的方法,你可以认为算法有一个智能的内部循环,事实上,他们确实有一个智能的内部循环,称为线性搜索算法(line search),它可以自动尝试不同的学习速率 ,并自动选择一个好的学习速率 ,它甚至可以为每次迭代选择不同的学习速率,那么你就不需要自己选择。他们更复杂、高级,因而通常比梯度下降更快地收敛。

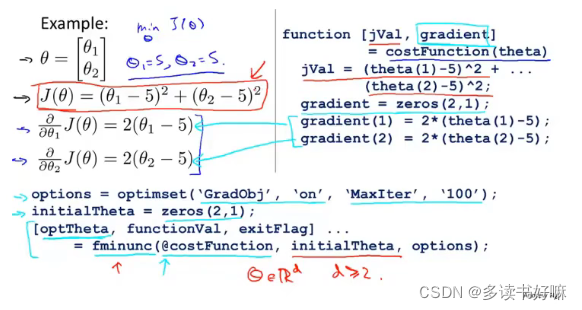

举例

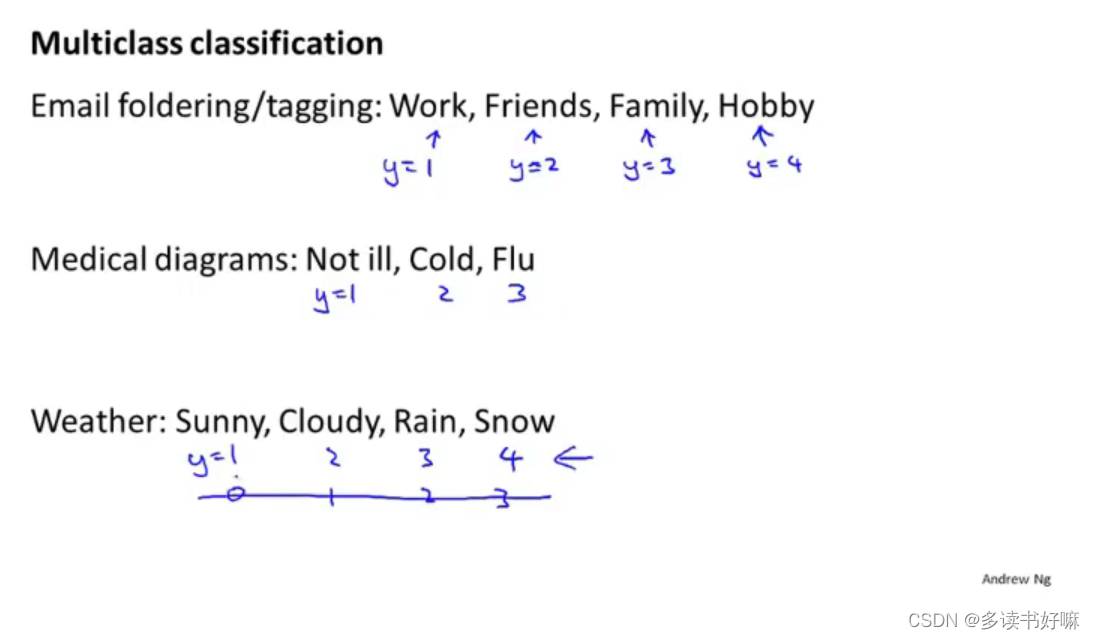

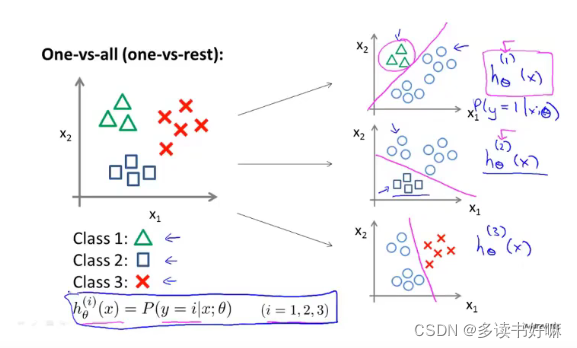

多元分类:一对多

类别多分类

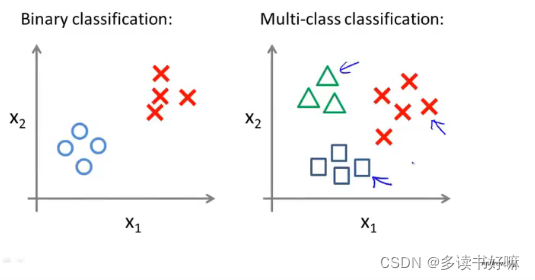

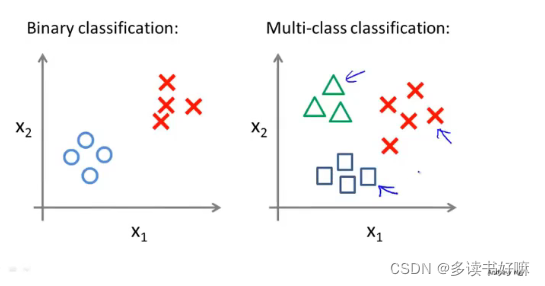

二元分类与多元分类数据集比较

多元分类步骤

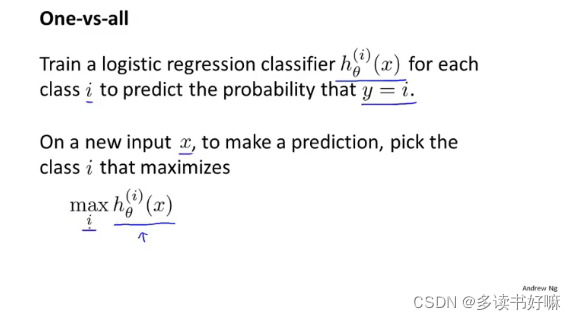

训练一个逻辑回归分类器hθ^(i)(x)预测i类别y=1地概率。最后为了预测,我们将新输入值x输入给分类器运行,选择h最大地类别

本文探讨了监督学习中的分类与回归问题,对比了线性回归与逻辑回归在解决分类问题上的表现,详细介绍了逻辑回归模型及其假设函数、决策边界、代价函数等内容。

本文探讨了监督学习中的分类与回归问题,对比了线性回归与逻辑回归在解决分类问题上的表现,详细介绍了逻辑回归模型及其假设函数、决策边界、代价函数等内容。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?