基于transformer的单目标跟踪算法学习笔记

- 基于transformer的目标跟踪的几种基本架构

- 2021

-

- Tokens-to-Token ViT: Training Vision Transformers from Scratch on ImageNet(引入cnn提升transformer提取局部特征的能力)

- HiFT: Hierarchical Feature Transformer for Aerial Tracking(针对无人机视频)

- Learning spatio-temporal transformer for visual tracking(简称STARK)

- Transformer Tracking(简称TransT)

- High-Performance Discriminative Tracking with Transformers(简称DTT)

- Transformer meets tracker:Exploiting temporal context for robust visual tracking(简称TrDiMP/TrSiam)

- TrTr: Visual Tracking with Transformer

- Learning Tracking Representations via Dual-Branch Fully Transformer Networks(简称DualTFR)

- 2022

-

- SwinTrack: A simple and strong baseline for transformer tracking(简称SwinTRACK)

- ProContEXT: Exploring Progressive Context Transformer for Tracking

- Joint Feature Learning and Relation Modeling for Tracking: A One-Stream Framework(简称OStrack)

- MixFormer: End-to-end tracking with iterative mixed attention

- Backbone is all your need: A simplified architecture for visual object tracking

- Transforming Model Prediction for Tracking(简称Tomp)

- SparseTT: Visual Tracking with Sparse Transformers

- ==CSWinTT: Transformer Tracking with Cyclic Shifting Window Attention(简称CSWinTT)==

- ‘==AiATrack: Attention in attention for transformer visual tracking==

- Unified Transformer Tracker for Object Tracking (这是一个mot和sot统一的跟踪器)

- Siamese Transformer Pyramid Networks for Real-Time UAV Tracking(无人机实时跟踪)

- 2023

-

- ==Generalized Relation Modeling for Transformer Tracking(改进ostrack)==

- ==DropMAE:Masked autoencoders with spatial-attention dropout for tracking tasks==

- Representation learning for visual object tracking by masked appearance transfer

- SeqTrack

- Autoregressive visual tracking(简称ARtrack)

- Foreground-Background Distribution Modeling Transformer for Visual Object Tracking(无人机+轻量化transformer)

- Exploring Lightweight Hierarchical Vision Transformers for Efficient Visual Tracking(轻量化)

- 2024

-

- RTracker: Recoverable Tracking via PN Tree Structured Memory(简称RTtracker)

- Autoregressive Queries for Adaptive Tracking with Spatio-Temporal Transformers

- HIPTrack: Visual Tracking with Historical Prompts

- DiffusionTrack: Point Set Diffusion Model for Visual Object Tracking(基于diffusion后面可以仔细看看)

- ARTrackV2: Prompting Autoregressive Tracker Where to Look and How to Describe(简称ARTrackv2)

- ODTrack: Online Dense Temporal Token Learning for Visual Tracking(简称ODTrack)

- Tracking Meets LoRA: Faster Training, Larger Model, Stronger Performance

- 总结

- 未来方向

查看跟踪器排行榜的地址

目前找到的比较新的综述:Transformers in Single Object Tracking:An Experimental Survey

参考帖子2

参考帖子

基于transformer的目标跟踪的几种基本架构

2021

Tokens-to-Token ViT: Training Vision Transformers from Scratch on ImageNet(引入cnn提升transformer提取局部特征的能力)

HiFT: Hierarchical Feature Transformer for Aerial Tracking(针对无人机视频)

创新点:

高分辨率特征编码和低分辨率特征解码。前者旨在学习不同特征层之间的相互依赖关系和空间信息,以引起对不同尺度(特别是低分辨率对象)对象的关注。而后者则聚合低分辨率特征图中的语义信息。

具体:

我们采用来自深层(第5层)的低分辨率特征来替代对象查询。同时,我们还将浅层(3,4层)特征输入Transformer,通过端到端训练,发现具有强辨别力的跟踪定制特征空间,该空间隐式地建模了高分辨率层的空间信息和低分辨率层的语义线索之间的关系。

总结:

使用的是一个标准的编码-解码结构,将卷积网络不同层的特征作为transformer的输入.。transformer的输出特征,经过分类和回归得到目标的位置。一个优点是使用轻量化的特征提取网络。

结果:

Learning spatio-temporal transformer for visual tracking(简称STARK)

为什么:

捕捉视频序列中空间和时间信息的全局特征依赖关系能有效提升跟踪性能

创新点:

1.一个模板更新策略

2.编码器建模目标和追踪区域之间的全局时空特征依赖,解码器学习一个query embedding来预测目标对象的空间位置。将目标追踪看作一个直接的边界框预测问题

具体:

架构包含三个关键组件:编码器、解码器和预测头。

编码器接受初始目标对象、当前图像和动态更新的模板作为输入。

编码器中的自注意模块通过特征依赖关系学习输入之间的关系。由于模板图像在视频序列中不断更新,编码器可以捕捉目标的空间和时间信息。

解码器学习查询嵌入以预测目标对象的空间位置。基于角点的预测头用于估计当前帧中目标对象的边界框。同时,得分头被用来控制动态模板图像的更新。

总结:

cnn提取搜索帧,模板帧,动态模板帧特征,融合为一个包含时空信息的特征输入编码器。编码器输出和解码器输出融合形成一个强化特征然后去进行回归和分类得到目标位置,同时根据解码器的输出去更新一个动态模板。

解码器输入可以是模板帧。引导解码器关注特定的目标对象。

Transformer Tracking(简称TransT)

为什么:互相关操作本身是一个局部线性匹配过程,容易丢失语义信息,陷入局部最优,这可能是设计高精度跟踪算法的瓶颈。

具体:

结果:

总结:本质上就是提取模板帧和搜索帧特征通过特征融合模块形成一个强化特征,然后进行回归与分类

High-Performance Discriminative Tracking with Transformers(简称DTT)

具体:

总结:就是使用了一个简单的编码-解码结构,解码器的输入是测试帧。

Transformer meets tracker:Exploiting temporal context for robust visual tracking(简称TrDiMP/TrSiam)

为什么:相邻帧间存在着丰富的时空上下文信息,但这一宝贵的资源尚未在现有的追踪算法中得到充分利用。本文通过引入Transformer架构,成功地将这些被忽视的上下文信息转化为强大的追踪优势。

具体:

将本文框架用于孪生网络/相关滤波框架如下,也就是编码器和解码器分别输出一个强化的特征,然后siamfc对这两个特征进行相关运算。

后续马丁大神的TOMP则是使用transformer去获预测一个跟踪模型(在相关滤波中也就是通过数据去获得滤波器w,而不是通过传统的优化目标函数来获得了)

TrTr: Visual Tracking with Transformer

解决问题:基于Siamese的和基于DCF的跟踪器已经统治了目标跟踪领域,但是它们都使用cross-correlation操作来获得模板特征和搜索区域特征之间的联系,但这个操作只能获得两个特征中局部区域之间的联系,而不能获得全局的联系

具体:

==总结:==还是遵循以下模式

cnn提取特征--------------编码器输入模板特征,解码器输入搜索帧特征——>>transfomer解码器输出一个强化特征----------------->>>>对强化特征进行回归分类

此外还设计了一个在线优化模块,具体后面再看是怎么实现的

甚至还没有利用多帧的时序信息,前面几篇文章,TrDiMP和stark都利用了,编码器输入是多帧图片提取特征然后融合得到的包含时间信息的特征

Learning Tracking Representations via Dual-Branch Fully Transformer Networks(简称DualTFR)

为什么:大多数方法仍然在很大程度上依赖CNN来提取特征,并仅在最后一层使用Transformer通过全局注意力进行特征融合。尽管这些方法在基准数据集上的跟踪精度得到了显著提升,但一个自然的问题随之而来——既然Transformer能够建模不同区域之间的结构依赖,它是否也能提升早期特征提取步骤的效果?我们旨在本研究中回答这个问题。

下面是本文和cnn+transformer架构的对比:

具体:

下面是文中定义的局部注意力和全局注意力:

总结:首次提出了不适用cnn提取特征,而使用自己设计的局部注意力+全局注意力提取特征,还设计了一个交叉注意力模块将特征融合,然后进行回归与分类。

感觉这种特征提取方法在卫星图像上或许有效,后面试一下用在卫星视频的目标跟踪

结果:

超过STARK,transT

2022

SwinTrack: A simple and strong baseline for transformer tracking(简称SwinTRACK)

为什么:

现有的基于Transformer的跟踪器大多使用Transformer来融合和增强CNN生成的特征。相比之下,在本文中提出了一种完全基于注意力的Transformer跟踪算法,Swin-Transformer Tracker(SwinTrack)。SwinTrack使用Transformer进行特征提取和特征融合,允许目标对象和搜索区域之间的完全交互以进行跟踪

具体:

总结:

使用transformer提取特征,然后concate 输入编码器,将编码器输出和运动token结合输入解码器,形成一个强化特征,然后进行分类回归。

作者在解码器这一块没有使用输入查询,还进行了消融实验具体分析,作者做了一大堆解释,还没有看懂,后面再仔细研究

结果:

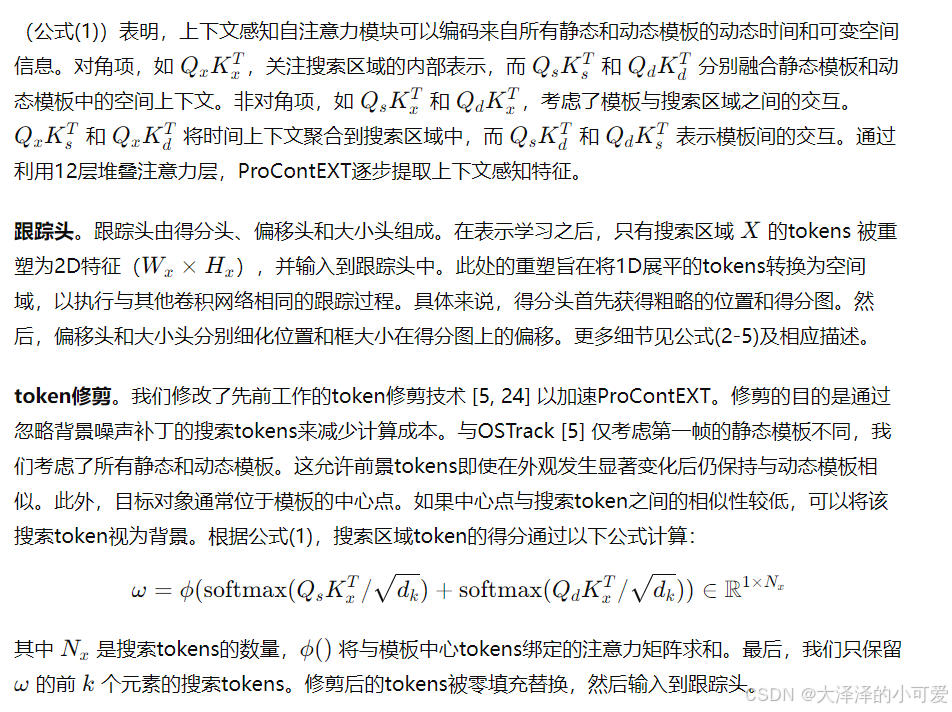

ProContEXT: Exploring Progressive Context Transformer for Tracking

为什么:

由于形变、遮挡、快速变化和拥挤的场景、相似等问题,跟踪器必须动态学习目标形状变化信息,Transformer的方法(,由于缺乏上下文信息,它们的性能在快速变化的场景中受到影响。为了解决这个问题,空间上下文学习)被提出、发展。此外,动态模板更新已被用于各种视觉任务(包括感知、分割、跟踪和密度估计),用于空间上下文建模。然而,对跟踪任务的时间和空间上下文的全面研究仍有待实现。

具体:

动态模板是在不同帧生生成的,关注目标外形变化。静态模板是同一张图上不同尺度下形成的,关注周围相似目标,然后和搜索帧共同输入一个类似于VIT的结构。作者设计了一个上下文感知注意力

](https://i-blog.csdnimg.cn/direct/cb84a234d8d94e94b7543dde861d26b6.png)

==总结:==所谓时间信息实际上也就是不同帧提取的模板信息,然后输入到VIT结构中,本文的VIT自己设计了一个上下文感知注意力来融合输入的三种信息。

结果:

Joint Feature Learning and Relation Modeling for Tracking: A One-Stream Framework(简称OStrack)

为什么:

然而,特征提取和关系建模的分离存在以下局限性。首先,由传统的双流两阶段框架提取的特征与目标无关。换句话说,每张图像的提取特征在离线训练后就已确定,因为模板和搜索区域之间没有交互。这与目标的持续变化和任意性质相违背,导致目标和背景的辨别能力有限。在目标对象的类别不在训练数据集中(即一次性跟踪)时,上述问题尤为严重。其次,双流两阶段框架容易受到性能与速度的权衡影响。根据特征融合模块的计算负担,通常采用两种不同的策略。第一种,如图2(a)所示,简单地采用交叉相关[1,27]或判别相关滤波器[2,7]等单一算子,这种方法高效但效果较差,因为简单的线性操作会导致辨别信息的丢失[5]。第二种,如图2(b)所示,通过复杂的非线性交互(Transformer[44])解决信息丢失问题,但由于参数众多且使用迭代优化(例如,对于每个搜索图像,STARK-S50[50]在RTX2080Ti GPU上花费7.5毫秒进行特征提取和14.1毫秒进行关系建模),效率较低。

在这项工作中,我们通过一个统一的单流单阶段跟踪框架来解决上述问题。单流框架的核心思想是在早期阶段(即原始图像对)桥接模板和搜索区域之间的自由信息流,从而提取面向目标的特征并避免辨别信息的丢失。具体来说,我们将展平的模板和搜索区域连接起来,输入堆叠的自注意力层[44](我们在实现中选择了广泛使用的视觉Transformer(ViT)[12]),生成的搜索区域特征可以直接用于目标分类和回归而无需进一步匹配。堆叠的自注意力操作使模板和搜索区域之间能够迭代特征匹配,从而允许相互指导进行目标导向的特征提取。因此,模板和搜索区域的特征都可以动态提取,具有很强的辨别力。此外,所提出的框架在性能和速度之间达到了良好的平衡,因为模板和搜索区域的连接使得单流框架高度并行化,并且不需要额外的复杂关系建模网络。

此外,所提出的单流框架提供了一个关于目标和搜索区域每个部分(即候选者)相似性的强先验,如图4所示,这意味着模型甚至在早期阶段就可以识别背景区域。这一现象验证了单流框架的有效性,并促使我们提出了一个网络内的早期候选者消除模块,以便及时逐步识别和剔除属于背景的候选者。所提出的候选者消除模块不仅显著提高了推理速度,还避免了无信息背景区域对特征匹配的负面影响。尽管结构简单,所提出的跟踪器在多个基准上取得了令人印象深刻的性能,并且保持了可爱的推理效率,显示出比现有Transformer跟踪器更快的收敛速度。如图1所示,我们的方法在精度和推理速度之间取得了良好的平衡。

创新点:

这项工作的主要贡献有三点:(1)我们提出了一个简单、整洁且有效的单流单阶段跟踪框架,通过结合特征提取和关系建模。(2)受目标和搜索区域每个部分之间早期获取的相似性得分的先验启发,提出了一个网络内的早期候选者消除模块,以减少推理时间。(3)我们进行了全面的实验,验证了单流框架在性能、推理速度和收敛速度方面优于之前的SOTA双流跟踪器。最终的跟踪器OSTrack在多个跟踪基准上创造了新的最先进水平。

具体:

网络内的早期候选者消除模块的大致思想:

1.search图像中的每个patch都可以被看作是一个目标候选区域。

2.在每个候选消除模块中,每个候选区域会被计算一个与template图像的相似度作为其得分,得分最高的k个候选区域会被保留下来,其他的候选区域则会被丢弃。

3.为了避免template中背景区域的影响,在本文中作者并没有使用候选区域与每个template patch计算相似度并取均值,而是直接计算其与template最中心位置的patch之间的相似度作为其得分。可以这样做的原因在于经过self-attention操作之后,中心的template

patch已经聚集了足够的目标信息。

4.由于这些背景区域不会对分类和回归操作造成影响,因此在Transformer输出之前,这些中途被丢弃的区域直接做zero-padding (作者想法)即可将特征恢复成原尺寸。

(感觉这个作者写的非常好直接拿过来了,https://blog.youkuaiyun.com/qq_44799766/article/details/131074627)

结果:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

859

859