通过第四期课程《LMDeploy 量化部署 LLM&VLM实战》的学习,对LMDeploy量化部署有了进一步深刻认识,由于此时github不能正常访问,目前只看视频学习做笔记。

课程视频:https://www.bilibili.com/video/BV1tr421x75B/

课程文档:https://github.com/InternLM/Tutorial/blob/camp2/lmdeploy/README.md

课程主要从大模型部署背景、方法、LMDeploy简介和动手实践四个环节进行。

1 部署背景

简单说明大模型在软件工程及AI领域的使用及关键作用,部署所涉及应用场景等。

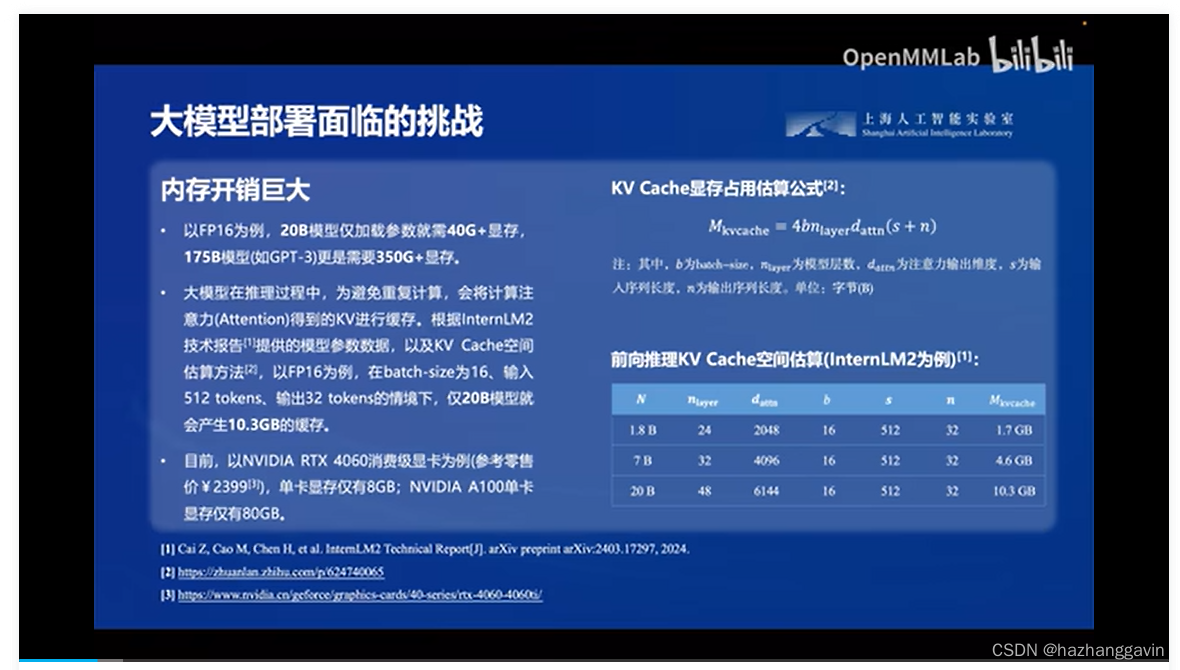

接着就大模型部署所面临的挑战:计算量巨大、内存开销巨大、访问瓶颈及动态请求量大等几个维度困难度,并实例量化说明。

2 部署方法

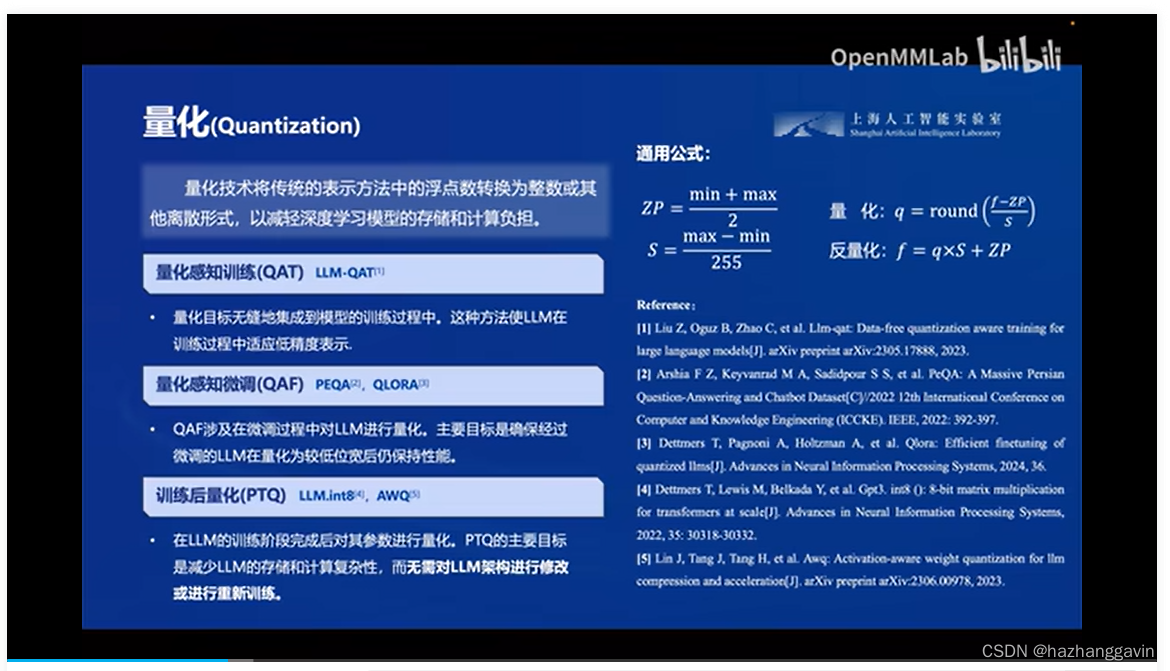

针对大模型部署所面临的挑战,对模型可以做三种技术处理方法:模型减枝、知识蒸馏及量化等。

3 LMDeploy简介

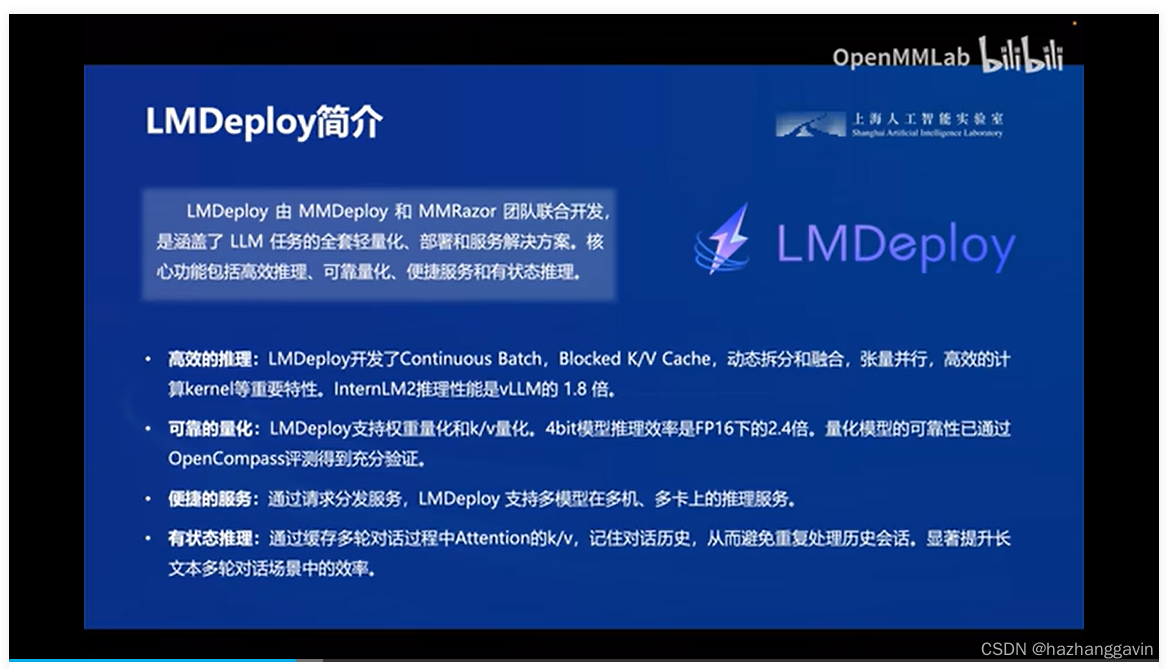

LMDeploy 由 MMDeploy 和 MMRazor 团队联合开发,是涵盖了 LLM 任务的全套轻量化、部署和服务解决方案。 其核心功能如下 :

多 GPU 部署和量化,性能卓越。

LMDeploy 支持多种推理后端。

4 动手实践

由于此时github不能正常访问,待后续补充。

本文介绍了通过《LMDeploy量化部署LLM&VLM实战》课程,对大模型部署的关键背景、挑战、LMDeploy技术解决方案(包括模型减枝、知识蒸馏和量化)以及多GPU部署进行了详细学习,但因GitHub访问问题,动手实践部分暂无更新。

本文介绍了通过《LMDeploy量化部署LLM&VLM实战》课程,对大模型部署的关键背景、挑战、LMDeploy技术解决方案(包括模型减枝、知识蒸馏和量化)以及多GPU部署进行了详细学习,但因GitHub访问问题,动手实践部分暂无更新。

801

801

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?