Open WebUI+Ollama+本地LLM是大模型本地化部署典型落地手段,其实Open WebUI并非一定与Ollama配套,可以直接与在线的大模型比如openai、deepseek等结合使用。本文仅介绍通过简单的配置,实现Open WebUI与deepseek的结合。

前提条件:先申请deepseek的API key。

具体配置过程如下:

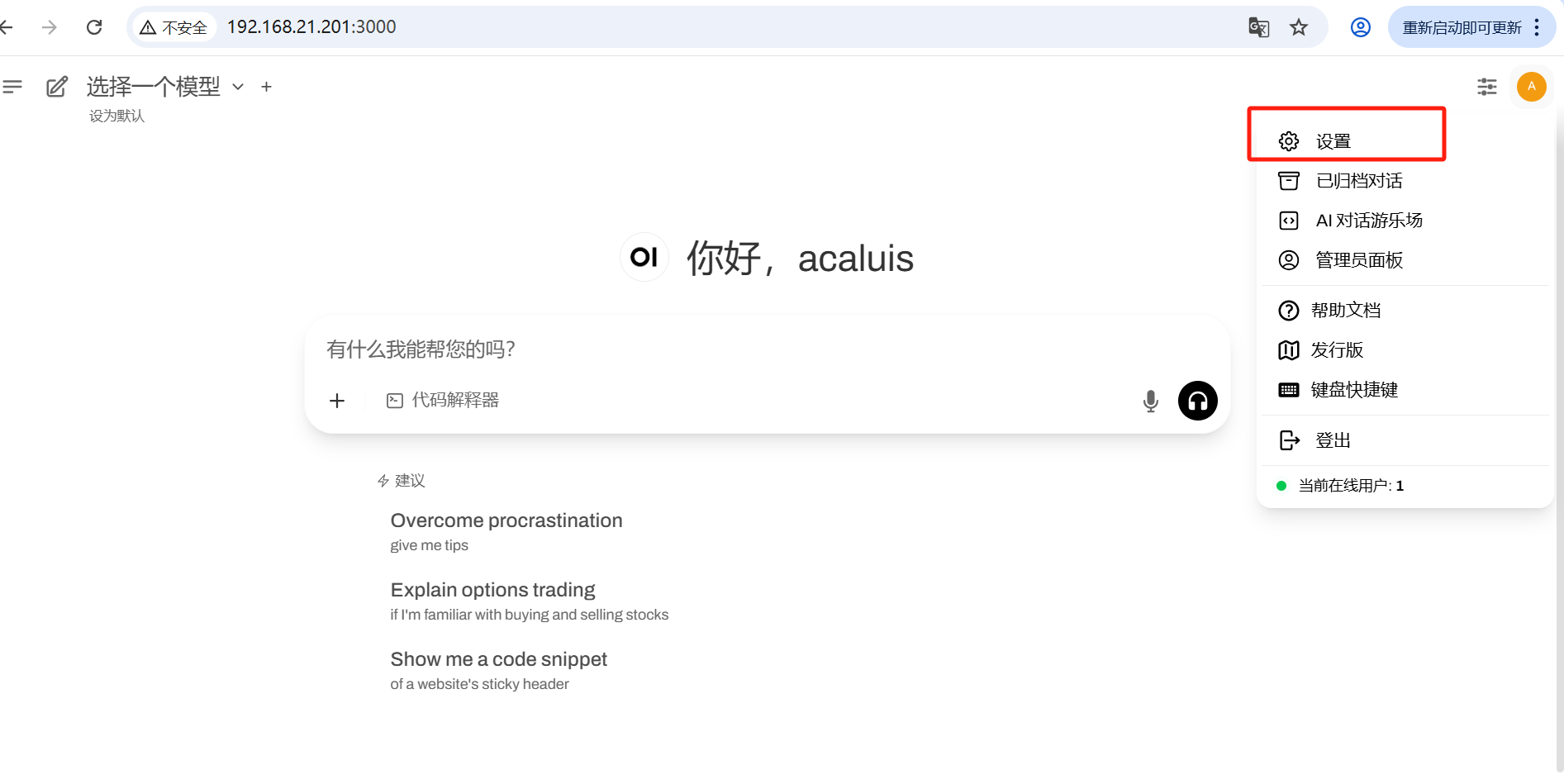

(1)找到管理员设置入口

(2)选择【设置】进入管理员设置页面:

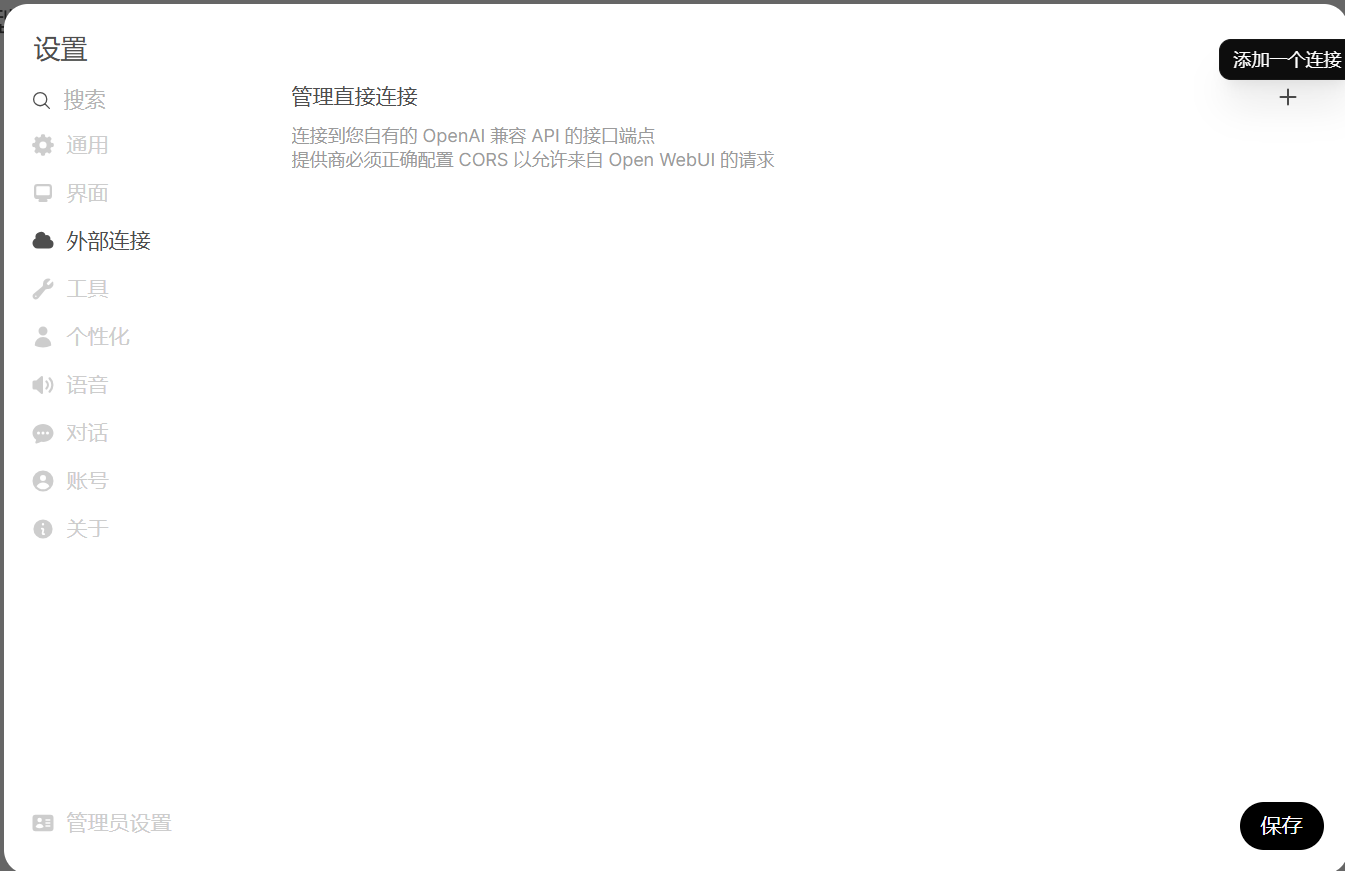

(3)选择【外部连接】,进入管理直接连接页面

(4)选择添加一个链接 【+】

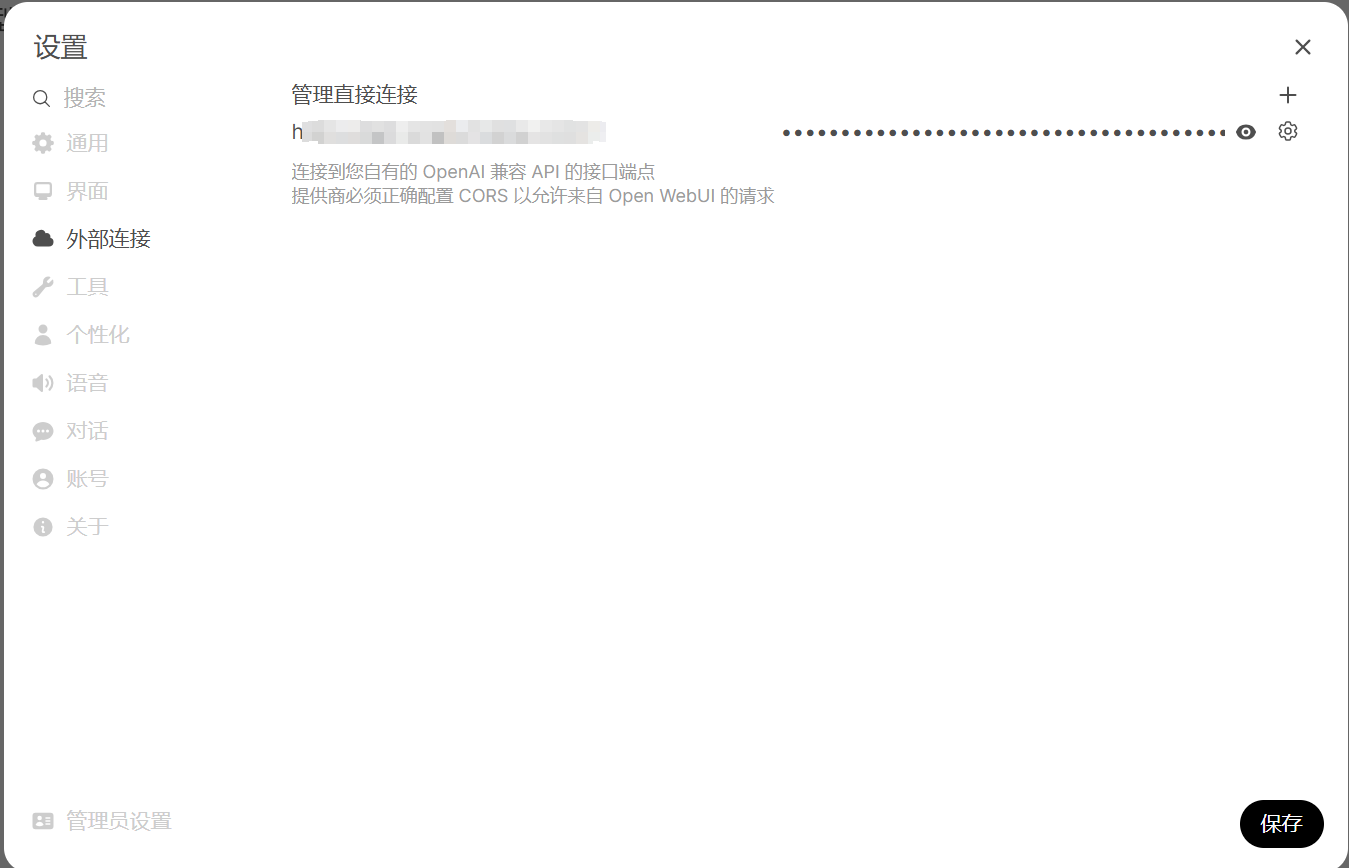

填写外部模型URL和API KEY并保存,进入最终保存页面:

确认无误后,保存。左上角显示新增加的模型。可以使用进行对话。

7341

7341

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?