orin 平台最简单和快捷的布置deepseek方法

部分内容可参考Nvidia(Ollama - NVIDIA Jetson AI Lab)

https://www.jetson-ai-lab.com/tutorial_ollama.html

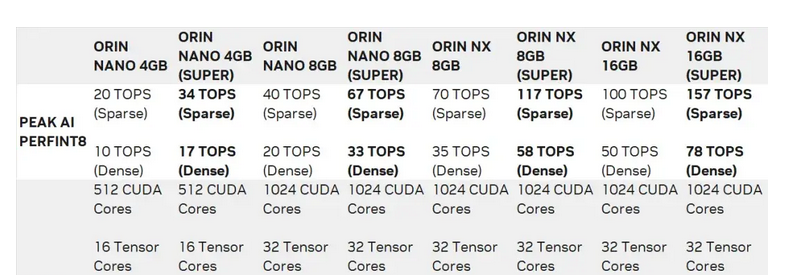

测试机器(中电港-Cecport):nvidia Jetson Orin nano/nx ;AGX orin套件

软件版本:Jetpack 6.2 ,R36.4.3

最新Jetpack 6.2 支持super 工作模式,在测试前切换到super模式,可提高机器性能,体现模型token 输出结果流畅

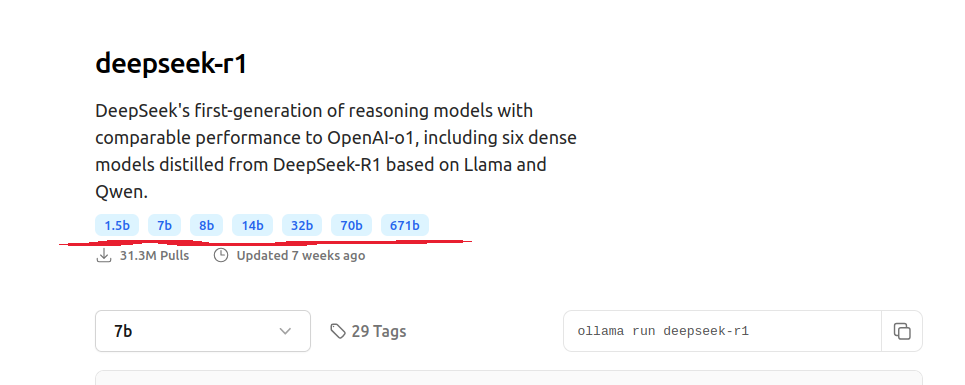

先在ollama 官方查找下,ollama 上 deepseek-R1 版本,从1.5B ,7B-至671B 共7个版本

https://www.ollama.com/library/deepseek-r1

两种安装方式可以实现:

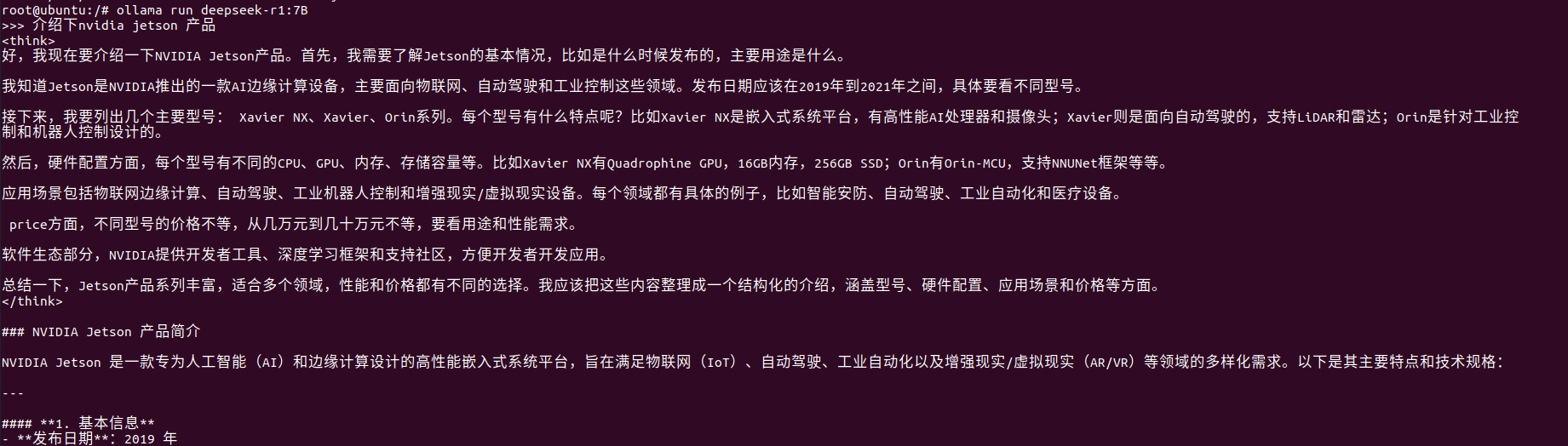

1. 第一种方式在Ollama's 官方下载脚本安装, 安装快捷简单,虽然功能可以实现,但是显示终端和互操作性很不友好,

curl -fsSL https://ollama.com/install.sh | sh

ollama run deepseek-r1:7b

2. 采用英伟达官方提供的 docker 容器安装 ollma方式,配合open-webui 网页图形化界面操作显示。

(1)先安装docker

参考官方链接

Docker - NVIDIA Jetson AI Lab(https://www.jetson-ai-lab.com/tips_ssd-docker.html)

sudo apt update

sudo apt install -y nvidia-container curl

curl https://get.docker.com | sh && sudo systemctl --now enable docker

sudo nvidia-ctk runtime configure --runtime=docker

sudo systemctl restart docker

sudo usermod -aG docker $USER

newgrp docker

sudo apt install -y jq

sudo jq '. + {"default-runtime": "nvidia"}' /etc/docker/daemon.json | \

sudo tee /etc/docker/daemon.json.tmp && \

sudo mv /etc/docker/daemon.json.tmp /etc/docker/daemon.json

考虑后面下载过程中有错误问题,增加修改daemon.json

cecport@ubuntu:~ cat /etc/docker/daemon.json

{

"runtimes": {

"nvidia": {

"path": "nvidia-container-runtime",

"runtimeArgs": []

}

},"default-runtime": "nvidia",

"iptables": false,

"registry-mirrors": ["https://docker.registry.cyou","https://docker-cf.registry.cyou",

"https://dockercf.jsdelivr.fyi",

"https://docker.jsdelivr.fyi",

"https://dockertest.jsdelivr.fyi",

"https://mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://docker.mirrors.ustc.edu.cn",

"https://mirror.iscas.ac.cn",

"https://docker.rainbond.cc"]

}

sudo systemctl daemon-reload && sudo systemctl restart docker

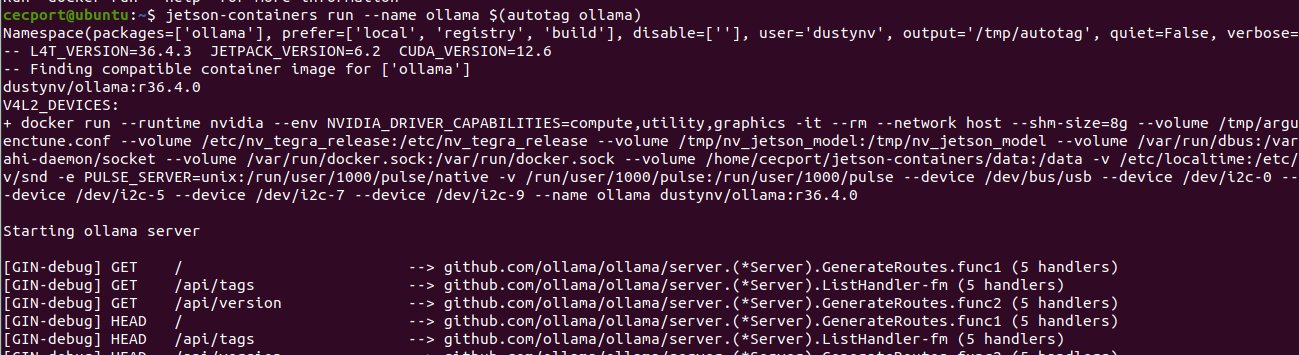

(2)安装 jetson容器

git clone https://github.com/dusty-nv/jetson-containers bash jetson-containers/install.sh

(3)在jetson 容器里面安装 运行ollama 和 下载 deekseek 7B模型

# models cached under jetson-containers/data

jetson-containers run --name ollama $(autotag ollama)

# models cached under your user's home directory

docker run --runtime nvidia --rm --network=host -v ~/ollama:/ollama -e OLLAMA_MODELS=/ollama dustynv/ollama:r36.4.0

jetson-containers run --name ollama $(autotag ollama)

ollama run deepseek-r1:7B

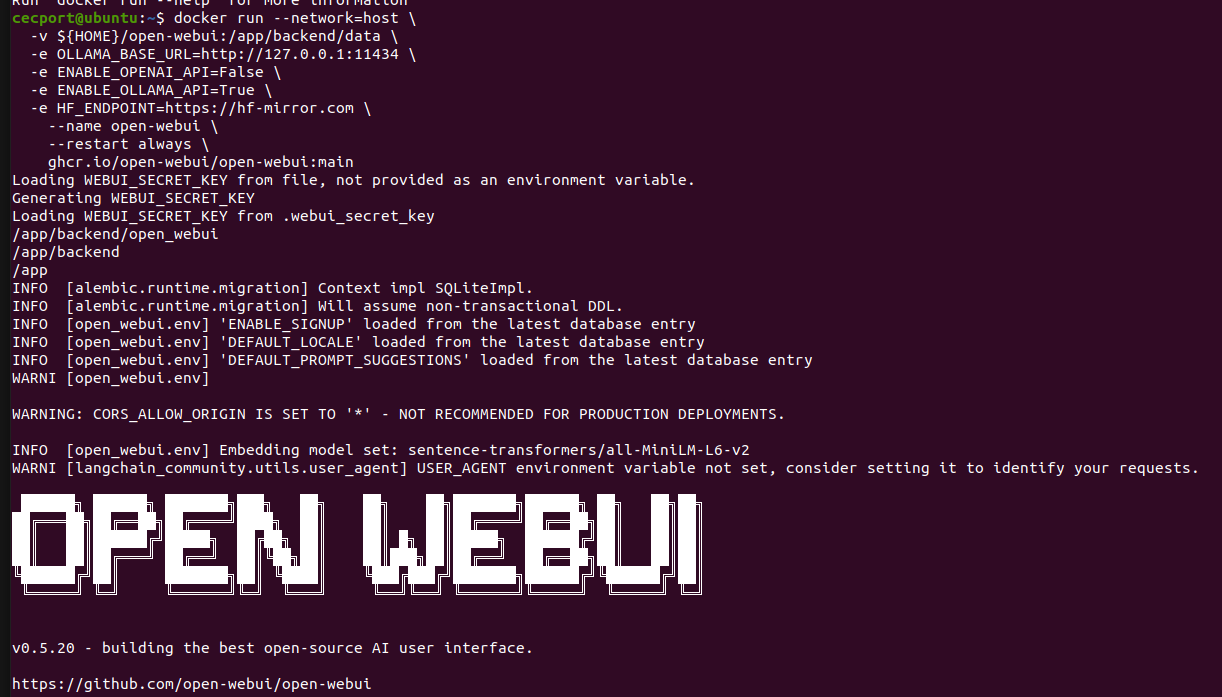

(4) 运行 OPEN webui

docker run --network=host \

-v ${HOME}/open-webui:/app/backend/data \

-e OLLAMA_BASE_URL=http://127.0.0.1:11434 \

-e ENABLE_OPENAI_API=False \

-e ENABLE_OLLAMA_API=True \

-e HF_ENDPOINT=https://hf-mirror.com \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

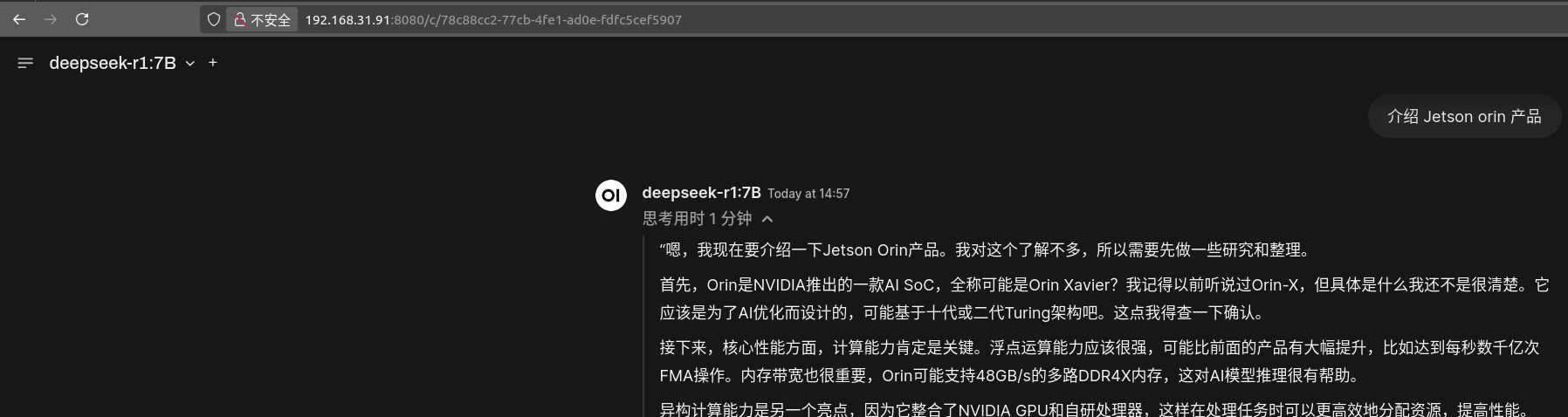

(5)通过浏览器访问 http://JETSON_IP:8080 进入web UI界面操作 注意 open webui账号和登陆注意账号和密码设置后需要记住,免得后面登陆失败,

测试输出结果,结果不是很满意,还能满

1052

1052

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?