模型评价指标

- 准确率

- 召回率(TP/(TP+FN) recall

- 查准率(TP/(TP+FP)-预测实际均正/(预测实际均正+预测正实际负)precision

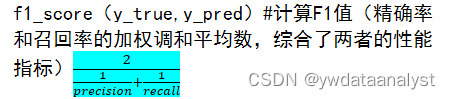

- f1_score(y_true,y_pred)#计算F1值(精确率和召回率的加权调和平均数,综合了两者的性能指标)21𝑝𝑟𝑒𝑐𝑖𝑠𝑖𝑜𝑛+1𝑟𝑒𝑐𝑎𝑙𝑙

|

混淆矩阵 |

预测值 | ||

|

Positive |

Negative | ||

|

真实值 |

Positive |

TP |

FN |

|

Negative |

FP |

TN |

特征工程

- 特征构造

常见特征:统计量特征(计数,求和,比例,标准差等),时间特征(相对时间和绝对时间,节假日双休日),空间特征(分箱,分布编码等)

处理方法:非线性变换(log/平方等);特征组合;特征交叉

- 特征选择

过滤式-先特征选择,再训练学习器-方法有Relief,方差选择,相关系数,互信息

在机器学习和特征选择中,互信息常被用作评估特征与目标变量之间的相关性,以确定哪些特征对于预测目标变量是最有价值的。较高的互信息表示特征与目标变量之间存在较强的相关性。

使用互信息进行特征选择的一般步骤如下:

- 计算每个特征与目标变量之间的互信息。

- 根据互信息的大小对特征进行排序,选择具有较高互信息的特征。

- 可以设置一个阈值或选择固定数量的特征,根据排序结果选择相关性较高的特征。

- 使用选定的特征进行建模和训练。

可用scikit-learn库中的mutual_info_classif(用于分类问题)和mutual_info_regression(用于回归问题)函数,进行互信息计算。

包裹式-直接把最终将要使用的学习器的性能作为特征子集的评价准则-方法有LVM

嵌入式-结合前两者,学习器训练过程中自动进行了特征选择-Lasso

- 降维-PCA LDA LCA 特征选择

代码中的一些函数

- zeros(9) # 创建一个长度为 9 的零数组

- map(function,iterable),map()函数用于对可迭代对象【如列表 元组等】中的每一个元素应用指定的函数,function是一个函数,iterable是一个可迭代对象。

- .map()方法是对 . 前的对象应用映射操作,即根据括号中的函数规则将原始值转换为新的值

- mean()计算均值

- concat()函数用于沿指定轴(行或列)将多个DataFrame对象或Series对象进行拼接

- axis参数用于指定连接操作沿哪个轴进行axis=0按行连接axis=1按列连接

|

uuid |

eid |

udmap |

common_ts |

x1 |

x2 |

x3 |

x4 |

x5 |

x6 |

x7 |

x8 |

|

0 |

26 |

{"key3":"67804","key2":"650"} |

1689673468244 |

4 |

0 |

41 |

107 |

206 |

1 |

0 |

1 |

- 题目分析

- uuid为样本唯一标识,eid为访问行为ID,udmap为行为属性,其中的key1到key9表示不同的行为属性,如项目名、项目id等相关字段,common_ts为应用访问记录发生时间(毫秒时间戳),其余字段x1至x8为用户相关的属性,为匿名处理字段。target字段为预测目标,即是否为新增用户。

- 新增时间特征 天 月份的时间特征 结果升

- 新增时间特征dayofweek 结果升

决策树(一般构造二叉树)

决策树的参数包括以下几个常见的参数:

- 最大深度(max_depth):指定决策树的最大深度,控制树的复杂程度和过拟合的风险。较大的最大深度可以提高模型的学习能力,但也容易造成过拟合。

- 最小样本划分数(min_samples_split):指定进行节点划分所需的最小样本数。如果某个节点的样本数量小于该值,则不再进行划分。增大该值可以限制决策树的生长,防止过拟合。

- 最小叶子节点样本数(min_samples_leaf):指定叶子节点上所需的最小样本数。如果叶子节点的样本数量小于该值,则不再进行进一步划分。增大该值可以限制决策树的生长,防止过拟合。

- 最大特征数(max_features):指定在每个节点上用于划分的特征数。可以是一个固定值,也可以是一个百分比。较小的特征数可以降低决策树的复杂度,防止过拟合。

- 分裂标准(criterion):指定用于衡量节点纯度或分裂质量的标准,常见的有基尼系数(gini)和信息增益(entropy)。

基尼系数 用来衡量不确定性。选择基尼系数最小的作为决策树节点,即下一步分类的依据,以此循环。以基尼系数为核心的是CART决策树。

如果决策树过于复杂,可以增加最大深度、最小样本划分数和最小叶子节点样本数等参数来限制其生长;如果决策树欠拟合,可以减小这些参数或调整分裂标准等来增加模型的复杂度。选择适当的参数可以帮助平衡模型的复杂度和性能。

198

198