提要:

使用ultralytics导出的onnx文件,使用onnx2ncnn工具转化后得到param文件,param文件只有out0,而目前github提供的yolo11.cpp都是out0,out1,out2。

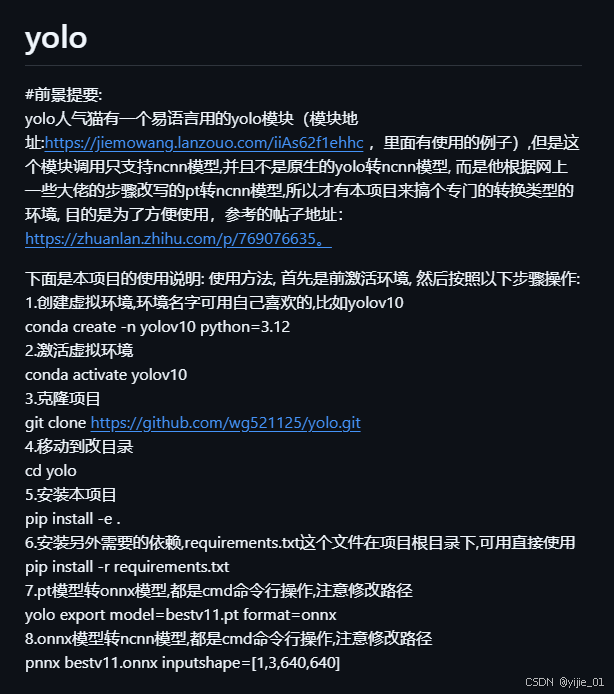

我们需要param文件中的out与他适配,这里感谢github作者wg521125提供的转换工具:

链接如下

https://github.com/wg521125/yolo?tab=readme-ov-file

链接页面:

亲测ultralytics训练得到的pt文件经过该工具转换后得到具有out0,ou1,ou2的param文件

再次致谢作者wg521125

845

845

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?