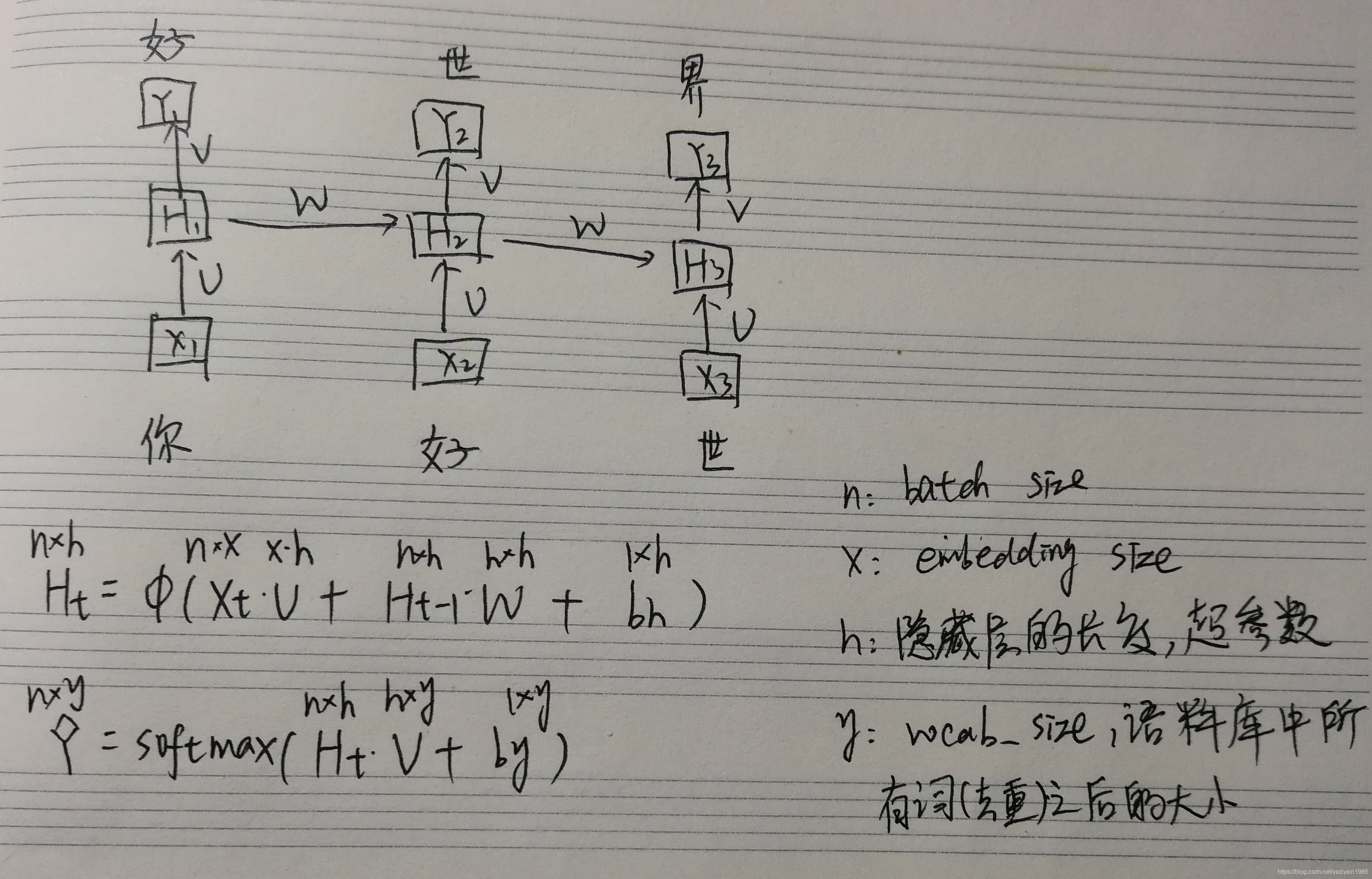

一、RNN

1.1 模型结构:

1.2 多层RNN

通过num_layers设置循环神经网络隐含层的层数,例如2。

对于一个多层循环神经网络,当前时刻隐含层的输入来自同一时刻输入层(如果有)或上一层隐含层的输出。每一层的隐含状态只沿着同一层传递。把单层循环神经网络中隐含层的每个单元当做一个函数f,这个函数在t时刻的输入是Xt, Ht-1,输出是Ht:

Ht = f(Xt, Ht-1)

加入输入为第0层,输出为第L+1层,在一共L个隐含层的循环神经网络中,上式可以拓展成以下的函数:

![]()

如下图所示:

1.3 双向RNN

二、LSTM

| 遗忘门: 更新门: |

本文详细介绍了循环神经网络(RNN)、LSTM、GRU和ELMO等序列模型,探讨了它们的结构和工作原理,如RNN的多层和双向结构,LSTM的门控机制,GRU的重置门和更新门,以及seq2seq模型和注意力机制在处理序列任务中的应用。此外,还讨论了解决不定长序列生成和模型优化的技巧。

本文详细介绍了循环神经网络(RNN)、LSTM、GRU和ELMO等序列模型,探讨了它们的结构和工作原理,如RNN的多层和双向结构,LSTM的门控机制,GRU的重置门和更新门,以及seq2seq模型和注意力机制在处理序列任务中的应用。此外,还讨论了解决不定长序列生成和模型优化的技巧。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?