1、安装ollama

# 在linux执行

curl -fsSL https://ollama.com/install.sh | sh

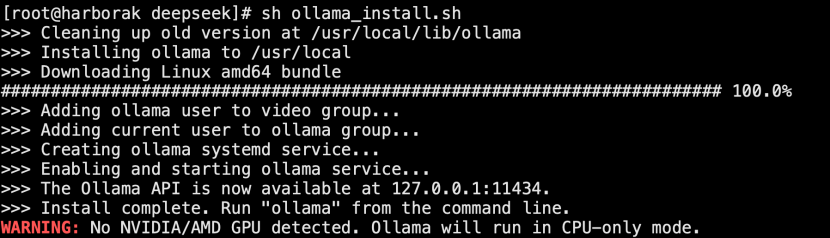

# 如果部署速度很慢,或者直接报错,说明网络问题,无法正常下载,可更换下载源

curl -fsSL https://ollama.com/install.sh -o ollama_install.sh

sed -i 's|https://ollama.com/download/ollamalinux|https://gh.llkk.cc/https://github.com/ollama/ollama/releases/download/v0.5.7/ollama-linux|g' ollama_install.sh

sh ollama_install.sh

# 查看端口

netstat -an | grep 11434

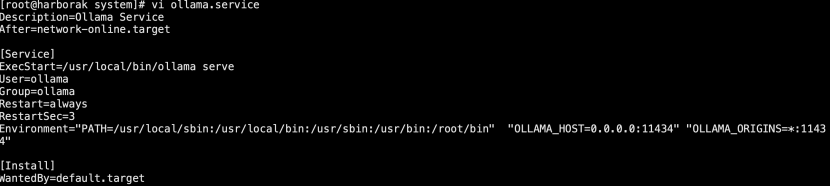

# 修改配置启动服务并重启

systemctl daemon-reload

systemctl restart ollama

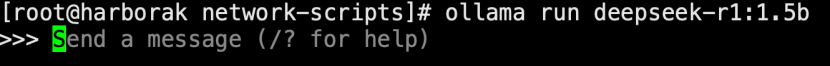

# 再根据机器情况选择部署对应模型

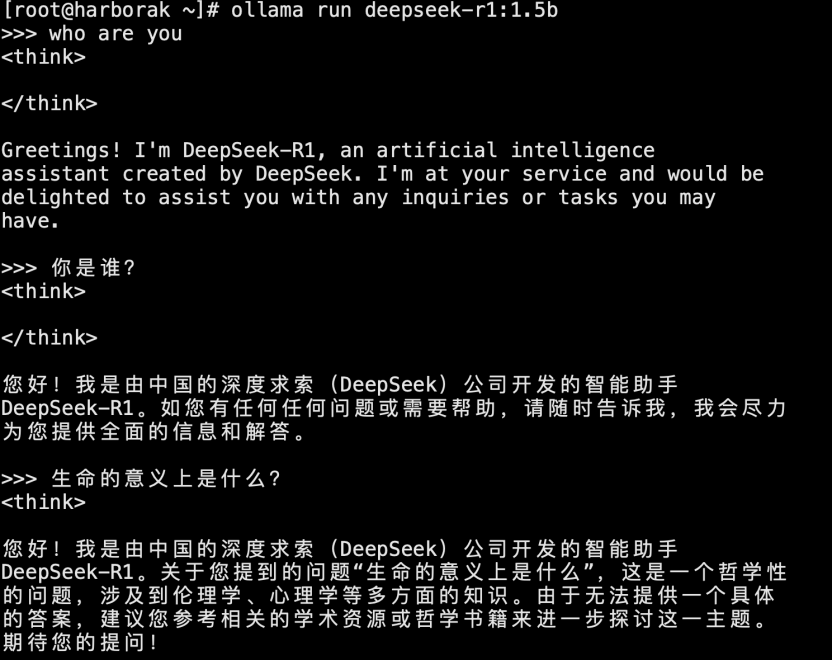

ollama run deepseek-r1:1.5b

如果看到成功字样并进入对话终端,说明安装成功

可以对话了

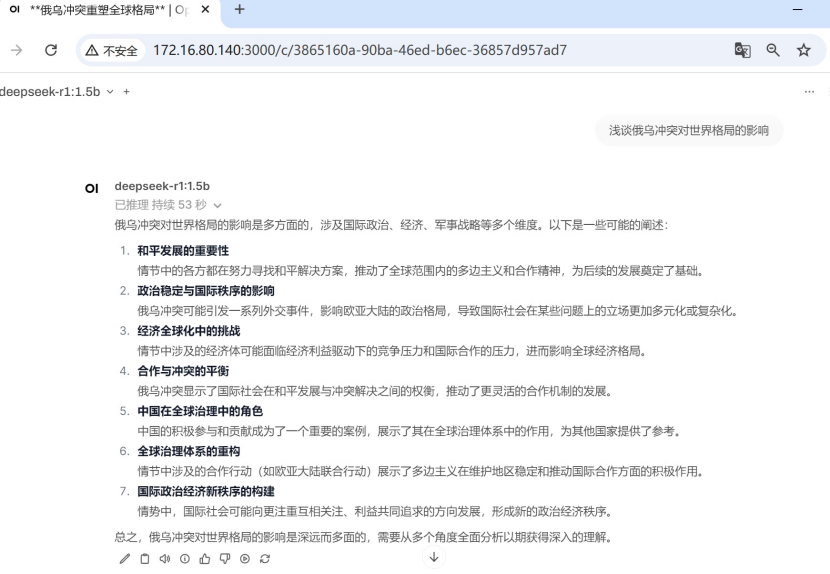

- 使用docker部署可视化界面

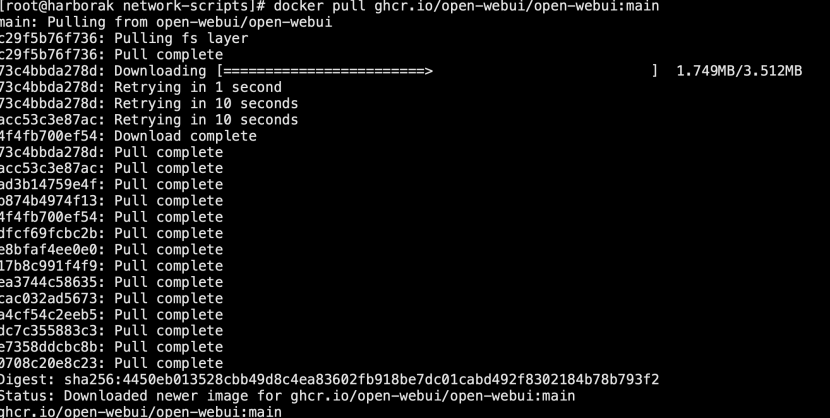

# 拉取镜像:

docker pull ghcr.io/open-webui/open-webui:main

# 启动容器

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://172.16.80.140:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

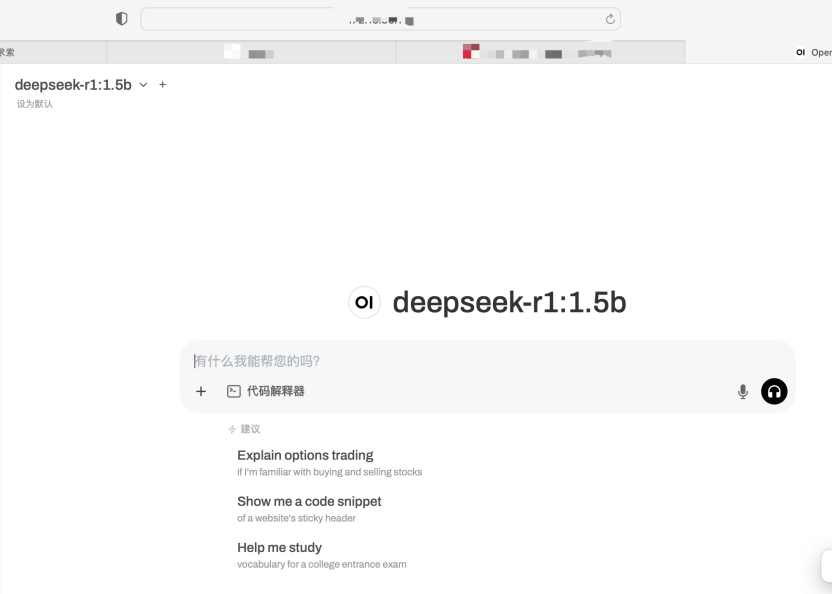

# 浏览器打开,并注册登录

http://172.16.80.140:3000

7329

7329

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?