FLOPS (floating-point operation per second)

计算机芯片的计算能力分为四个方面:整数运算,浮点计算,字符和字符串处理,寻址能力和IO。FLOPS(floating-point operation per second)即每秒浮点运算次数,用于衡量计算机的算力和执行效能。

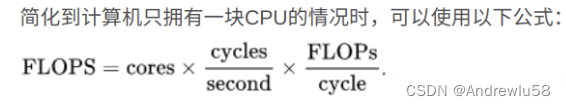

浮点运算能力 = 处理器核数 * 每周期浮点运算次数 * 处理器主频

除了FLOPS,还有MFLOPS、GFLOPS、TFLOPS、PFLOPS、EFLOPS等单位,

MFLOPS:megaFLOPS,每秒10^6次浮点运算,相当于每秒一百万次浮点运算

GFLOPS:gigaFLOPS,每秒10^9次浮点运算,相当于每秒十亿次浮点运算

TFLOPS:teraFLOPS,每秒10^12次浮点运算,相当于每秒一万亿次浮点运算

PFLOPS:petaFLOPS,每秒10^15次浮点运算,相当于每秒一千万亿次浮点运算

EFLOPS:exaFLOPS,每秒10^18次浮点运算,相当于每秒一百亿亿次浮点运算浮点运算会比整数运算更消耗时间,不过现在的处理器中通常会有FPU(floating point unit).在FPU出现之前,计算机计算小数运算都是使用整数运算模拟的,非常不精确。另外在实际应用中算力只能作为

本文介绍了FLOPS(每秒浮点运算次数)的概念,用于评估计算机的算力。内容包括CPU、GPU的FLOPS计算方法,以及集群的FLOPS计算。此外,还讨论了TFLOP(teraflop)单位,并区分了统计效率和计算效率在深度学习中的不同角色。

本文介绍了FLOPS(每秒浮点运算次数)的概念,用于评估计算机的算力。内容包括CPU、GPU的FLOPS计算方法,以及集群的FLOPS计算。此外,还讨论了TFLOP(teraflop)单位,并区分了统计效率和计算效率在深度学习中的不同角色。

订阅专栏 解锁全文

订阅专栏 解锁全文

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?