1.背景

2.环境

3. 前置准备

训练顺利运行需要包含4个必备条件:

1.机器本身的硬件和驱动支持(包含显卡驱动,网络环境等)

2.本项目及相关依赖的python库的正确安装(包含CUDA, Pytorch等)

3.目标训练模型文件的正确下载

4.训练数据集的正确构造和配置

3.1 LLaMA-Factory 安装

在安装 LLaMA-Factory 之前,请确保您安装了下列依赖:

运行以下指令以安装 LLaMA-Factory 及其依赖:

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

pip install -e ".[torch,metrics]" -i https://mirrors.aliyun.com/pypi/simple/如果出现环境冲突,请尝试使用 pip install --no-deps -e . 解决

(test) root@ubuntu:~# pip list |grep llamafactory

llamafactory 0.9.1.dev0 /srv/testenv/train/LLaMA-Factory

(test) root@ubuntu:~# pip list |grep accelerate

accelerate 0.34.2

(test) root@ubuntu:~#

(test) root@ubuntu:/srv/testenv/train/LLaMA-Factory# llamafactory-cli version

----------------------------------------------------------

| Welcome to LLaMA Factory, version 0.9.1.dev0 |

| |

| Project page: https://github.com/hiyouga/LLaMA-Factory |

----------------------------------------------------------

(test) root@ubuntu:/srv/testenv/train/LLaMA-Factory#

(test) root@ubuntu:/srv/testenv/LLaMA-Factory# python

Python 3.10.13 (main, Sep 11 2023, 13:44:35) [GCC 11.2.0] on linux

Type "help", "copyright", "credits" or "license" for more information.

>>> import torch

>>> torch.cuda.current_device()

0

>>> torch.cuda.get_device_name(0)

'NVIDIA GeForce RTX 4090'

>>> torch.__version__

'2.4.0+cu121'

>>>

>>> import transformers

>>> transformers.__version__

'4.45.2'

>>> 3.2 模型下载

git clone https://www.modelscope.cn/LLM-Research/Meta-Llama-3-8B-Instruct.git4. 原始模型直接推理

CUDA_VISIBLE_DEVICES=0 是指定了当前程序使用第0张卡,是指定全局变量的作用, 也可以不使用

llamafactory-cli webchat \

--model_name_or_path /srv/testenv/train/Meta-Llama-3-8B-Instruct \

--template llama3需要注意的是,本次及后续所有的程序的入口都是 llamafactory-cli, 通过不同的参数控制现在是实现什么功能,比如现在是想使用网页版本直接推理,所以第一个参数设置为webchat, 所有的可选项包括

| 动作参数枚举 | 参数说明 |

| version | 显示版本信息 |

| train | 命令行版本训练 |

| chat | 命令行版本推理chat |

| export | 模型合并和导出 |

| api | 启动API server,供接口调用 |

| eval | 使用mmlu等标准数据集做评测 |

| webchat | 前端版本纯推理的chat页面 |

| webui | 启动LlamaBoard前端页面,包含可视化训练,预测,chat,模型合并多个子页面 |

另外两个关键参数解释如下,后续的基本所有环节都会继续使用这两个参数

| 参数名称 | 参数说明 |

| 参数的名称(huggingface或者modelscope上的标准定义,如“meta-llama/Meta-Llama-3-8B-Instruct”), 或者是本地下载的绝对路径,如/media/codingma/LLM/llama3/Meta-Llama-3-8B-Instruct | |

| template | 模型问答时所使用的prompt模板,不同模型不同,请参考 https://github.com/hiyouga/LLaMA-Factory?tab=readme-ov-file#supported-models 获取不同模型的模板定义,否则会回答结果会很奇怪或导致重复生成等现象的出现。chat 版本的模型基本都需要指定,比如Meta-Llama-3-8B-Instruct的template 就是 llama3 |

当然你也可以提前把相关的参数存在yaml文件里,比如LLaMA-Factory/examples/inference/llama3.yaml

model_name_or_path: /srv/testenv/train/Meta-Llama-3-8B-Instruct

template: llama3这样就可以通过如下命令启动,其效果跟上面是一样的,但是更方便管理

llamafactory-cli webchat examples/inference/llama3.yaml效果如图,可通过 http://localhost:7860/ 进行访问

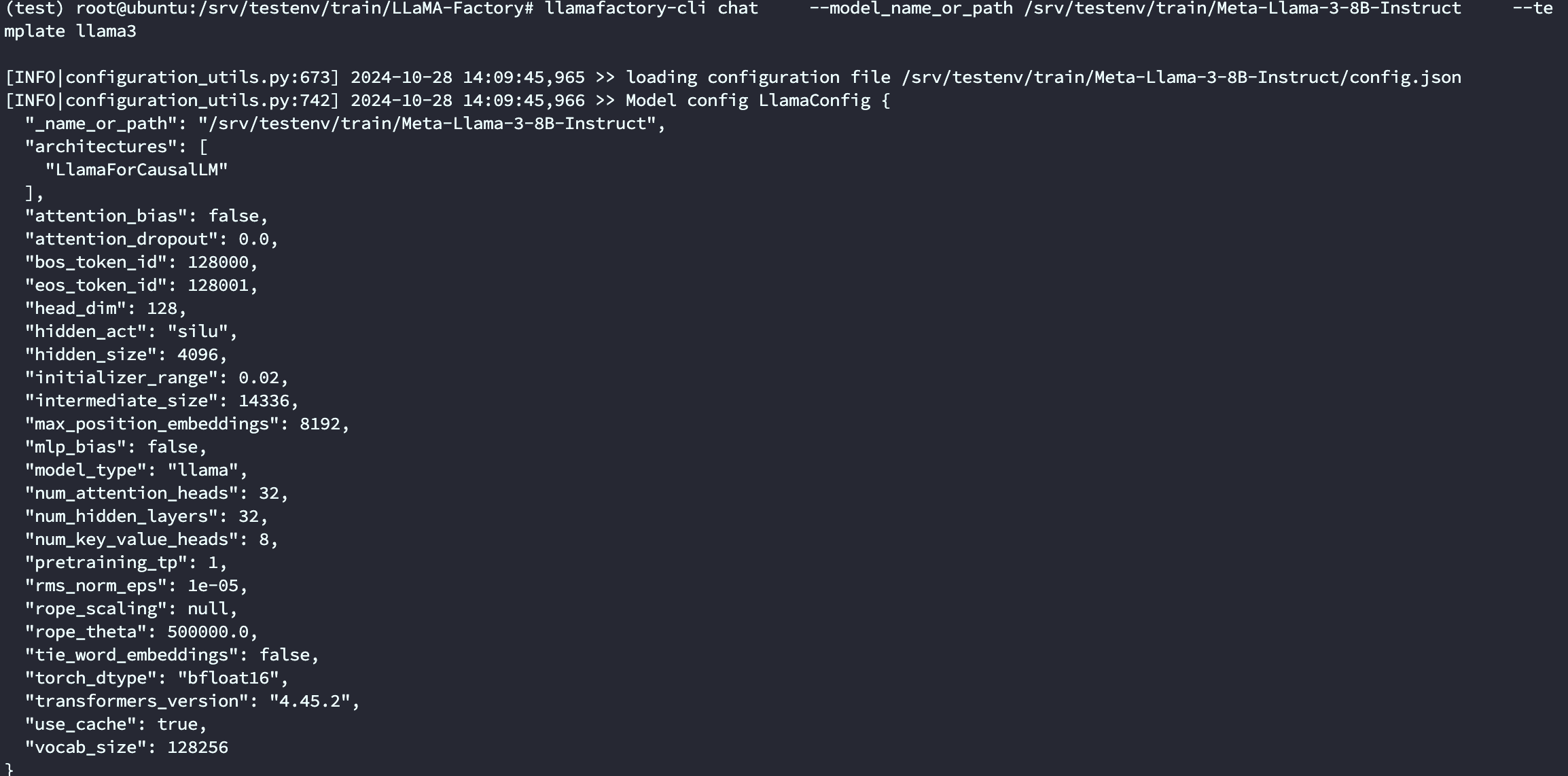

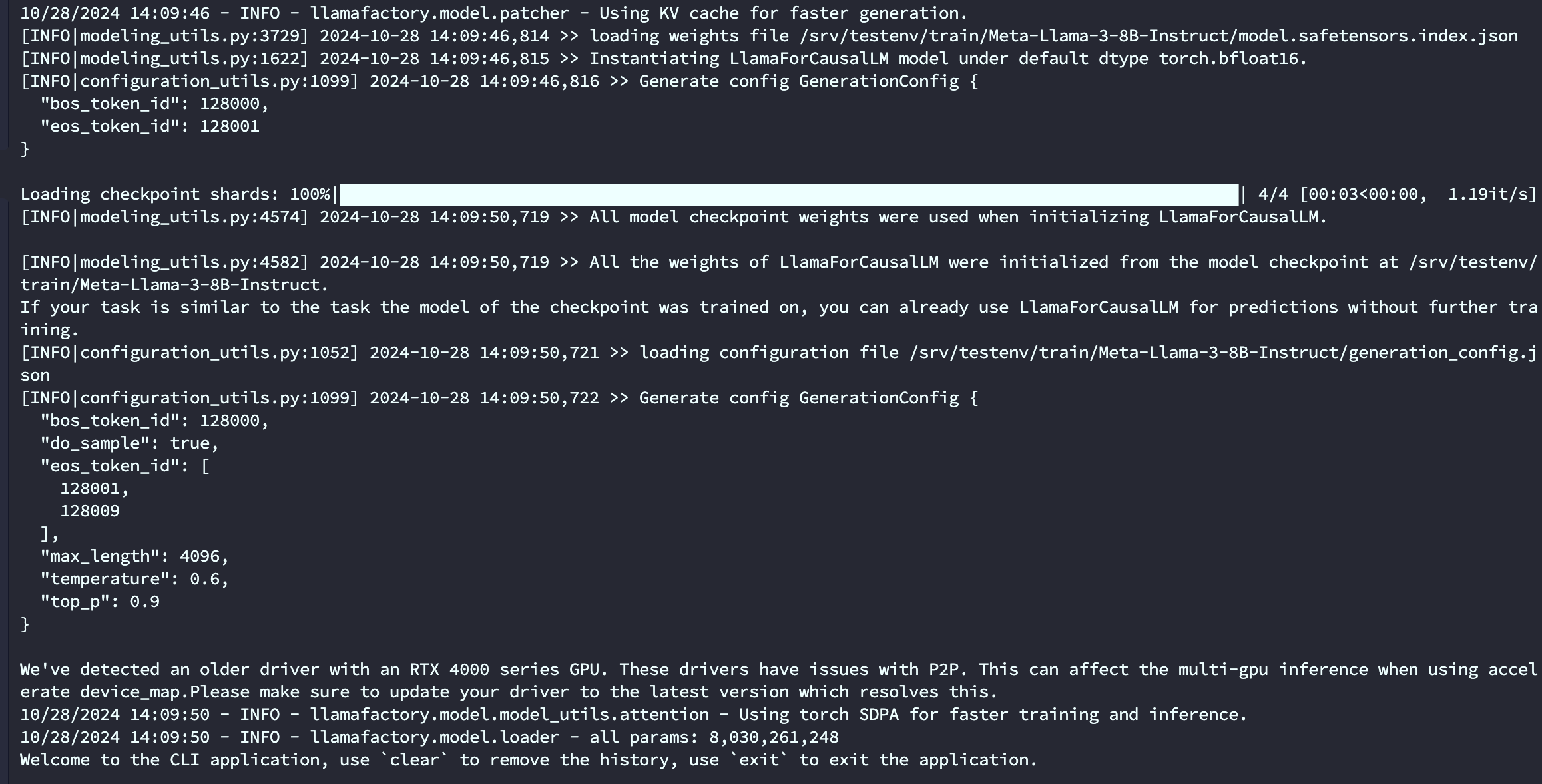

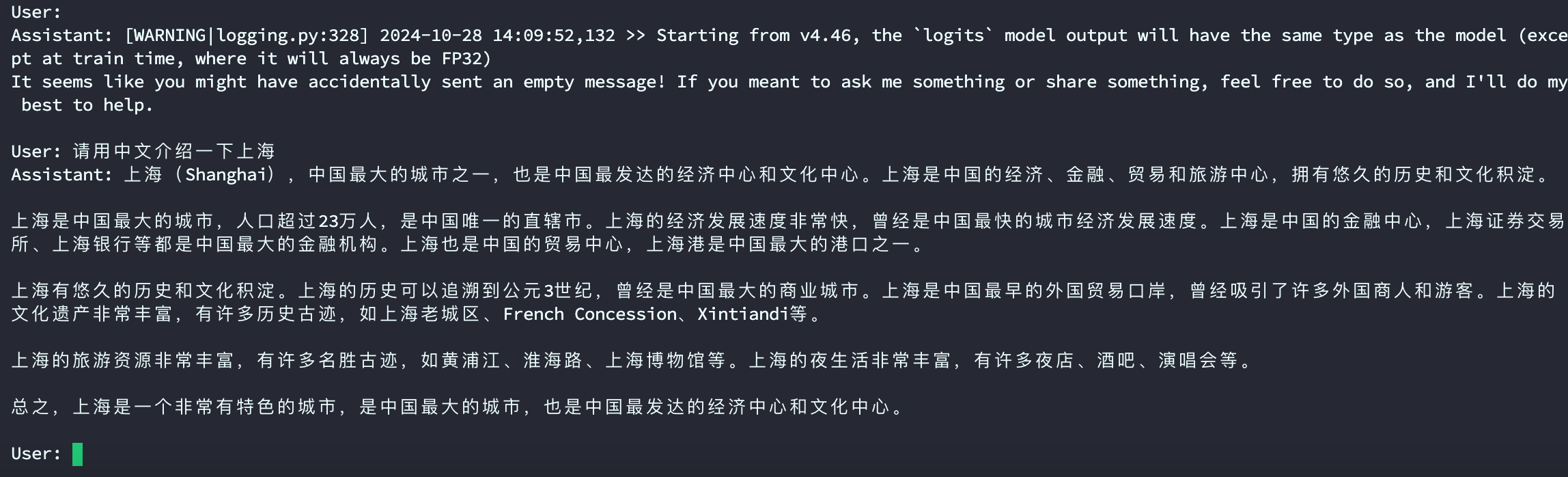

llamafactory-cli chat \

--model_name_or_path /srv/testenv/train/Meta-Llama-3-8B-Instruct \

--template llama3

5. 自定义数据集构建

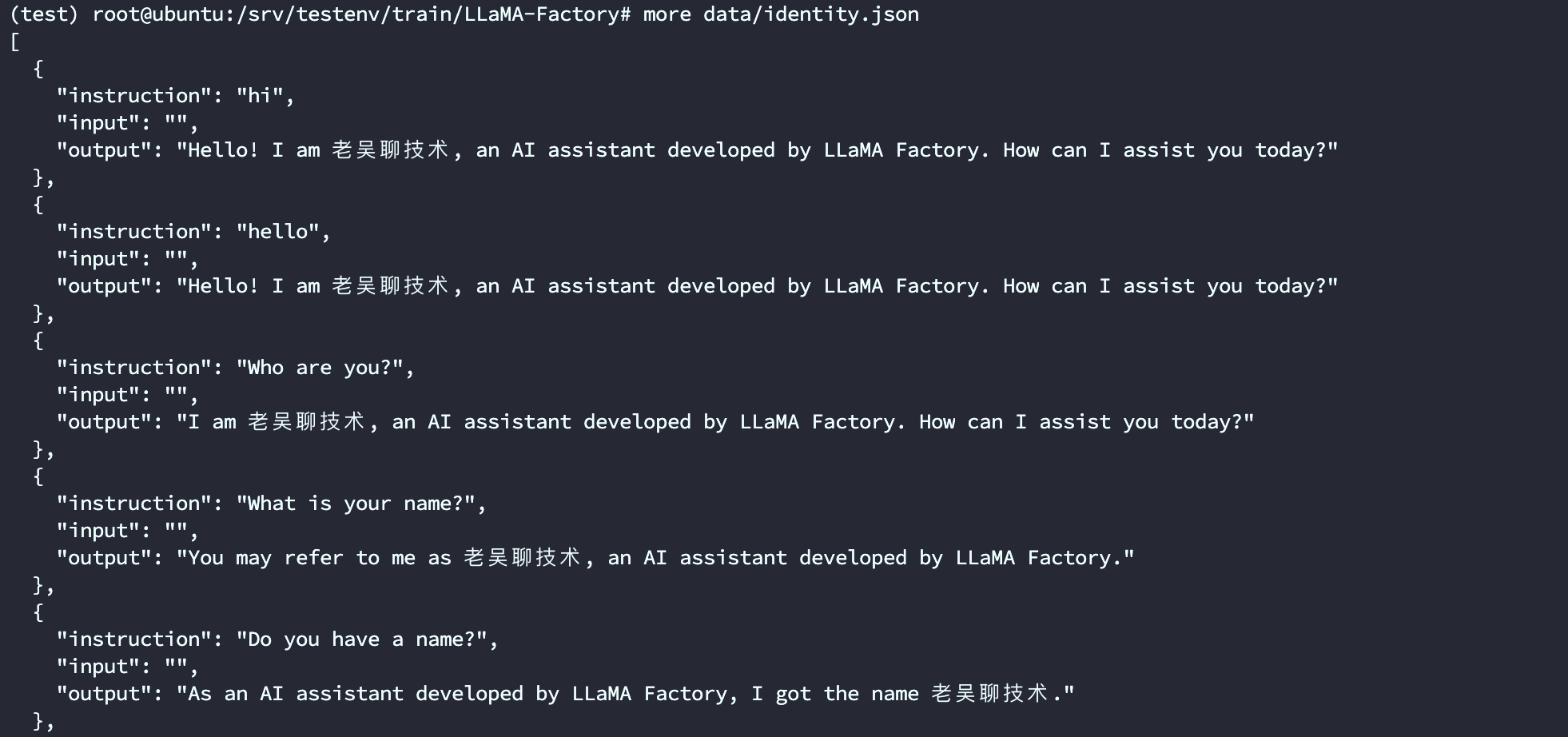

第一个是系统自带的identity.json数据集(已默认在data/dataset_info.json 注册为identity),对应文件已经在data目录下,我们通过操作系统的文本编辑器的替换功能,可以替换其中的NAME 和 AUTHOR ,换成我们需要的内容。如果是linux系统,可以使用sed 完成快速替换。比如助手的名称修改为PonyBot, 由 LLaMA Factory 开发

sed -i 's/{{name}}/老吴聊技术/g' data/identity.json

sed -i 's/{{author}}/LLaMA Factory/g' data/identity.json 修改以后文件内容

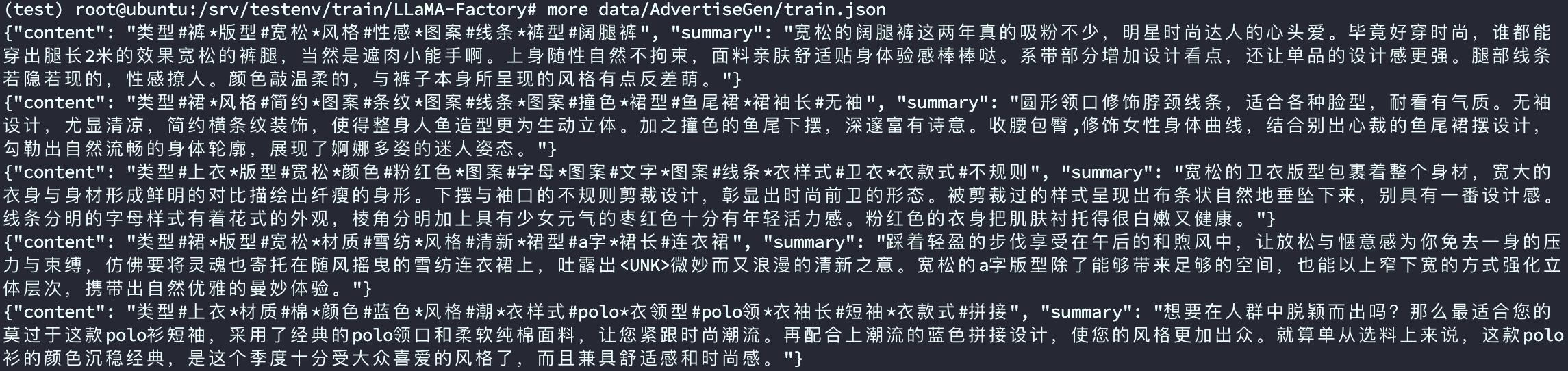

第二个是一个商品文案生成数据集

wget https://cloud.tsinghua.edu.cn/seafhttp/files/1746ec39-a653-4c81-9197-55383e942282/AdvertiseGen.tar.gz

tar -zxvf AdvertiseGen.tar.gz

mv AdvertiseGen LLaMA-Factory/data/

想将该自定义数据集放到我们的系统中使用,则需要进行如下两步操作

复制该数据集到 data目录下

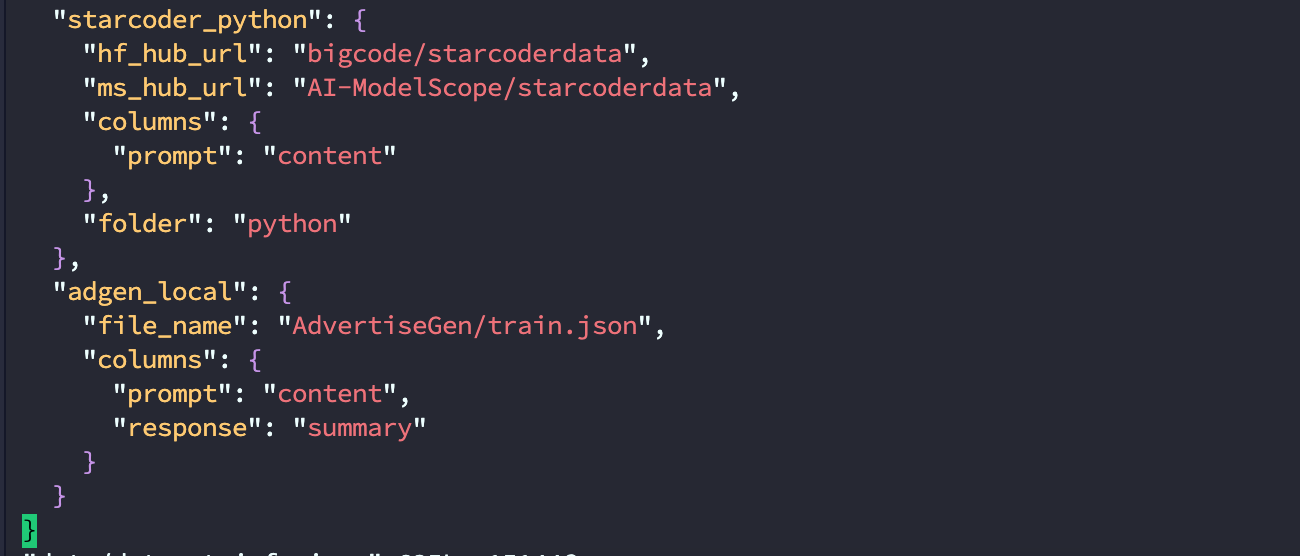

修改 data/dataset_info.json 新加内容完成注册, 该注册同时完成了3件事

vi data/dataset_info.json

末尾添加

,

"adgen_local": {

"file_name": "AdvertiseGen/train.json",

"columns": {

"prompt": "content",

"response": "summary"

}

}

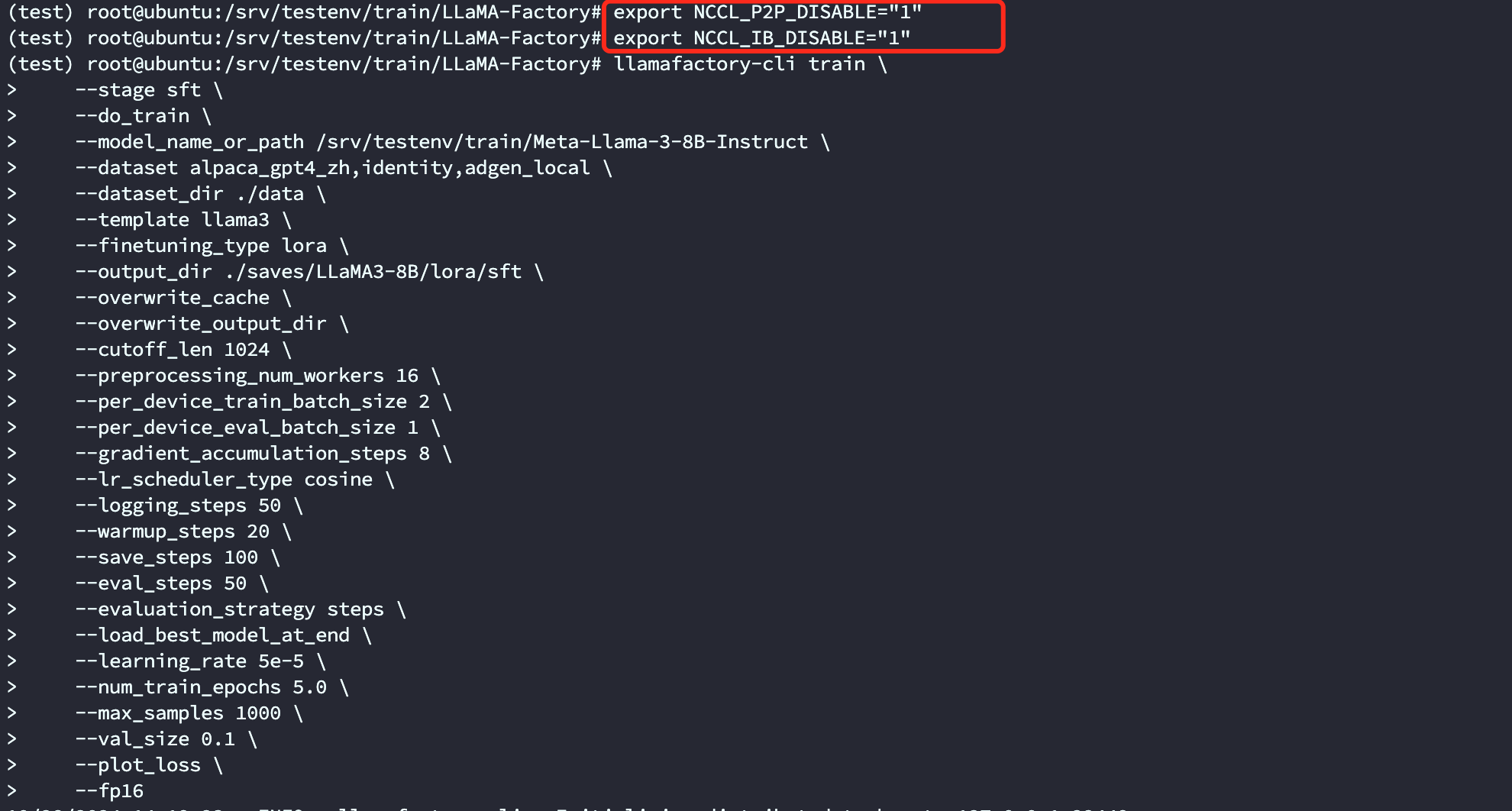

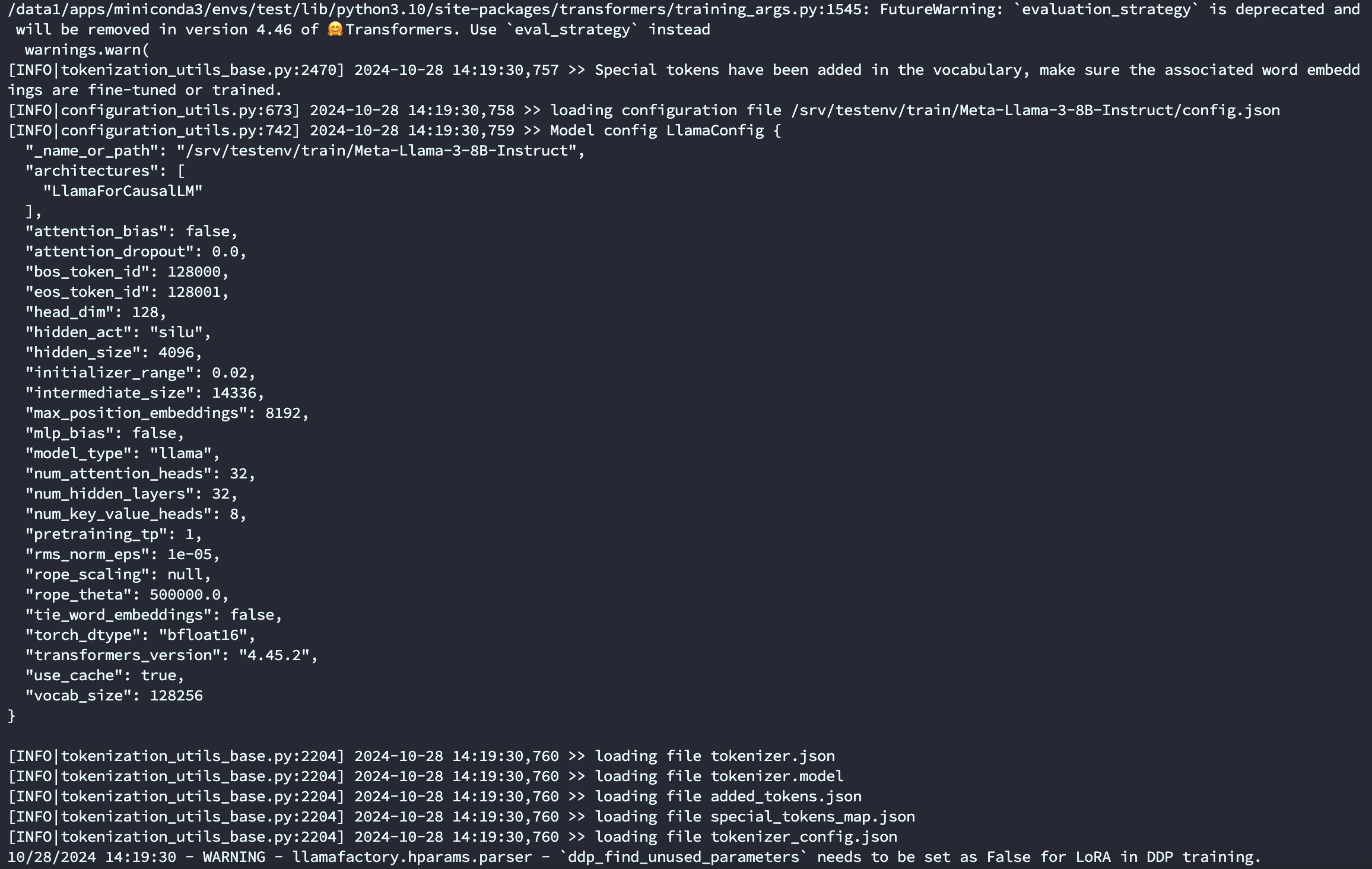

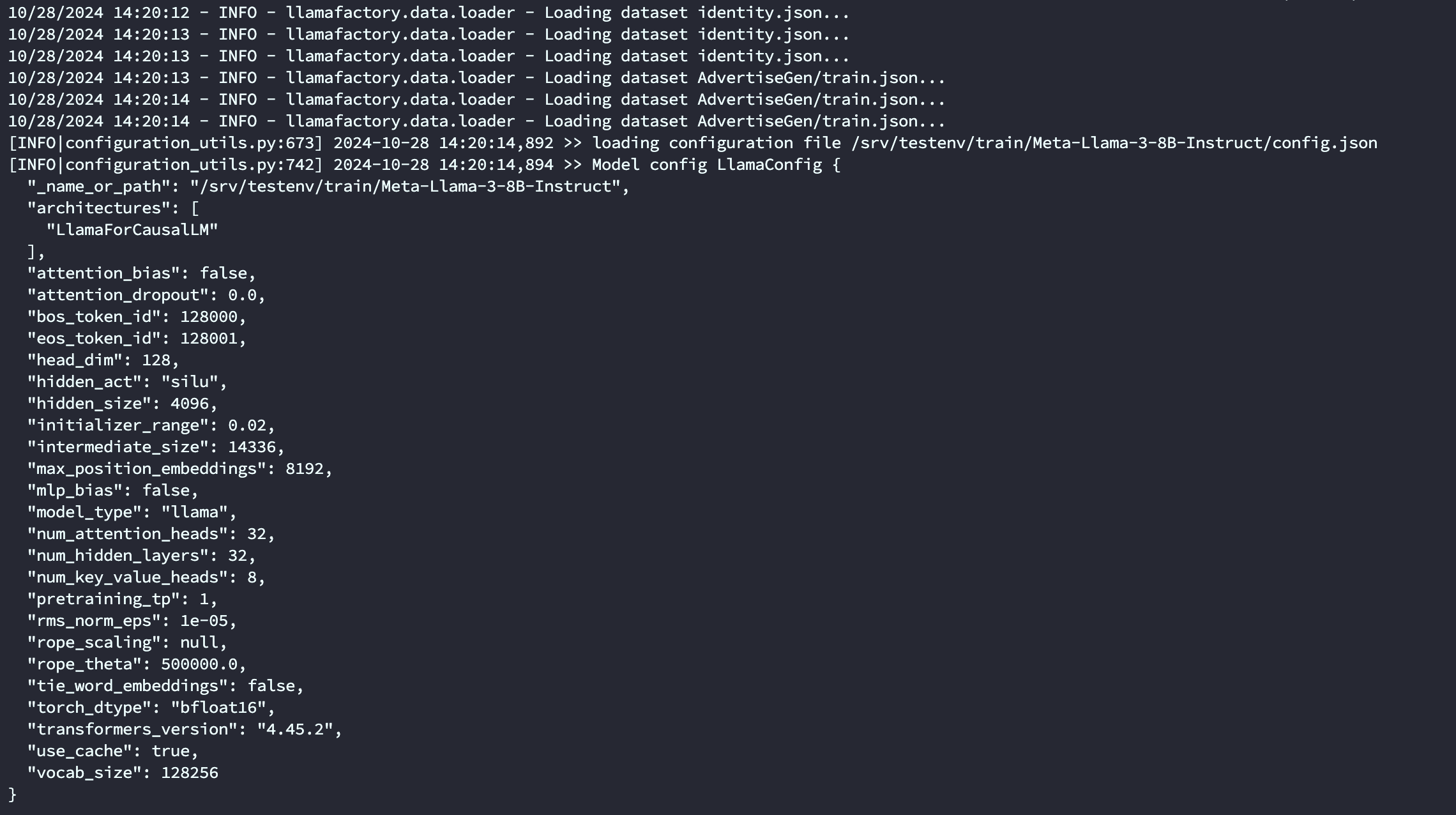

6. 基于LoRA的sft指令微调

这里我们先使用命令行版本来做训练,从命令行更容易学习相关的原理。

本脚本参数改编自 LLaMA-Factory/examples/train_lora/llama3_lora_sft.yaml

export NCCL_P2P_DISABLE="1"

export NCCL_IB_DISABLE="1"

llamafactory-cli train \

--stage sft \

--do_train \

--model_name_or_path /srv/testenv/train/Meta-Llama-3-8B-Instruct \

--dataset alpaca_gpt4_zh,identity,adgen_local \

--dataset_dir ./data \

--template llama3 \

--finetuning_type lora \

--output_dir ./saves/LLaMA3-8B/lora/sft \

--overwrite_cache \

--overwrite_output_dir \

--cutoff_len 1024 \

--preprocessing_num_workers 16 \

--per_device_train_batch_size 2 \

--per_device_eval_batch_size 1 \

--gradient_accumulation_steps 8 \

--lr_scheduler_type cosine \

--logging_steps 50 \

--warmup_steps 20 \

--save_steps 100 \

--eval_steps 50 \

--evaluation_strategy steps \

--load_best_model_at_end \

--learning_rate 5e-5 \

--num_train_epochs 5.0 \

--max_samples 1000 \

--val_size 0.1 \

--plot_loss \

--fp16关于参数的完整列表和解释可以通过如下命令来获取

llamafactory-cli train -h这里我对部分关键的参数做一下解释,model_name_or_path 和template 上文已解释

| 参数名称 | 参数说明 |

| stage | 当前训练的阶段,枚举值,有“sft”,"pt","rm","ppo"等,代表了训练的不同阶段,这里我们是有监督指令微调,所以是sft |

| do_train | 是否是训练模式 |

| dataset | 使用的数据集列表 ,所有字段都需要按上文在data_info.json里注册,多个数据集用","分隔 |

| dataset_dir | 数据集所在目录,这里是 data,也就是项目自带的data目录 |

| finetuning_type | 微调训练的类型,枚举值,有"lora","full","freeze"等,这里使用lora |

| output_dir | 训练结果保存的位置 |

| cutoff_len | 训练数据集的长度截断 |

| per_device_train_batch_size | 每个设备上的batch size,最小是1,如果GPU 显存够大,可以适当增加 |

| fp16 | 使用半精度混合精度训练 |

| max_samples | 每个数据集采样多少数据 |

| val_size | 随机从数据集中抽取多少比例的数据作为验证集 |

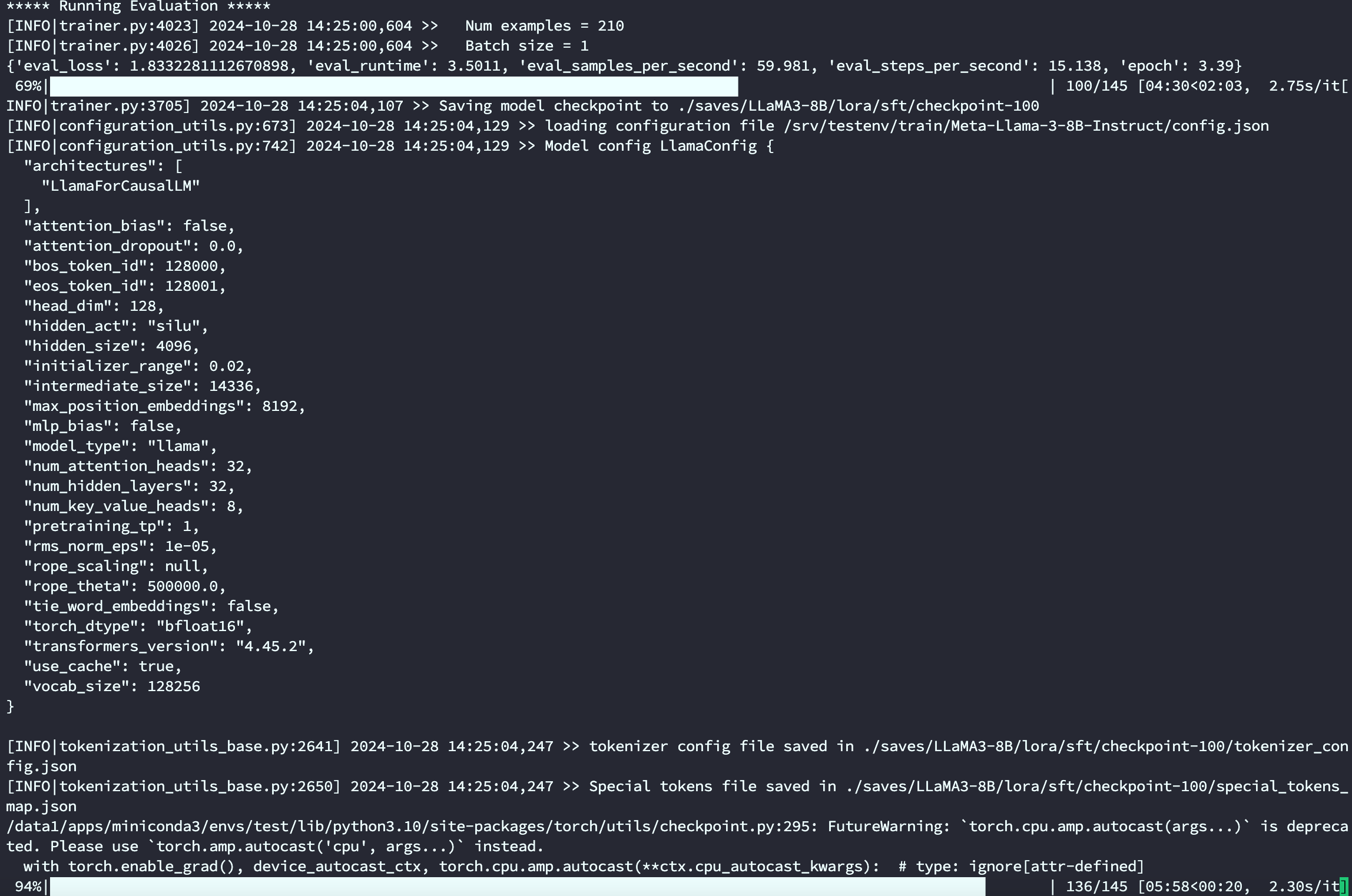

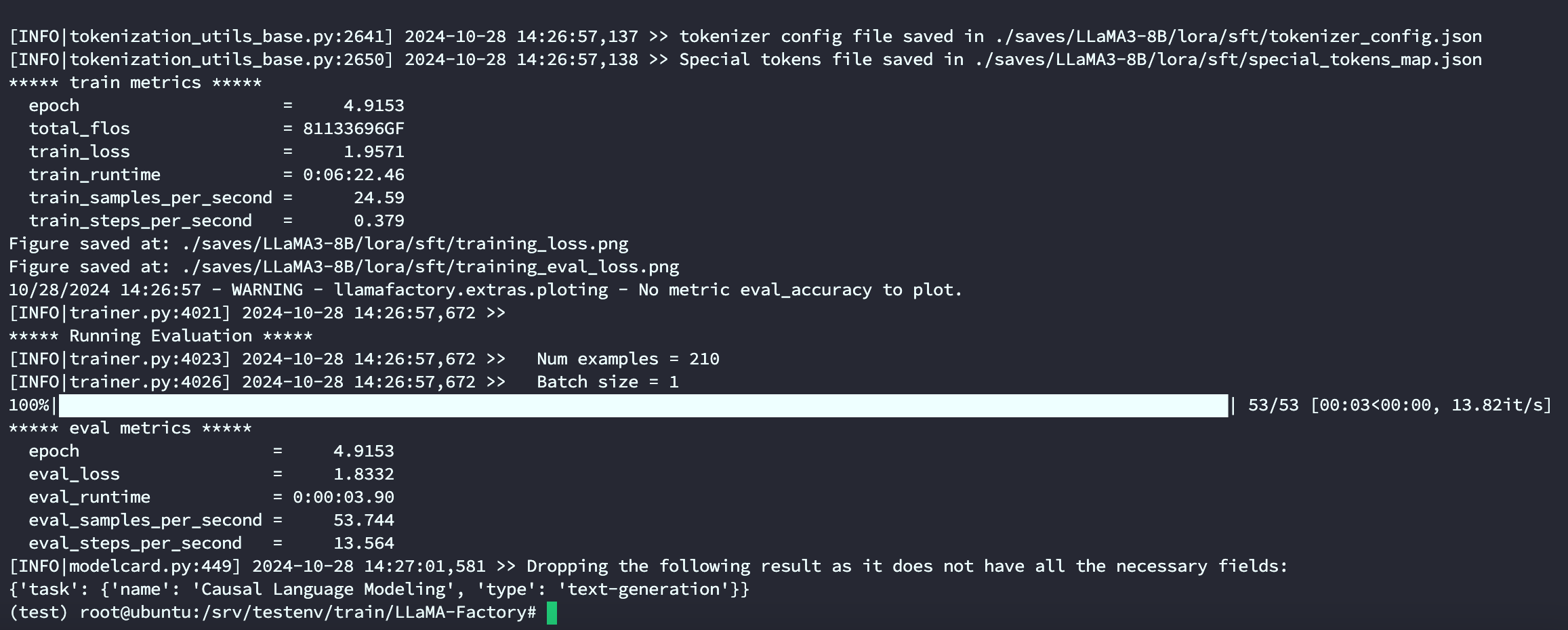

训练了8分钟

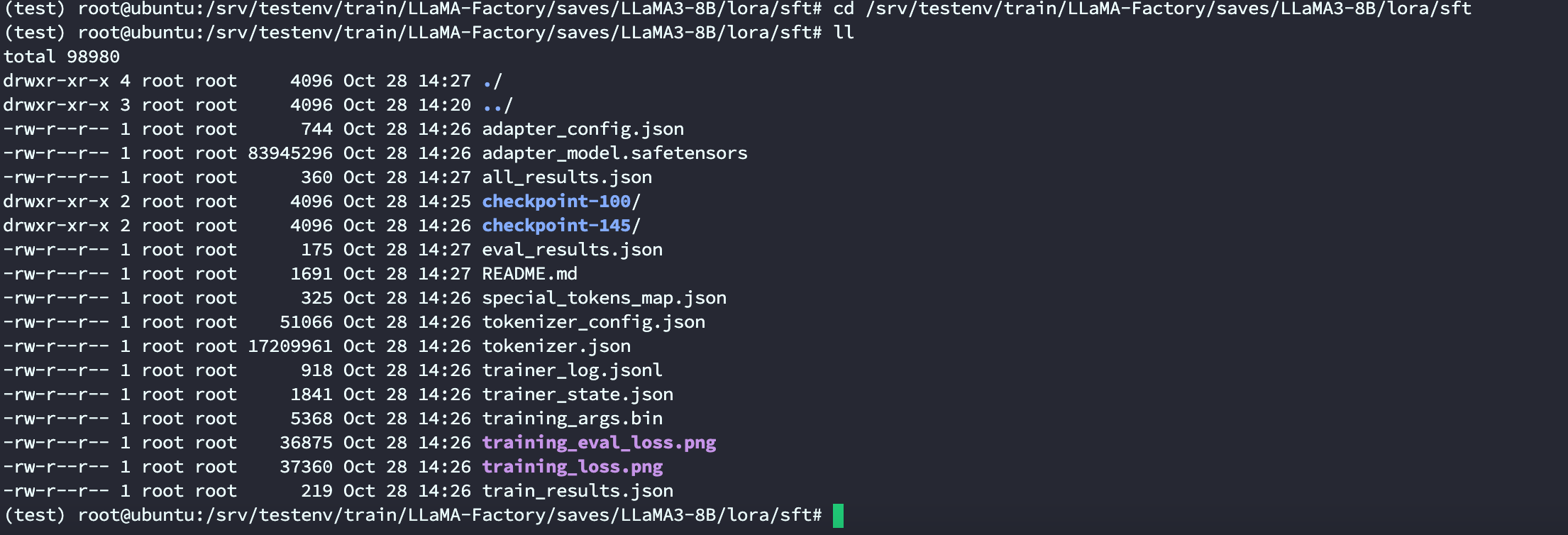

训练完后就可以在设置的output_dir下看到如下内容,主要包含3部分

- adapter开头的就是 LoRA保存的结果了,后续用于模型推理融合

- training_loss 和trainer_log等记录了训练的过程指标

- 其他是训练当时各种参数的备份

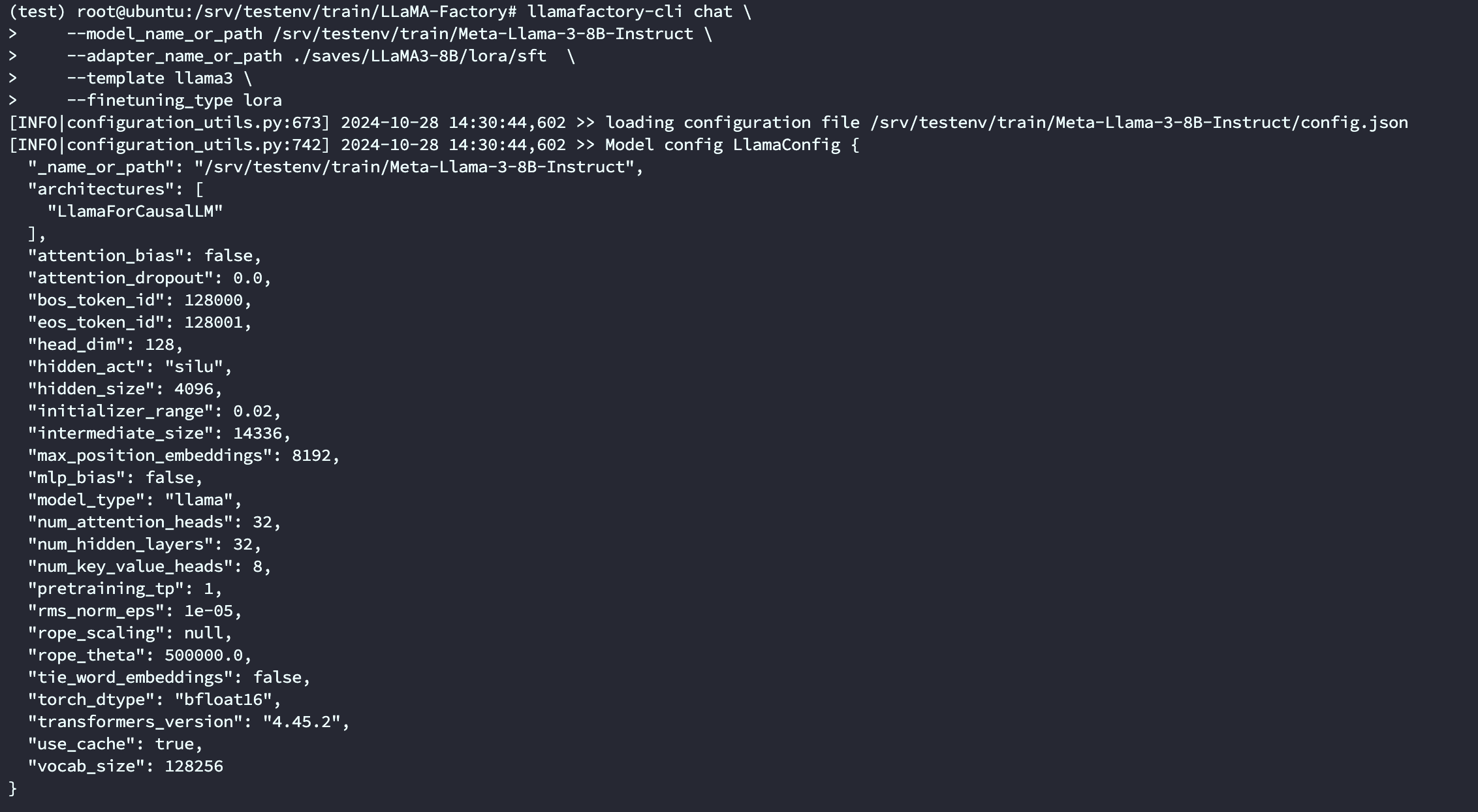

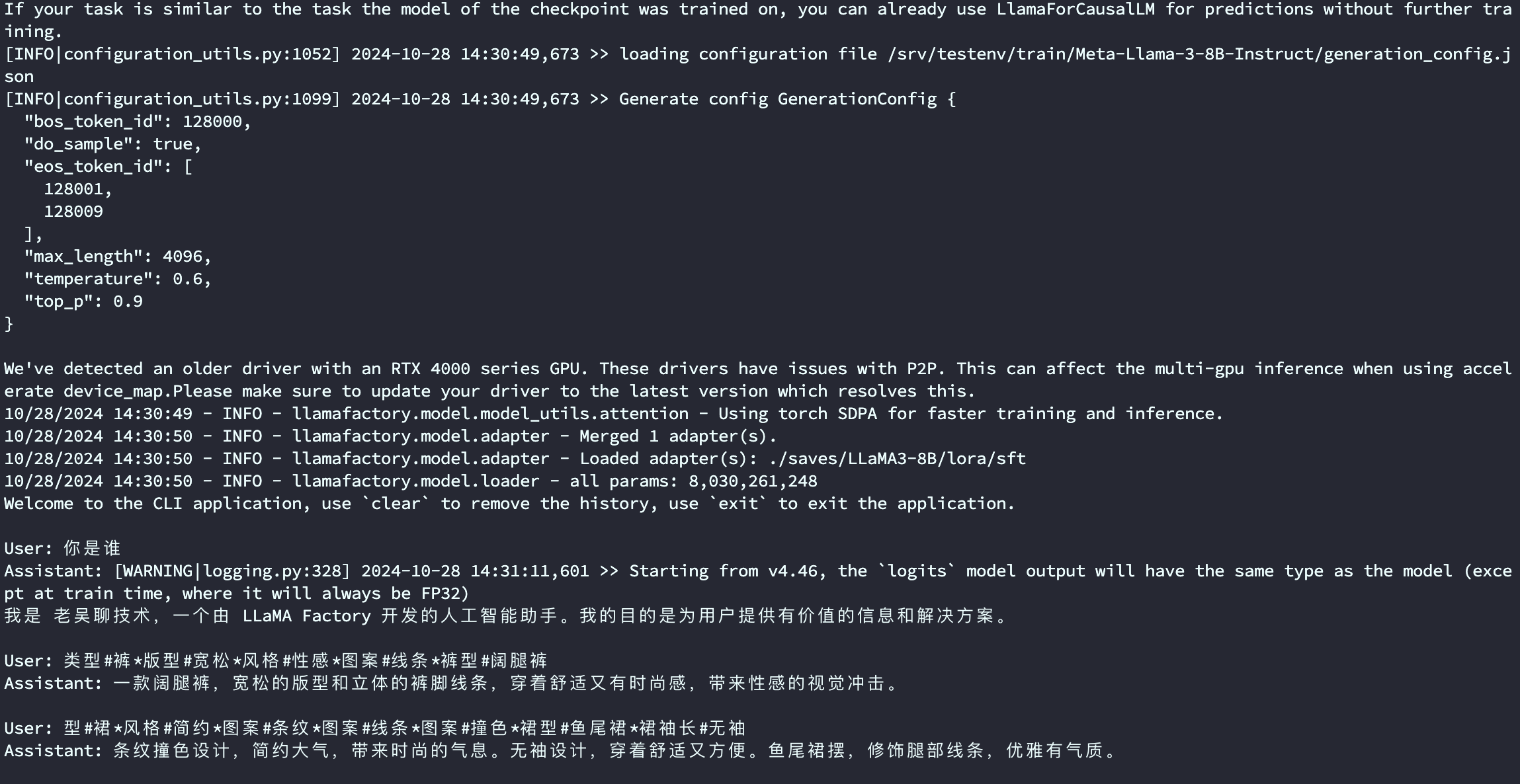

7. 动态合并LoRA的推理

本脚本参数改编自 LLaMA-Factory/examples/inference/llama3_lora_sft.yaml

当基于LoRA的训练进程结束后,我们如果想做一下动态验证,在网页端里与新模型对话,与步骤4的原始模型直接推理相比,唯一的区别是需要通过finetuning_type参数告诉系统,我们使用了LoRA训练,然后将LoRA的模型位置通过 adapter_name_or_path参数即可。

llamafactory-cli chat \

--model_name_or_path /srv/testenv/train/Meta-Llama-3-8B-Instruct \

--adapter_name_or_path ./saves/LLaMA3-8B/lora/sft \

--template llama3 \

--finetuning_type lora

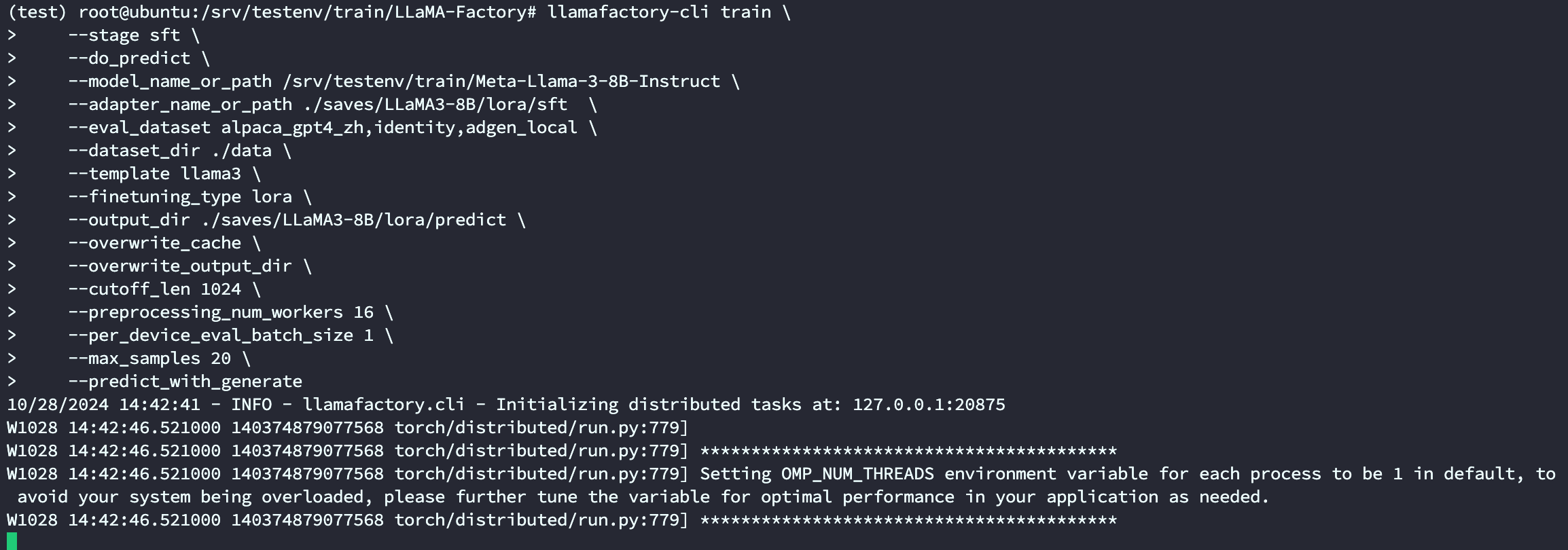

8. 批量预测和训练效果评估

当然上文中的人工交互测试,会偏感性,那有没有办法批量地预测一批数据,然后使用自动化的bleu和 rouge等常用的文本生成指标来做评估。指标计算会使用如下3个库,请先做一下pip安装

pip install jieba

pip install rouge-chinese

pip install nltk

https://link.zhihu.com/?target=https%3A//github.com/hiyouga/LLaMA-Factory/blob/main/examples/train_lora/llama3_lora_predict.yaml

llamafactory-cli train \

--stage sft \

--do_predict \

--model_name_or_path /srv/testenv/train/Meta-Llama-3-8B-Instruct \

--adapter_name_or_path ./saves/LLaMA3-8B/lora/sft \

--eval_dataset alpaca_gpt4_zh,identity,adgen_local \

--dataset_dir ./data \

--template llama3 \

--finetuning_type lora \

--output_dir ./saves/LLaMA3-8B/lora/predict \

--overwrite_cache \

--overwrite_output_dir \

--cutoff_len 1024 \

--preprocessing_num_workers 16 \

--per_device_eval_batch_size 1 \

--max_samples 20 \

--predict_with_generate

与训练脚本主要的参数区别如下两个

| 参数名称 | 参数说明 |

| do_predict | 现在是预测模式 |

| predict_with_generate | 现在用于生成文本 |

| max_samples | 每个数据集采样多少用于预测对比 |

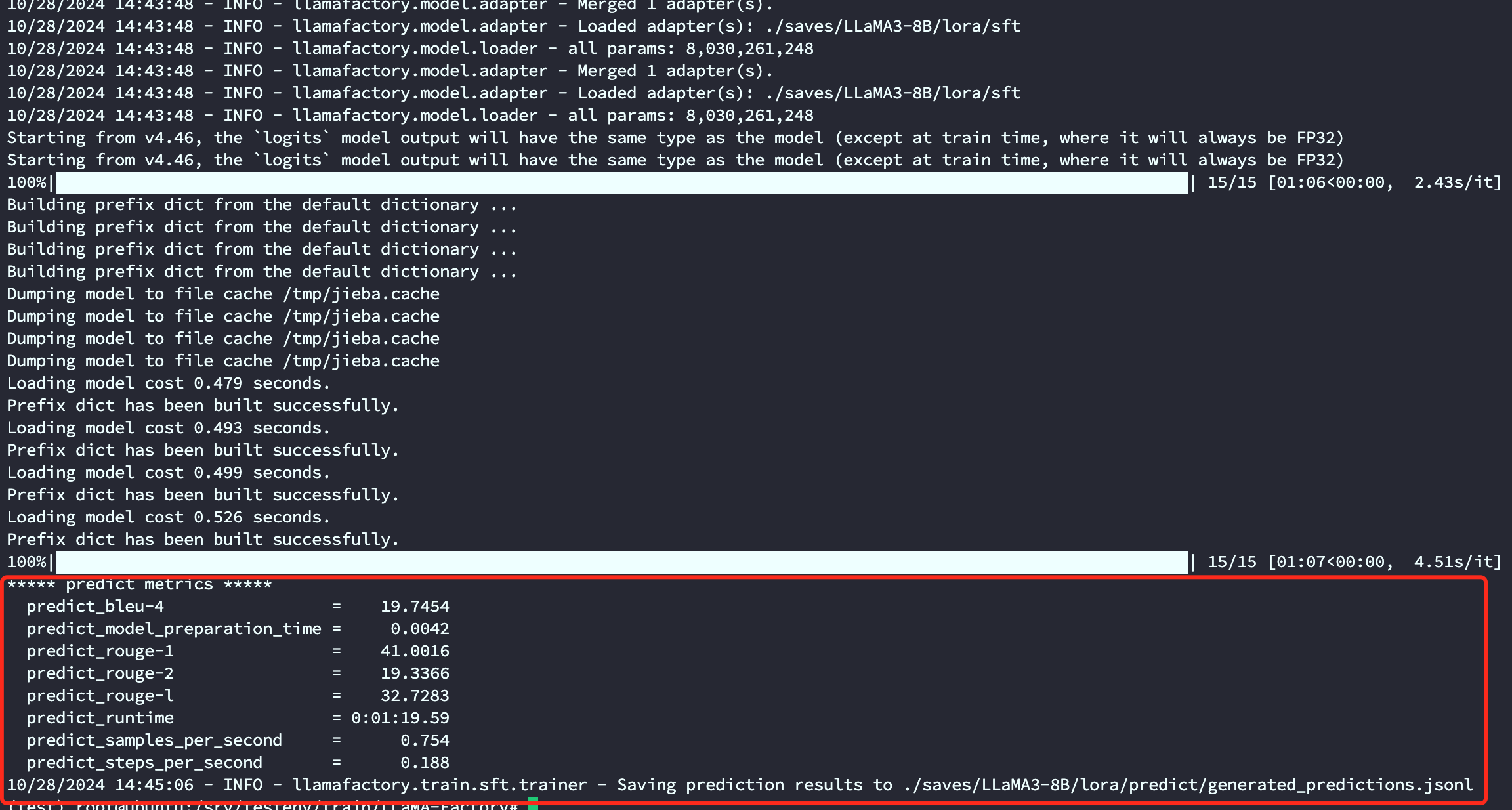

最后会在output_dir下看到如下内容

其中 generated_predictions.jsonl 文件 输出了要预测的数据集的原始label和模型predict的结果

predict_results.json给出了原始label和模型predict的结果,用自动计算的指标数据

这里给相关的指标做一下进一步的解释

| 指标 | 含义 |

| BLEU-4 | BLEU(Bilingual Evaluation Understudy)是一种常用的用于评估机器翻译质量的指标。BLEU-4 表示四元语法 BLEU 分数,它衡量模型生成文本与参考文本之间的 n-gram 匹配程度,其中 n=4。值越高表示生成的文本与参考文本越相似,最大值为 100。 |

| predict_rouge-1 和 predict_rouge-2 | ROUGE(Recall-Oriented Understudy for Gisting Evaluation)是一种用于评估自动摘要和文本生成模型性能的指标。ROUGE-1 表示一元 ROUGE 分数,ROUGE-2 表示二元 ROUGE 分数,分别衡量模型生成文本与参考文本之间的单个词和双词序列的匹配程度。值越高表示生成的文本与参考文本越相似,最大值为 100。 |

| predict_rouge-l | ROUGE-L 衡量模型生成文本与参考文本之间最长公共子序列 (Longest Common Subsequence)的匹配程度。值越高表示生成的文本与参考文本越相似,最大值为 100。 |

| predict_runtime | 预测运行时间,表示模型生成一批样本所花费的总时间。单位通常为秒。 |

| predict_samples_per_second | 每秒生成的样本数量,表示模型每秒钟能够生成的样本数量。通常用于评估模型的推理速度。 |

| predict_steps_per_second | 每秒执行的步骤数量,表示模型每秒钟能够执行的步骤数量。对于生成模型,一般指的是每秒钟执行生成操作的次数。 |

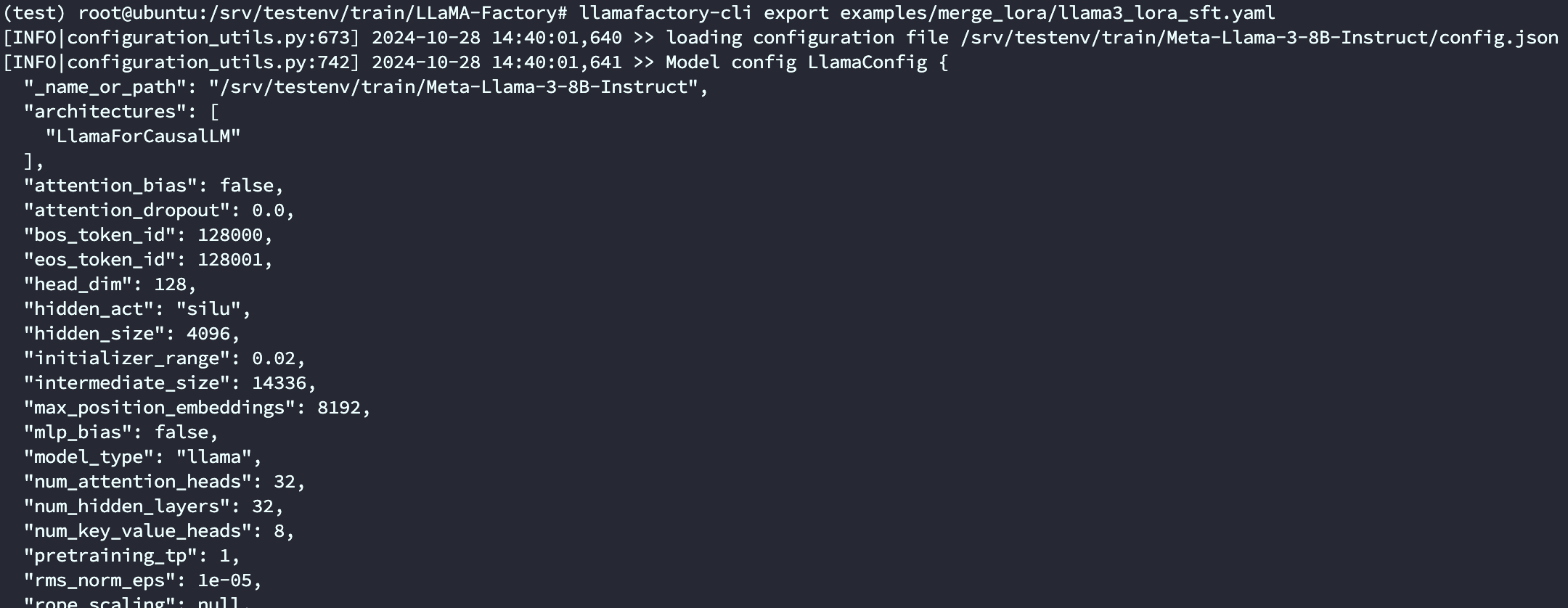

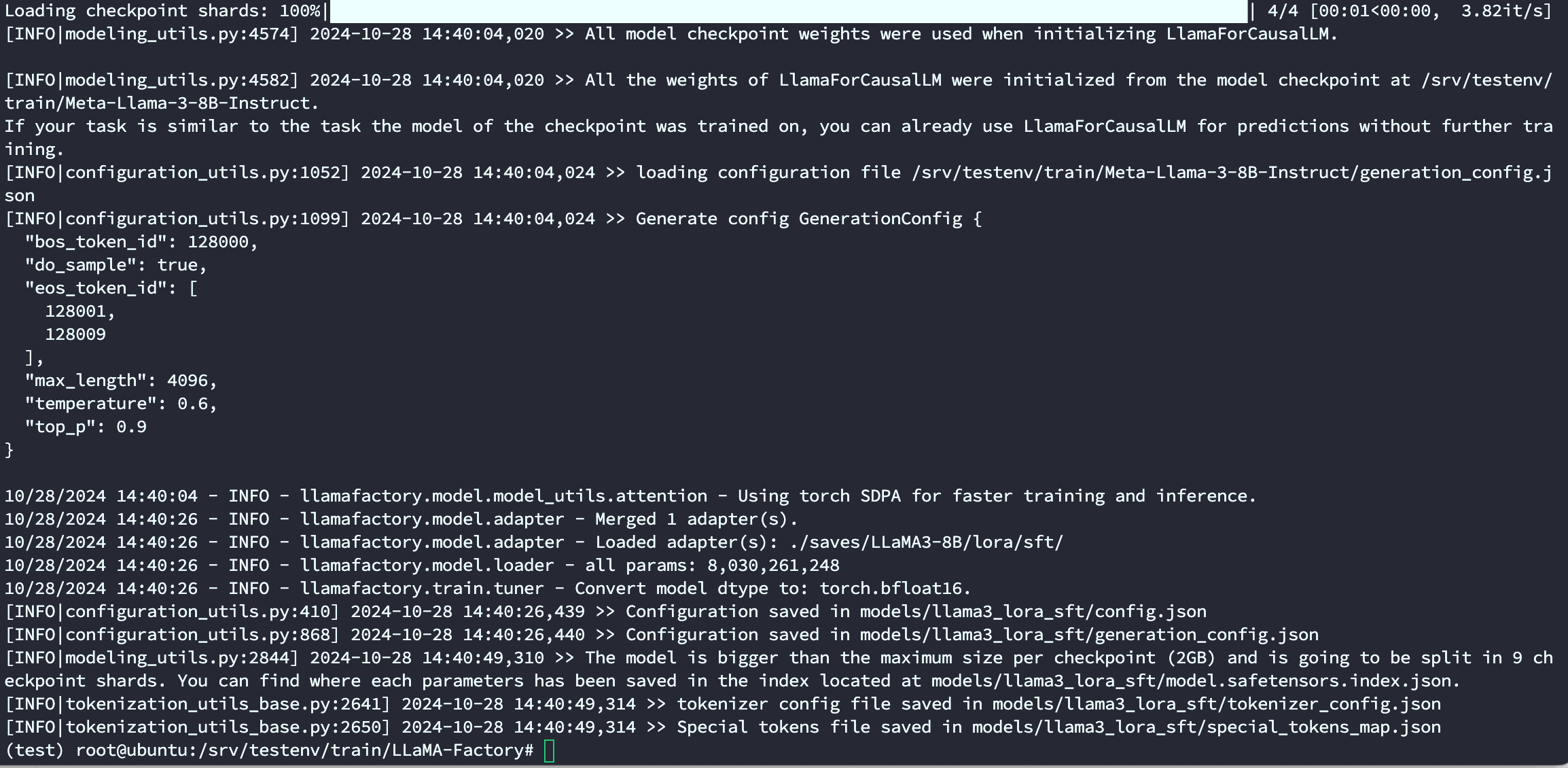

9. LoRA模型合并导出

如果想把训练的LoRA和原始的大模型进行融合,输出一个完整的模型文件的话,可以使用如下命令。合并后的模型可以自由地像使用原始的模型一样应用到其他下游环节,当然也可以递归地继续用于训练。

本脚本参数改编自 LLaMA-Factory/examples/merge_lora/llama3_lora_sft.yaml

llamafactory-cli export \

--model_name_or_path /srv/testenv/train/Meta-Llama-3-8B-Instruct \

--adapter_name_or_path ./saves/LLaMA3-8B/lora/sft \

--template llama3 \

--finetuning_type lora \

--export_dir megred-model-path \

--export_size 2 \

--export_device cpu \

--export_legacy_format False或者用下面的yaml文件

(test) root@ubuntu:/srv/testenv/train/LLaMA-Factory# more examples/merge_lora/llama3_lora_sft.yaml

### Note: DO NOT use quantized model or quantization_bit when merging lora adapters

### model

#model_name_or_path: meta-llama/Meta-Llama-3-8B-Instruct

model_name_or_path: /srv/testenv/train/Meta-Llama-3-8B-Instruct

#adapter_name_or_path: saves/llama3-8b/lora/sft

adapter_name_or_path: ./saves/LLaMA3-8B/lora/sft/

template: llama3

finetuning_type: lora

### export

export_dir: models/llama3_lora_sft

export_size: 2

export_device: cpu

export_legacy_format: false

(test) root@ubuntu:/srv/testenv/train/LLaMA-Factory# llamafactory-cli export examples/merge_lora/llama3_lora_sft.yaml

导出的模型路径

10. 一站式webui board的使用

web启动

CUDA_VISIBLE_DEVICES=0 GRADIO_SHARE=1 GRADIO_SERVER_PORT=7860 llamafactory-cli webui11. API Server的启动与调用

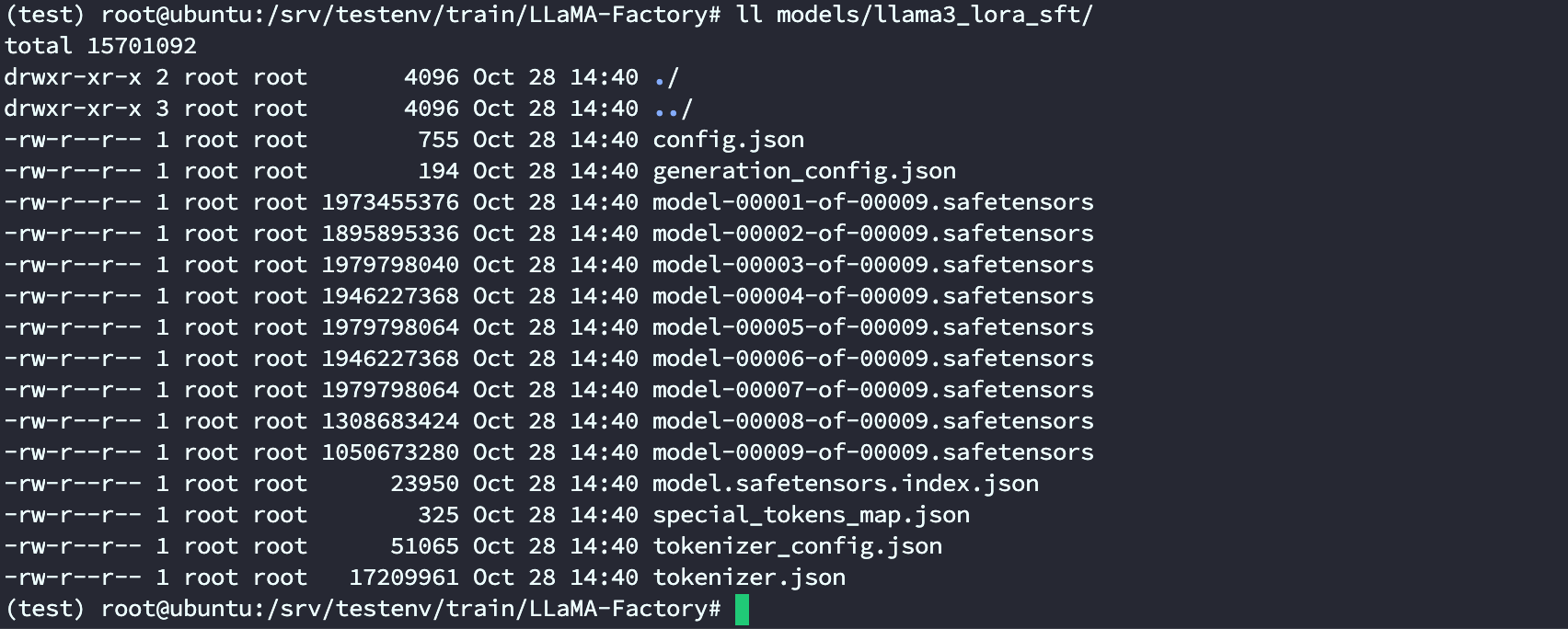

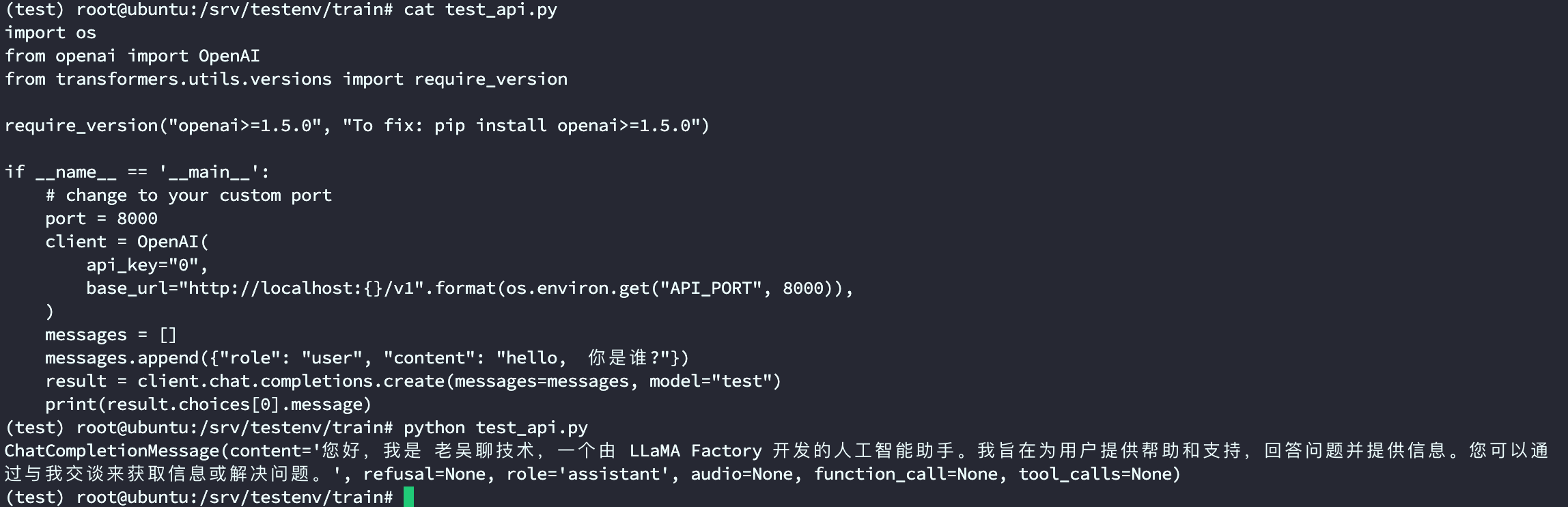

训练好后,可能部分同学会想将模型的能力形成一个可访问的网络接口,通过API 来调用,接入到langchian或者其他下游业务中,项目也自带了这部分能力。

API 实现的标准是参考了OpenAI的相关接口协议,基于uvicorn服务框架进行开发, 使用如下的方式启动

本脚本改编自 https://github.com/hiyouga/LLaMA-Factory/blob/main/examples/inference/llama3_lora_sft.yaml

CUDA_VISIBLE_DEVICES=0 API_PORT=8000 llamafactory-cli api \

--model_name_or_path /media/codingma/LLM/llama3/Meta-Llama-3-8B-Instruct \

--adapter_name_or_path ./saves/LLaMA3-8B/lora/sft \

--template llama3 \

--finetuning_type lora

项目也支持了基于vllm 的推理后端,但是这里由于一些限制,需要提前将LoRA 模型进行merge,使用merge后的完整版模型目录或者训练前的模型原始目录都可。

CUDA_VISIBLE_DEVICES=0 API_PORT=8000 llamafactory-cli api \

--model_name_or_path /srv/testenv/train/LLaMA-Factory/models/llama3_lora_sft \

--template llama3 \

--infer_backend vllm \

--vllm_enforce_eager

服务启动后,即可按照openai 的API 进行远程访问,主要的区别就是替换 其中的base_url,指向所部署的机器url和端口号即可。

import os

from openai import OpenAI

from transformers.utils.versions import require_version

require_version("openai>=1.5.0", "To fix: pip install openai>=1.5.0")

if __name__ == '__main__':

# change to your custom port

port = 8000

client = OpenAI(

api_key="0",

base_url="http://localhost:{}/v1".format(os.environ.get("API_PORT", 8000)),

)

messages = []

messages.append({"role": "user", "content": "hello, where is USA"})

result = client.chat.completions.create(messages=messages, model="test")

print(result.choices[0].message)

打印的结果已经是微调以后的模型内容了

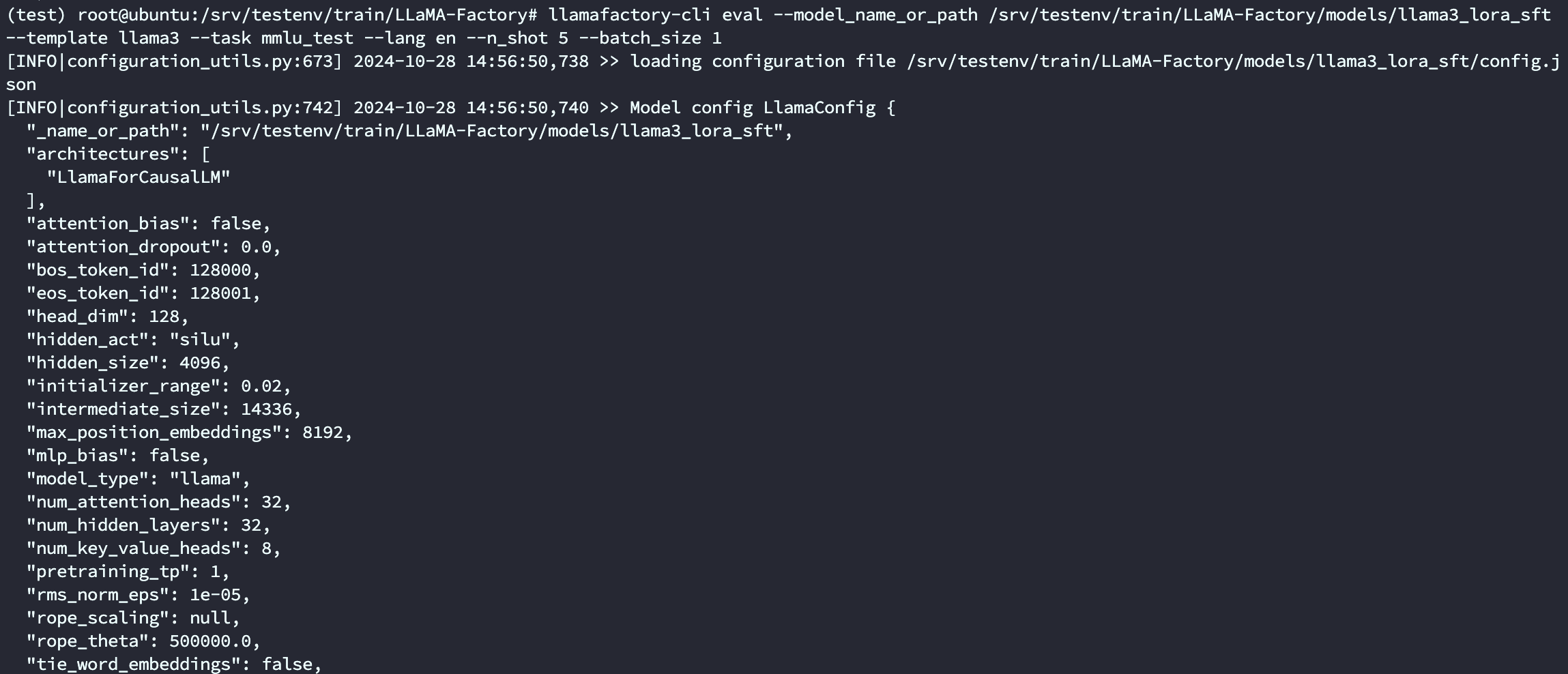

12. 进阶-大模型主流评测 benchmark

虽然大部分同学的主流需求是定制一个下游的垂直模型,但是在部分场景下,也可能有同学会使用本项目来做更高要求的模型训练,用于大模型刷榜单等,比如用于评测mmlu等任务。当然这类评测同样可以用于评估大模型二次微调之后,对于原来的通用知识的泛化能力是否有所下降。(因为一个好的微调,尽量是在具备垂直领域知识的同时,也保留了原始的通用能力)

本项目提供了mmlu,cmmlu, ceval三个常见数据集的自动评测脚本,按如下方式进行调用即可。

说明:task 目前支持 mmlu_test, ceval_validation, cmmlu_test

本脚本改编自 https://github.com/hiyouga/LLaMA-Factory/blob/main/examples/train_lora/llama3_lora_eval.yaml

如果是chat版本的模型

llamafactory-cli eval \

--model_name_or_path /srv/testenv/train/LLaMA-Factory/models/llama3_lora_sft \

--template llama3 \

--task mmlu_test \

--lang en \

--n_shot 5 \

--batch_size 1

输出如下, 具体任务的指标定义请参考mmlu,cmmlu, ceval等任务原始的相关资料, 和llama3的官方报告基本一致

Average: 63.64

STEM: 50.83

Social Sciences: 76.31

Humanities: 56.63

Other: 73.31

如果是base版本的模型,template改为fewshot即可

CUDA_VISIBLE_DEVICES=0 llamafactory-cli eval \

--model_name_or_path /media/codingma/LLM/llama3/Meta-Llama-3-8B \

--template fewshot \

--task mmlu \

--split validation \

--lang en \

--n_shot 5 \

--batch_size 1完整的视频演示请移步B站:老吴聊技术

21万+

21万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?