声明:对于作者的原创代码,禁止转售倒卖,违者必究!

前言

很久没改进过优化算法了,后台也经常收到小伙伴的疑问,为什么最近都没有改进算法了呢?

其实想要改进算法,使改进的算法比原始算法效果好并不难。难的是改进的策略不可以太牵强,不可以偏离原始算法本意!最重要的是不可以增加算法复杂度!

有些人改的算法,修改之后不仅算法运行时间大幅增加,而且修改的策略完全脱离原始算法本意。

比如:改进一个灰狼算法,你加个莱维飞行,你加个布谷鸟搜索策略,怎么,灰狼也会像布谷鸟一样去飞行去搜索吗?它能有这样的生活习性吗?

还有反向学习也是一个常见的万金油策略,但是此策略严重增加了算法复杂度,增加了适应度的计算次数,添加此策略也发不了太好的期刊。

改一个优秀的算法不是分分钟就能改出来的,你得分析算法本意,你得想办法改进它原本的公式(但不可改变原本意思),而且不可增加算法复杂度,这样改出来的算法才称得上是一个好算法。

正文

本期改进一个2024年发布于计算机一区期刊的徒步优化算法。目前该算法在谷歌学术统计的被引次数为129。

本期改进的徒步优化算法,核心策略就是:将算法原本只由领导者带队的思想进行改进,融入了团队之间的协作策略(细化精英领导者)。另外还添加了两种策略(不采用混沌映射、反向学习等初级策略)

算法的改进完全考虑到了徒步优化算法本身的含义,以及原始算法中原理公式的欠缺问题(这在代码的改进原理文件中都有详细说明)

算法的改进不增加任何适应度计算次数(也就是不增加算法复杂度)。

结果展示

本期代码测试在CEC2017和CEC2022函数集测试,很多高水平期刊论文常用该测试集!这两种测试集的难度也是CEC函数中公认最高的。

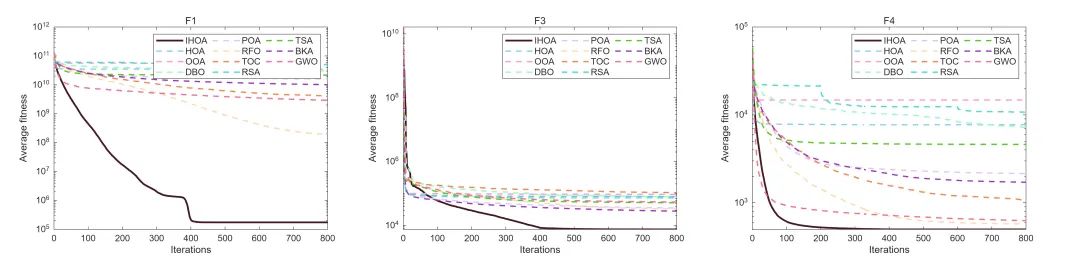

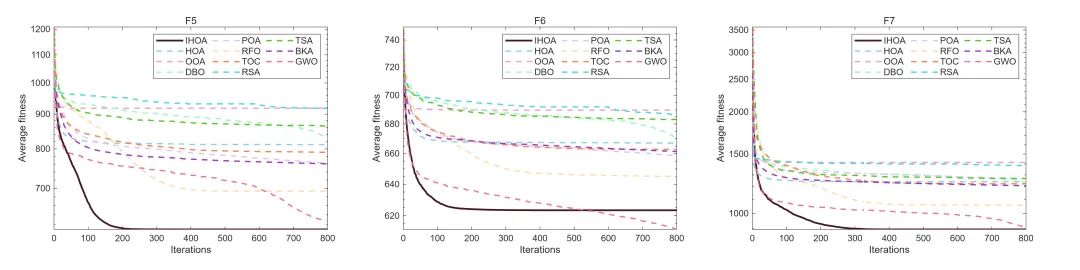

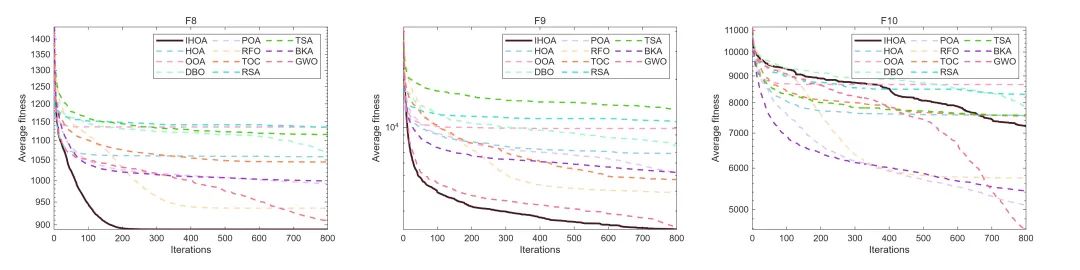

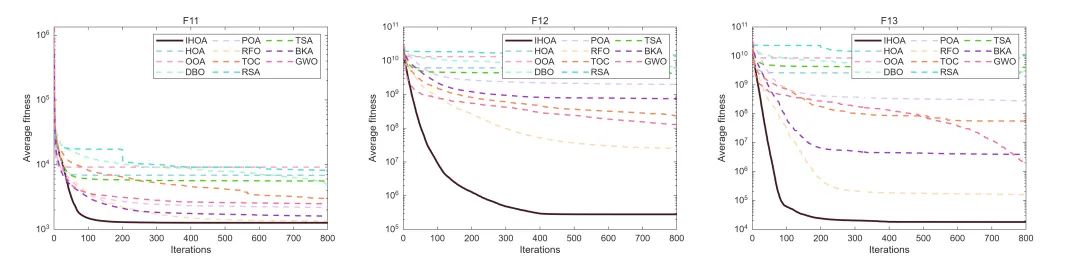

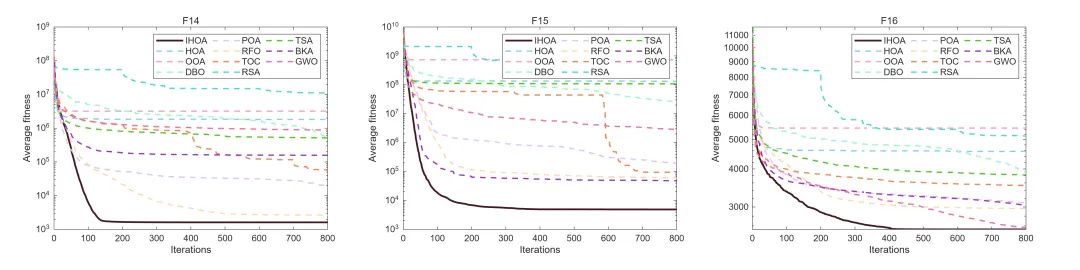

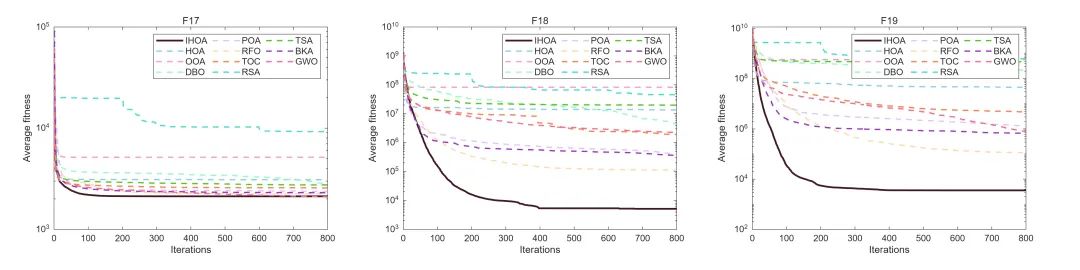

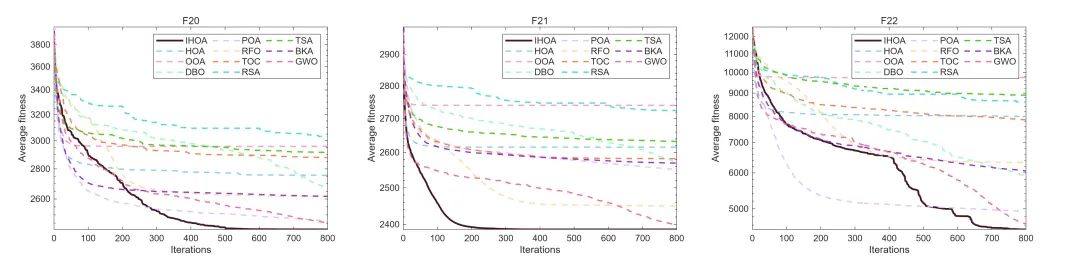

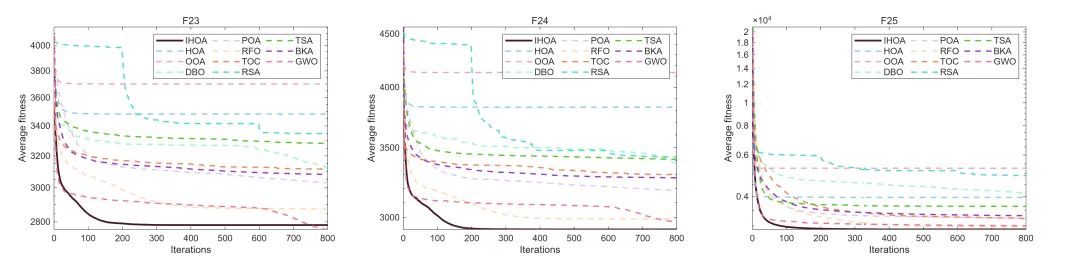

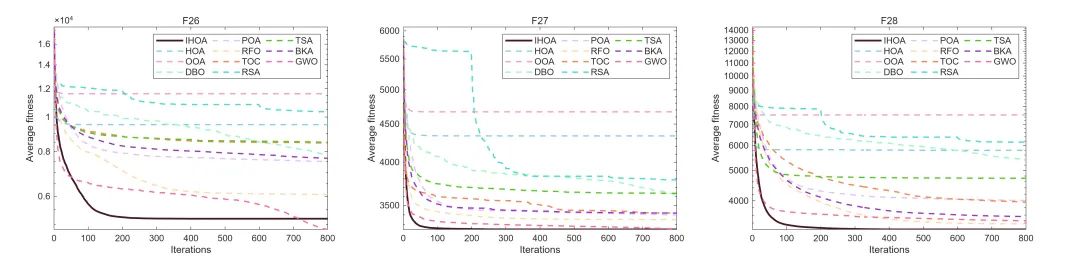

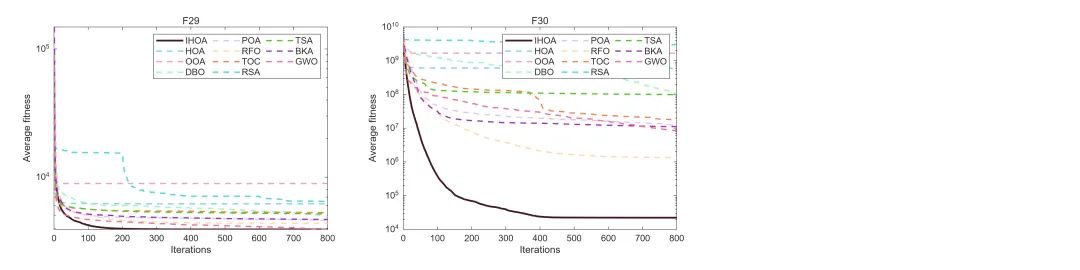

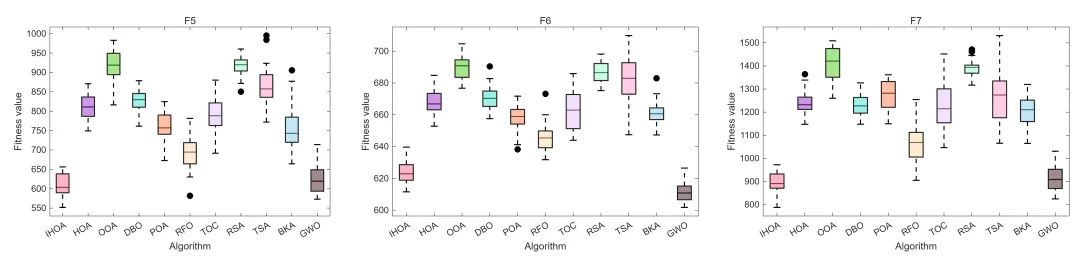

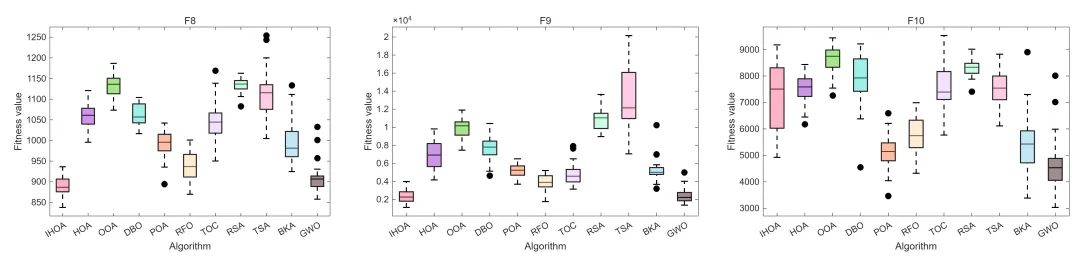

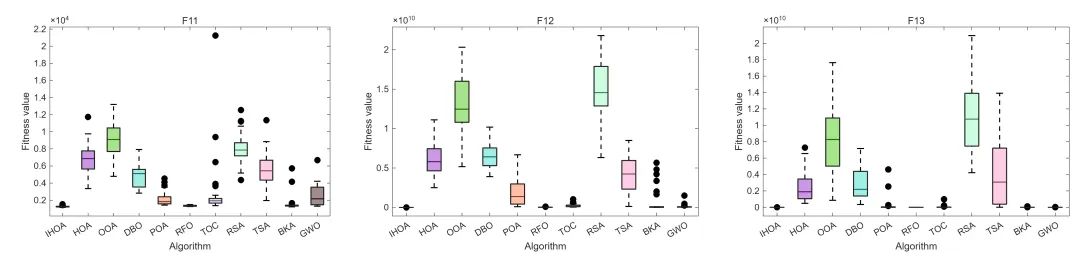

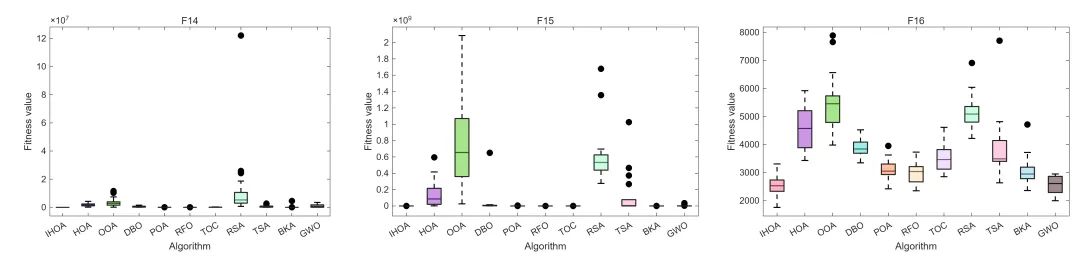

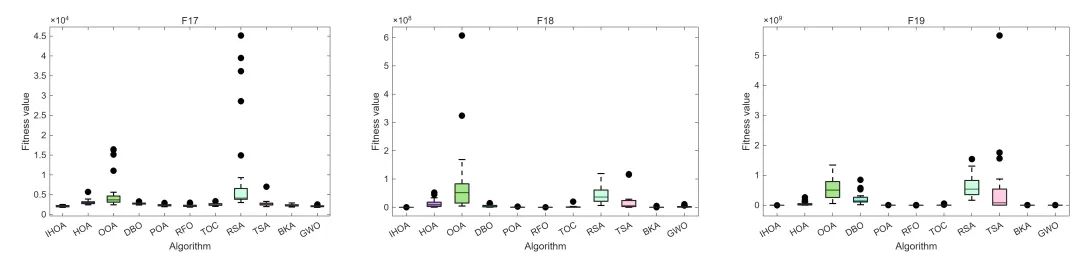

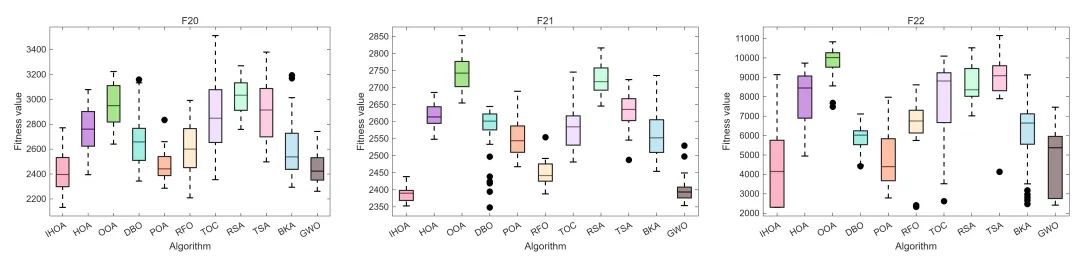

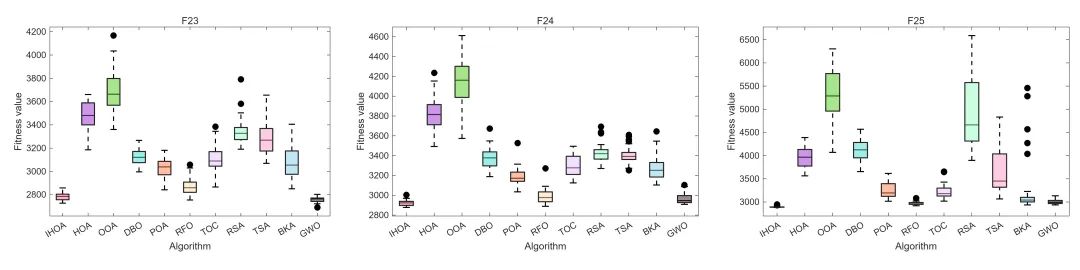

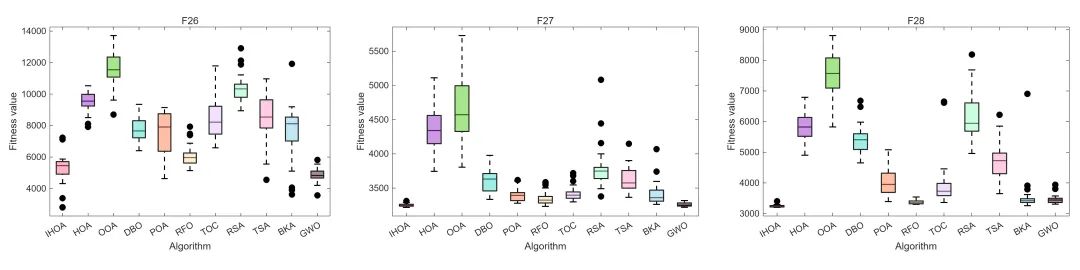

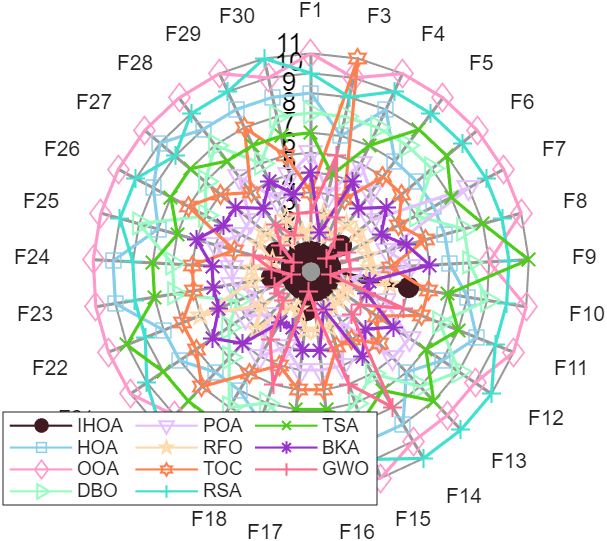

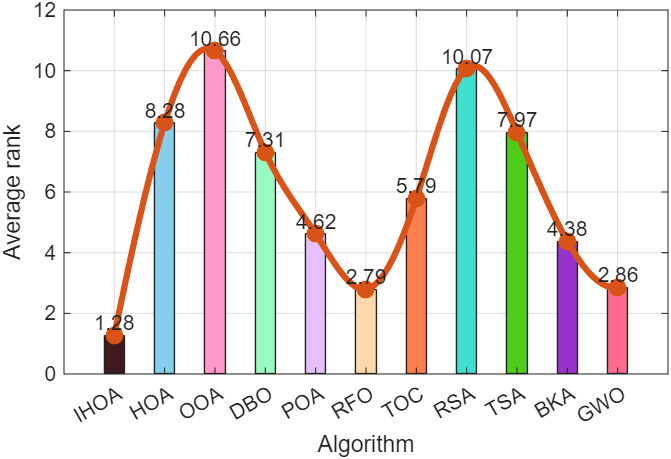

参与对比的算法有:改进的徒步优化算法与原始徒步优化算法(HOA),鱼鹰算法(OOA)、鹈鹕算法(POA)、蜣螂算法(DBO),吕佩尔狐优化(RFO)、龙卷风算法(TOC)、爬行搜索算法(RSA)、囊状虫群(TSA)、黑翅鸳算法(BKA)、灰狼算法(GWO)。

这些算法有最新的,也有比较经典的,都是表现很不错的算法。和这些算法相比较还是比较有说服力的!

在CEC2017、CEC2022函数集上,每种算法跑30次,统计最优值、标准差、 平均值、中值、最差值和平均运行时间。(为什么跑30次?因为优化算法每次运行都会有偶然性,跑30次的结果取平均值,可以凸显改进算法的优势!)

这里不放单次训练图了,直接上平均收敛曲线图(平均收敛曲线图的子图个数也可以随意更改)

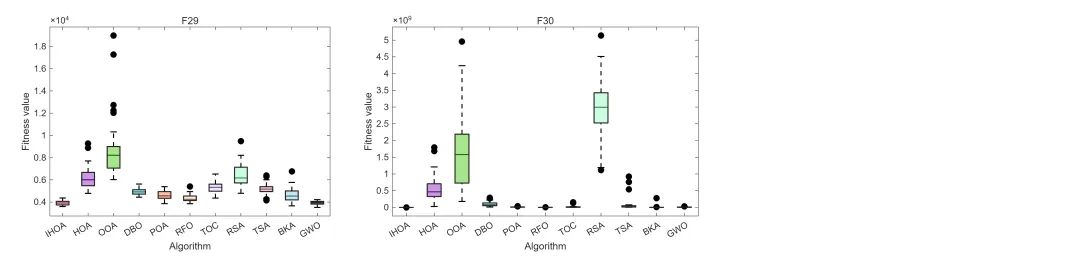

箱线图(箱线图的子图个数也可以随意更改)

雷达图:

以及平均排序图:

CEC2022函数集的结果就不再一一展示了。效果也是非常棒的!

改进徒步算法的原理也在word文件中写的非常清楚,基本上你可以一字不改直接放到你的论文中了。

所有公式都用mathtype敲好了。

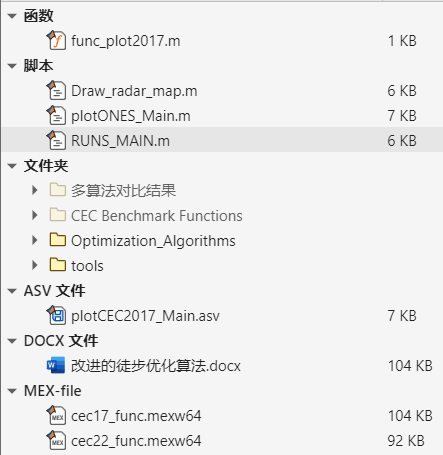

代码目录

代码目录如下:

以上图片,统计结果表格等都是一键运行!

代码获取

复制链接跳转:https://mbd.pub/o/bread/YZWVm5tyaA==

或者点击下方阅读原文跳转链接。

获取更多代码:

或者复制链接跳转:https://docs.qq.com/sheet/DU3NjYkF5TWdFUnpu

1200

1200

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?