提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

前言

参考一个大佬的代码,知乎链接:https://zhuanlan.zhihu.com/p/102453331

GitHub代码链接:https://github.com/enazoe/yolo-tensorrt

一、配置tensorRT

参考之前的博客文章或者网上其他教程。

二、使用vs2019 cuda10.2编译tensorrt代码

1.首先把代码和模型文件下载备用

2.配置sln/props里的配置文件

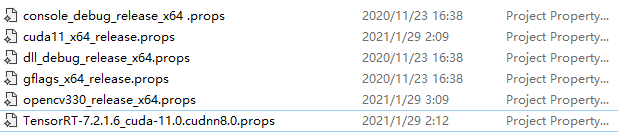

把里面cuda opencv tensorrt这三个包的路径修改为自己的路径

3.配置sln/dll_detector里的dll_detector.vcxproj配置文件

<Import Project="$(VCTargetsPath)\BuildCustomizations\CUDA 10.2.props" />

因为原始是11.0我使用的是10.2所以要修改像上面那样(有两个地方)

如果报错没有props文件:如

该博客介绍了如何在Visual Studio 2019环境下,配合CUDA 10.2编译TensorRT代码,实现Yolo-v5的int8、fp16和batch inference功能。作者强调了CUDA和TensorRT版本匹配的重要性,并分享了遇到的问题及解决办法,包括修改配置文件、处理编译错误等。

该博客介绍了如何在Visual Studio 2019环境下,配合CUDA 10.2编译TensorRT代码,实现Yolo-v5的int8、fp16和batch inference功能。作者强调了CUDA和TensorRT版本匹配的重要性,并分享了遇到的问题及解决办法,包括修改配置文件、处理编译错误等。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

812

812