目录

2、tSNE(t-distributed stochastic neighbor embedding)

线性降维

1、PCA主成分分析

- •主成分分析降低数据维数而不丢失太多信息。

- •用于机器学习、信号处理和图像压缩(以及其他)。

- PCA追求的是在降维之后能够最大化保持数据的内在信息,并通过衡量在投影方向上的数据方差的大小来衡量该方向的重要性。但是这样投影以后对数据的区分作用并不大,反而可能使得数据点揉杂在一起无法区分。

2、LDA线性判别分析

-

同类的数据点尽可能的接近(within class)

-

不同类的数据点尽可能的分开(between class)

3、CCA典型相关分析

4、三者比较

非线性降维

1、MDS (多维尺度分析)

2、tSNE(t-distributed stochastic neighbor embedding)

-

主要用于可视化,现多使用UMAP

- UMAP(Uniform Manifold Approximation and Projection)基于概率流线的方法,同时保留局部和全局结构,结果更稳定,计算快。

- 核心:使用图(加权二进制图)表示高维低维之间的相关关系,保证点和邻居间的相对关系保持不变

- 参数:perplexcity困惑度,考虑的邻居数

- UMAP(Uniform Manifold Approximation and Projection)基于概率流线的方法,同时保留局部和全局结构,结果更稳定,计算快。

- tSNE思想:高维的点间的距离关系在低维仍然保持

- 通过放射变换将数据点映射到概率分布上。在保证分布的基础上使得距离越远越好。

- 两个步骤

- SNE在低维空间里在构建这些点的概率分布,使得这两个概率分布之间尽可能的相似。

- SNE构建一个高维对象之间的概率分布,使得相似的对象有更高的概率被选择,而不相似的对象有较低的概率被选择。

- Loss(Highdim, Lowdim)降维后的距离损失最小化(在两个概率分布之间使用Kullback-Leibler divergence散度衡量)

- 参数:perplexcity(困惑度,什么时候对于方程满意),可视化结果对于该参数非常敏感

- 不足,除了可视化很难其他应用,降维没有唯一解(无法重复),倾向于局部特征,计算慢。

3、LASSO

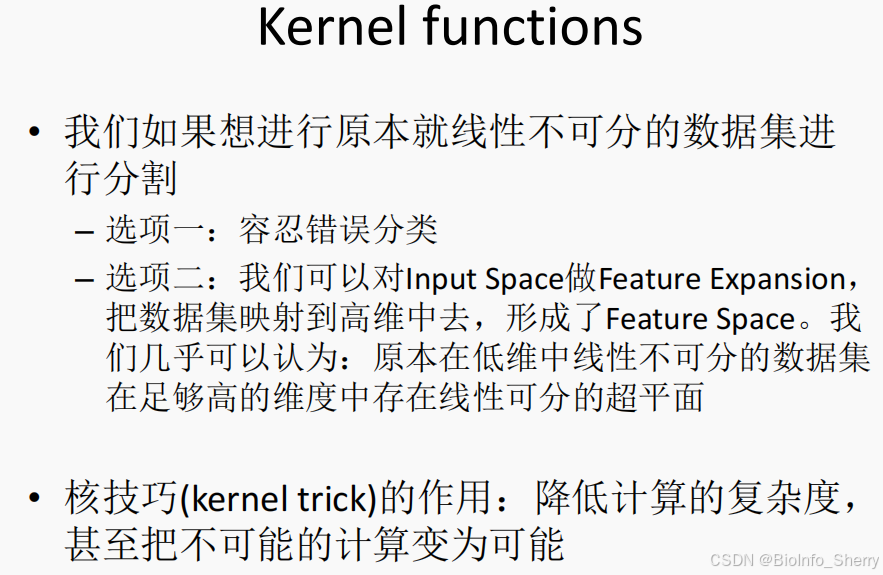

核函数

• 通过某非线性变换,将输入空间映射到高维特征空间,本质还是对原有数据增加维度。

• 核函数和映射没有关系。核函数只是用来计算映射到高维空间之后的内积的一种简便方法。

• 核函数包括:线性核函数、多项式核函数、高斯核函数等,其中高斯核函数最常用,可以将数据映射到无穷维。

• 通过使用非线性映射算法将低维输入空间线性不可分的样本转化为高维特征空间使其线性可分

• 从而使得高维特征空间采用线性算法对样本的非线性特征进行线性分析成为可能

- 常见例子:SVM中使用核技巧

考试重点

了解和比较PCA,LDA,CCA

了解tSNE与UPAM,LASSO与Ridge Regression

了解核技巧的意义(升维降低计算难度)和应用

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?