提示:本文用LM studio进行本地大模型部署,尤其本文重点解决模型无法识别的时候如何处理。

前言

上一期我们介绍了如何使用Ollama在本地部署DeepSeek模型,收到了很多小伙伴的私信询问是否需要或能否进行本地部署。本期我们将详细解释在什么情况下需要本地部署,并提供一个更简单的教程,即使是电脑小白也能轻松上手。如果你担心ollama部署后大模型会占用C盘空间,可以参考上一期的内容进行优化(地址)。

- 如果你还在担心如何使用DeepSeek,或者不确定该输入什么指令,可以参考我的文章《deepseek可以算命?》

- 如果你想进一步了解如何将本地部署的DeepSeek与PyCharm结合,用于编程辅助开发,可以阅读我的另一篇文章《deepseek本地部署教程:从零开始搭建你的AI助手》

以下是本篇文章正式内容:

一、什么情况下需要本地部署?

本地部署DeepSeek就是把AI模型装在你自己的电脑或服务器上,而不是依赖别人提供的在线服务。那么,什么情况下你需要这么做呢?以下是几种常见的场景:

1. 你担心数据隐私和安全

如果你处理的数据很敏感,比如公司机密、个人隐私或者医疗信息,你肯定不希望这些数据传到别人的服务器上。本地部署可以确保数据只留在你的设备上,别人碰不到。

例子:比如你是医生,想用AI分析病人的病历,本地部署就能避免病历泄露。

2. 你经常遇到网络问题

如果你用的网络不稳定,或者网速很慢,每次用AI都要等半天,那本地部署就很有必要了。因为模型在你电脑上运行,不需要联网,速度更快、更稳定。

例子:比如你在偏远地区工作,网络信号差,本地部署就能让你随时随地用AI。

3. 你需要定制化功能(个人觉得最重要原因)

如果你对AI有特殊需求,比如让它学习你行业的专业术语,或者调整它的回答风格,本地部署可以让你随意修改模型,完全按你的需求来。

例子:比如你是律师,想让AI更懂法律条文,本地部署后你可以训练它学习法律知识,当然如果你是学术研究者可以把你的相关文献传给AI让AI学习。

4. 你想长期省钱

虽然本地部署一开始需要买好点的电脑或服务器,但长期来看,比一直花钱买在线服务更划算。尤其是如果你经常用AI,本地部署能省下不少钱。

例子:比如你每天都要用AI处理大量数据,本地部署后就不用再付月费或按次收费了。

5. 你需要离线使用

如果你需要在没有网络的地方用AI,比如飞机上、地下室或者野外,本地部署是唯一的选择。因为模型在你电脑上,完全不需要联网。

例子:比如你是野外科研人员,需要在没有信号的地方分析数据,本地部署就能派上用场。

6.最重要的一点哈

你的电脑内存允许以及电脑性能支持的情况下部署,如果你本地C盘容量本身已经不足,我个人建议你别跟风本地部署。 毕竟如果你c盘容量不足的情况下,可能你是电脑小白安装软件一直无脑下一步导致,或者你的电脑c盘磁盘分区不合理。然后ollama默认还装到C盘,这不是给你原本不富裕的c盘雪上加霜吗?当然本博主较为善良,在这里提醒你可以清理一下你的C磁盘哈,你可以装一个TreeSize软件看一下你的哪个文件占用内存很大。

如果电脑不支持也不要灰心,网页版已经很好很好用啦,还不占用你的内存。

二、LM Studio使用步骤

1.安装LM Studio

第一步:官网下载安装:官网地址

2.配置deepseek

第一步:打开软件

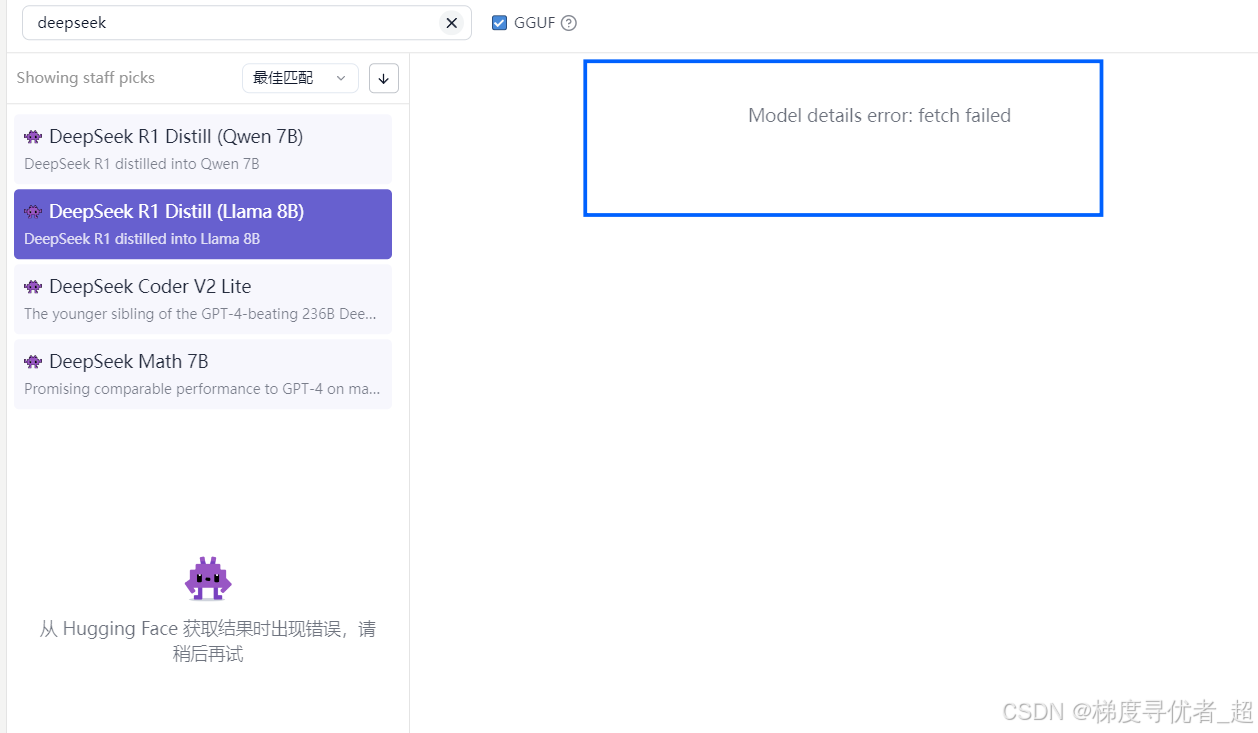

方式一:可以搜索模型下载(个人测试失败不能完成)

出现下图失败的情况,不要着急进行方案二应急。

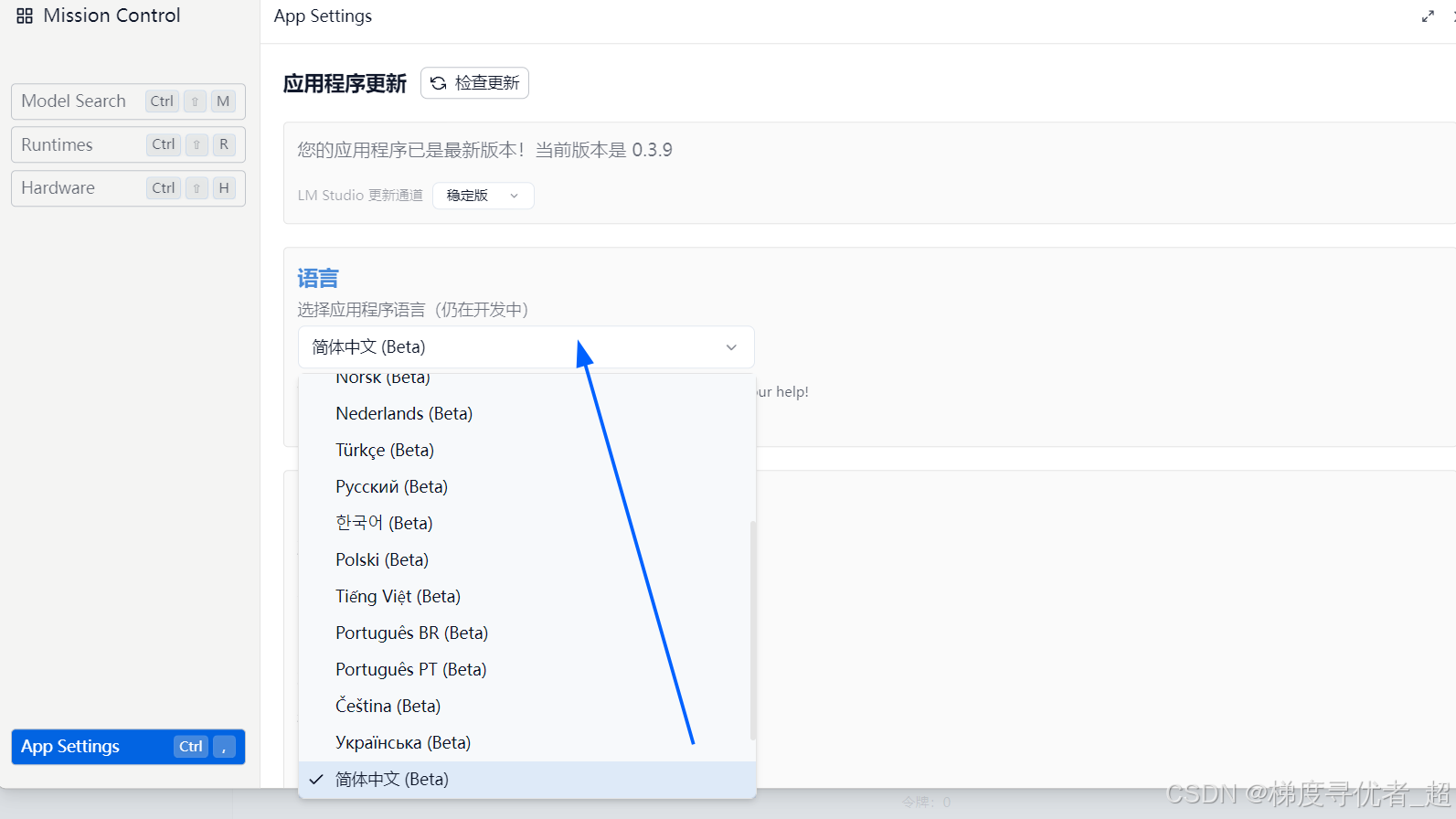

如果觉得英文界面不太友好可以设置中文界面,如下图。

方式二:

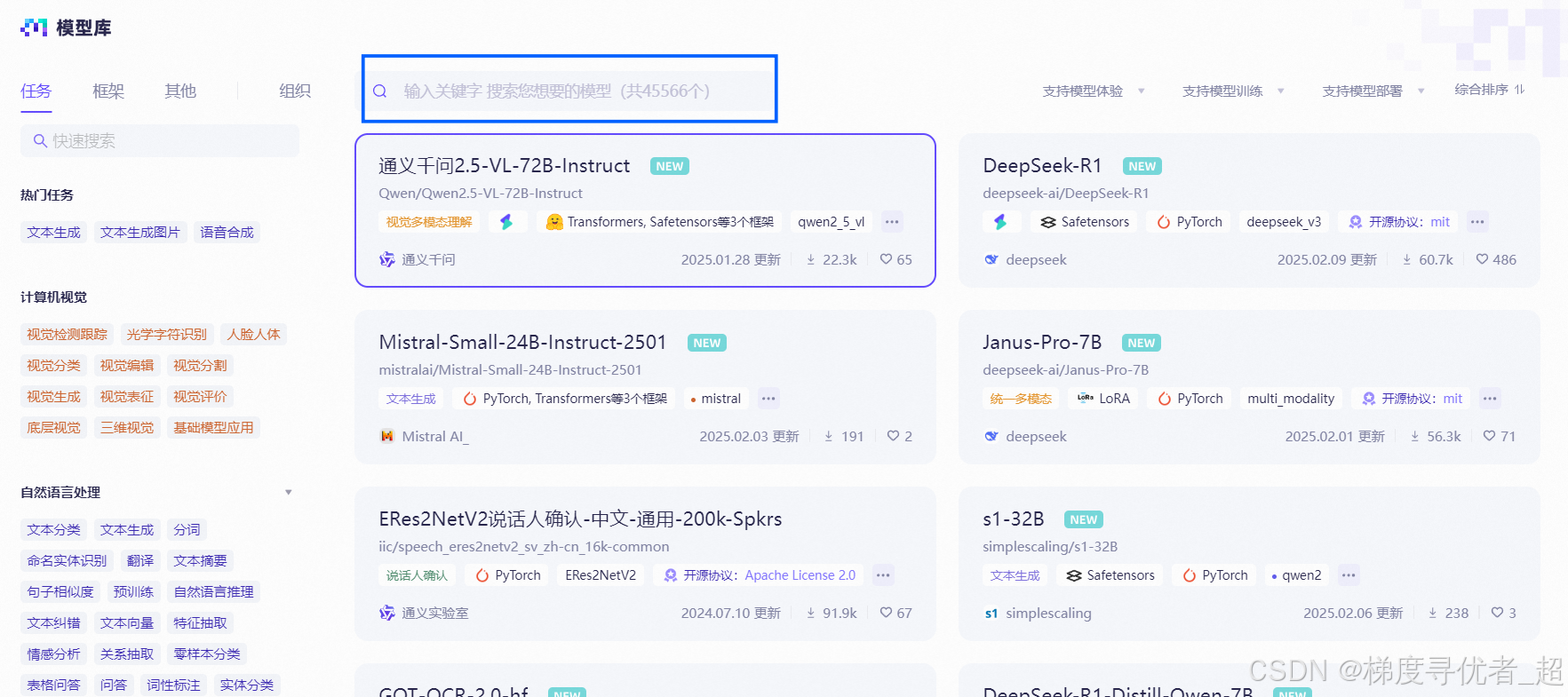

第一步:打开魔搭网站,下载gguf格式的文件然后进行部署。

当然魔搭平台还支持免费cpu部署,觉得电脑不太好使的可以采用云端部署,但是云端部署之后需要用程序使用API接口来使用。详细不做介绍。

魔搭官网地址:https://modelscope.cn/models

千万注意:一定注意下载gguf格式文件

我下载1.5b的作为演示。

然后点击模型文件

然后看清gguf格式的随便选择一个下载即可

第二步:模型下载到哪里?

注意先打开LM studio软件,注意默认是c盘,可以更改到其他盘。(这样不占用c盘内存)我改到d盘llm文件夹下面,这样也就意味着我第一步下载的模型需要存到这个里面。(注意看后文重点提醒,不然识别不到模型)

这个是国内下载下载速度很快,个人较为推荐的一种方式。

下载完成后即可配置这个模型完成模型配置。

特别提醒

特别提醒

模型储存位置要和你之前软件设置的地址相隔三个文件不然不能识别。

不懂就看下图的两个框的文件位置。

3.软件使用调整

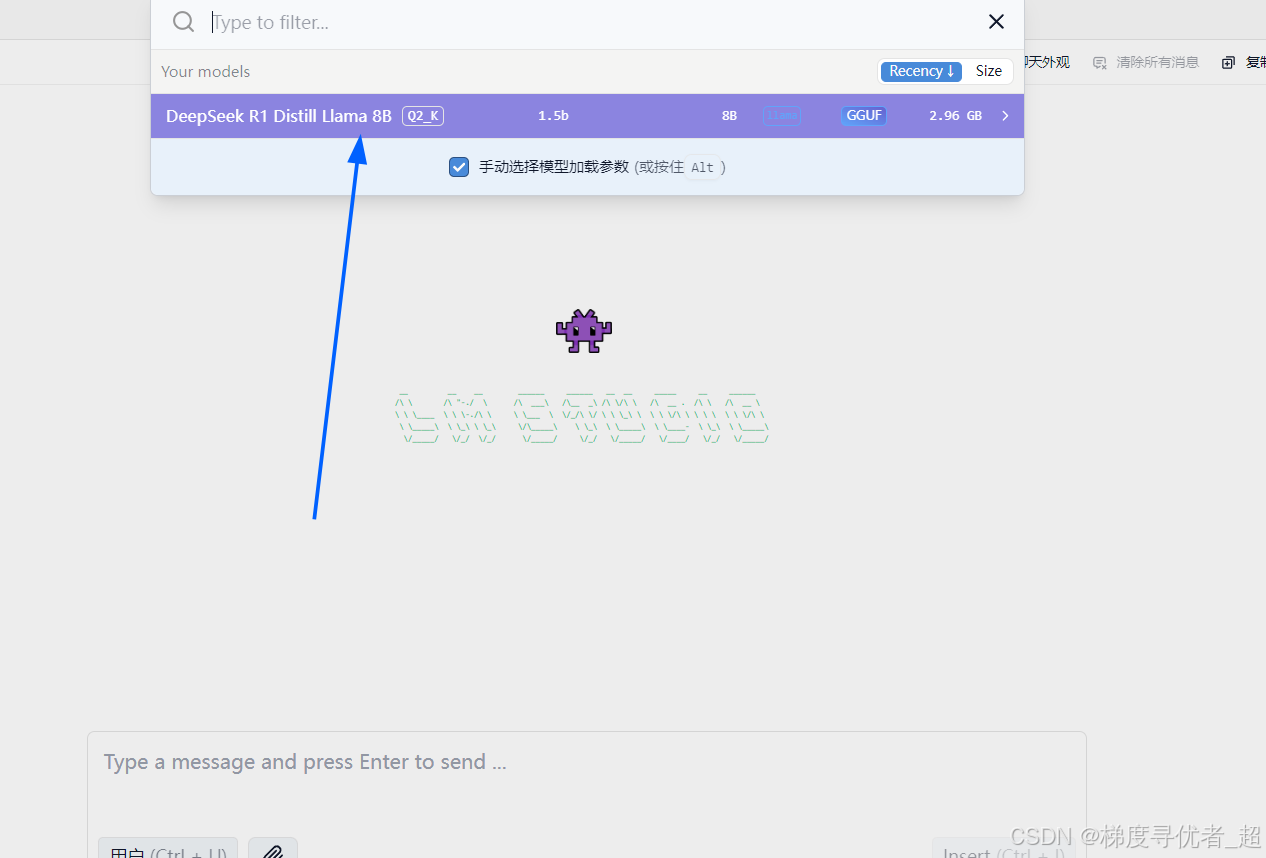

选择加载模型即可使用

下图可以调整你的使用偏好。

解释参数

上下文长度:根据任务需求调整。如果处理长文本(如文档摘要),可以增加上下文长度;如果处理短文本(如聊天),可以减少上下文长度以节省资源。

GPU 卸载(加载):根据 CPU 和 GPU 的负载情况调整。如果 CPU 负载高,可以增加 GPU 卸载以分担计算任务。(并非越大越快)

CPU Thread Pool Size:根据 CPU 核心数调整。多核 CPU 可以增加线程池大小以提高并行处理能力。

评估批处理大小:根据内存容量调整。大内存可以增加批处理大小以提高效率;小内存可以减少批处理大小以避免内存溢出。

RoPE 频率基底和缩放:根据任务对位置编码的需求调整。复杂任务可以调整这些参数以优化位置编码效果。

保持模型在内存中:根据内存容量调整。大内存可以启用此选项以加快访问速度;小内存可以禁用此选项以节省内存。

尝试 mmap():根据内存使用情况调整。如果内存紧张,可以启用此选项以减少内存占用。

种子:根据实验需求调整。固定种子以确保实验可重复性;随机种子以增加实验多样性。

快速注意力:根据计算资源调整。高性能硬件可以启用此选项以加速计算;低性能硬件可以禁用此选项以避免资源耗尽。

K Cache 和 V Cache 量化类型:根据存储和计算需求调整。实验性功能,可以根据具体任务需求尝试不同的量化类型以优化性能。

还有高级预设也可以设置。

温度:他指的是严谨程度,就是是否发散,也有人理解为离谱程度,值越大越离谱。

总结

提示:上述内容分享至此可继续探索哈,如有不足欢迎补充。

本文用到魔搭平台,这个平台的资源下载比上一期的ollama直接下载速度快很多,并且不用cmd命令。所有本节对电脑小白很友好。

下集预告

如给本地deepseek投喂数据,让它更加智能,让它能解决你专业领域的问题,尽请期待哈。

285

285

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?