与上章不同的是,本章介绍的方法是基于推理的方法,使用到神经网络。

1 基于推理的方法和神经网络

基于计数方法存在问题:在现实中,语料库量巨大,使用SVD来执行不现实。

结论:基于计数方法要一次性处理全部数据;基于推理方法使用部分数据逐步学习。神经网络学习空余使用多台机器,多个GPU并行执行,加速学习过程。

推理 即 预测

模型就是训练好的,训练时需要提供正确答案。类似于背课文,考你完形填空。

1.1 神经网络中处理单词方法

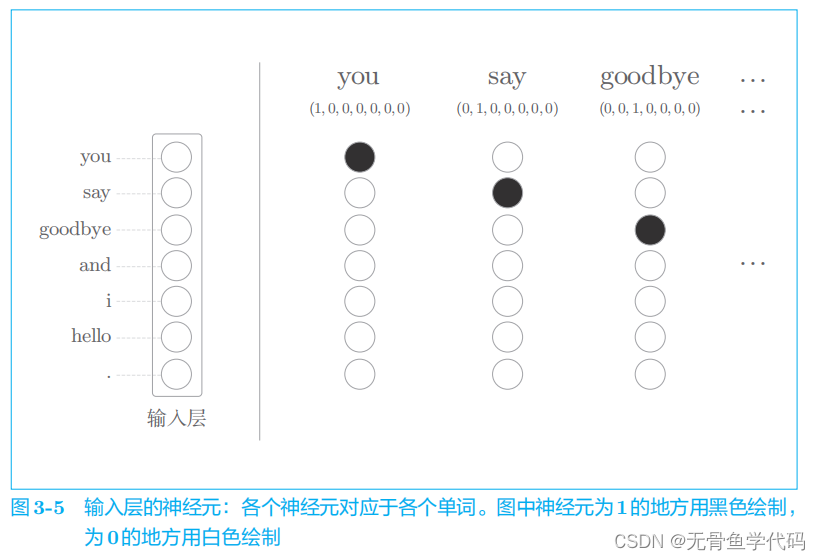

one-hot表示法:将单词转化为固定长度向量。

这样,神经网络输入层神经元个数就可以固定下来

7个单词对应7个神经元。

全连接层通过箭头连接所有节点。这些箭头拥有权重(参数),它们和输入层神经元的加权和成为中间层的神经元。另外,本章使用的全连接层将省略偏置。没有偏置的全连接层相当于在计算矩阵乘积。

2 简单的word2vec

2.1 CBOW模型的推理

CBOW

模型是根据上下文预测目标词的神经网络(“目标词”是指中间的单词,它周围的单词是“上下文”)。

这个上下文用

['you', 'goodbye']

这样的单词列表表示。我们将其转换为 one-hot

表示,以便

CBOW

模型可以进行处理。

这里,因为我们对上下文仅考虑两个单词,所以输入层有两个。如果对上下文考虑 N

个单词,则输入层会有

N

个。

中间层的神经元是各个输入层经全连接层变换后得到的值的“平均”,1/2

(

h

1

+

本文介绍了基于推理的神经网络技术在自然语言处理中的应用,特别是word2vec中的CBOW和skip-gram模型。CBOW模型通过上下文预测目标词,而skip-gram则是反之。文中还讨论了神经网络的学习过程,包括权重更新和数据预处理,以及与基于计数方法的对比。

本文介绍了基于推理的神经网络技术在自然语言处理中的应用,特别是word2vec中的CBOW和skip-gram模型。CBOW模型通过上下文预测目标词,而skip-gram则是反之。文中还讨论了神经网络的学习过程,包括权重更新和数据预处理,以及与基于计数方法的对比。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

412

412

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?