1 Attention的结构

基于

Attention

机制,

seq2seq

可以像我们人类一样,将“注意力”集中在必要的信息上。

1.1 seq2seq存在问题

1.2 编码器的改进

编码器的输出的长度应该根据输入文本的长度相应地改变

在图

8

-

2

的例子中,输入了

5

个单词,此时编码器输出 5

个向量。

这里我们所做的改进只是将编码器的全部时刻的隐藏状态取出来而已。通过这个小改动,编码器可以根据输入语句的长度,成比例地编码信息。

1.3 解码器的改进①

在上一章的最简单的

seq2seq

中,仅将编码器最后的隐藏状态向量传递给了解码器。

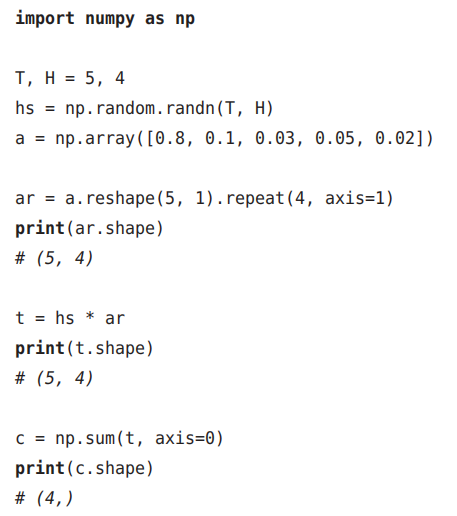

这里重述一下要点:“

Repeat

的反向传播是

Sum

”“

Sum

的反向传播是 Repeat

”。

将图

8

-

11

的计算图实现为层

1.4 解码器的改进②

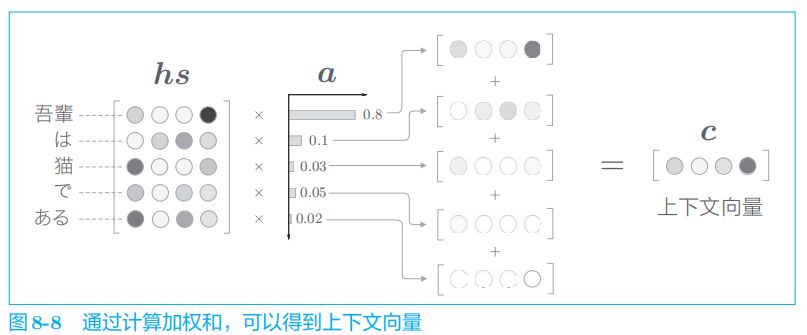

下面我们来看一下各个单词的权重

a

的求解方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?