思路:通过部署ollama和open-webui实现局域网拥有自己的本地deepseek大模型

安装环境----

操作系统:Ubuntu_Server22.04

核显运行

本地安装ollma,通过docker安装open-webui

先安装好操作系统,参考文档

一.安装ollama

官网安装文档

ollama/docs/linux.md at main · ollama/ollama · GitHub

下载并解压压缩包

curl -L https://ollama.com/download/ollama-linux-amd64.tgz -o ollama-linux-amd64.tgz

sudo tar -C /usr -xzf ollama-linux-amd64.tgz将ollama添加到启动服务

为ollama创建用户和用户组

sudo useradd -r -s /bin/false -U -m -d /usr/share/ollama ollama

sudo usermod -a -G ollama $(whoami)创建服务文件/etc/systemd/system/ollama.service

sudo vi /etc/systemd/system/ollama.service将以下内容复制粘贴到文件中并保存

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=$PATH"

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_FLASH_ATTENTION=1"

[Install]

WantedBy=default.target然后启动服务

sudo systemctl daemon-reload

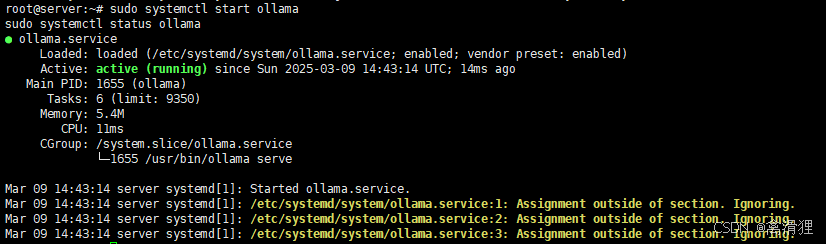

sudo systemctl enable ollama启动ollama服务并验证

sudo systemctl start ollama

sudo systemctl status ollama

安装deepseek-r1模型 测试

官网地址

deepseek-r1![]() https://ollama.com/library/deepseek-r1

https://ollama.com/library/deepseek-r1

模型下载地址Tags · deepseek-r1![]() https://ollama.com/library/deepseek-r1/tags

https://ollama.com/library/deepseek-r1/tags

这里我选择安装1.5b模型进行测试

ollama run deepseek-r1:1.5b安装完毕自动进入模型对话界面,使用Ctrl+D退出模型

二.安装docker

卸载系统下可能存在的docker软件包

for pkg in docker.io docker-doc docker-compose docker-compose-v2 podman-docker containerd runc; do sudo apt autoremove $pkg; done更新软件源

sudo apt-get update

sudo apt-get upgrade安装docker依赖包

sudo apt-get install \

ca-certificates \

lsb-release \

curl \

gnupg添加docker密钥

curl -fsSL http://mirrors.aliyun.com/docker-ce/linux/ubuntu/gpg | sudo apt-key add -添加docker官方源

sudo add-apt-repository \

"deb [arch=amd64] http://mirrors.aliyun.com/docker-ce/linux/ubuntu \

$(lsb_release -cs) \

stable"回车[ENTER]确认添加源

再次更新软件源

sudo apt-get update安装docker社区版

sudo apt-get install -y docker-ce命令查询dokcer版本确认是否安装

sudo docker -v三.安装open-webui

拉取open-webui容器并且配置运行

sudo docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://172.17.0.1:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

查询容器

sudo docker ps

通过同局域网下的主机访问服务器open-webui网址

${inner_ip}替换成服务器的ip

http://${inner_ip}:3000

登录网页后点击使用

创建管理员账户,邮箱可以随便填

网页会白屏几分钟,因为由于默认对接了open-ai的Api,但是没有科学上网的话,会一直等待响应,只需要等待进入页面后关闭该选项即可。

等待几分钟后......

确认后即可开始对话。

关闭open-ai的Api

关闭之后即可探索大模型的魅力了!

265

265

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?