摘要

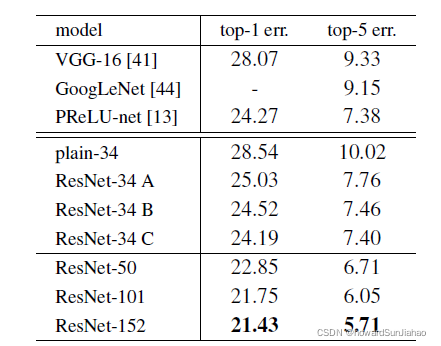

随着神经网络的深度变深,网络会更加难以学习,作者提出了一种残差连接的网络,使得在模型变深的时候依旧能够学习。网络是在ImageNet上学习的,总共有152层的深度,是VGG的8倍,即便深度增加了这么多,ResNet仍旧获得了很好的结果。

1 引言

深度网络将高中低等级的特征组合在一起,使用端到端的多层结构来分类,并且可以通过增加深度来增加特征。

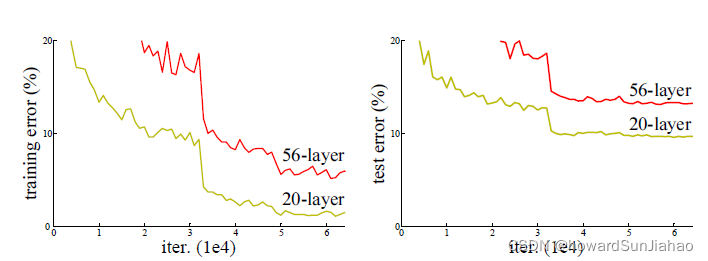

但是问题也随之而来:深度的增加会出现梯度消失、梯度爆炸的问题,同时,当网络深度增加,可以发现精度会先饱和,然后迅速下降,而这样的下降却不是由过拟合导致的,因为训练误差也在同步增加(如果是过拟合导致的,那么训练误差不会增加)。

可以看到下图中,56层的网络并没有20层的网络表现得好。

但是,如果我们做这样一个假设:当浅层的网络效果比较好的时候,深度网络训练会逐渐向浅层的网络进行学习。比如我们在一个浅层的网络上加一系列的恒等映射f(x)=x,那么看上去深度增加了,但是实际效果是不会变的,如果深度网络能够逐渐学习到这样的一个恒等映射,那么是不是就不会变差呢?但是,SGD的优化方法容易让学习陷入一个局部最优,所以无法学习到这样的一个恒等映射,于是深度的网络可能会比浅层的更差。

3 残差网络

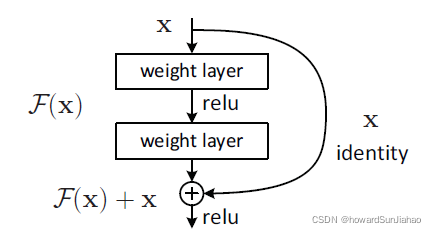

为了使得深度的网络至少不会比一个对应的浅层网络要差,引入了残差的结构:

假设我们希望网络学习到的是一个H(x)H(x)H(x)的映射,那么本来的浅层网络输出一个xxx,后面加的层假设是F(x)F(x)F(x),我们希望这些加的层学到的是H(x)−xH(x)-xH(x)−x,也就是残差。那么换一种写法也就是H(x)=F(x)+xH(x)=F(x)+xH(x)=F(x)+x。极端情况下,如果恒等映射是最优的,那么就更容易将残差部分变成0。同时,这样的恒等映射不会增加计算的复杂度。

具体实现而言就是引入了一个shortcut,可以理解为一个捷径,可以跳过中间的层,直接作用于输出上,如下图所示:

实验证明,比只是堆加层的网络,残差网络错误率低,并且深度增加的时候也可以有好的准确率。

shortcut的思想很久之前就被提出来了,并不是这篇文章提出来的,同时,但是的一些研究,如highway network,和residual的思想差不多,但是highway的shortcut connection是有参数的,所以可能这样的参数会变成0,于是就变成了没有残差的网络。

3.2 恒等映射

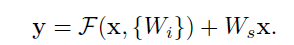

当然,还有个问题要解决,如何保证xxx和F(x)F(x)F(x)可以加呢,也就是说,要保证这两个的维度是相同的。

如果F(x)F(x)F(x)对输入xxx有维度上的改变,那么我们也需要在shortcut的xxx上做一些映射,使得维度匹配,也就是:

当然,这样的记号是对于全连接层而言的,但是卷积层也是类似的,我们实际上使用的映射就是1×1的卷积作为这里的WsW_sWs,因为1×1的卷积只会改变输入输出的维度,或者说通道数。

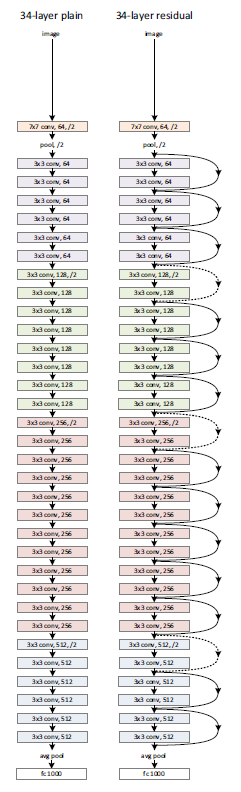

3.3 网络架构

一个34层的ResNet架构如下(右),其中实线是中间的卷积层F(x)F(x)F(x)没有改变输入的维度,虚线则是有维度的改变,这里维度的改变就是通道数的改变。

保证维度相等的方式有两种:

- 使用零进行填充

- 使用1×1的卷积核来改变维度。

3.4 实现

实现中,参考了Alexnet,但是又有些不同,将图片的短边随机变成256-480的数值,作为数据增强,然后随机裁出224×224的,也包括了它们的水平镜像,同时减去了均值做中心化。

同时,使用了批量归一化BN层在每一个卷积层之后和激活之前。训练的批量大小batch-size=256,learning-rate开始0.1,当误差稳定(plateau)的时候,就除以10。

和AlexNet意义,也用了权重衰减,但是衰减率是0.0001,还有动量梯度下降,动量为0.9。

测试的时候也和AlexNet一样,裁出10个224×224的然后取平均。

4 实验

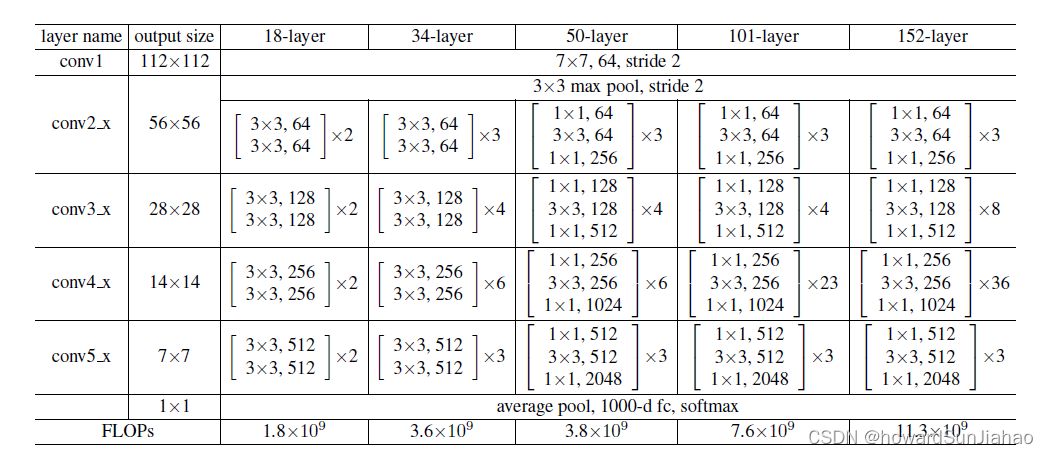

实验中尝试了18、34、50、101、152层的不同网络结构。

可以看到,所有结构最前面都是一个7×7的卷积和3×3的最大池化,和AlexNet是类似的,然后不同的是后面的架构,其中18层和34层的都差不多,就是残差块的数量多少有变化,而到了50层或者更深的网络,则采用了一种不同的架构——bottleneck。

采用这种架构的起因是,由于网络更加深了,于是输入通道数变得更多了,如果还想和本来保持差不多的复杂度,那么先使用1×1的卷积层把通道数降低,然后中间3×3和之前一样,最后再用1×1的卷积层映射回去,保证输入输出的通道数是一样的。中间的那个3×3的卷积被称为bottleneck。

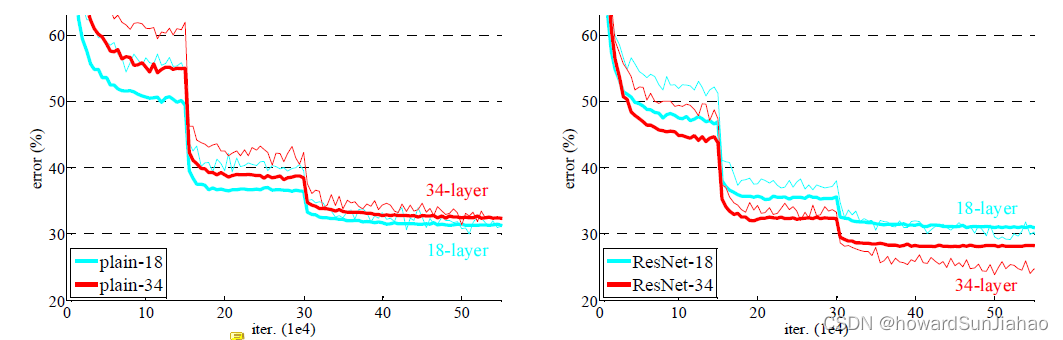

对比18层和34层的网络,细的是训练误差,粗的是验证误差,一开始可以看到验证的误差反而要低,这是因为用了数据增强,所以训练的时候会有许多的噪音。在使用了残差连接之后,深层的网络比浅层的网络效果要好:

作者还比较了使用0填充和使用1×1卷积核来保证维度的效果,下图中间的A、B、C分别表示了用零填充、用1×1卷积来增加维度和所有都用投影,虽然C的效果比B还要好,但是作者认为C会增加额外的计算复杂度,而且B的效果依旧很不错了。

本文介绍了ResNet残差网络,针对深度网络训练中的梯度问题和性能下降,通过引入残差连接保持深层网络的学习能力。该网络在ImageNet上展现了即使深度翻倍(152层)仍能保持高精度。关键概念包括恒等映射、shortcut和网络架构,如34层的ResNet结构。实验对比了不同深度网络,展示了ResNet的优势。

本文介绍了ResNet残差网络,针对深度网络训练中的梯度问题和性能下降,通过引入残差连接保持深层网络的学习能力。该网络在ImageNet上展现了即使深度翻倍(152层)仍能保持高精度。关键概念包括恒等映射、shortcut和网络架构,如34层的ResNet结构。实验对比了不同深度网络,展示了ResNet的优势。

1404

1404

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?