利用YOLO模型对是否佩戴口罩进行检测

参考:

https://blog.youkuaiyun.com/kushe123/article/details/113702225

https://blog.youkuaiyun.com/didiaopao

两位博主的文章

学习目标

- 环境的配置

- 依赖包的下载

- 数据集的准备

- 预训练权重

- 训练模型

- 训练模型路径的修改

- 查看训练结果(参数的变化过程,wandb)

- 测试

| 工具 | 解释器 | 参数可视化 | 虚拟环境 |

|---|---|---|---|

| pycharm | Anaconda | wandb | yolov5 |

一、环境的配置

1、创建虚拟环境yolov5

不想破坏现有的Anaconda的生态环境,所以创建一个虚拟环境yolov5运行项目

2、下载yolov5项目

github官网上有yolov5的开源项目可以打包下载

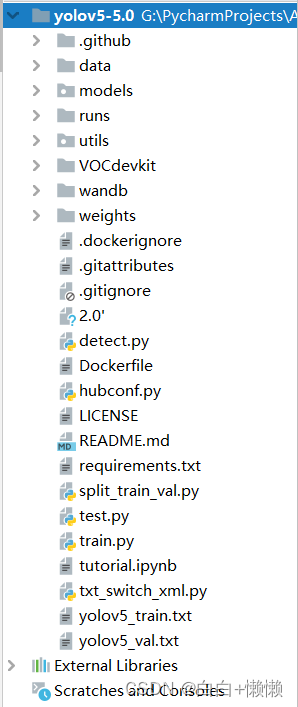

3、yolo项目的结构

将下载的yolov5的包解压缩,并用pycharm打开

YOLOV5结构

| data | 存放一些超参数的配置文件(yaml)用来配置训练集、测试集、验证集的路径,目标检测的种类和种类的名称。训练自己的数据集的时候需要改动这些yaml文件,但是数据集建议放到yolov5项目的同级目录下面 |

|---|---|

| models | 网络构建的配置文件和函数,保函了该项目四个不同的版本是s,m,l,x。检测速度从快到慢,精度从低到高。训练自己的数据集的话需要修改里面相应的yaml来训练自己的模型 |

| utils | 存放工具类的函数。loss函数、metrics函数、plots函数等 |

| weights | 放置训练好的权重参数 |

| detect.py | 利用训练好的权重参数进行目标检测 ,可以进行图片、摄像头的检测 |

| train.py | 训练自己数据集的函数 |

| test.py | 测试训练结果的函数 |

| requirements.txt | 文本文件,包含使用yolov5使用的环境依赖包 |

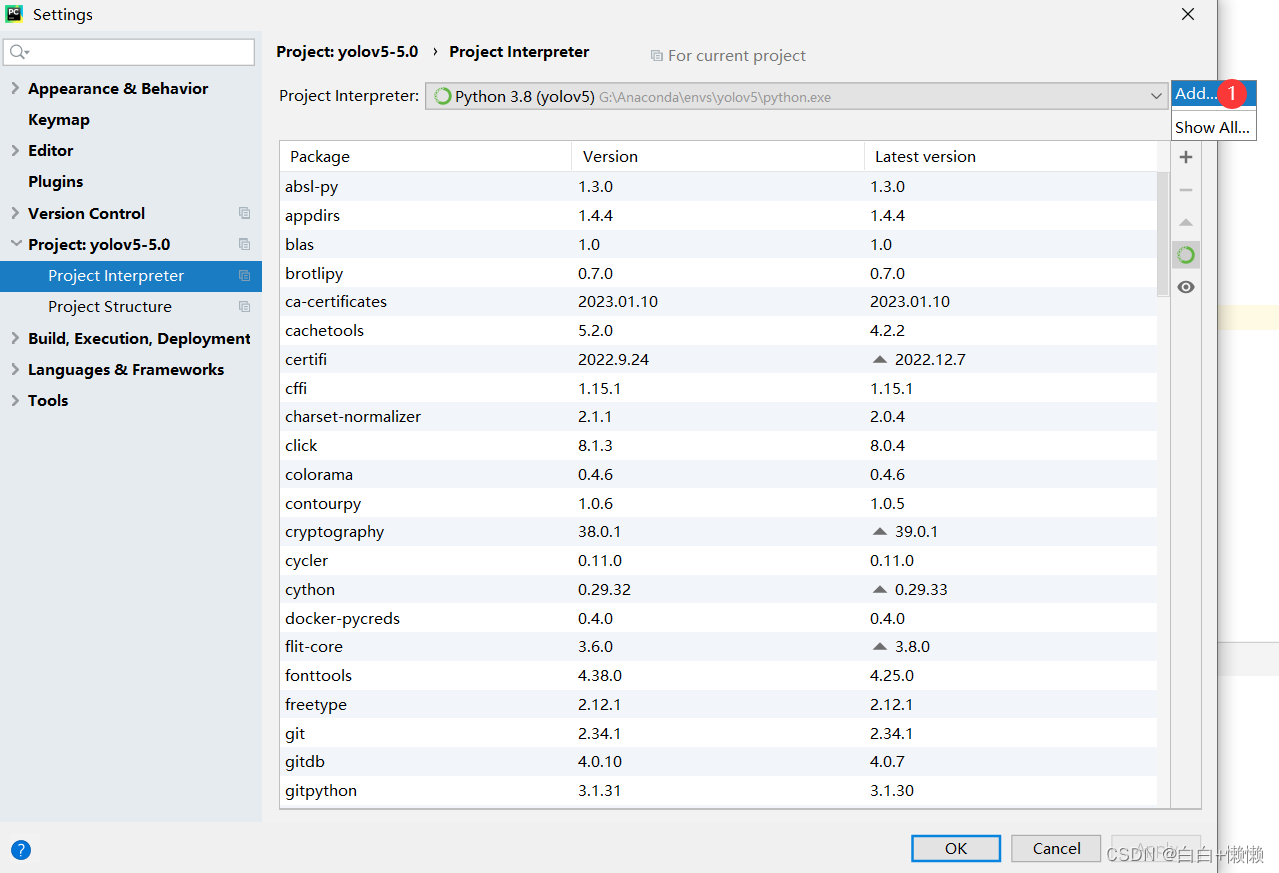

4、解释器的选择

pycharm中python环境选择刚才创建的虚拟环境

创建的虚拟环境在Anaconda中的envs中

检查是否成功(出现下图代表已将环境换为yolov5的虚拟环境)

二、依赖包的下载

1、文本文件下载依赖包

pip install -r requirements.txt

2、command ‘pip install ‘pycocotools>=2.0’’ returned non-zero exit status 1.

解决办法 不用尝试其他方法了,whl,翻墙都不行

三、数据集的准备

1、数据集下载

感谢https://blog.youkuaiyun.com/kushe123/article/details/113702225

链接:https://pan.baidu.com/s/16RUb8b8CZ4Hv6XbZvsskPQ

提取码:igg4

| 图片数量 | 约8000张 |

|---|---|

| 标签种类 | 两类 0:no-mask;1:mask |

| 标签格式 | txt (yolo训练需要txt格式,但是一般标签是xml格式) |

大约包含8000张图片,可以抽取部分图片进行训练,因为数据量太大模型的训练时间还是蛮长的

2、划分数据集为训练集和验证集

下载的数据标签类型为txt(先将其转换成xml标签,再划分数据集)

要注意路径!!!

py文件

- 转换成xml标签(txt_switch_xml.py)

# coding=utf-8

from xml.dom.minidom import Document

import os

import cv2

# def makexml(txtPath, xmlPath, picPath): # txt所在文件夹路径,xml文件保存路径,图片所在文件夹路径

def makexml(picPath, txtPath, xmlPath): # txt所在文件夹路径,xml文件保存路径,图片所在文件夹路径

"""此函数用于将yolo格式txt标注文件转换为voc格式xml标注文件

在自己的标注图片文件夹下建三个子文件夹,分别命名为picture、txt、xml

"""

dic = {'0': "hat", # 创建字典用来对类型进行转换

'1': "person", # 此处的字典要与自己的classes.txt文件中的类对应,且顺序要一致

}

files = os.listdir(txtPath)

for i, name in enumerate(files):

xmlBuilder = Document()

annotation = xmlBuilder.createElement("annotation") # 创建annotation标签

xmlBuilder.appendChild(annotation)

txtFile = open(txtPath + name)

txtList = txtFile.readlines()

img = cv2.imread(picPath + name[0:-4] + ".jpg")

Pheight, Pwidth, Pdepth = img.shape

folder = xmlBuilder.createElement("folder") # folder标签

foldercontent = xmlBuilder.createTextNode("driving_annotation_dataset")

folder.appendChild(foldercontent)

annotation.appendChild(folder) # folder标签结束

filename = xmlBuilder.createElement("filename") # filename标签

filenamecontent = xmlBuilder.createTextNode(name[0:-4] + ".jpg")

filename.appendChild(filenamecontent)

annotation.appendChild(filename) # filename标签结束

size = xmlBuilder.createElement("size") # size标签

width = xmlBuilder.createElement("width") # size子标签width

widthcontent = xmlBuilder.createTextNode(str(Pwidth))

width.appendChild(widthcontent)

size.appendChild(width) # size子标签width结束

height = xmlBuilder.createElement("height") # size子标签height

heightcontent = xmlBuilder.createTextNode(str(Pheight))

height.appendChild(heightcontent)

size.appendChild(height) # size子标签height结束

depth = xmlBuilder.createElement("depth") # size子标签depth

depthcontent = xmlBuilder.createTextNode(str(Pdepth))

depth.appendChild(depthcontent)

size.appendChild(depth) # size子标签depth结束

annotation.appendChild(size) # size标签结束

for j in txtList:

oneline = j.strip().split(" ")

object = xmlBuilder.createElement("object") # object 标签

picname = xmlBuilder.createElement("name") # name标签

namecontent = xmlBuilder.createTextNode(dic[oneline[0]])

picname.appendChild(namecontent)

object.appendChild(picname) # name标签结束

pose = xmlBuilder.createElement("pose") # pose标签

posecontent = xmlBuilder.createTextNode("Unspecified")

pose.appendChild(posecontent)

object.appendChild(pose) # pose标签结束

truncated = xmlBuilder.createElement("truncated") # truncated标签

truncatedContent = xmlBuilder.createTextNode("0")

truncated.appendChild(truncatedContent)

object.appendChild(truncated) # truncated标签结束

difficult = xmlBuilder.createElement("difficult") # difficult标签

difficultcontent = xmlBuilder.createTextNode("0")

difficult.appendChild(difficultcontent)

object.appendChild(difficult) # difficult标签结束

bndbox = xmlBuilder.createElement("bndbox") # bndbox标签

xmin = xmlBuilder.createElement("xmin") # xmin标签

mathData = int(((float(oneline[1])) * Pwidth + 1) - (float(oneline[3])) * 0.5 * Pwidth)

xminContent = xmlBuilder.createTextNode(str(mathData))

xmin.appendChild(xminContent)

bndbox.appendChild(xmin) # xmin标签结束

ymin = xmlBuilder.createElement("ymin") # ymin标签

mathData = int(((float(oneline[2])) * Pheight + 1) - (float(oneline[4])) * 0.5 * Pheight)

yminContent = xmlBuilder.createTextNode(str(mathData))

ymin.appendChild(yminContent)

bndbox.appendChild(ymin) # ymin标签结束

xmax = xmlBuilder.createElement("xmax") # xmax标签

mathData = int(((float(oneline[1])) * Pwidth + 1) + (float(oneline[3])) * 0.5 * Pwidth)

xmaxContent = xmlBuilder.createTextNode(str(mathData))

xmax.appendChild(xmaxContent)

bndbox.appendChild(xmax) # xmax标签结束

ymax = xmlBuilder.createElement("ymax") # ymax标签

mathData = int(((float(oneline[2])) * Pheight + 1) + (float(oneline[4])) * 0.5 * Pheight)

ymaxContent = xmlBuilder.createTextNode(str(mathData))

ymax.appendChild(ymaxContent)

bndbox.appendChild(ymax) # ymax标签结束

object.appendChild(bndbox) # bndbox标签结束

annotation.appendChild(object) # object标签结束

f = open(xmlPath + name[0:-4] + ".xml", 'w')

xmlBuilder.writexml(f, indent='\t', newl='\n', addindent='\t', encoding='utf-8')

f.close()

if __name__ == "__main__":

picPath = "VOCdevkit/VOC2007/JPEGImages/" # 图片所在文件夹路径,后面的/一定要带上

txtPath = "VOCdevkit/VOC2007/YOLOLabels/" # txt所在文件夹路径,后面的/一定要带上

xmlPath = "VOCdevkit/VOC2007/Annotations/" # xml文件保存路径,后面的/一定要带上

makexml(picPath, txtPath, xmlPath)

- 划分数据集(split_train_val.py)

# coding=utf-8

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

import random

from shutil import copyfile

classes = ["hat", "person"]

# classes=["ball"]

TRAIN_RATIO = 80 #训练集和验证集的比例,说明80%的训练集,20%的验证集

def clear_hidden_files(path):

dir_list = os.listdir(path)

for i in dir_list:

abspath = os.path.join(os.path.abspath(path), i)

if os.path.isfile(abspath):

if i.startswith("._"):

os.remove(abspath)

else:

clear_hidden_files(abspath)

def convert(size, box):

dw = 1. / size[0]

dh = 1. / size[1]

x = (box[0] + box[1]) / 2.0

y = (box[2] + box[3]) / 2.0

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return (x, y, w, h)

def convert_annotation(image_id):

in_file = open('VOCdevkit/VOC2007/Annotations/%s.xml' % image_id)

out_file = open('VOCdevkit/VOC2007/YOLOLabels/%s.txt' % image_id, 'w')

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

in_file.close()

out_file.close()

wd = os.getcwd()

wd = os.getcwd()

data_base_dir = os.path.join(wd, "VOCdevkit/")

if not os.path.isdir(data_base_dir):

os.mkdir(data_base_dir)

work_sapce_dir = os.path.join(data_base_dir, "VOC2007/")

if not os.path.isdir(work_sapce_dir):

os.mkdir(work_sapce_dir)

annotation_dir = os.path.join(work_sapce_dir, "Annotations/")

if not os.path.isdir(annotation_dir):

os.mkdir(annotation_dir)

clear_hidden_files(annotation_dir)

image_dir = os.path.join(work_sapce_dir, "JPEGImages/")

if not os.path.isdir(image_dir):

os.mkdir(image_dir)

clear_hidden_files(image_dir)

yolo_labels_dir = os.path.join(work_sapce_dir, "YOLOLabels/")

if not os.path.isdir(yolo_labels_dir):

os.mkdir(yolo_labels_dir)

clear_hidden_files(yolo_labels_dir)

yolov5_images_dir = os.path.join(data_base_dir, "images/")

if not os.path.isdir(yolov5_images_dir):

os.mkdir(yolov5_images_dir)

clear_hidden_files(yolov5_images_dir)

yolov5_labels_dir = os.path.join(data_base_dir, "labels/")

if not os.path.isdir(yolov5_labels_dir):

os.mkdir(yolov5_labels_dir)

clear_hidden_files(yolov5_labels_dir)

yolov5_images_train_dir = os.path.join(yolov5_images_dir, "train/")

if not os.path.isdir(yolov5_images_train_dir):

os.mkdir(yolov5_images_train_dir)

clear_hidden_files(yolov5_images_train_dir)

yolov5_images_test_dir = os.path.join(yolov5_images_dir, "val/")

if not os.path.isdir(yolov5_images_test_dir):

os.mkdir(yolov5_images_test_dir)

clear_hidden_files(yolov5_images_test_dir)

yolov5_labels_train_dir = os.path.join(yolov5_labels_dir, "train/")

if not os.path.isdir(yolov5_labels_train_dir):

os.mkdir(yolov5_labels_train_dir)

clear_hidden_files(yolov5_labels_train_dir)

yolov5_labels_test_dir = os.path.join(yolov5_labels_dir, "val/")

if not os.path.isdir(yolov5_labels_test_dir):

os.mkdir(yolov5_labels_test_dir)

clear_hidden_files(yolov5_labels_test_dir)

train_file = open(os.path.join(wd, "yolov5_train.txt"), 'w')

test_file = open(os.path.join(wd, "yolov5_val.txt"), 'w')

train_file.close()

test_file.close()

train_file = open(os.path.join(wd, "yolov5_train.txt"), 'a')

test_file = open(os.path.join(wd, "yolov5_val.txt"), 'a')

list_imgs = os.listdir(image_dir) # list image files

prob = random.randint(1, 100)

print("Probability: %d" % prob)

for i in range(0, len(list_imgs)):

path = os.path.join(image_dir, list_imgs[i])

if os.path.isfile(path):

image_path = image_dir + list_imgs[i]

voc_path = list_imgs[i]

(nameWithoutExtention, extention) = os.path.splitext(os.path.basename(image_path))

(voc_nameWithoutExtention, voc_extention) = os.path.splitext(os.path.basename(voc_path))

annotation_name = nameWithoutExtention + '.xml'

annotation_path = os.path.join(annotation_dir, annotation_name)

label_name = nameWithoutExtention + '.txt'

label_path = os.path.join(yolo_labels_dir, label_name)

prob = random.randint(1, 100)

print("Probability: %d" % prob)

if (prob < TRAIN_RATIO): # train dataset

if os.path.exists(annotation_path):

train_file.write(image_path + '\n')

convert_annotation(nameWithoutExtention) # convert label

copyfile(image_path, yolov5_images_train_dir + voc_path)

copyfile(label_path, yolov5_labels_train_dir + label_name)

else: # test dataset

if os.path.exists(annotation_path):

test_file.write(image_path + '\n')

convert_annotation(nameWithoutExtention) # convert label

copyfile(image_path, yolov5_images_test_dir + voc_path)

copyfile(label_path, yolov5_labels_test_dir + label_name)

train_file.close()

test_file.close()

运行成功后会出现下图的文件夹

3、KeyError: 'None’

如果在转换yolo格式(txt)到VOC格式(xml)时出现 KeyError: 'None’的报错,但一部分的txt文件已经转换成xml,这时候只需将下一个待转换图片和txt(对应的标签)删除即可。(估计是文件有问题,删除后就可以将后面的全部转换了)

四、预训练权重

与训练权重下载 本实验使用的是 yolov5s.pt

预训练权重:预先设置的训练权重,可以缩短训练时间。

将yolov5s.pt放置到weights文件夹中

五、训练模型

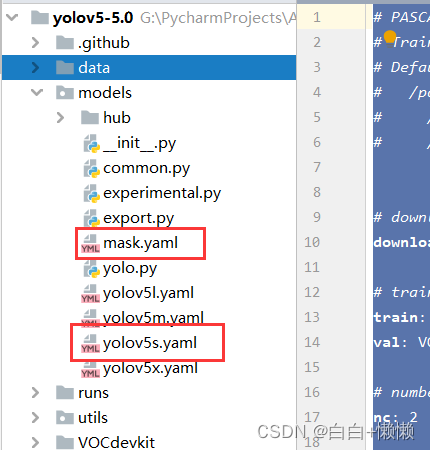

前文讲解yolo模型的结构时讲到

训练自己的数据集需要更改数据配置文件(data中的yaml)和模型配置文件(midels中的yaml文件)

1、更改数据配置文件

复制data中的voc.yaml命名为mask.yaml

mask.yaml文件

# PASCAL VOC dataset http://host.robots.ox.ac.uk/pascal/VOC/

# Train command: python train.py --data voc.yaml

# Default dataset location is next to /yolov5:

# /parent_folder

# /VOC

# /yolov5

# download command/URL (optional)

download: bash data/scripts/get_voc.sh

# train and val data as 1) directory: path/images/, 2) file: path/images.txt, or 3) list: [path1/images/, path2/images/]

train: VOCdevkit/images/train # 597 images 划分的训练集的路径

val: VOCdevkit/images/val # 144 images 划分的验证集的路径

# number of classes

nc: 2 #检测的类别数

# class names

names: ['no-mask','mask'] #标签类别的名

2、更改模型配置文件

预训练权重选择的是ylov5s.pt

所以models模型应该选择yolov5s.yaml(不同的与训练权重对应不同的网络层数,用错会报错)

复制models中的yolov5.yaml命名为mask.yaml

mask.yaml

# parameters

nc: 2 # number of classes

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.50 # layer channel multiple

# anchors

anchors:

- [10,13, 16,30, 33,23] # P3/8

- [30,61, 62,45, 59,119] # P4/16

- [116,90, 156,198, 373,326] # P5/32

# YOLOv5 backbone

backbone:

# [from, number, module, args]

[[-1, 1, Focus, [64, 3]], # 0-P1/2

[-1, 1, Conv, [128, 3, 2]], # 1-P2/4

[-1, 3, C3, [128]],

[-1, 1, Conv, [256, 3, 2]], # 3-P3/8

[-1, 9, C3, [256]],

[-1, 1, Conv, [512, 3, 2]], # 5-P4/16

[-1, 9, C3, [512]],

[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32

[-1, 1, SPP, [1024, [5, 9, 13]]],

[-1, 3, C3, [1024, False]], # 9

]

# YOLOv5 head

head:

[[-1, 1, Conv, [512, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 6], 1, Concat, [1]], # cat backbone P4

[-1, 3, C3, [512, False]], # 13

[-1, 1, Conv, [256, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 4], 1, Concat, [1]], # cat backbone P3

[-1, 3, C3, [256, False]], # 17 (P3/8-small)

[-1, 1, Conv, [256, 3, 2]],

[[-1, 14], 1, Concat, [1]], # cat head P4

[-1, 3, C3, [512, False]], # 20 (P4/16-medium)

[-1, 1, Conv, [512, 3, 2]],

[[-1, 10], 1, Concat, [1]], # cat head P5

[-1, 3, C3, [1024, False]], # 23 (P5/32-large)

[[17, 20, 23], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5)

]

六、训练模型路径的修改

1、修改路径

打开train.py文件(train.py是训练自己数据集的函数)

需要修改

| 需要修改 | 配置文件路径 |

|---|---|

| 预训练权重 | weights/yolov5s.pt |

| 数据集 | data/mask.yaml |

| 模型 | models/mask.yaml |

- 修改预训练权重

parser.add_argument('--weights', type=str, default='weights/yolov5s.pt', help='initial weights path')

- 修改模型的路径

parser.add_argument('--cfg', type=str, default='models/mask.yaml', help='model.yaml path')

- 修改数据的路径

parser.add_argument('--data', type=str, default='data/mask.yaml', help='data.yaml path')

| 参数 | 意义 |

|---|---|

| epochs | 训练次数,刚开始的时候可以选取较小的值进行训练 |

| batch-size | 每次输入图片的数量 |

| worker | CPU的工作核心 |

2、OSError:[WinError 1455]页面太小,无法完成操作

3、AttributeError: Can’t get attribute ‘SPPF’

缺少SPPF类

class SPPF(nn.Module):

# Spatial Pyramid Pooling - Fast (SPPF) layer for YOLOv5 by Glenn Jocher

def __init__(self, c1, c2, k=5): # equivalent to SPP(k=(5, 9, 13))

super().__init__()

c_ = c1 // 2 # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c_ * 4, c2, 1, 1)

self.m = nn.MaxPool2d(kernel_size=k, stride=1, padding=k // 2)

def forward(self, x):

x = self.cv1(x)

with warnings.catch_warnings():

warnings.simplefilter('ignore') # suppress torch 1.9.0 max_pool2d() warning

y1 = self.m(x)

y2 = self.m(y1)

return self.cv2(torch.cat([x, y1, y2, self.m(y2)], 1))

将上述代码放到models中的common.py中,如下图

4、RuntimeError: result type Float can’t be cast to the desired output type __int64

模型已经全部修改完成,运行train.py训练模型(这需要较长的时间,需耐心等待,等不了的话可以直接用训练好的模型)

七、查看训练结果

训练模型的过程中各种参数会发生变化,yolo训练完成后会给出整个过程的统计

wandb可以可视化训练过程中的状态

1、wandb

- pycharm上安装

pip install wandb

还需要注册账户信息

2、查看可视化结果

tensorboard --logdir=runs

3、runs文件夹

在train.py运行结束后,会产生一个runs文件夹,结构为runs/train/exp/weights会产生两个权重文件,其中best.pt(最好的权重),last.pt(是最后一轮的权重),利用最好的权重(best.pt),可以将前面的与训练权重换成best.pt。

八、测试(detect.py)

将前面训练得到的最好的权重(best.pt)进行测试(detect.py测试文件)

1、换权重文件

2、照片测试

-

输入测试图片的位置

-

运行detect.py

3、摄像头测试

-

将刚才照片的路径改为0即可

-

运行detect.py将会调用摄像头(不做演示)

全部完成咯,记录第一次做口罩检测的项目!!!

最后十分感谢

https://blog.youkuaiyun.com/kushe123/article/details/113702225

https://blog.youkuaiyun.com/didiaopao

两位的文章,受益匪浅!!!

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?