论文:《Deep Residual Learning for Image Recongnition》 kaiming he ,jian sun等人

ResNet 在2015年由微软实验室提出,斩获当年ImageNet竞赛中分类任务的第一名,目标检测第一名。获得coco数据集中目标检测,图像分割的第一名。就是一种非常牛掰的网络。我们可以叫它残差网络。

LeNet5、AlexNet、VGG-16、GoogLeNet、ResNet50原理及其结构 - 简书 (jianshu.com)这个链接里面做的图比较高清

(壹)网络当中的亮点:

(一)网络结构非常深(作者在原论文当中尝试搭建1000层的网络)

(二)提出Residual模块

(三)使用Batch Normalization加速训练(丢弃Dropout)

(一)网络结构加深就一定好吗?

加深层数产生的问题:

1 梯度消失或者梯度爆炸:如果我们的权重<1在反向传播中就会慢慢的变成0,如果>1,在一层层的反向传播中就会导致梯度爆炸。

如何处理(处理方法发有哪些):(1)对数据进行标准化处理(2)权重初始化(3)BN层

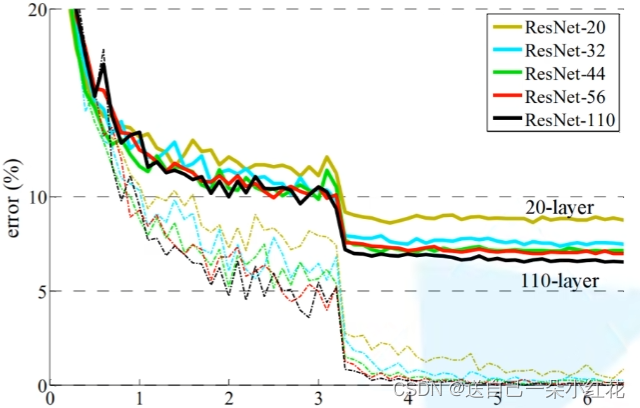

2 退化问题(degradation problem):随着网络加深,效果反而不好。但是残差网络很好的解决了这一问题,如下图,随着网络的加深,反而我们的错误率越低。

(二)Residual结构(残差结构)

左边这副是针对网络深度较小的网络设置残差结构,右边是深层次的网络所搭建的残差结构,

34-layars , 50、101、152-layars。

我们提到过,神经网络的目标是减少参数。

我们经计算:右

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?