目录

Tittle:3D Dilated Multi-Fiber Network for Real-time Brain Tumor Segmentation in MRI

轻量化网络节省计算开销的相关概念补充

深度可分离卷积

使用深度可分离卷积可以在准确率小幅下降的前提下,大大的减少模型的参数量和运算量。在实践当中常使用深度可分离卷积来代替普通卷积来轻量化网络,从而减少计算的开销

DW卷积(Depthwise Conv)

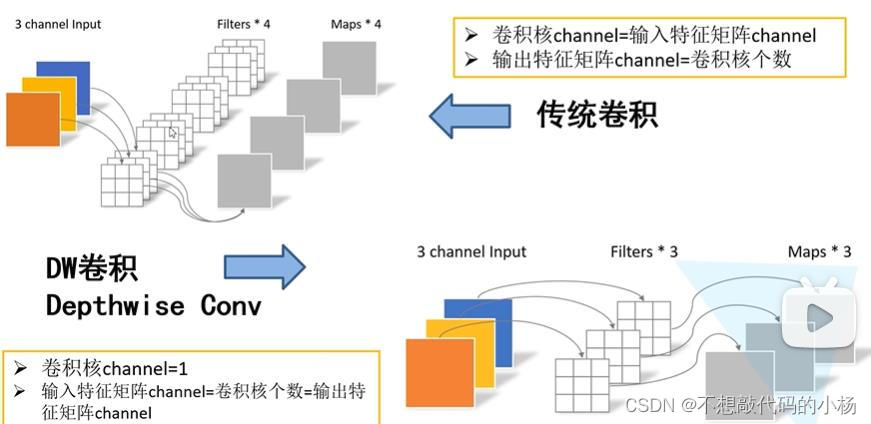

传统卷积和DW卷积对比图如下:

在传统卷积中,比如一个输入特征矩阵深度为3,我们使用4个卷积核进行卷积,并且每个卷积核的深度都与输入特征矩阵的深度是一致的,然后输出特征矩阵的深度是由卷积核的个数所决定的,图中采用了4个卷积核所以输出特征矩阵的深度就为4。

而在DW卷积中,每个卷积核的深度都是为1的,在DW卷积中每一个卷积核只负责对输入特征矩阵的一个通道进行卷积,然后再得到相应的输出特征矩阵的一个通道。因此卷积核的个数等于输入特征矩阵通道数也等于输出特征矩阵的通道数。

PW卷积(Pointwise Conv)

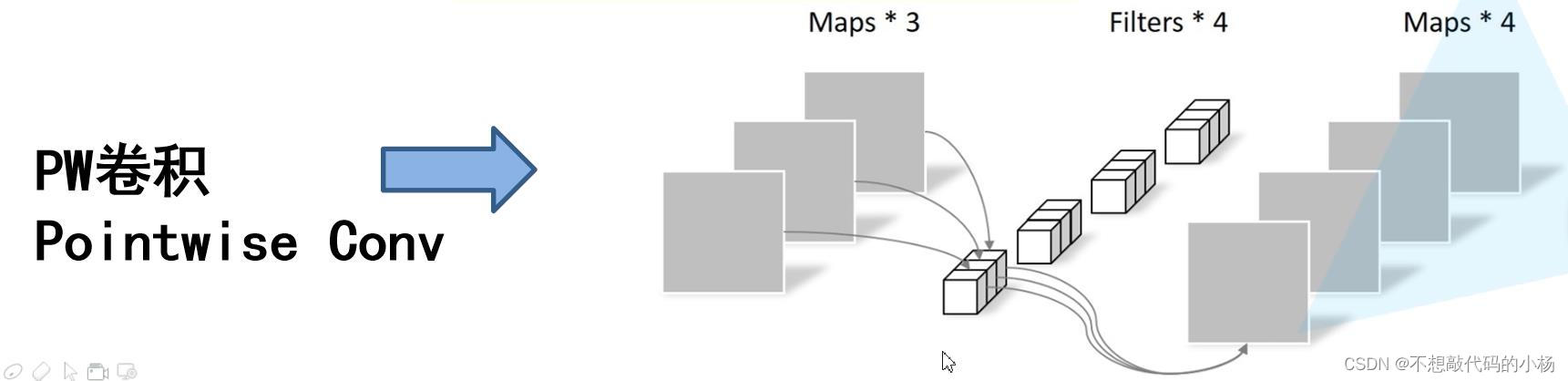

PW卷积的示意图如下所示:

PW卷积其实就是普通的传统卷积,只不过其卷积核的大小等于1而已。从上图中可以看出每一个卷积核的深度同样与输入特征矩阵的深度相同,然后输出矩阵的深度与卷积核的个数相同

DW卷积+PW卷积就是深度可分离卷积

普通卷积和深度可分离卷积计算量对比

普通卷积的计算如下

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1684

1684

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?