摘要:基于脉冲的神经形态的硬件承诺去减少图片分类和其他学习应用的能量消耗,尤其在手机和其他边缘设备上。然而,深度脉冲神经网络的直接训练是困难的,并且先前将被训练的人工神经网络转变到脉冲神经网络的方法是无效的因为神经元不得不发出太多脉冲。我们展示了一个大体上更有效转变提升,当以这个为目的优化脉冲神经元模型,以至于它不仅仅与一个神经元发放多少脉冲的信息转变有关也许什么时候它发放这些脉冲有关。这个进步精度能用脉冲神经元来做图像分类能被达到,并且结果网络需要平均每个脉冲神经元仅仅两个脉冲去分类图片。额外的,我们和的心转变方法提升潜在因素和结果脉冲网络的吞吐量。

脉冲神经网络作为最近在边缘设备中现代AI的更广泛使用的障碍被探索尽可能多的解决方案。大的最先进的人工神经网络的能量消耗被深度学习所生产。

最广泛使用在图片分类上的是卷积神经网络,当然也用在其他应用域。这些人工神经网络不得不是足够大的去达到顶级的表现,因为他们需要有一个足够大数量的参数为了从他们训练过的大数据集中去吸引足够的信息。这些大的人工神经网络的标准硬件实现的推论是无力的。

脉冲神经元已经聚焦在用一个彻底地减少能量预算的新奇的计算硬件的AI发展,尤其因为这个大脑的巨大SNN-由大约1000亿个神经元组成-仅仅20w的功率消耗。刻板形象的脉冲也叫做脉冲的脉冲神经元输出训练。因此他们的输出是和持续的一个人工神经网络神经元的生产作为输出是非常不同的。大多数的被考虑在神经元形态上的硬件的实现被大脑中的脉冲神经元的简单模型所激发。然而,这些简单神经元模型不捕获生物神经元的能力去被不同的短暂脉冲模式去编码不同的输入,不仅仅通过他们的发放率。

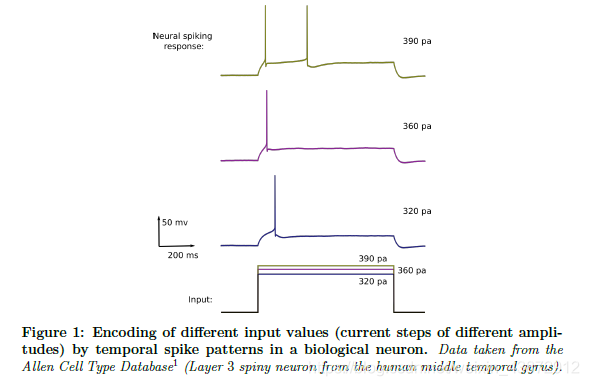

不同输入值的编码(不同振幅的电流阶跃)在一个生物神经元里的短暂脉冲模式。

而大的人工神经网络,在巨大的数据集上用甚至更复杂的深度学习算法训练,在几个智能分类接近有时候超越人类的表现,基于脉冲的神经形态的硬件的最近几代的表现发展滞后。希望通过循环排重神经网络的例子能使差距缩小,因为那

本文提出了一种新的ANN到SNN转换方法——FS转换,该方法通过优化脉冲神经元模型,使得每个脉冲神经元仅需发出少量脉冲即可完成图像分类任务,大大提升了脉冲神经网络在边缘设备上的能效比。

本文提出了一种新的ANN到SNN转换方法——FS转换,该方法通过优化脉冲神经元模型,使得每个脉冲神经元仅需发出少量脉冲即可完成图像分类任务,大大提升了脉冲神经网络在边缘设备上的能效比。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

865

865

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?