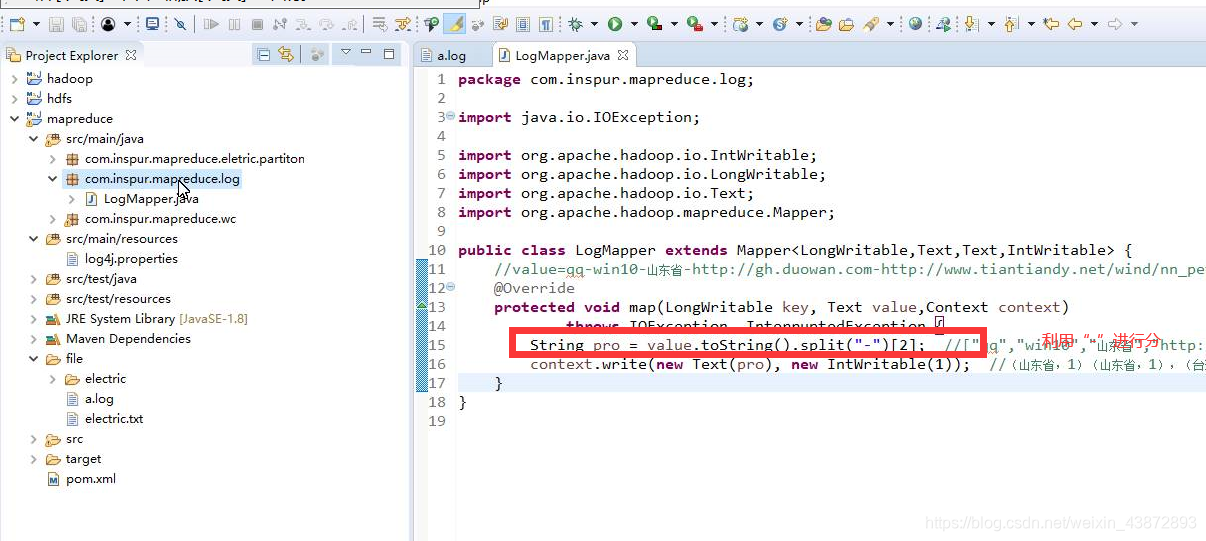

省份提取

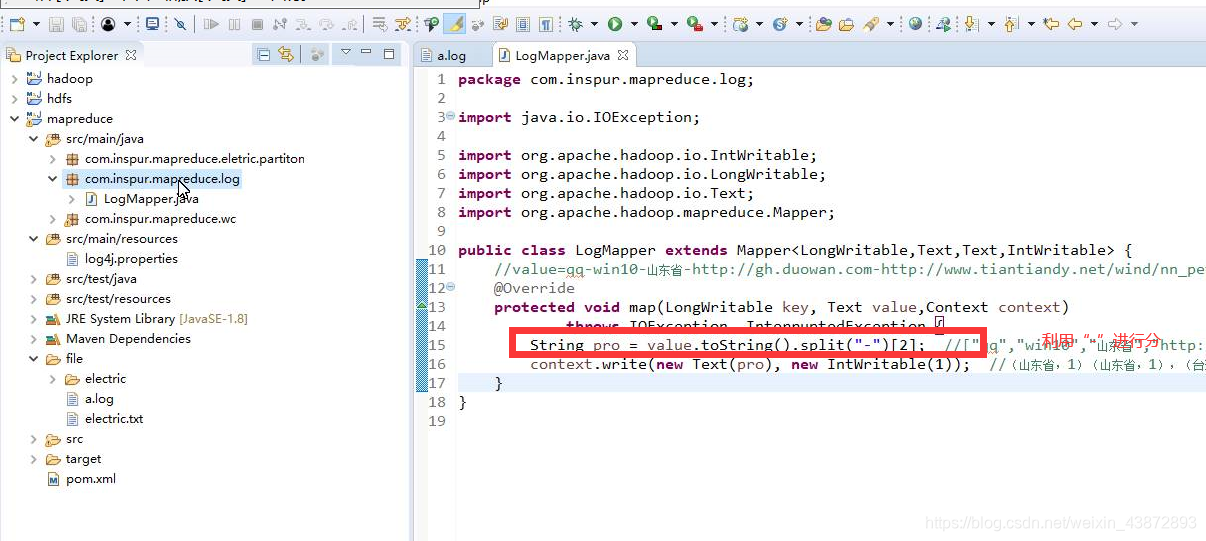

1、LogMapper.java

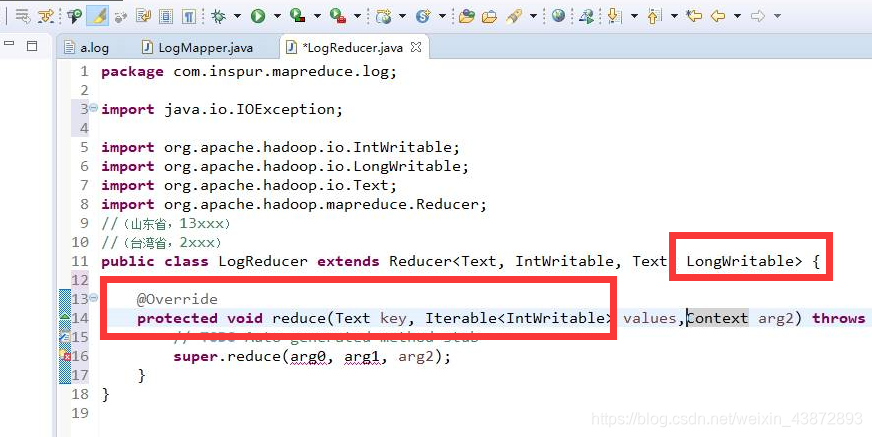

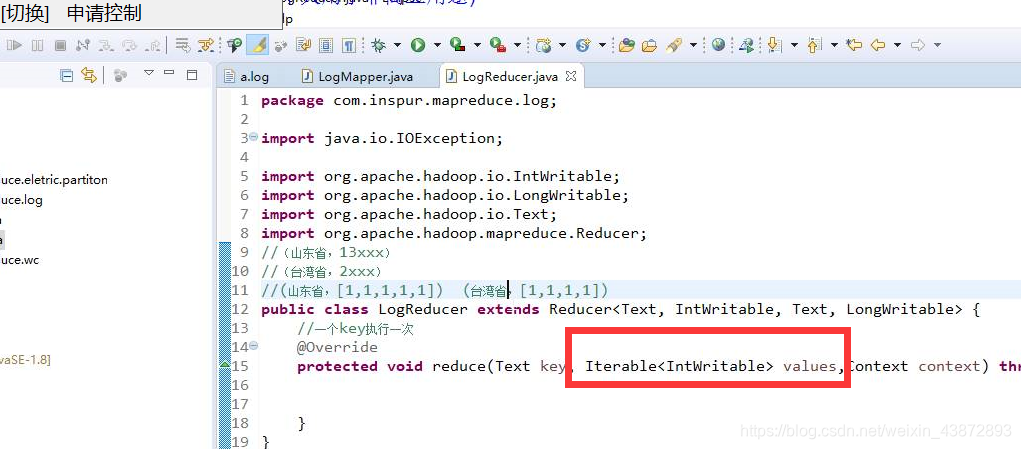

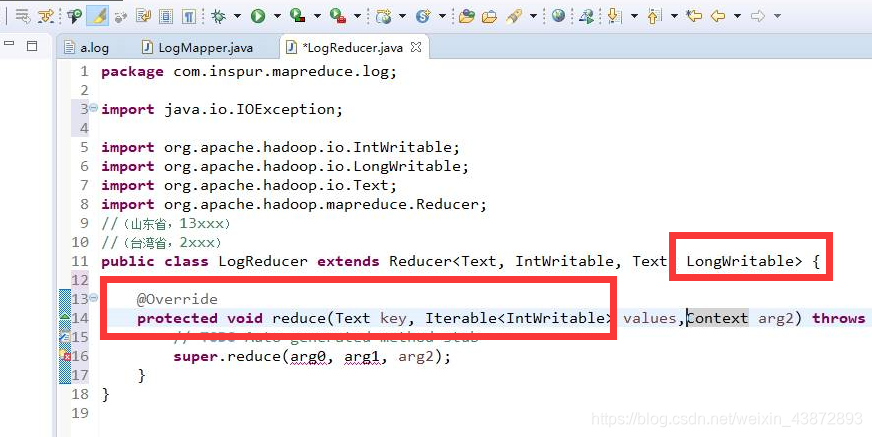

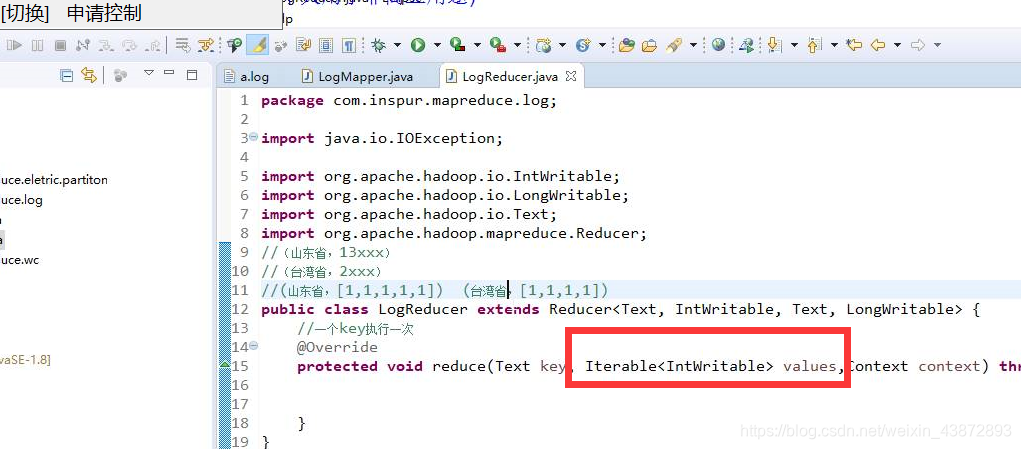

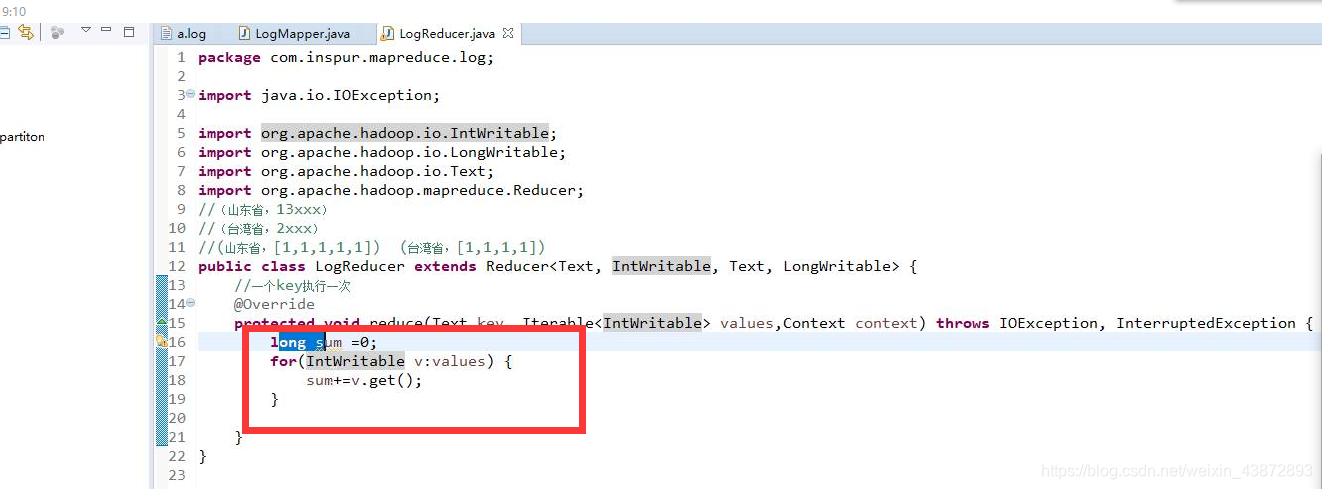

2、LogReducer.java

重写reduce方法,

进入到reduce的数据是(山东省,【1,1,1,1,】,(台湾省,【1,1,1,1】))

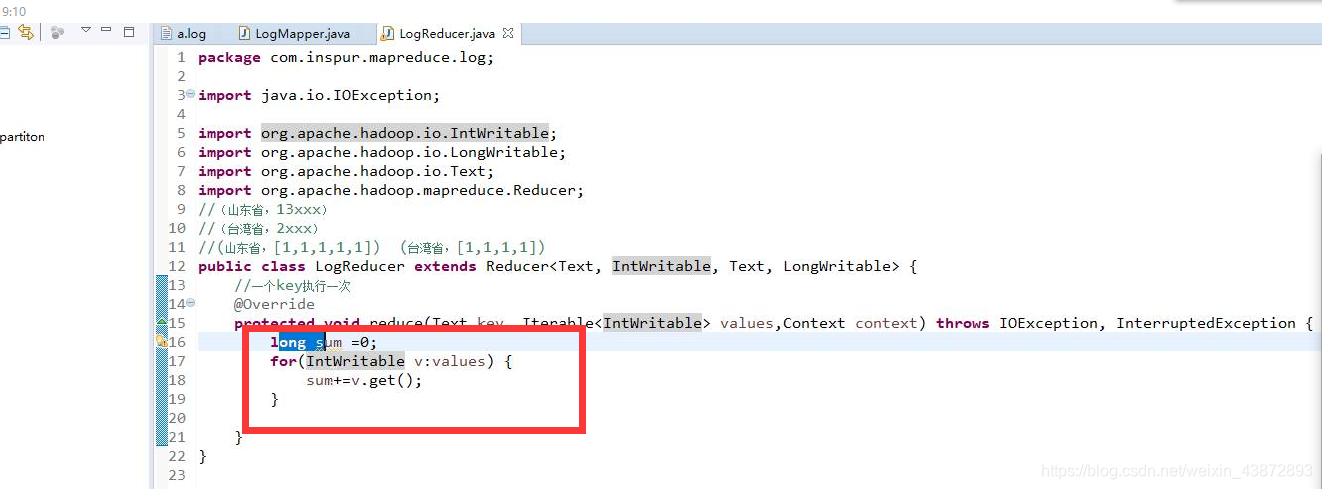

其中values就是数组

将取到的值放到sum上

通过intWritable改成int类型

3、每一个key_value对进行一次

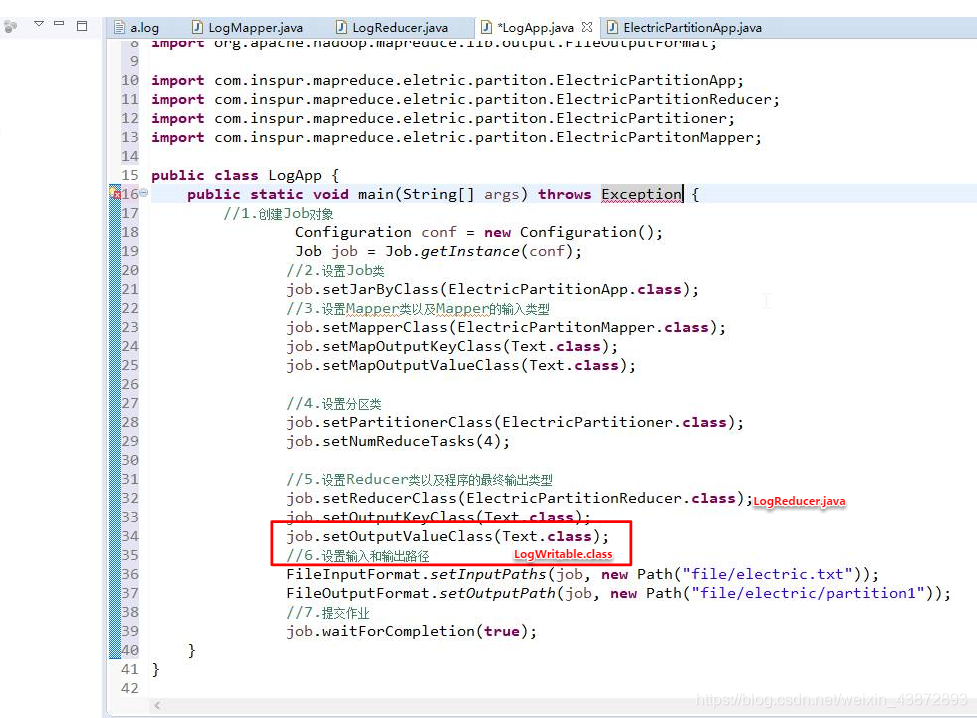

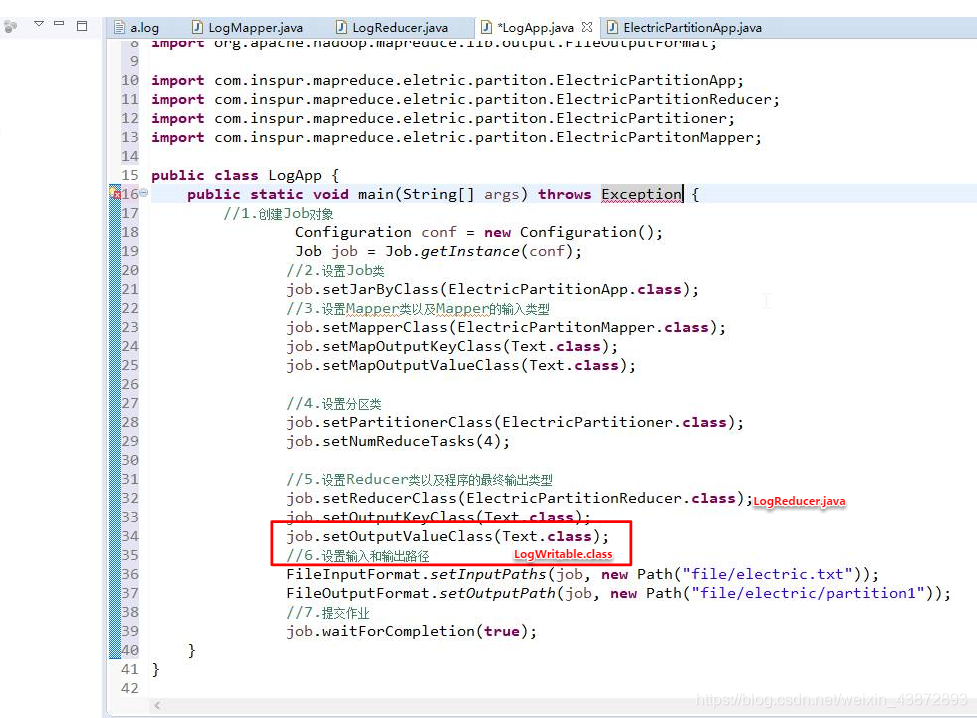

4、开发LogApp.java

main方法

5、当然也可以放到数据库中,以扇形图等的形式进行展示

本文介绍了一种处理日志文件中省份数据的方法,通过MapReduce技术实现数据汇总,并讨论了如何将处理后的数据以扇形图等形式进行可视化展示。

本文介绍了一种处理日志文件中省份数据的方法,通过MapReduce技术实现数据汇总,并讨论了如何将处理后的数据以扇形图等形式进行可视化展示。

省份提取

1、LogMapper.java

2、LogReducer.java

重写reduce方法,

进入到reduce的数据是(山东省,【1,1,1,1,】,(台湾省,【1,1,1,1】))

其中values就是数组

将取到的值放到sum上

通过intWritable改成int类型

3、每一个key_value对进行一次

4、开发LogApp.java

main方法

5、当然也可以放到数据库中,以扇形图等的形式进行展示

1260

1260

238

238

790

790