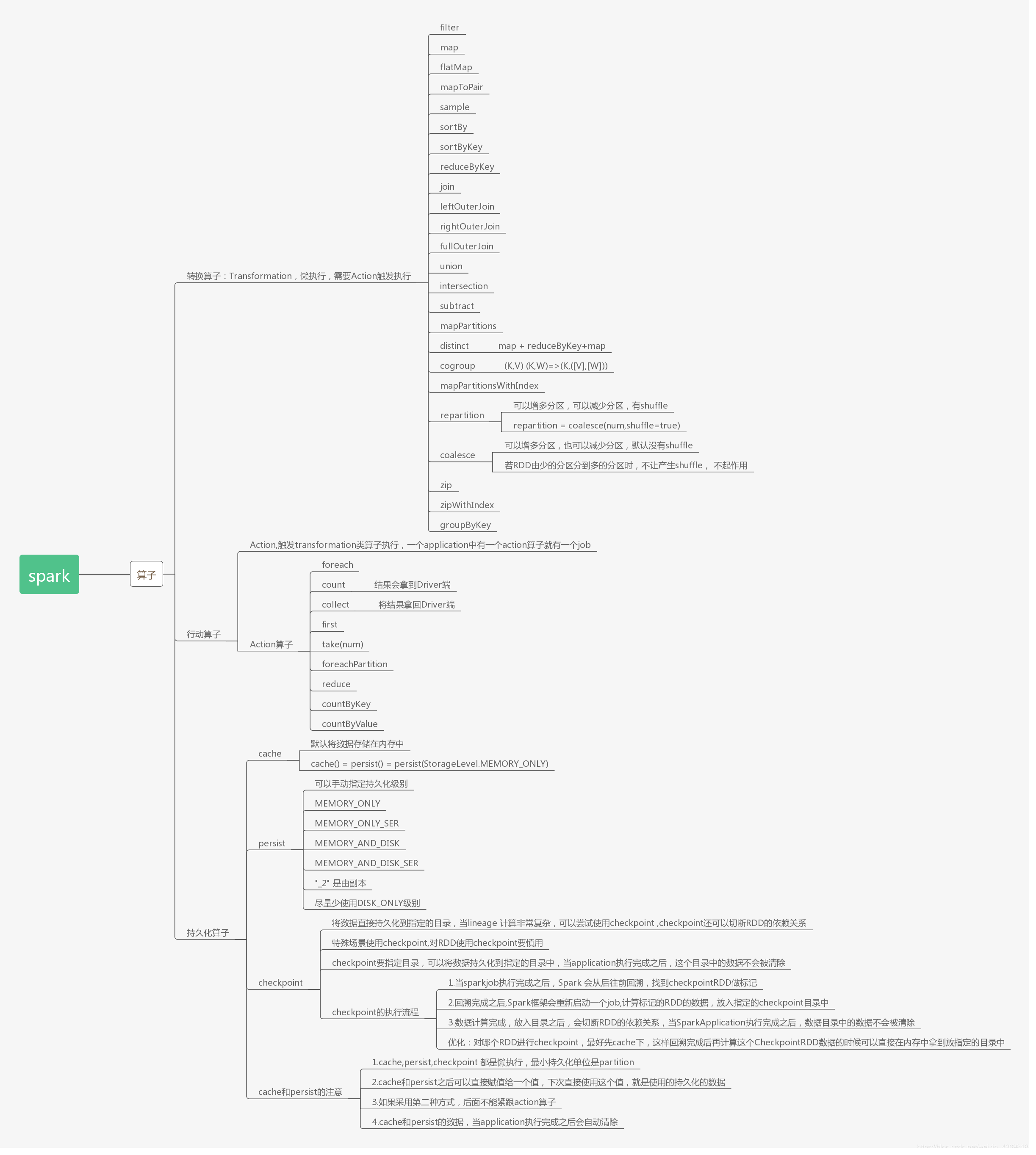

一、spark常用算子

1、Transformations转换算子

1.概念:

Transformations类算子是一类算子(函数)叫做转换算子,如map,flatMap,reduceByKey等。Transformations算子是延迟执行,也叫懒加载执行。

2.Transformation类算子:

- filter

过滤符合条件的记录数,true保留,false过滤掉。

- map

将一个RDD中的每个数据项,通过map中的函数映射变为一个新的元素。

特点:输入一条,输出一条数据。

- flatMap

先map后flat。与map类似,每个输入项可以映射为0到多个输出项。

- sample

随机抽样算子,根据传进去的小数按比例进行又放回或者无放回的抽样。

- reduceByKey

将相同的Key根据相应的逻辑进行处理。

- sortByKey/sortBy

作用在K,V格式的RDD上,对key进行升序或者降序排序。

2、Action行动算子

- 概念:

Action类算子也是一类算子(函数)叫做行动算子,如foreach,collect,count等。Transformations类算子是延迟执行,Action类算子是触发执行。一个application应用程序中有几个Action类算子执行,就有几个job运行。

2.Action类算子

- count

返回数据集中的元素数。会在结果计算完成后回收到Driver端。

- take(n)

返回一个包含数据集前n个元素的集合。

- first

first=take(1),返回数据集中的第一个元素。

- foreach

循环遍历数据集中的每个元素,运行相应的逻辑。

- collect

将计算结果回收到Driver端。

3、控制算子

概念:控制算子有三种,cache,persist,checkpoint,以上算子都可以将RDD持久化,持久化的单位是partition。cache和persist都是懒执行的。必须有一个action类算子触发执行。checkpoint算子不仅能将RDD持久化到磁盘,还能切断RDD之间的依赖关系。

- cache

默认将RDD的数据持久化到内存中。cache是懒执行。

- 注意:chche () = persist()=persist(StorageLevel.Memory_Only)

- 测试cache文件:

这里需要一个大一点文件200M即可

测试代码:

SparkConf conf = new SparkConf();

conf.setMaster("local").setAppName("CacheTest");

JavaSparkContext jsc = new JavaSparkContext(conf);

JavaRDD<String> lines = jsc.textFile("./filename");

lines = lines.cache();

long startTime = System.currentTimeMillis();

long count = lines.count();

long endTime = System.currentTimeMillis();

System.out.println("共"+count+ "条数据,"+"初始化时间+cache时间+计算时间="+

(endTime-startTime));

long countStartTime = System.currentTimeMillis();

long countrResult = lines.count();

long countEndTime = System.currentTimeMillis();

System.out.println("共"+countrResult+ "条数据,"+"计算时间="+ (countEndTime-

countStartTime));

jsc.stop();

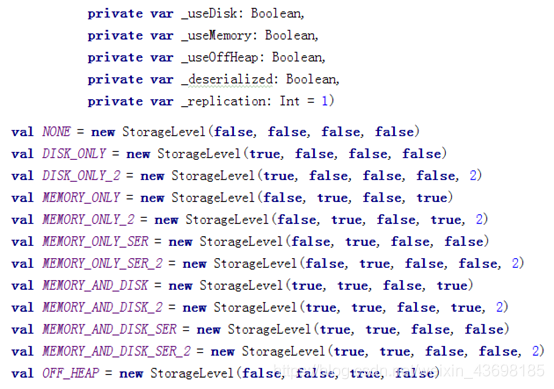

2.persist

可以指定持久化的级别。最常用的是MEMORY_ONLY和MEMORY_AND_DISK。”_2”表示有副本数。

- cache和persist的注意事项:

- cache和persist都是懒执行,必须有一个action类算子触发执行。

- cache和persist算子的返回值可以赋值给一个变量,在其他job中直接使用这个变量就是使用持久化的数据了。持久化的单位是partition。

- cache和persist算子后不能立即紧跟action算子。

- cache和persist算子持久化的数据当applilcation执行完成之后会被清除。

错误:rdd.cache().count() 返回的不是持久化的RDD,而是一个数值了。

3.checkpoint

checkpoint将RDD持久化到磁盘,还可以切断RDD之间的依赖关系。checkpoint目录数据当application执行完之后不会被清除。

- checkpoint 的执行原理:

- 当RDD的job执行完毕后,会从finalRDD从后往前回溯。

- 当回溯到某一个RDD调用了checkpoint方法,会对当前的RDD做一个标记。

- Spark框架会自动启动一个新的job,重新计算这个RDD的数据,将数据持久化到HDFS上。

- 优化:对RDD执行checkpoint之前,最好对这个RDD先执行cache,这样新启动的job只需要将内存中的数据拷贝到HDFS上就可以,省去了重新计算这一步。

- 使用:

SparkConf conf = new SparkConf();

conf.setMaster("local").setAppName("checkpoint");

JavaSparkContext sc = new JavaSparkContext(conf);

sc.setCheckpointDir("./checkpoint");

JavaRDD<Integer> parallelize = sc.parallelize(Arrays.asList(1,2,3));

parallelize.checkpoint();

parallelize.count();

sc.stop();

本文详细介绍了Spark中的Transformations转换算子,包括filter、map、flatMap、sample、reduceByKey、sortByKey/sortBy等,并阐述了Action行动算子如count、take、first、foreach和collect的作用。同时,讨论了控制算子cache、persist和checkpoint的功能和使用注意事项,特别是它们在数据持久化和优化计算流程中的角色。

本文详细介绍了Spark中的Transformations转换算子,包括filter、map、flatMap、sample、reduceByKey、sortByKey/sortBy等,并阐述了Action行动算子如count、take、first、foreach和collect的作用。同时,讨论了控制算子cache、persist和checkpoint的功能和使用注意事项,特别是它们在数据持久化和优化计算流程中的角色。

562

562

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?