点击这里你可以看到官网中提供的激活函数

首先介绍几种常见的激活函数

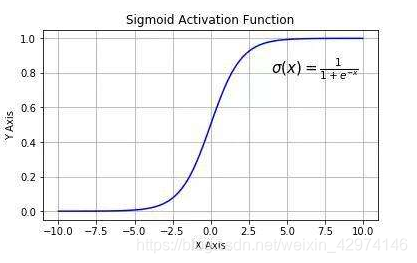

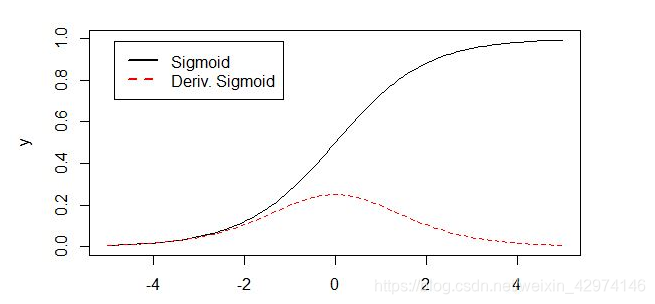

sigmoid函数

也叫Logistic函数,它可以将一个实数映射到(0,1)的区间。

根据求导σ '(x)=σ(x)(1-σ(x)),在x=0时梯度最大。缺点:在误差反向传播时,容易造成梯度消失。

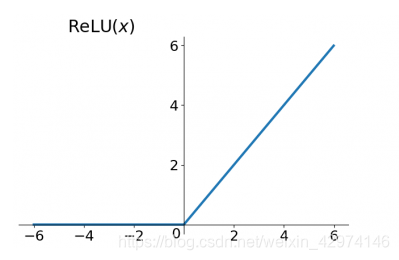

Relu函数

relu函数又称线性修正单元,一般用于回归中输出层神经元。

形状如上,公式:f(x)=max(0,x)

参考:https://blog.youkuaiyun.com/Leo_Xu06/article/details/53708647

relu函数能够解决sigmoid函数在反向传播时x>0“梯度消失问题”,还能加快收敛速度。但是在训练时容易x<0处造成梯度为0,权重无法更新的情况。如果发生这种情况,那么流经神经元的梯度从这一点开始将永远是0。。由此我们引进relu函数变种,给x<0时有部分梯度

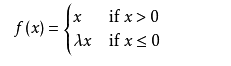

Leaky ReLU

称为带泄露线性整流函数,常数λ属于(0,1)。参考https://blog.youkuaiyun.com/qq_23304241/article/details/80300149

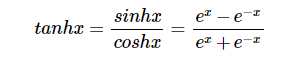

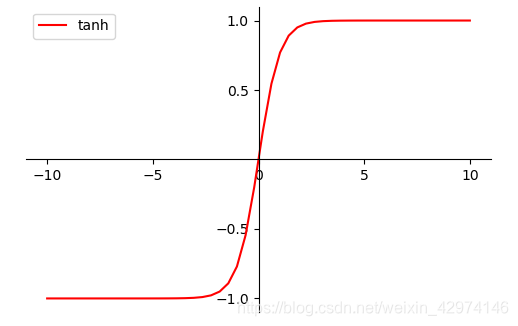

tanh函数

曲线图形如下

最后,如何在实际的神经网络中使用激活函数,查看博客TensorFlow实现深层神经网络

参考一些不错的文章

https://blog.youkuaiyun.com/weixin_41417982/article/details/81437088

TensorFlow中的激活函数

最新推荐文章于 2022-05-07 10:21:15 发布

本文深入解析了常见的激活函数,包括sigmoid、relu及其变种LeakyReLU,还有tanh函数。探讨了它们的特点、优缺点及应用场景,特别强调了relu函数解决梯度消失问题的优势。

本文深入解析了常见的激活函数,包括sigmoid、relu及其变种LeakyReLU,还有tanh函数。探讨了它们的特点、优缺点及应用场景,特别强调了relu函数解决梯度消失问题的优势。

805

805

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?