1.什么是向量

向量是一种有大小和方向的数学对象。它可以表示为从一个点到另一个点的有向线段。例如,二维空间中的向量可以表示为 ( x , y ) (x,y) (x,y),表示从原点 ( 0 , 0 ) (0,0) (0,0) 到点 ( x , y ) (x,y) (x,y) 的有向线段。

以此类推,可以用一组坐标 ( x 0 , x 1 , … , x N − 1 ) (x_0, x_1, \ldots, x_{N-1}) (x0,x1,…,xN−1) 表示一个 N N N 维空间中的向量, N N N 叫向量的维度。

1.1 文本向量(Text Embedding)

- 将文本转成一组 N N N 维浮点数,即文本向量又叫 Embeddings

- 向量之间可以计算距离,距离远近对应语义相似度大小

1.2 向量是怎么得到的?

- 构建相关(正立)与不相关(负例)的句子对儿样本

- 训练双塔式模型,让正例间的距离小,负例间的距离大

2.向量的相似度计算

欧氏距离、余弦距离

import numpy as np

from numpy import dot

from numpy.linalg import norm

def cos_sim(a, b):

'''余弦距离 -- 越大越相似'''

return dot(a, b)/(norm(a)*norm(b))

def l2(a, b):

'''欧氏距离 -- 越小越相似'''

x = np.asarray(a)-np.asarray(b)

return norm(x)

def get_embeddings(texts, model="text-embedding-ada-002", dimensions=None):

'''封装 OpenAI 的 Embedding 模型接口'''

if model == "text-embedding-ada-002":

dimensions = None

if dimensions:

data = client.embeddings.create(

input=texts, model=model, dimensions=dimensions).data

else:

data = client.embeddings.create(input=texts, model=model).data

return [x.embedding for x in data]

test_query = ["测试文本"]

vec = get_embeddings(test_query)[0]

print(f"Total dimension: {len(vec)}")

print(f"First 10 elements: {vec[:10]}")

### 输出

Total dimension: 1536

First 10 elements: [-0.007280634716153145, -0.006147929932922125, -0.010664181783795357, 0.001484171487390995, -0.010678750462830067, 0.029253656044602394, -0.01976952701807022, 0.005444996990263462, -0.01687038503587246, -0.01207733154296875]

# query = "国际争端"

# 且能支持跨语言

query = "global conflicts"

documents = [

"联合国就苏丹达尔富尔地区大规模暴力事件发出警告",

"土耳其、芬兰、瑞典与北约代表将继续就瑞典“入约”问题进行谈判",

"日本岐阜市陆上自卫队射击场内发生枪击事件 3人受伤",

"国家游泳中心(水立方):恢复游泳、嬉水乐园等水上项目运营",

"我国首次在空间站开展舱外辐射生物学暴露实验",

]

query_vec = get_embeddings([query])[0]

doc_vecs = get_embeddings(documents)

print("Query与自己的余弦距离: {:.2f}".format(cos_sim(query_vec, query_vec)))

print("Query与Documents的余弦距离:")

for vec in doc_vecs:

print(cos_sim(query_vec, vec))

print()

print("Query与自己的欧氏距离: {:.2f}".format(l2(query_vec, query_vec)))

print("Query与Documents的欧氏距离:")

for vec in doc_vecs:

print(l2(query_vec, vec))

### 输出

Query与自己的余弦距离: 1.00

Query与Documents的余弦距离:

0.7622749944010915

0.7563038106493584

0.7426665802579038

0.7079273699608006

0.7254355321045072

Query与自己的欧氏距离: 0.00

Query与Documents的欧氏距离:

0.6895288502682277

0.6981349637998769

0.7174028746492277

0.7642939833636829

0.7410323668625171

3. 向量数据库

向量数据库,是为向量检索设计的中间件

# !pip install chromadb

# 环境端差异,对pysqlite的兼容处理

import os

if os.environ.get('CUR_ENV_IS_STUDENT',False):

import sys

__import__('pysqlite3')

sys.modules['sqlite3'] = sys.modules.pop('pysqlite3')

###

# 暂只取两页(第一章)

paragraphs = extract_text_from_pdf(

"llama2.pdf",

page_numbers=[2, 3],

min_line_length=10

)

#####

import chromadb

from chromadb.config import Settings

class MyVectorDBConnector:

def __init__(self, collection_name, embedding_fn):

chroma_client = chromadb.Client(Settings(allow_reset=True))

# 为了演示,实际不需要每次 reset()

chroma_client.reset()

# 创建一个 collection

self.collection = chroma_client.get_or_create_collection(

name=collection_name)

self.embedding_fn = embedding_fn

def add_documents(self, documents):

'''向 collection 中添加文档与向量'''

self.collection.add(

embeddings=self.embedding_fn(documents), # 每个文档的向量

documents=documents, # 文档的原文

ids=[f"id{i}" for i in range(len(documents))] # 每个文档的 id

)

def search(self, query, top_n):

'''检索向量数据库'''

results = self.collection.query(

query_embeddings=self.embedding_fn([query]),

n_results=top_n

)

return results

# 创建一个向量数据库对象

vector_db = MyVectorDBConnector("demo", get_embeddings)

# 向向量数据库中添加文档

vector_db.add_documents(paragraphs)

user_query = "Llama 2有多少参数"

# user_query = "Does Llama 2 have a conversational variant"

results = vector_db.search(user_query, 2)

for para in results['documents'][0]:

print(para+"\n")

输出:

1. Llama 2, an updated version of Llama 1, trained on a new mix of publicly available data. We also increased the size of the pretraining corpus by 40%, doubled the context length of the model, and adopted grouped-query attention (Ainslie et al., 2023). We are releasing variants of Llama 2 with 7B, 13B, and 70B parameters. We have also trained 34B variants, which we report on in this paper but are not releasing.§

In this work, we develop and release Llama 2, a family of pretrained and fine-tuned LLMs, Llama 2 and Llama 2-Chat, at scales up to 70B parameters. On the series of helpfulness and safety benchmarks we tested, Llama 2-Chat models generally perform better than existing open-source models. They also appear to be on par with some of the closed-source models, at least on the human evaluations we performed (see Figures 1 and 3). We have taken measures to increase the safety of these models, using safety-specific data annotation and tuning, as well as conducting red-teaming and employing iterative evaluations. Additionally, this paper contributes a thorough description of our fine-tuning methodology and approach to improving LLM safety. We hope that this openness will enable the community to reproduce fine-tuned LLMs and continue to improve the safety of those models, paving the way for more responsible development of LLMs. We also share novel observations we made during the development of Llama 2 and Llama 2-Chat, such as the emergence of tool usage and temporal organization of knowledge.

- 向量数据库的意义是快速的检索;

- 向量数据库本身不生成向量,向量是由 Embedding 模型产生的;

- 向量数据库与传统的关系型数据库是互补的,不是替代关系,在实际应用中根据实际需求经常同时使用。

4.向量数据库服务

# Server 端

chroma run --path /db_path

# Client端

import chromadb

chroma_client = chromadb.HttpClient(host='localhost', port=8000)

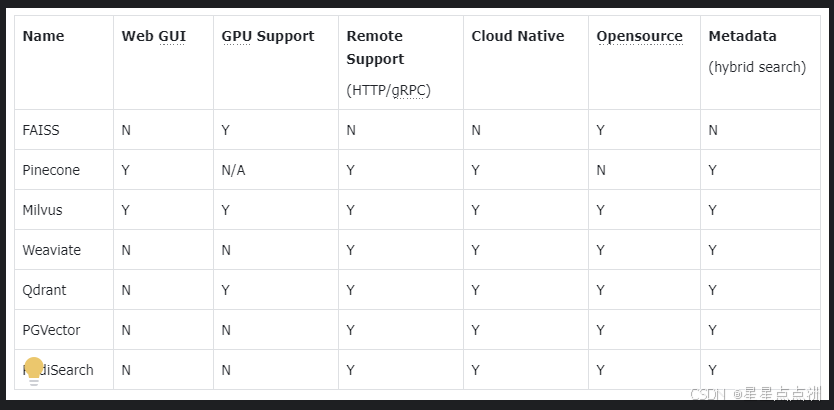

5.主流向量数据库对比

- FAISS: Meta 开源的向量检索引擎 https://github.com/facebookresearch/faiss

- Pinecone: 商用向量数据库,只有云服务 https://www.pinecone.io/

- Milvus: 开源向量数据库,同时有云服务 https://milvus.io/

- Weaviate: 开源向量数据库,同时有云服务 https://weaviate.io/

- Qdrant: 开源向量数据库,同时有云服务 https://qdrant.tech/

- PGVector: Postgres 的开源向量检索引擎 https://github.com/pgvector/pgvector

- RediSearch: Redis 的开源向量检索引擎 https://github.com/RediSearch/RediSearch

- ElasticSearch 也支持向量检索 https://www.elastic.co/enterprise-search/vector-search

1658

1658

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?