AlexNet论文笔记

模型介绍:

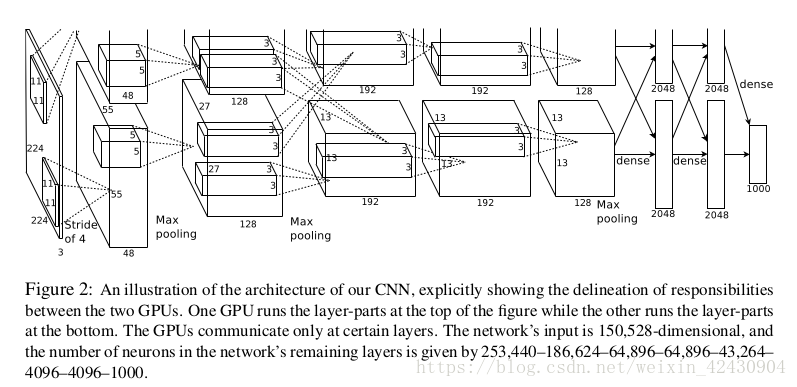

如下图所示,其网络结构为它包含8个学习层—–5个卷积层和3个全连接层。

模型参数分析:

[227x227x3] INPUT

[55x55x96] CONV1:96 11113 filters at stride 4 ,pad 0

[27x27x96] MAX POOL1: 3x3 filters at stride 2

[27x27x96] NORM1:Normalization layer

[27x27x256 CONV2 :256 5x5 filters at stride 1 ,pad 2

[13x13x256] MAX POOL2: 3x3 filters at stride 2

[13x13x256]: NORM2: Normalization layer

[13x13x256] : CONV3 384 3x3 filters at stride 1 ,pad 1

[13x13x384]: CONV4 384 3x3 filters at stride 1 ,pad 1

[13x13x384]: CONV5 256 3x3 filters at stride 1 ,pad 1

[6X6X256] MAX POOLl3: 3X3 filters at stride 2

[4096] FC6:4096 neurons

[4096] FC7 : 4096 neurons

[1000]FC8 :1000neurons(class scores)

在这里会发现论文中INPUT的size是 224x224x3 在第一个卷积层时,(224 +0*2- 11)/4 ,无法得到(55x55x96)第一个卷积层,所以将输入图片尺寸改为[227x227x3],才能得到后面的结果。

模型特点

1.ReLU激活函数(Rectified Linear Units)

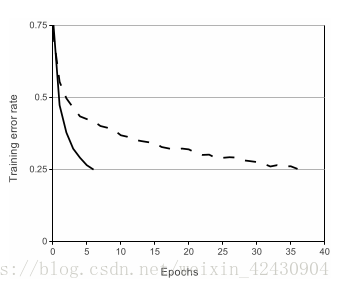

一般的方法是将神经元的输出作为函数f(x)=tanh(x) 或 f(x) =1/(1+e^-x) 的输入x 。依据梯度下降的时间,这些饱和非线性函数是比不饱和非线性函数f(x)=max(0,x)更慢的。下图为一个特别的四层卷积神经网络在CIFAR-10数据集上达到25%的错误率所需要的迭代次数。

2.大规模GPUs训练

一个GTX580 GPU仅仅有3GB的内存,这限制了在其上训练的网络的最大规模。事实是120万训练样本才足以训练网络,这太大了不适合在一个GPU上训练。因此,我们将网络分布在两个GPU上。当前的GPU非常适合跨GPU并行化,因为它们可以直接对另一块GPU进行读写操作,而不需要通过主机内存。我们采用的并行机制基本上每块GPU设置了一半的核函数(神经元),一个额外的小技巧:GPU 的交流仅仅在某些层。意思是说,例如,第三层神经元的输入来自第二层的所有神经元。但是,第四层的神经元仅仅来自同一块GPU上第三层的神经元。选择这种连接方式对于交叉验证是一个问题,但是这允许我们精确地调整连接的数量直到计算数值是一个可以接受的值。这个机制分别减小了我们的top1错误率1.7% 和 top5错误率1.2%,和每个卷积层许多神经元在同一块GPU上训练像比较起来,两块GPU网络比一块GPU花费更少的时间。

3.局部响应正则化

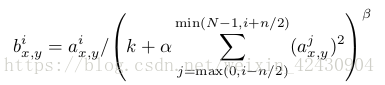

Relus 有一个良好的特性,它不要求输入归一化来防止饱和。如果至少一些训练数据产生了一个积极的输入给Relus,那个神经元将开始学习。然而,我们还发现接下来的局部归一化机制促进了泛化。用a表示通过核函数i在神经元(x,y)处计算得到的激活值,然后应用Relu非线性变换,响应归一化b通过表达式给出:

论文中使用这个方法在top-1和top-5上错误率分别减少了1.4%和1.2%,详细可以参考论文。

重叠池化 (Overlapping Pooling)

当池化操作中步长小于核的大小,相邻的池化就会发生重叠,据文中介绍,重叠池化比不重叠池化更不易出现过拟合。

DropOut

被“Dropout”的这些神经元对前向传播不做贡献,也不参与后向传播。所以,每次一个输入被展示的时候,神经网络表现出不同的结构,但是所有这些结构共享权重。这个技术减少了神经元的复杂的互相适应,由于一个神经元不能依赖其他特定神经元的存在。因此,学习更多稳定的特征是紧迫的,这些特征对连接其他神经元的许多不同随机集合是非常有用的。在测试阶段,我们使用所有的神经元但是对它们的输出乘以0.5,这是一个合理的近似,采取由指数丢包网络产生的预测分布的几何平均值。

我们在前两层全连接层使用dropout。没有dropout,我们的网络表现出大量的过拟合。孤过拟合大概使达到收敛的次数增加两倍。

数据增强

在图像数据上最容易也是最常见的减少过拟合的方法是通过标签保存转换人工地增大数据集。

第一种方法是对图像进行转换和水平旋转。第二种方法是3通道的RGB图片像素值进行PCA操作,改变其在RGB上的强度。

3841

3841

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?