说明:这是一个机器学习实战项目(附带数据+代码+文档+视频讲解),如需数据+代码+文档+视频讲解可以直接到文章最后关注获取。

1.项目背景

支持向量机(SVC)作为一种经典的机器学习算法,在分类任务中表现出色,尤其在处理高维数据和小样本问题时具有显著优势。然而,SVC的性能高度依赖于正则化参数(C)、gamma等的选择。传统的参数调优方法如网格搜索和随机搜索虽然简单易用,但计算成本较高且效率较低。近年来,元启发式优化算法(如遗传算法、粒子群优化等)被广泛应用于机器学习模型的参数优化。NOA星雀优化算法作为一种新兴的群体智能优化算法,因其高效的全局搜索能力和良好的收敛特性,为SVC分类模型的参数优化提供了新的解决方案。

本项目的目标是通过Python实现NOA星雀优化算法,并将其应用于支持向量机(SVC)分类模型的参数优化。具体而言,将利用NOA算法自动调整SVC的关键超参数(如C值、gamma等),以提高模型在分类任务中的准确率、召回率和F1分数等指标。项目的技术路线包括:首先构建SVC分类模型的基础框架,然后设计NOA算法的适应度函数以评估不同参数组合下的模型性能,最后通过实验验证NOA优化后的SVC模型相较于传统方法的优势。

NOA星雀优化算法优化的支持向量机分类模型在多个领域具有广泛的应用前景,例如医疗诊断中的疾病分类、金融领域的信用评分、工业生产中的质量检测以及社交网络中的用户行为分析等。通过本项目的实施,不仅可以提升SVC模型在实际问题中的分类性能,还能够推动元启发式优化算法在机器学习领域的进一步应用。未来,结合更多先进的优化算法和深度学习技术,有望开发出更加高效、智能的分类模型,助力各行业的智能化转型和创新发展。

本项目通过Python实现NOA星雀优化算法优化支持向量机SVC分类模型项目实战。

2.数据获取

本次建模数据来源于网络(本项目撰写人整理而成),数据项统计如下:

| 编号 | 变量名称 | 描述 |

| 1 | x1 | |

| 2 | x2 | |

| 3 | x3 | |

| 4 | x4 | |

| 5 | x5 | |

| 6 | x6 | |

| 7 | x7 | |

| 8 | x8 | |

| 9 | x9 | |

| 10 | x10 | |

| 11 | y | 因变量 |

数据详情如下(部分展示):

3.数据预处理

3.1 用Pandas工具查看数据

使用Pandas工具的head()方法查看前五行数据:

关键代码:

3.2数据缺失查看

使用Pandas工具的info()方法查看数据信息:

从上图可以看到,总共有11个变量,数据中无缺失值,共2000条数据。

关键代码:

3.3数据描述性统计

通过Pandas工具的describe()方法来查看数据的平均值、标准差、最小值、分位数、最大值。

关键代码如下:

4.探索性数据分析

4.1 y变量柱状图

用Matplotlib工具的plot()方法绘制柱状图:

4.2 y=1样本x1变量分布直方图

用Matplotlib工具的hist()方法绘制直方图:

4.3 相关性分析

从上图中可以看到,数值越大相关性越强,正值是正相关、负值是负相关。

5.特征工程

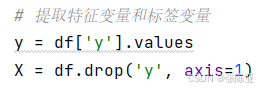

5.1 建立特征数据和标签数据

关键代码如下:

5.2 数据集拆分

通过train_test_split()方法按照80%训练集、20%验证集进行划分,关键代码如下:

5.3 数据归一化

关键代码如下:

6.构建NOA星雀优化算法优化SVM分类模型

主要通过Python实现NOA星雀优化算法优化支持向量机SVM分类模型算法,用于目标分类。

6.1 寻找最优参数值

最优参数值:

6.2 最优参数构建模型

这里通过最优参数构建分类模型。

| 模型名称 | 模型参数 |

| SVM分类模型 | C=best_C |

| gamma=best_gamma | |

| tol=best_tol |

7.模型评估

7.1评估指标及结果

评估指标主要包括准确率、查准率、查全率、F1分值等等。

| 模型名称 | 指标名称 | 指标值 |

| 测试集 | ||

| SVM分类模型 | 准确率 | 0.9650 |

| 查准率 | 0.9561 | |

| 查全率 | 0.9751 | |

| F1分值 | 0.9655 | |

从上表可以看出,F1分值为0.9655,说明NOA星雀优化算法优化的SVM模型效果良好。

关键代码如下:

7.2 分类报告

从上图可以看出,分类为0的F1分值为0.96;分类为1的F1分值为0.97。

7.3 混淆矩阵

从上图可以看出,实际为0预测不为0的 有9个样本,实际为1预测不为1的 有5个样本,模型效果良好。

8.结论与展望

综上所述,本文采用了通过NOA星雀优化算法优化SVM分类算法的最优参数值来构建分类模型,最终证明了我们提出的模型效果良好。此模型可用于日常产品的建模工作。

6486

6486

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?