(一)项目目标

本次要练习的目标时起点中文网里面的免费小说。

1. 如下图,找到免费小说的目录:

2. 点击更多后,随便找一本免费小说打开:

3. 点击中间的目录按钮,进入小说目录:

可以看到,该小说一共有83章,这就是本次目标。

(二)网页分析

1. 在目录页中点击一章,进入阅读页面,并同时检查网络,查看内容来源。

请注意下图中标注的三个部分:

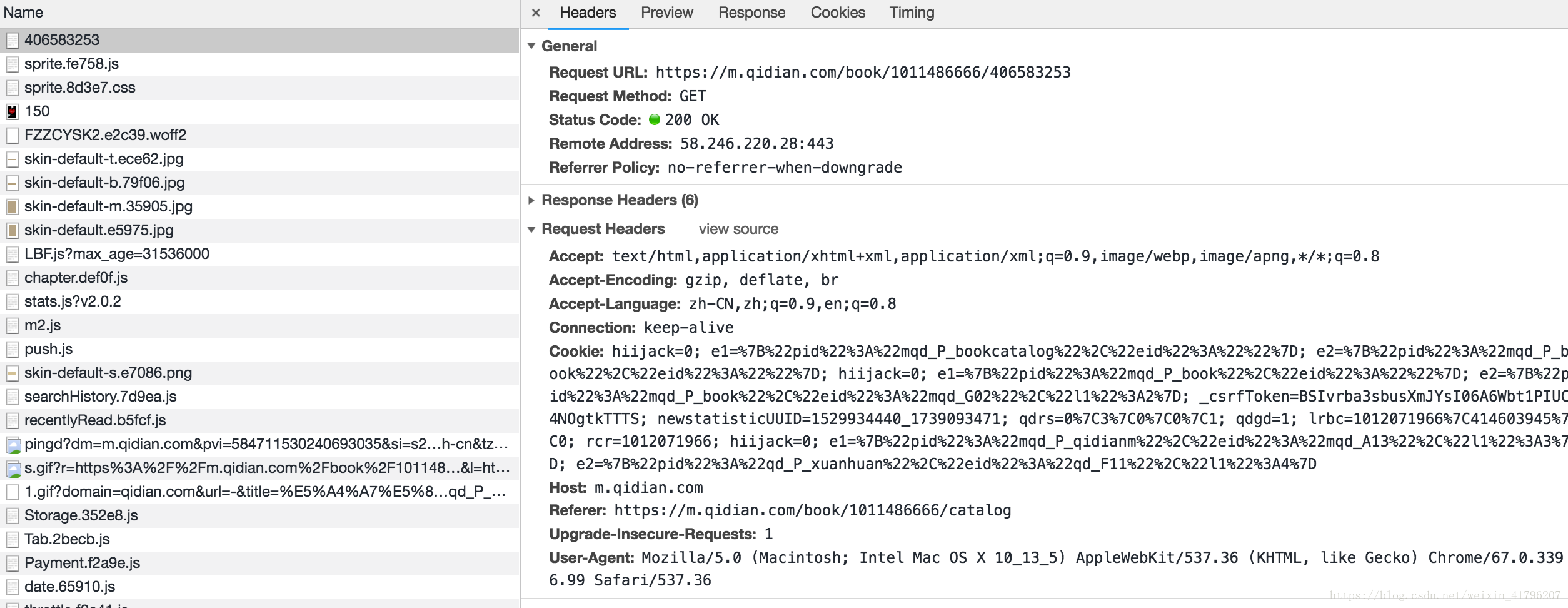

2. 这样,我们找到了获取内容的请求。下面仔细分析该请求:

从上面截图可以看到,请求的类型是GET,url与页面url相同。

这样,只要通过页面url就能拿到小说这一章的数据。

那么,其他章的url从哪里可以获取呢?

3. 还是回到最初的目录页,审查

本文介绍了如何使用Python爬虫爬取起点中文网的免费小说。通过分析网页结构,发现可以通过目录页获取所有章节URL,然后利用GET请求获取每一章的内容。最终在Jupyter中实现代码,并在MongoDB中展示了爬取结果。

本文介绍了如何使用Python爬虫爬取起点中文网的免费小说。通过分析网页结构,发现可以通过目录页获取所有章节URL,然后利用GET请求获取每一章的内容。最终在Jupyter中实现代码,并在MongoDB中展示了爬取结果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1023

1023

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?