接上篇文章内容,在完成本地ollama+deepseek部署后,问答都是命令行中进行,既不方便,也不美观。而且,无法建立自己的知识库,有没有更好的方式呢,当然是有的。

1、Anything LLM

AnythingLLM 是一款开箱即用的一体化 AI 应用,支持 RAG(检索增强生成)、AI 代理等功能。它无需编写代码或处理复杂的基础设施问题,适合快速搭建私有知识库和智能问答系统。

主要特性:

多种部署方式:支持云端、本地和自托管部署。

多用户协作:支持团队协作,适用于企业知识管理和客户支持。

多模型支持:兼容 OpenAI、Anthropic、LocalAI 等主流大模型。

多向量数据库支持:支持 Pinecone、Weaviate 等向量数据库。

多文件格式处理:支持 PDF、TXT、DOCX 等文件格式。

实时网络搜索:结合 LLM 响应缓存与对话标记功能,提供高效的文档管理和智能问答能力。

下载与安装

AnythingLLM 提供了 Mac、Windows 和 Linux 的安装包,用户可以直接从官网下载并安装。

打开官网下载页面https://anythingllm.com/desktop

选择你电脑系统对应的版本下载安装。

安装很简单,下一步下一步就好。

安装好后运行软件

直接点右侧箭头到下面界面

创建你的工作区,命名

工作区内用于存放你个人让AI掌握的资料。

工作区创建好后,进入下面的界面

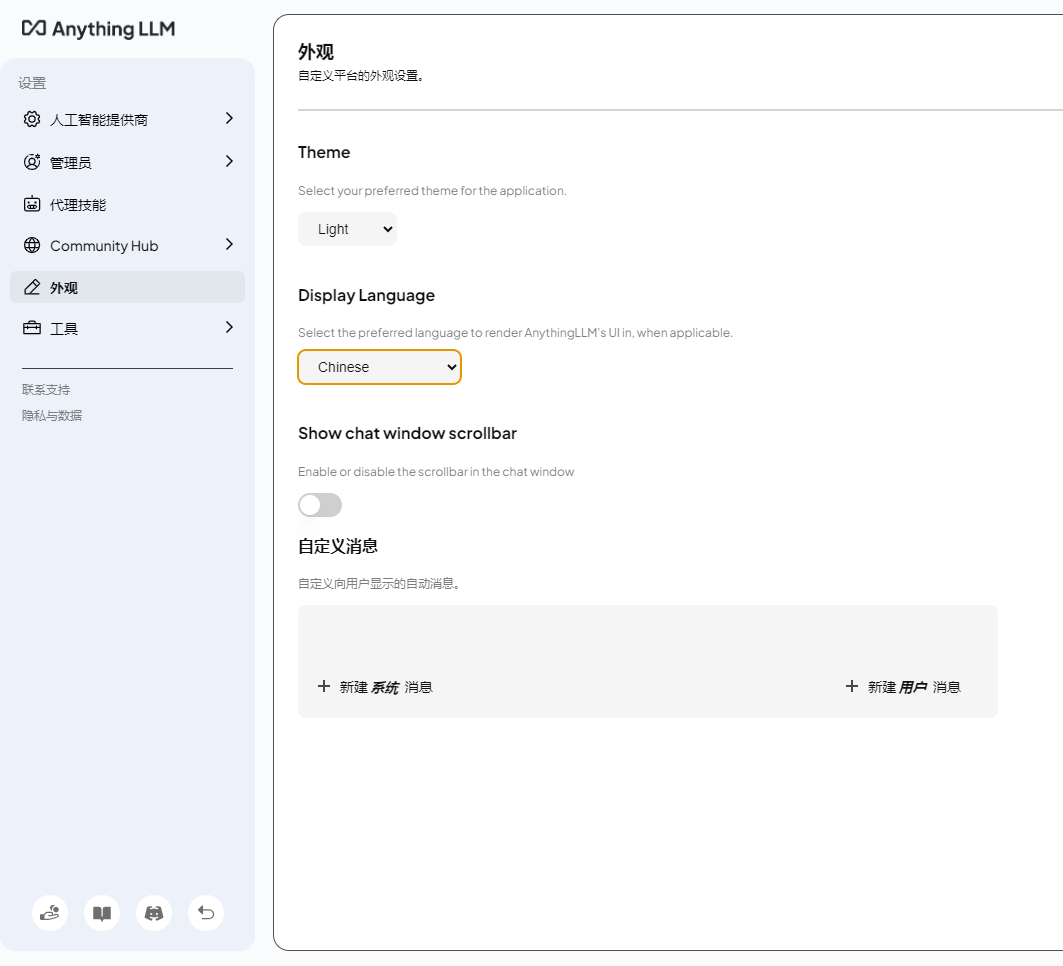

中文设置

点击左边区域下方的小扳手

在显示语言中选择中文

英语好的同学可以直接略过这一步。

选择LLM首选项

在右侧LLM提供商中选择ollama

然后再使用你ollama安装好的模型,记得点右上方按钮保存

返回后选择刚才创建的工作区就可以聊天了

随便问个问题

可以看到,他回答得煞有介事,实际上完全是在胡编乱造,数据全都不对的。这是大模型的通病,对于模型中不存在的数据,他会生成看似合理但实际错误的内容(称为"幻觉/Hallucination")。禁止他瞎扯,可以进行以下限制

选则工作区右侧的设置,选择聊天设置,把聊天改成查询

再问同样的问题,他就会回答There is no relevant information in this workspace to answer your query.意思是工作区中没有相关信息来回答你的查询。这段话在刚才那个聊天设置中也可以设置。大家可自行摸索。

建立本地知识库

点选工作区这个按钮上传知识文件

按上图步骤操作,即可将知识库文件上传至向量数据库

再问同样的问题,AI就会去知识库中寻找相应的答案。

1744

1744

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?