准确率:

准确率=预测正确的样本数 / 所有样本数

当不同类别的样本比例非常不均衡时,占比大的类别往往成为影响准确率最主要的因素。

解决类别不均衡问题:

1。 小样本扩增或大样本采样

2. 尝试其他评价指标精确率,召回率,ROC曲线

3. 惩罚因子。对分类器中不同类别分配不同的权值,小类别增加权值

精确率:指分类正确的正样本的个数占分类器判定为正样本的样本个数的比例。

precision:也叫查准率

召回率:指分类正确的正样本个数占真正的正样本个数的比例。

针对某一类样本与所有Ground Truth 的比例

精确率和召回率之前矛盾又统一。分类模型返回的TopN的结果就是模型判定的正样本,接着计算前N的位置上的精确率Precision@N和召回率Recall@N。为了提高精确率Precision,分类器将在更有把握的情况下才把样本判定为正样本。这样往往因为过于保守漏掉很多正样本导致Recall低。

P-R曲线(precision-recall):横轴召回率纵轴精确率,P-R曲线反映了模型在不同阈值下召回率和精确率的变化。要想全面衡量模型的性能,只有通过P-R曲线整体体现。

F1 score:精确率和召回率的调和平均值。

mAP:

RMSE:评价回归模型的好坏。

ROC曲线:ROC曲线越接近左上角,代表模型越好。AUC指的是ROC曲线的面积。

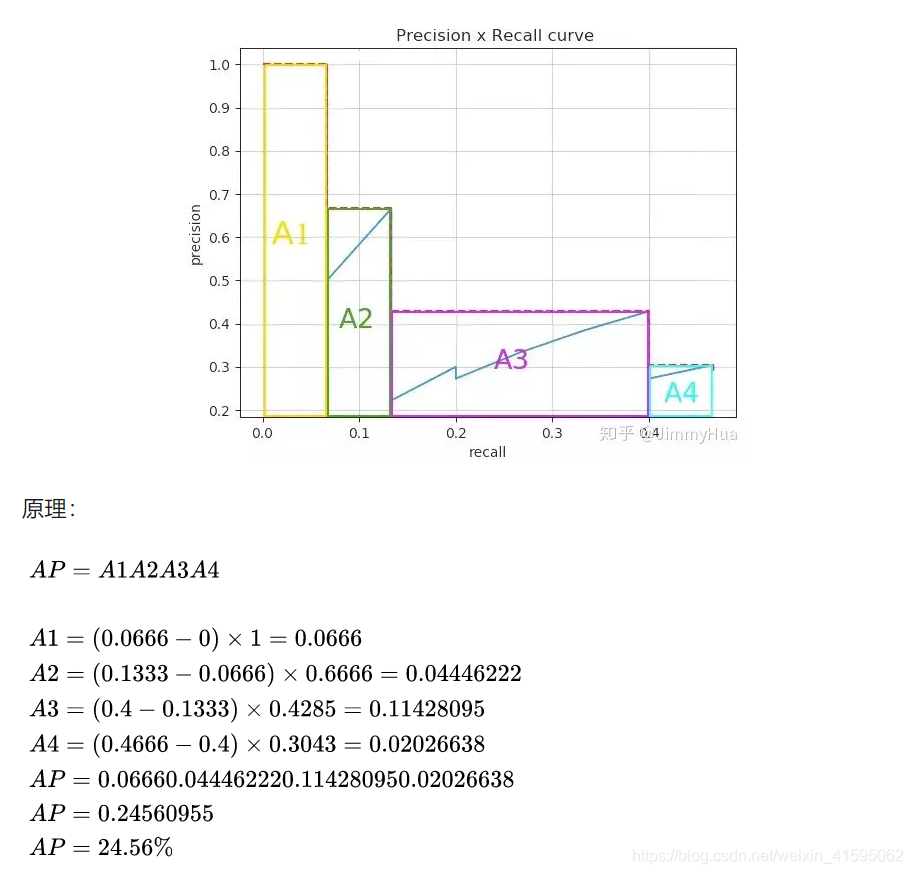

AP :Average Precision

P-R曲线的面积就是AP。由于积分困难,引入插值法近似成若干矩形。

mAP=所有类别的AP之和 / 类别数

过拟合的解决:数据增强,引入噪声,正则化,dropout,提前终止学习,集成学习方法。

欠拟合的解决:添加新特征(组合特征),增加模型的复杂度(网络层数或神经元个数),减小正则化系数

本文详细介绍了机器学习模型性能评估的多种指标,包括准确率、精确率、召回率、F1分数、AUC、mAP等,并探讨了如何解决类别不平衡问题及过拟合和欠拟合现象。

本文详细介绍了机器学习模型性能评估的多种指标,包括准确率、精确率、召回率、F1分数、AUC、mAP等,并探讨了如何解决类别不平衡问题及过拟合和欠拟合现象。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?