提升模型精度

- 数据增强(也就是pytorch里面的图像预处理)

- 学习率衰减

- 更好的优化方法(Adam\lookhead)

- dropout(防止过拟合)正则化

- BN层(是数据分布相同)

- 迁移学习+微调

- +增加数据集

以上几种方法 往往能够提升模型精度

在训练数据集时,怎么保存预测精度最高的参数(第几个epoch对应的精度)

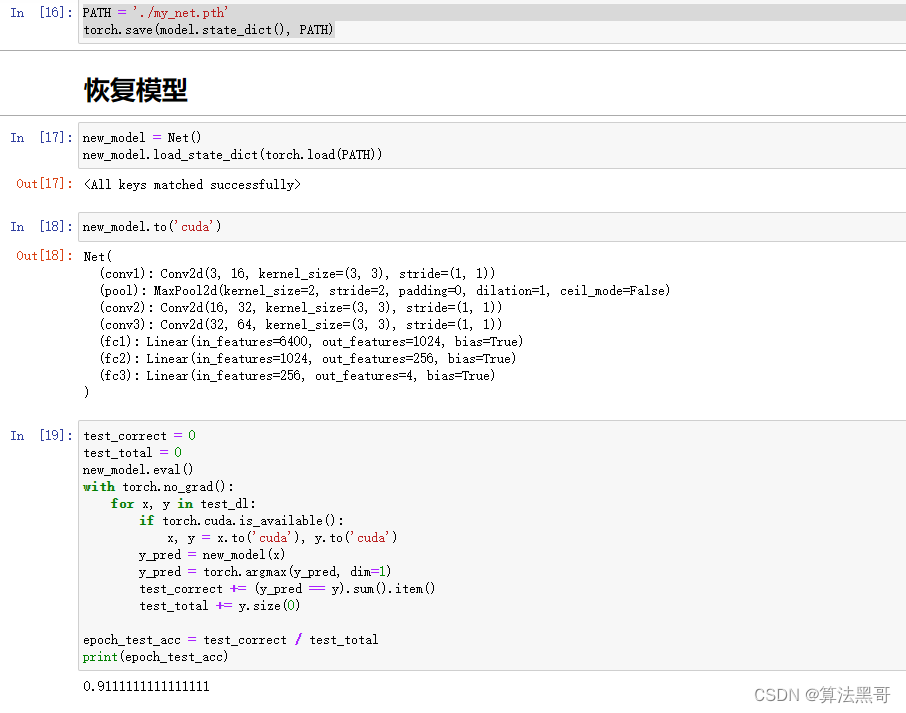

保存模型(字典形式的保存)

state_dict就是一个简单的Python字典,它将模型中的可训练参数(比如weights和biases,batchnorm的running_mean、torch.optim参数等)通过将模型每层与层的参数张量之间一一映射,实现保存、更新、变化和再存储。

- 恢复模型前,需要先把模型的网络结果写出来

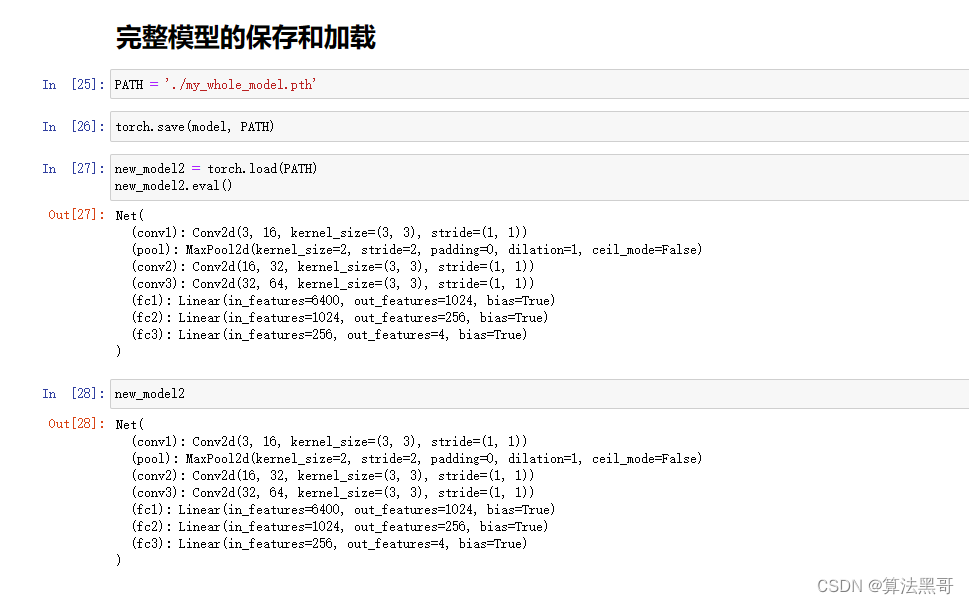

完整模型的保存与加载

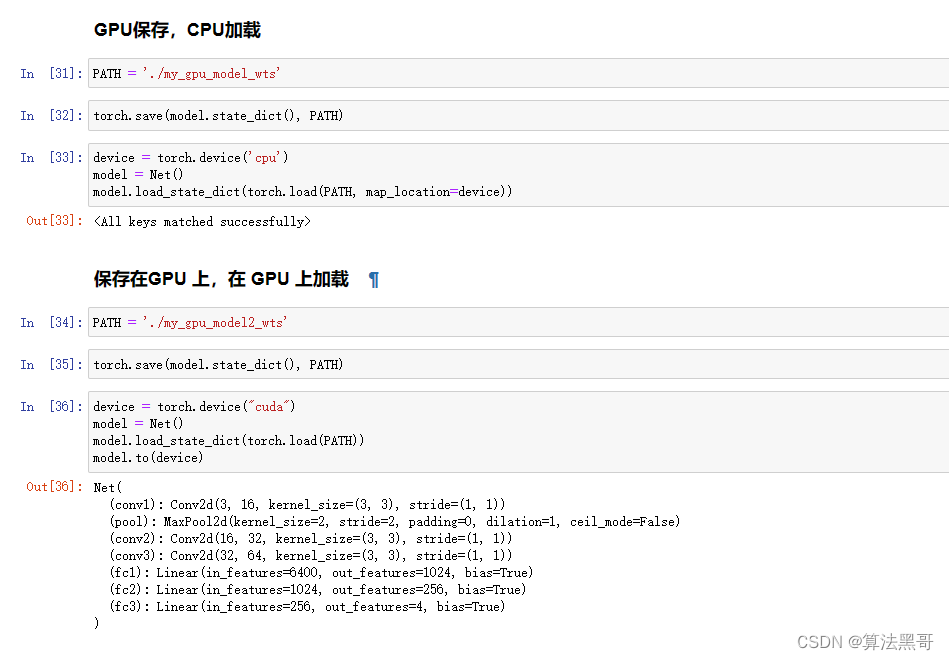

文章介绍了提升模型精度的方法,包括数据增强、学习率衰减、dropout防止过拟合、正则化和BN层的应用,以及迁移学习和微调。在训练过程中,通过保存每个epoch的state_dict,当测试精度最高时记录并保存这些参数。之后详细展示了如何在PyTorch中保存和加载最优模型状态。

文章介绍了提升模型精度的方法,包括数据增强、学习率衰减、dropout防止过拟合、正则化和BN层的应用,以及迁移学习和微调。在训练过程中,通过保存每个epoch的state_dict,当测试精度最高时记录并保存这些参数。之后详细展示了如何在PyTorch中保存和加载最优模型状态。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?