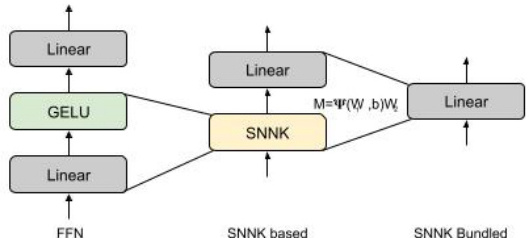

前馈神经网络(Feedforward Neural Network,简称FFN或FNN)是一种基础的人工神经网络结构,其信息流动仅沿单一方向,从输入层至隐藏层,再至输出层,无反馈连接。这种网络通常由输入层、一个或多个隐藏层以及输出层组成,每一层的神经元通过权重和偏置与下一层的神经元相连,但同一层的神经元之间没有连接。

前馈神经网络的结构与工作原理

-

结构:

- 输入层:接收外部信息,其神经元数量通常由输入特征的数量决定。

- 隐藏层:位于输入层与输出层之间,可以有一层或多层。隐藏层通过激活函数(如ReLU、Sigmoid等)引入非线性特性,从而能够学习复杂的模式。

- 输出层:产生网络的最终输出,其神经元数量由任务需求决定(例如分类任务中,神经元数量等于类别数)。

-

工作原理:

- 前向传播:输入数据从输入层开始,经过隐藏层的逐层处理,最终到达输出层。每一层的神经元接收前一层的加权输入信号,并通过激活函数转换后产生输出。

- 反向传播:在训练过程中,通过计算损失函数的梯度来更新网络的权重和偏置,以最小化损失函数。

前馈神经网络的特点

- 单向传播:信号在网络中只从输入层到输出层单向流动,没有反馈连接。

- 灵活性:能够逼近任意连续函数及平方可积函数,是一种强大的非线性映射工具。

- 简单性:结构简单,易于实现和训练,适用于多种任务,如图像识别、自然语言处理和金融预测等。

应用领域

前馈神经网络广泛应用于多个领域:

- 图像识别:通过多层感知机(MLP)实现对图像特征的提取和分类。

- 自然语言处理:用于文本数据的特征提取和分类任务。

- 金融预测:用于预测股票价格、市场趋势等。

激活函数与优化算法

-

激活函数:常用的激活函数包括ReLU、Sigmoid和GELU等,它们引入非线性特性,使网络能够学习复杂模式。

-

优化算法:常用的优化算法包括反向传播算法、梯度下降法及其变种(如Adam、Levenberg-Marquardt等),用于调整网络参数以最小化损失函数。

总结

前馈神经网络是一种基础且广泛应用的神经网络模型,其结构简单、易于实现,并且能够通过多层非线性变换处理复杂的任务。通过合理设计网络结构和选择合适的激活函数及优化算法,前馈神经网络可以有效地解决各种实际问题。

前馈神经网络(Feedforward Neural Networks, FNN)在图像识别中的最新应用和进展

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1843

1843

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?