“团结就是力量,这力量是铁,这力量是钢… …”,小学学的一首歌,至今还刻骨铭心。“团结就是力量”,完美的阐述了机器学习中非常强大的集成学习方法的思想。其实,集成学习方法就这么简单,将多个模型组合在一起会得到更强大的模型。本篇就让我们一起来探讨比赛必用神技——集成学习方法(Ensemble Learning Method)。

1)什么是集成学习方法

集成学习是一种技术框架,训练多个基模型,按照不同的思路组合基模型,以达到更好的结果。用于组合的基模型,在大多数情况下并不是很好,比如低方差高偏差而准确度不够或者低偏差高方差而缺乏泛化能力。因此,集成学习的思想是,将这些基模型组合在一起,以减少偏差或者方差,创建一个表现更好的强大的模型。

用以组合的基模型可以选择同质模型(Bagging,Boosting),比如基模型全部为决策树模型;也可以选择使用非同一类模型,即异质模型(Stacking),比如基模型包括随机森林,KNN,支持向量机。需要注意的是,我们选择的基模型必须和我们的组合方式一致。如果我们选择的基模型是高方差低偏差,选择的组合方式应该倾向于减小方差,比如bagging;相反,我们选择的基模型是高偏差低方差,选择的组合方式应该倾向于减小偏差,比如boosting。

目前,有三种常见的集成学习框架:bagging,boosting和stacking。

2)Bagging

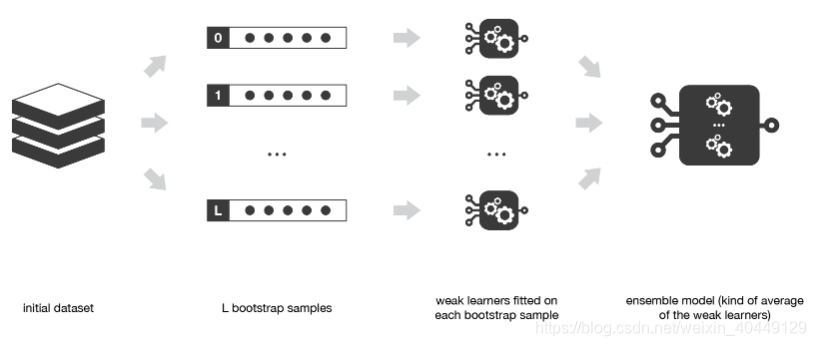

Bagging(bootstrap aggregating)的框架思想是,选择同质的基学习器,让基学习器之间相互独立并行训练,最后将所有基学习器的结果组合(分类使用投票,回归使用平均)在一起。基学习器主要选择高方差低偏差的模型。

从上图中可以看出,bagging是在初始的数据集上进行 L L

本文介绍了集成学习方法,包括Bagging、Boosting和Stacking。Bagging通过有放回采样训练基模型,降低方差;Boosting通过序列化训练减少偏差;Stacking使用异质基模型,通过模型融合提高准确性。随机森林和AdaBoost等算法是其典型应用。

本文介绍了集成学习方法,包括Bagging、Boosting和Stacking。Bagging通过有放回采样训练基模型,降低方差;Boosting通过序列化训练减少偏差;Stacking使用异质基模型,通过模型融合提高准确性。随机森林和AdaBoost等算法是其典型应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

384

384

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?