当最后的结果,使用了下面的方法后,测试的效果得到了明显的提升。质量的飞跃啊!!!!

glo = glo.view(glo.size(0),-1)

#print('glosize2',glo.shape)

x=glo

#x = torch.cat((glo,ocr),dim = 1,out = None)

x_norm = x.norm(p=2, dim=1, keepdim=True) + 1e-8

x = x.div(x_norm)

第一个是概念区分:归一化、正则化、标准化的区别

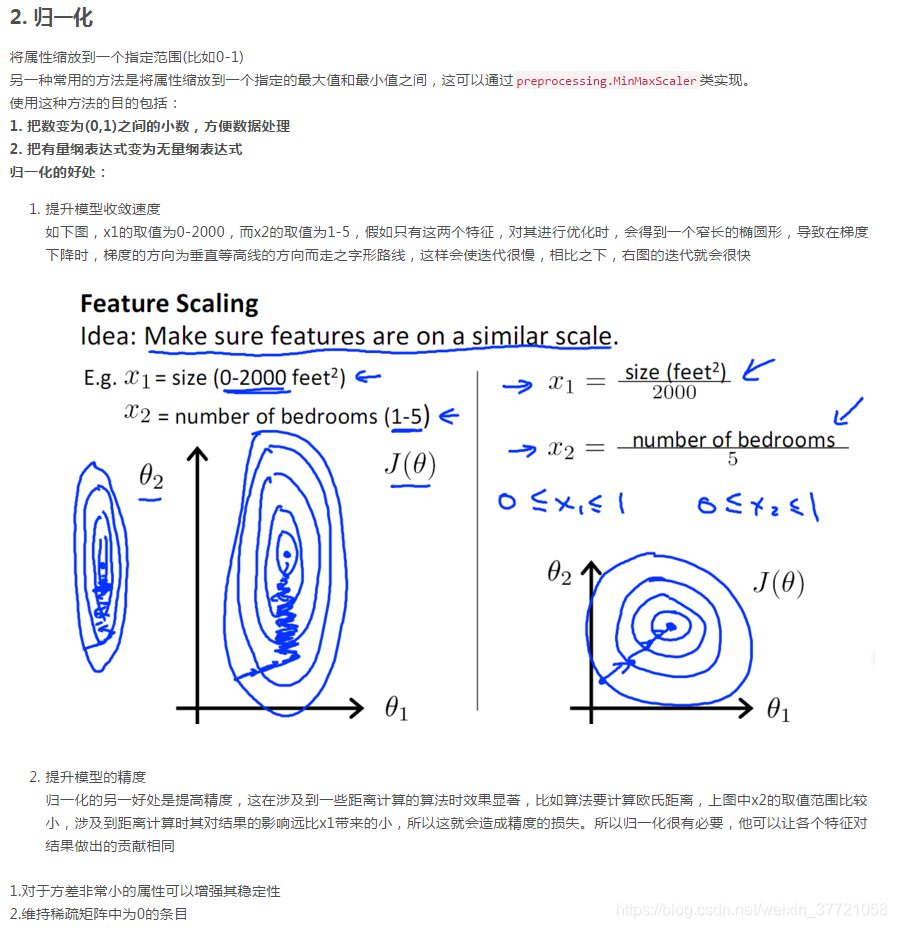

归一化是为了消除不同数据之间的量纲,方便数据比较和共同处理,比如在神经网络中,归一化可以加快训练网络的收敛性;

标准化是为了方便数据的下一步处理,而进行的数据缩放等变换,并不是为了方便与其他数据一同处理或比较,比如数据经过零-均值标准化后,更利于使用标准正态分布的性质,进行处理;

正则化而是利用先验知识,在处理过程中引入正则化因子(regulator),增加引导约束的作用,比如在逻辑回归中使用正则化,可有效降低过拟合的现象。

https://blog.youkuaiyun.com/power0405hf/article/details/53456162

https://blog.youkuaiyun.com/u011092188/article/details/78174804 这篇更加清晰

本文介绍了L2范数归一化在模型训练和图像检索中的应用,强调了它能提升测试效果,防止梯度消失和爆炸,并在正则化、归一化和标准化之间进行了区分。L2范数归一化使得欧式距离和余弦相似度等价,方便处理聚类问题。同时,文章讨论了训练中何时使用L2范数归一化对模型收敛速度的影响,提出了一种可能需要深入研究的现象:不使用归一化可能使模型更快收敛。

本文介绍了L2范数归一化在模型训练和图像检索中的应用,强调了它能提升测试效果,防止梯度消失和爆炸,并在正则化、归一化和标准化之间进行了区分。L2范数归一化使得欧式距离和余弦相似度等价,方便处理聚类问题。同时,文章讨论了训练中何时使用L2范数归一化对模型收敛速度的影响,提出了一种可能需要深入研究的现象:不使用归一化可能使模型更快收敛。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

547

547

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?